如何通过Stable Diffusion ControlNet来进行姿态控制。来一起来看下简单示例:

参数设置:

大模型: 墨幽人造人_v1080

模型下载地址: https://www.liblib.art/modelinfo/9470cdf92e33f5ad72cc2f40f834a69a

分辨率: 768*512

采样方法 (Sampler): Euler a

迭代步数 (Steps): 50

提示词引导系数 (CFG Scale): 7

Lora:仙侠古装_仙侠1.3

*Lora下载地址:*

https://www.liblib.art/modelinfo/014a5ebbf32a41a49278221cc8b974ee

Lora:Xian-T手部修复_v3.0

*Lora下载地址:*

https://www.liblib.art/modelinfo/855ea21b14ad4c04810eade3f05b0fdd

**Lora:**SYK_Mild detail adjuster(用于改变原有画面的姿势、服装、色彩等)

*Lora下载地址:*

https://www.liblib.art/modelinfo/65ebb9c3ebfe4317b82edaea10760b3c

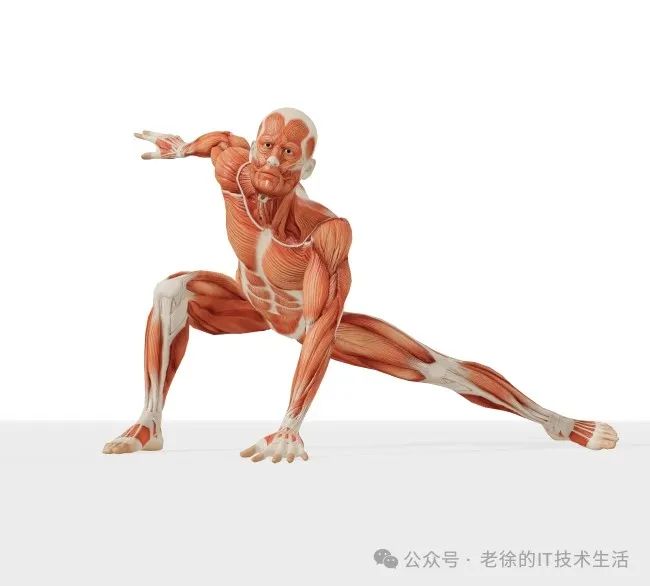

使用OpenPose控制这里其实你可以使用其他图片进行姿态控制,老徐这里仍然推荐这款在线网站,提供了多种姿态。网站地址:https://www.posemaniacs.com/poses,在里面选择一张想要创作的姿态图,可以进行下载或截图保存。

场景一:茶楼静坐

启用ControlNet 选择OpenPose (姿态)控制,上传参考姿态图,点击预处理器后面的爆炸图标,进行预览。这里如果出现姿势识别效果很差的时候并不需要担心,我们可以点击预览图右侧的**编辑按钮,**进行进一步的编辑。这里手部没有进行细致调整,所以导致下面生图手部存在严重问题。

编辑调整参考姿态,编辑完成后,点击左上角发送姿势到ControlNet按钮。

下一步,填写提示词进行跑图抽卡,提示词需要根据您想要创作的场景的同时也要贴合下面ControlNet的姿态场景。

提示词:

masterpiece,highres,best quality,1 girI in ancient tea houses, sitting on chairs, chinese immortal,chinese clothes,<lora:仙侠古装_仙侠1.3【chinese immortal,chinese clothes,1gir】:0.6>,lora:Xian-T手部修复_v3.0:1,<lora:SYK_Mild detail adjuster_V1.0_4(MINI):1>

杰作,高层,最好的质量,1 girI在古老的茶馆,坐在椅子上,中国的神仙,中国的衣服,lora:仙侠古装_仙侠1.3【中国神仙,中国衣服,1gir】:0.6,lora:仙-T手部修复_v3.0:1,lora:SYK_轻度细节调节器_V1.0_4(MINI):1

前面没有进行手部调整,手部生成的太可怕了,这里老徐尝试进行了隐藏手部

场景二:练习剑术

该姿势上传到ControlNet中后也会出现手部识别的问题,即便使用了手部修复的Lora,但因ControlNet的控制权重过高也会导致失效,这时,老徐同样使用了编辑功能,对手部节点进行适当编辑完善。简单粗暴的方法仍然是去掉所有手指,让AI自己去绘制。

**提示词:**masterpiece,highres,best quality,1 girI Practicing swordsmanship by the river,chinese immortal,chinese clothes,<lora:仙侠古装_仙侠1.3【chinese immortal,chinese clothes,1gir】:0.6>,lora:Xian-T手部修复_v3.0:1,<lora:SYK_Mild detail adjuster_V1.0_4(MINI):1>

杰作,高层,最好的质量,1 girI在河边练习剑术,lora:仙侠古装_仙侠1.3【中国神仙,中国衣服,1gir】:0.6,lora:仙-T手部修复_v3.0:1,lora:SYK_轻度细节调节器_V1.0_4(MINI):1

场景三:林中练拳

提示词:

masterpiece,highres,best quality,1 girI Practicing boxing in the forest,chinese immortal,chinese clothes<lora:仙侠古装_仙侠1.3【chinese immortal,chinese clothes,1gir】:0.6>,lora:Xian-T手部修复_v3.0:1,<lora:SYK_Mild detail adjuster_V1.0_4(MINI):1>

杰作,高层,最好的质量,1 girI在森林里练习拳击,中国神仙,中国衣服lora:仙侠古装_仙侠1.3【中国神仙,中国衣服,1gir】:0.6,lora:仙-T手部修复_v3.0:1,lora:SYK_轻度细节调节器_V1.0_4(MINI):1

哈哈,看看这个练拳击的,拳击手套都戴上了 (稍微娱乐一下~)

(稍微娱乐一下~)

有时候姿态控制效果不太好,需要自己细心编辑达到更好的效果,由于老徐这里没有进行对手部细致的调整,里面手部控制仍然存在很多问题,即便使用了手部修复Lora 仍然难以控制。

关于AI绘画技术储备

学好 AI绘画 不论是就业还是做副业赚钱都不错,但要学会 AI绘画 还是要有一个学习规划。最后大家分享一份全套的 AI绘画 学习资料,给那些想学习 AI绘画 的小伙伴们一点帮助!

对于0基础小白入门:

如果你是零基础小白,想快速入门AI绘画是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以找到适合自己的学习方案

包括:stable diffusion安装包、stable diffusion0基础入门全套PDF,视频学习教程。带你从零基础系统性的学好AI绘画!

需要的可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

1.stable diffusion安装包 (全套教程文末领取哈)

随着技术的迭代,目前 Stable Diffusion 已经能够生成非常艺术化的图片了,完全有赶超人类的架势,已经有不少工作被这类服务替代,比如制作一个 logo 图片,画一张虚拟老婆照片,画质堪比相机。

最新 Stable Diffusion 除了有win多个版本,就算说底端的显卡也能玩了哦!此外还带来了Mac版本,仅支持macOS 12.3或更高版本。

2.stable diffusion视频合集

我们在学习的时候,往往书籍源码难以理解,阅读困难,这时候视频教程教程是就很适合了,生动形象加上案例实战,一步步带你入坑stable diffusion,科学有趣才能更方便的学习下去。

3.stable diffusion模型下载

stable diffusion往往一开始使用时图片等无法达到理想的生成效果,这时则需要通过使用大量训练数据,调整模型的超参数(如学习率、训练轮数、模型大小等),可以使得模型更好地适应数据集,并生成更加真实、准确、高质量的图像。

4.stable diffusion提示词

提示词是构建由文本到图像模型解释和理解的单词的过程。可以把它理解为你告诉 AI 模型要画什么而需要说的语言,整个SD学习过程中都离不开这本提示词手册。

5.AIGC视频教程合集

观看全面零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

实战案例

纸上得来终觉浅,要学会跟着视频一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

这份完整版的学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

1783

1783

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?