浅层神经网络

-

3.1 神经网络概览

-

⭐有一些小点需要注意一下: [n]代表了哪一层,(i)代表了单个训练样本。我们会使用符号[m]表示第m层网络中节点相关的数,这些节点的集合被称为第[m]层网络。这样可以保证不会和我们之前用来表示单个的训练样本的(i)即我们使用表示第个训练样本混淆。

还有就是上一层的预测值作为输入传给下一层。

-

3.2 神经网络表示

⭐在一个神经网络中,当你使用监督学习训练它的时候,训练集包含了输入x和输出y

⭐“隐藏层”的含义是在训练集中 这些中间节点的真正数值我们是不知道的,在训练集中看不到它们的数值(但能在训练集中看到输入、输出)

⭐输入特征的数值的表示符号中a也有“激活”的意思,它意味着网络中不同层的值会传入给后面的层(e.g. 输入层将x的值传递给隐藏层,输入层为a^[0],隐藏层为a^[1],输出层为a^[2] )

⭐在logistic中,y帽=a,因为只有一个输出层,所以a上没用带方括号的上标。

但在神经网络中,用这种带方括号的上标来明确这些值来自哪一层

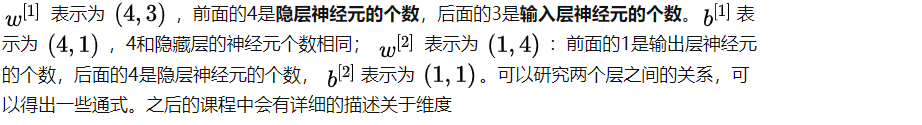

⭐隐藏层和输出层是带有参数的:

上图的隐藏层、输出层有两个相关的参数 W和b,隐藏层为W^[1] b^[1] 输出层为W^[2] b^[2]

-

3.3 计算神经网络的输出

⭐用圆圈表示神经网络的计算单元,逻辑回归的计算有两个步骤,首先你按步骤计算出,然后在第二步中你以sigmoid函数为激活函数计算 Z(得出),一个神经网络只是这样子做了好多次重复计算。

⭐用圆圈表示神经网络的计算单元,逻辑回归的计算有两个步骤,首先你按步骤计算出,然后在第二步中你以sigmoid函数为激活函数计算 Z(得出),一个神经网络只是这样子做了好多次重复计算。

通过本视频,你能够根据给出的一个单独的输入特征向量,运用四行代码计算出一个简单神经网络的输出。接下来你将了解的是如何一次能够计算出不止一个样本的神经网络输出,而是能一次性计算整个训练集的输出。

-

3.4多个例子的向量化

在3.3中,了解到如何针对于单一的训练样本,在神经网络上计算出预测值。

在这个视频,将会了解到如何向量化多个训练样本,并计算出结果。该过程与你在逻辑回归中所做类似

逻辑回归是将各个训练样本组合成矩阵,对矩阵的各列进行计算。神经网络是通过对逻辑回归中的等式简单的变形,让神经网络计算出输出值。这种计算是所有的训练样本同时进行的。

· 3.5向量化实现的解释

· 3.6激活函数

⭐б函数,介于0和1之间

⭐g(z)函数,g可以是非线性函数,不一定是б函数。

tanh激活函数介于-1到1之间

⭐不同层的激活函数可以不同

· 3.7为什么需要非线性激活函数

如果要用线性激活函数(恒等激活函数),那么神经网络只是把输入线性组合再输出

· 3.8激活函数的导数

· 3.9神经网络的梯度下降法

187

187

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?