第一节课

第一周

基本上就是一个单纯的小简介

第二周:神经网络的编程基础

2.1

logistic是一个用于二分分类的算法

计算机保存图片有三个通道RGB

如果有一个图片是64643全部列成一个

长度为12288

进行了符号说明

2.2

logistic y = W^T X+ b

Sigmoid y = σ(W^T X+ b)

2.3

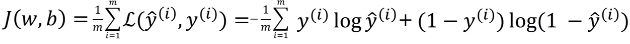

logistic 回归损失函数(loss function)

J是成本函数

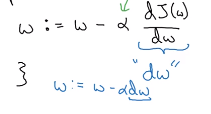

2.4 梯度下降算法

沿着最陡也就是导数最大的地方下降

2.5 & 2.6:导数

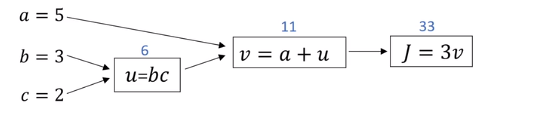

2.7 计算图

2.8计算图的导数计算

2.9m个样本的梯度下降

没听懂

2.10& 2.11向量化

向量化之后进行点乘运算比直接用显示for循环进行两个矩阵点乘的速度会快很多

Numpy中有很多函数用来进行矩阵的(或者说向量的)运算(numpy很多内置函数是c语言编写的)

2.12向量化logistic回归 &2.13回归的梯度输出

#就是不使用显示for循环,通过向量化可以一次同时实现logistic的一次迭代

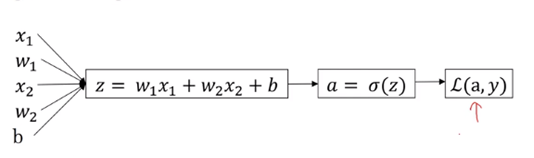

正向传播过程:对一个样本预测(计算出Z→计算激活函数→计算在第一个样本的y尖),然后继续计算第二个训练样本,然后第三个,直到完全计算

向量化:将m个x构成一个1*m的行向量,随之w,z和b都是矩阵

原来的算法

取消for循环

2.15python中的广播(broadcasting)

import numpy as np

A = np.array([[56.0,0.0,4.4,68.0],

[1.2,104.0,0.52,8.0],

[1.8,135.0,99.0,0.9]])

print(A)

#竖直相加

cal = A.sum(axis = 0)

print(cal)

percentage = 100*A/cal.reshape(1,4)

print(percentage)

2.16 numpy向量的说明

就是关于numpy的一些函数使用时的注意事项,尤其是矩阵

a = np.random.rand(5)

#尽量不要使用这种数据结构,尽量不要使用秩为1的矩阵

需要时可以使用assert和shape

2.17.jupyter简介

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?