转载自:http://blog.csdn.net/ownwell/article/details/8113980

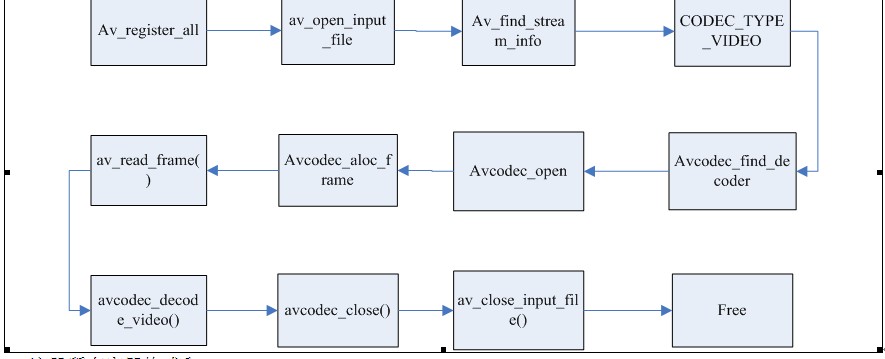

首先第一件事情就是开一个视频文件并从中得到流。我们要做的第一件事情就是使用av_register_all();来初始化libavformat/libavcodec: 这一步注册库中含有的所有可用的文件格式和编码器,这样当打开一个文件时,它们才能够自动选择相应的文件格式和编码器。av_register_all()只需调用一次,所以,要放在初始化代码中。也可以仅仅注册个人的文件格式和编码。

下一步,打开文件:

AVFormatContext *pFormatCtx;

const char *filename="myvideo.mpg";

av_open_input_file(&pFormatCtx, filename, NULL, 0, NULL); // 打开视频文件

最后三个参数描述了文件格式,缓冲区大小(size)和格式参数;我们通过简单地指明NULL或0告诉 libavformat 去自动探测文件格式并且使用默认的缓冲区大小。这里的格式参数指的是视频输出参数,比如宽高的坐标。

下一步,我们需要取出包含在文件中的流信息:

- av_find_stream_info(pFormatCtx); // 取出流信息

- AVFormatContext 结构体

- dump_format(pFormatCtx, 0, filename, false);//我们可以使用这个函数把获取到得参数全部输出。

- for(i=0; i<pFormatCtx->nb_streams; i++) //区分视频流和音频流

- if(pFormatCtx->streams->codec.codec_type==CODEC_TYPE_VIDEO) //找到视频流,这里也可以换成音频

- {

- videoStream=i;

- break;

- }

接下来就需要寻找解码器

- AVCodec *pCodec;

- pCodec=avcodec_find_decoder(pCodecCtx->codec_id);

- avcodec_open(pCodecCtx, pCodec); // 打开解码器

给视频帧分配空间以便存储解码后的图片:

- AVFrame *pFrame;

- pFrame=avcodec_alloc_frame();

/开始解码///

第一步当然是读数据:

我们将要做的是通过读取包来读取整个视频流,然后把它解码成帧,最后转换格式并且保存。

- while(av_read_frame(pFormatCtx, &packet)>=0) { //读数据

- if(packet.stream_index==videoStream){ //判断是否视频流

- avcodec_decode_video(pCodecCtx,pFrame, &frameFinished,

- packet.data, packet.size); //解码

- if(frameFinished) {

- img_convert((AVPicture *)pFrameRGB, PIX_FMT_RGB24,(AVPicture*)pFrame, pCodecCtx->pix_fmt, pCodecCtx->width,pCodecCtx->height);//转换 }

- SaveFrame(pFrameRGB, pCodecCtx->width,pCodecCtx->height, i); //保存数据

- av_free_packet(&packet); //释放

av_read_frame()读取一个包并且把它保存到AVPacket结构体中。这些数据可以在后面通过av_free_packet()来释 放。函数avcodec_decode_video()把包转换为帧。然而当解码一个包的时候,我们可能没有得到我们需要的关于帧的信息。因此,当我们得到下一帧的时候,avcodec_decode_video()为我们设置了帧结束标志frameFinished。最后,我们使用 img_convert()函数来把帧从原始格式(pCodecCtx->pix_fmt)转换成为RGB格式。要记住,你可以把一个 AVFrame结构体的指针转换为AVPicture结构体的指针。最后,我们把帧和高度宽度信息传递给我们的SaveFrame函数。

1219

1219

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?