一、介绍

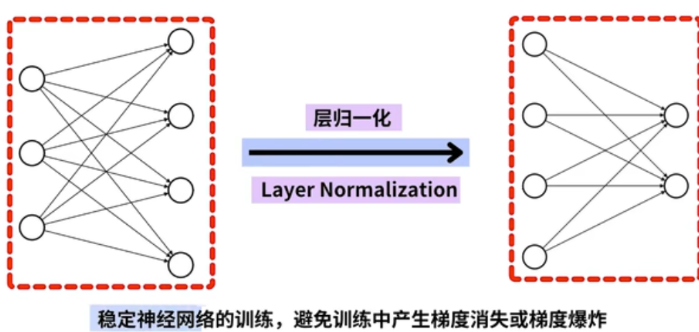

在 PyTorch 中,LayerNorm 是一种常用的归一化方法,特别适用于序列模型(如 Transformer)或小批量训练的场景。它的核心思想是对每个样本的所有特征维度进行归一化,而不是像 BatchNorm 那样对整个 batch 的同一维度进行归一化

🧠 二、计算公式

对每个样本的特征向量x∈Rdx \in \mathbb{R}^dx∈Rd,归一化过程如下:

x^i=xi−μσ2+ϵ⋅γ+β\hat{x}_i = \frac{x_i - \mu}{\sqrt{\sigma^2 + \epsilon}} \cdot \gamma + \betax^i=<

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?