转自:http://blog.csdn.net/mxs30443/article/details/53070533

Spatial Transformer Networks是Deepmind团队去年的一个工作,一经发布就引起了大量关注,这篇文章把在图像识别前常做的alignment操作放到了neural network当中,不得不说方法很优雅也很work。我当时也在第一时间读了这篇文章,Deepmind的工作都很impressive,很多论文可能只需要花十几分钟甚至几分钟过一遍就可以,因为那些文章往往只是在前人的工作上做了一点点改进,而Deepmind的论文几乎都是有比较大的创新,并且实验充分,工作扎实。

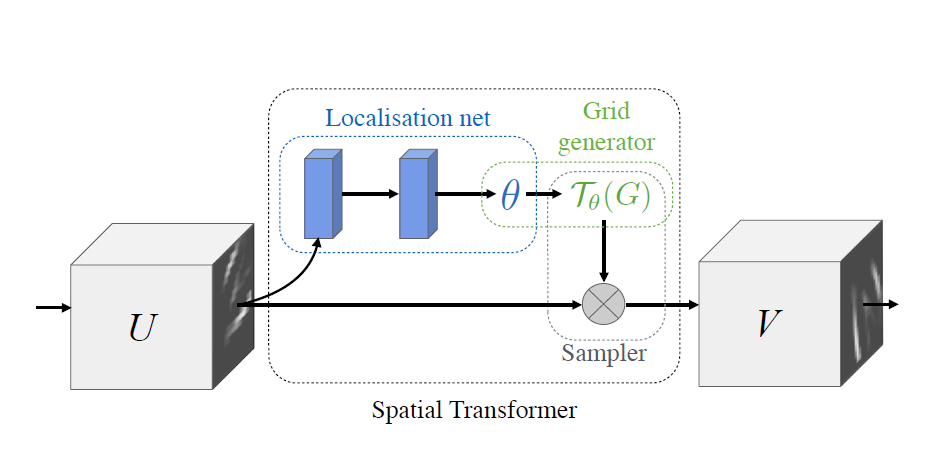

这篇论文提出了Spatial Transformer Layer,如下图所示,论文中说的有点复杂,其实理解了也挺简单的,Localisation net是最关键的一步,以Affine transform为例,就是图片过一个CNN学习Affine transform需要的6个参数,这个CNN的输出就是这6个参数,然后剩下的两步其实就是做transform了,Grid generator就是将原始图片的每个点映射到做transform后的坐标,Sampler就是根据映射后的坐标做插值得到完整图像。其实很好理解也易于实现。

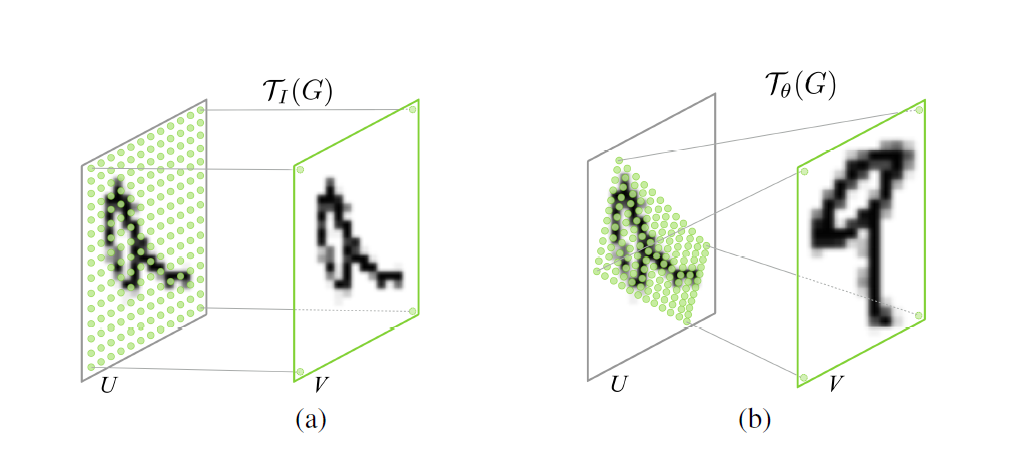

前几天我尝试在SVHN数据集上复现了下实验,网络和论文中不一样,自己随便搭了一个,最后用LSTM+CTC做识别,原始的准确率是93.2%,加了单个Spatial Transformer Layer后提升到了93.4%,论文里是从96%->96.3%,虽然准确率提升不多,但是可以看到很多倾斜的图片经过Spatial Transformer Layer后明显变正了,效果如下图所示。实验中感觉有几个地方需要注意,一是Localisation net要足够大才能比较好地捕捉到图片的抽象特征,可以参考论文中的结构,二是Spatial Transformer Layer的初始化要满足一开始输出图片和输入图片相同,否则一开始就随机对图片做transform很难训练得到比较好的结果。以Affine transform为例,Spatial Transformer Layer最后一层输出6个参数的全连接层初始化的weight为0,bias为1 0 0 0 1 0,这样就能开始时保证输出图像和输入图像一样。我一开始做实验没有注意这一点,浪费了不少时间。

这个实验还比较好做,并且对处理倾斜的物体确实有效果,大家有兴趣可以试一下

-

顶

- 0

-

踩

6012

6012

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?