一.实验题目

1.利用集成学习方法对所给数据进行分类判定,比对准确率。

二.算法分析

1.集成学习主要分两种方法,Bagging,Adaboost,本次实验,我采用Bagging算法,算法思想即从大小为n的原始数据集D中,分别独立随机地抽取个数据(<n)形成自助数据集,并且将这个过程独立进行许多次,直到产生很多个独立的自助数据集。然后,每一个自助数据集都被独立地运用于训练一个“分量分类器”。最终的分类判决将根据这些“分量分类器”各自的判决结果的投票来决定。

代码:

clear;

tic;

load Data-Ass2.mat;

x=2000;%.....

y=500;%......

for j=1:5

for i=1:x

p=randperm(x);

tridata(1,i)=data(1,p(1));

tridata(2,i)=data(2,p(1));

tridata(3,i)=data(3,p(1));

end

testdata = data(:,2501:3000);

test_opt(:,j)=rbf(tridata,testdata);

% disp(test_opt(:,j));

end

% disp(test_opt);

for i=1:y

aa=0;

bb=0;

for j=1:5

if (test_opt(i,j)<0)

aa=aa+1;%disp(aa);

else

bb=bb+1; % disp(bb);

end

end

if(aa>bb)

testfiopt(i)=-1;

else

testfiopt(i)=1;

end

end

% disp(testfiopt);

testdata_opt=testdata(3,:);

wr=0;

for i=1:y

if ( testfiopt(i)*testdata_opt(i)<0)

wr=wr+1;

end

end

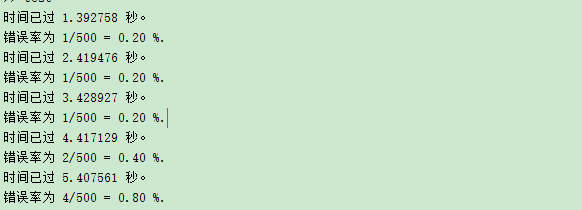

fprintf('总的错误率为 %d/500 = %.2f %%.\n',wr,wr/5);

hold on;

%画出判别之后的图

for i=1:3000

if (data(3,i)==1)

plot(data(1,i),data(2,i),'yx');

else

plot(data(1,i),data(2,i),'gx');

end

end

for i=1:y

if ( testfiopt(i)==1)

plot(data(1,2500+i),data(2,2500+i),'ro');

else

plot(data(1,2500+i),data(2,2500+i),'bo');

end

end

xlabel('x');

ylabel('y');

legend('1','-1');

function [test_opt]=rbf(tridata,testdata)

x=2000;

y=500;

inn=4;%输入层节点个数

hidn=10;%隐含层节点个数

outn=1;%输出层节点个数

%K-means分类

train_data_src=tridata(1:2,:);

[idx,cen]=kmeans(train_data_src',hidn);

train_data_opt=tridata(3,:);

testdata_opt=testdata(3,:);

testout=zeros(1,y);

%计算高斯函数的宽度以及phi值

xgm=zeros(1,hidn);

fai=zeros(x+y,hidn);

for i=1:hidn

xgmmin=1e15;

for j=1:hidn

t=(cen(i,1)-cen(j,1)).^2+(cen(i,2)-cen(j,2)).^2;

if (i~=j&&t<xgmmin)

xgmmin=t;

end

end

xgm(i)=xgmmin;

end

for i=1:x

for j=1:hidn

fai(i,j)=exp(-((train_data_src(1,i)-cen(j,1)).^2+(train_data_src(2,i)-cen(j,2)).^2)/(2.*xgm(j)));

end

end

%迭代修正权重过程

i=1;

max=100;%最大迭代次数.。。。。

alpha=0.1;%学习率。。。。。

errt=zeros(1,x);

%记录总的误差值

err=zeros(1,max+1);

w=rand(hidn,outn);%随机生成权重矩阵

while (i<=max) %当平均误差小于0.001时则结束迭代

triednum=1;

while (triednum<=x)

%计算当前输出值

F=0.0;

for i=1:hidn

F=F+w(i,1)*fai(triednum,i);

end

%计算误差值

errtmp=0.5.*(train_data_opt(triednum)-F).^2;

errt(triednum)=0.5.*errtmp;

%修正权重

for i=1:hidn

w(i,1)=w(i,1)+alpha*(train_data_opt(triednum)-F)*fai(triednum,i);

end

triednum=triednum+1;

end

tmp=0.0;

for i=1:x

tmp=tmp+errt(i).^2;

end

tmp=tmp/x;

err(i)=tmp.^(0.5);

if (err(i)<0.001)

break;

end

i=i+1;

end

%对于test数据

%计算高斯函数的值

testdata_src=testdata(1:2,:);

for i=1:y

for j=1:hidn

fai(i+x,j)=exp(-((testdata_src(1,i)-cen(j,1)).^2+(testdata_src(2,i)-cen(j,2)).^2)/(2.*xgm(j)));

end

end

%测试过程

tested=1;

while (tested<=y)

%输出值

N=0.0;

for j=1:hidn

N=N+fai(tested+x,j)*w(j,1);

end

%进行判别

if N>0

test_opt(tested)=1;

else

test_opt(tested)=-1;

end

tested=tested+1;

end

%计时结束

% disp(test_opt);

toc;

%计算错误率

wr=0;

for i=1:y

if (test_opt(i)*testdata_opt(i)<0)

wr=wr+1;

end

end

fprintf('错误率为 %d/500 = %.2f %%.\n',wr,wr/5);

4988

4988

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?