文章目录

引言

随着人工智能技术的不断发展,手势识别作为一种自然交互方式,在人机交互、智能控制等领域具有广泛的应用前景。本系统基于 YOLO11 深度学习算法,旨在实现对手势的准确检测与识别,为用户提供便捷、高效的交互体验。本系统可以识别检测4个类别:前进,左,右,停。

软件主界面

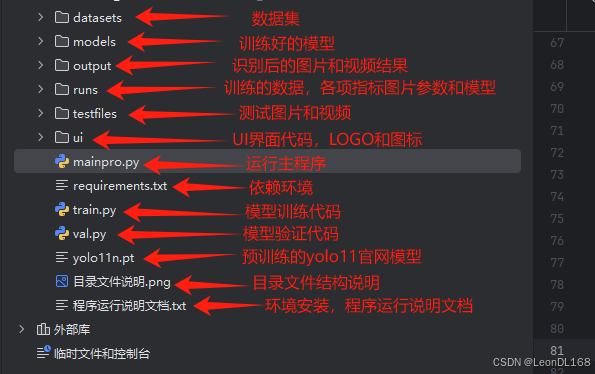

源码目录文件说明

一、环境安装

开发环境:Python3.9+Pyqt5+Yolo11

(1)安装python

先安装ananconda软件,官网地址:https://www.anaconda.com/download

安装完成后,在conda命令窗口,使用命令"conda create -n py39 python=3.9"创建3.9的虚拟环境

然后激活虚拟环境“conda activate py39”,然后再进行依赖库的安装。

(2)安装软件所需的依赖库

(注意:输入命令前,命令行需先进入项目目录的路径下,不然会提示找不到文件)

运行下方命令

pip install -r requirements.txt -i https://pypi.tuna.tsinghua.edu.cn/simple

二、软件核心功能介绍及效果演示

环境安装完成后,直接运行mainpro.py文件即可打开程序。

(1)软件核心功能

1、图片检测功能:选择对应图片路径,即开始自动检测该图片并显示检测结果

2、文件检测功能:选择对应文件夹路径,即开始自动检测该文件夹下的图片并显示检测结果

3、视频检测功能:选择对应视频路径,即开始自动检测该视频并显示检测结果到界面

4、摄像头检测功能:开启摄像头,即开始自动检测摄像头下的监控并显示检测结果到界面

5、运行模式设置:可以勾选GPU还是CPU运行,当电脑上没有GPU时,底层自动默认CPU运行

6、最小置信度设置:可以设置最小置信度,目标的置信度小于最小置信度时,则不会被识别到

7、保存数据:可以保存识别后的图片和视频,保存的图片和视频带有识别检测框和检测信息

8、实时显示检测结果:可以实时看到当前的检测结果,也可勾选识别到的某个目标,显示该目标的所有检测数据和检测框。

(2)软件效果演示

基于YOLO11深度学习的手势识别检测系统

三、模型的训练、评估与推理

(1)数据集准备与训练

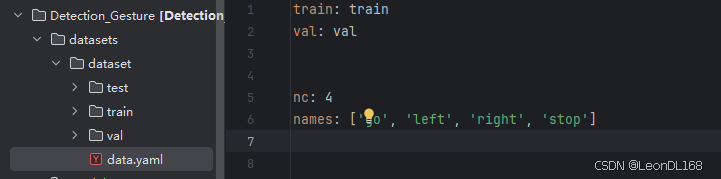

将文件【datasets/dataset/data.yaml】中train,val,test数据集的路径改为自己项目数据集的路径,配置好对应的类别

然后运行train.py文件即可开始进行模型训练,训练结果会默认保存在runs/detect目录中。

(2)训练结果评估

已有的runs/train是我已经训练好的结果文件,含模型与所有过程内容。

(3)使用训练好的模型识别

模型训练完成后,我们可以得到一个最佳的训练结果模型best.pt文件,在runs/trian/weights目录下。我们可以使用该文件进行后续的推理检测。我们将它复制到models文件夹下,后面软件启动后就会自动加载models文件夹下的best.pt文件进行推理识别

四、完整相关文件及源码下载链接

基于YOLO11深度学习的手势识别检测系统(带GUI界面)(Python源码+Pyqt5界面+300多张标注好的数据集+安装使用教程+训练好的模型+评估指标曲线+演示图片视频),开箱即用

五、其他YOLO11实战项目下载链接

六、结束语

关于该系统涉及到的完整源码、UI界面代码、数据集、训练代码、测试图片视频等相关文件,均已打包上传,感兴趣的小伙伴可以通过下载链接自行获取,也可私信或者加QQ联系获取。

该资源内项目代码都经过本人训练测试并运行成功,功能都OK的情况下才上传的,请放心下载使用!整套系统可参考学习,也可在此基础上略做修改,以实现其他功能,也可直接用于毕设、课设和作业等。有问题请私信我,提供技术支持。

464

464

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?