GPU版本的pytorch要根据显卡的型号选择合适的版本(Nvidia GTX 3090)

1.Anaconda创建虚拟环境

conda create -n pytorch python=3.8

conda activate pytorch2.安装pytorch

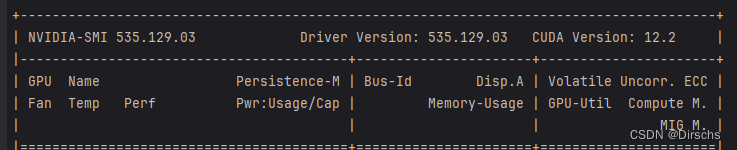

安装前查看当前GPU的所有基础信息

nvidia-smi查看cuda支持的最高版本,此处为12.2

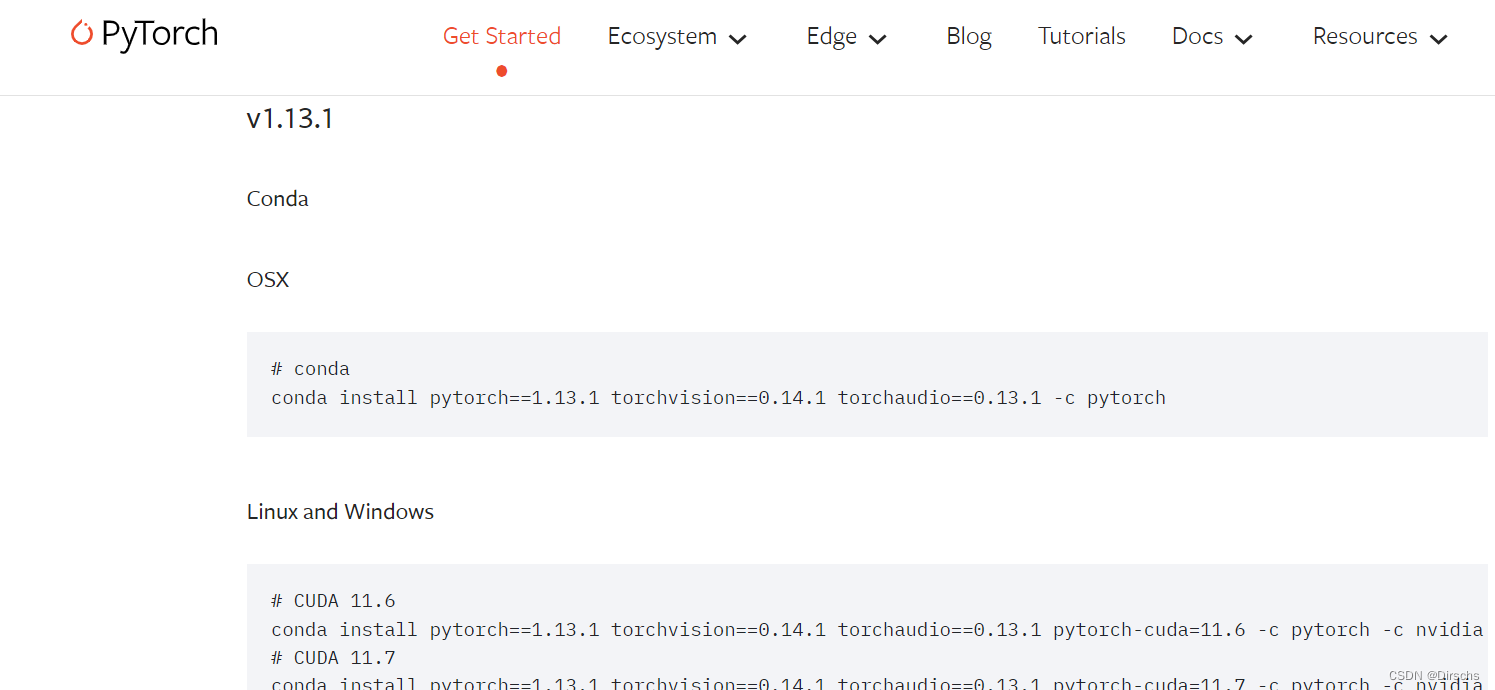

在官网找到合适的版本下载:Previous PyTorch Versions | PyTorch

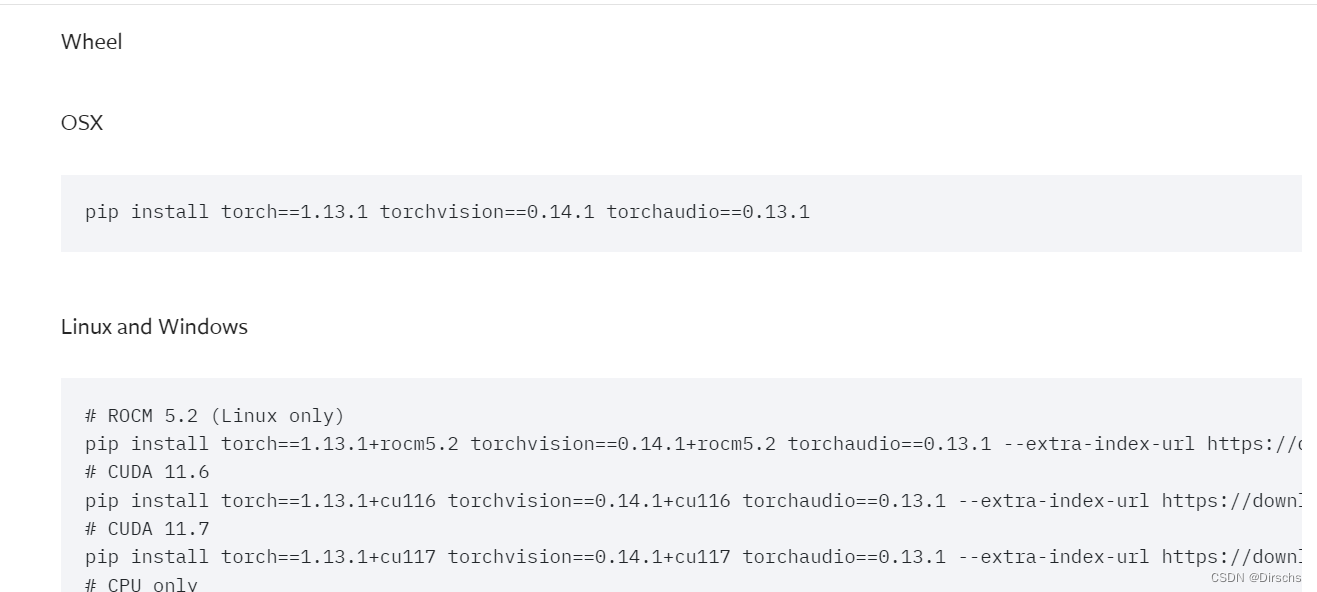

这里选择了1.13.1pip版本:

安装命令如下:

pip install torch==1.13.0+cu117 torchvision==0.14.0+cu117 torchaudio==0.13.0 --extra-index-url https://download.pytorch.org/whl/cu1173.检验安装

进入python环境后输入以下命令:

import torch

torch.cuda.is_available()如果输出结果是True则安装成功

4988

4988

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?