1- 数据处理语义

- 对于批处理,fault-tolerant(容错性)很容易做,失败只需要replay,就可以完美做到容错。

- 对于流处理,数据流本身是动态,没有所谓的开始或结束,虽然可以replay buffer的部分数据,但fault-tolerant做起来会复杂的多。

2- 数据一致性语义详解

-

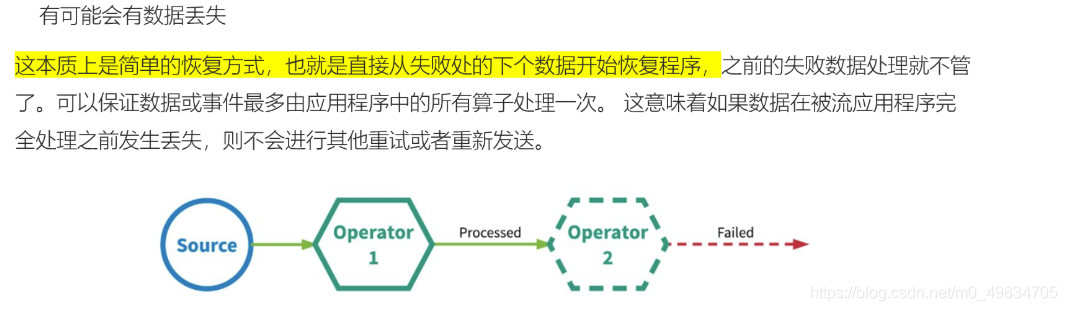

1)、最多一次:

At-most-once:数据可能丢失,没有进行处理

-

2)、至少一次:

At-least-once,数据可能被处理多次

-

3)、精确一次:

Exactly-once,不会丢弃,也不会重复(最理想),Exactly-Once 是 Flink、Spark 等流处理系统的核心特性之一

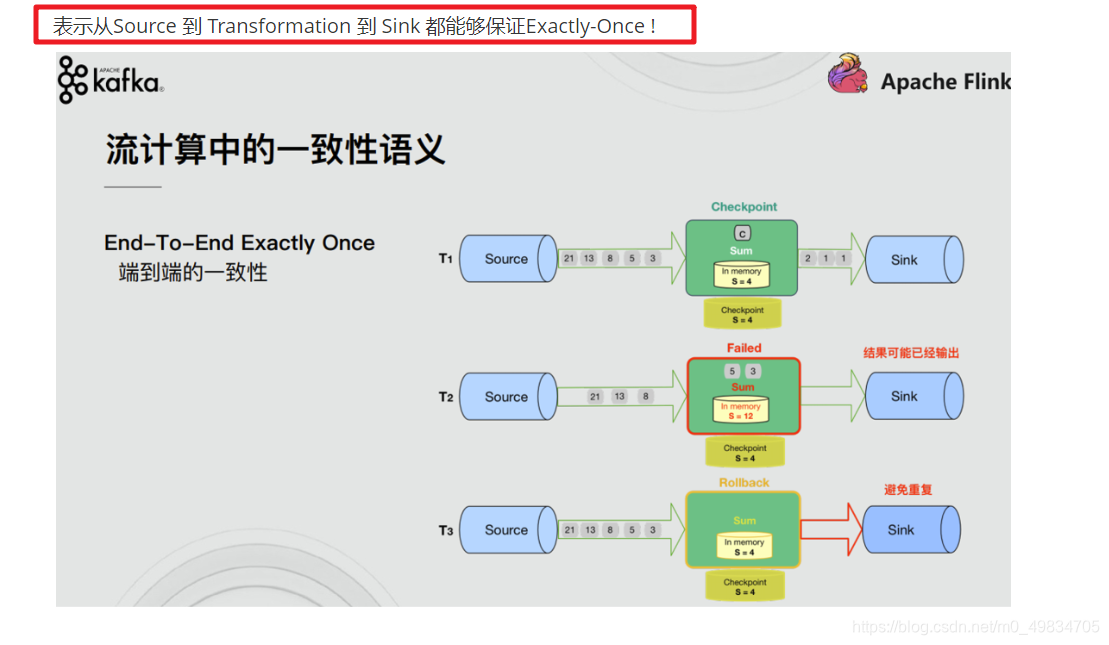

4)、End-to-End Exactly-Once

3- 如何实现局部的Exactly-Once

-

1-去重:

-

2-幂等

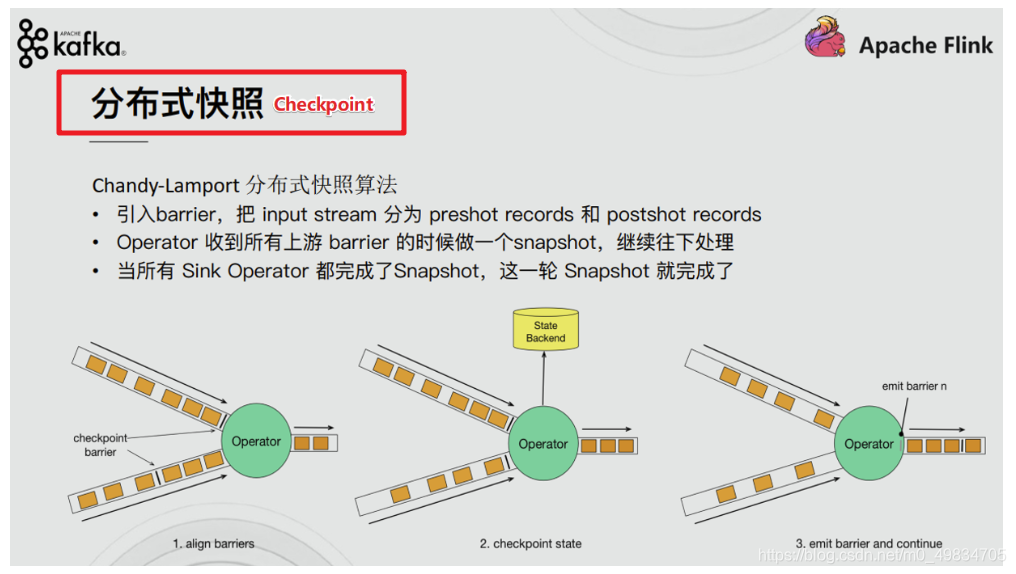

- 分布式快照/Checkpoint—

Flink使用的是这个

- 总结:

4- Flink如何实现End-To-End Exactly-Once

StructuredStreaming 流式应用程序精确一次性语义实现:

- 数据源Source:支持偏移量,比如Kafka支持

- 数据转换Transformation:Checkpoint和WAL预写日志

- 数据终端Sink:支持幂等性

Flink 实现Exactly-Once

- Source: 如Kafka,

offset 支持数据的replay/重放/重新传输 - Transformation: 借助于

Checkpoint - Sink:

Checkpoint + 两阶段事务提交

两阶段事务提交相关API:

两阶段事务提交简单流程:

- SourceOperater从Kafka消费消息/数据并记录offset

- TransformationOperater对数据进行处理转换并做Checkpoint

- SinkOperator将结果写入到Kafka

注意:在sink的时候会执行两阶段提交:

-

1.开启事务

-

2.各个Operator执行barrier的Checkpoint, 成功则进行预提交

-

3.所有Operator执行完预提交则执行真正的提交

-

4.如果有任何一个预提交失败则回滚到最近的Checkpoint

代码演示:

kafka主题flink-kafka1 --->

Flink Source -->

Flink-Transformation做WordCount-->

结果存储到kafka主题-flink-kafka2

//1.创建主题

/export/server/kafka/bin/kafka-topics.sh --zookeeper node1:2181 --create --replication-factor 2 --partitions 3 --topic flink_kafka1

/export/server/kafka/bin/kafka-topics.sh --zookeeper node1:2181 --create --replication-factor 2 --partitions 3 --topic flink_kafka2

//2.开启控制台生产者

/export/server/kafka/bin/kafka-console-producer.sh --broker-list node1:9092 --topic flink_kafka1

//3.开启控制台消费者

/export/server/kafka/bin/kafka-console-consumer.sh --bootstrap-server node1:9092 --topic flink_kafka2

import org.apache.commons.lang3.SystemUtils;

import org.apache.flink.api.common.RuntimeExecutionMode;

import org.apache.flink.api.common.functions.FlatMapFunction;

import org.apache.flink.api.common.functions.MapFunction;

import org.apache.flink.api.common.restartstrategy.RestartStrategies;

import org.apache.flink.api.common.serialization.SimpleStringSchema;

import org.apache.flink.api.common.time.Time;

import org.apache.flink.api.java.tuple.Tuple2;

import org.apache.flink.runtime.state.filesystem.FsStateBackend;

import org.apache.flink.streaming.api.CheckpointingMode;

import org.apache.flink.streaming.api.datastream.DataStream;

import org.apache.flink.streaming.api.datastream.SingleOutputStreamOperator;

import org.apache.flink.streaming.api.environment.CheckpointConfig;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.connectors.kafka.FlinkKafkaConsumer;

import org.apache.flink.streaming.connectors.kafka.FlinkKafkaProducer;

import org.apache.flink.streaming.connectors.kafka.internals.KeyedSerializationSchemaWrapper;

import org.apache.flink.util.Collector;

import java.util.Properties;

import java.util.Random;

import java.util.concurrent.TimeUnit;

/**

* Desc 演示Flink的EndToEnd_Exactly_Once

* 需求:

* kafka主题flink-kafka1 --->Flink Source -->Flink-Transformation做WordCount-->结果存储到kafka主题-flink-kafka2

*/

public class Flink_Kafka_EndToEnd_Exactly_Once {

public static void main(String[] args) throws Exception {

//TODO 0.env

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

env.setRuntimeMode(RuntimeExecutionMode.AUTOMATIC);

//开启Checkpoint

//===========类型1:必须参数=============

//设置Checkpoint的时间间隔为1000ms做一次Checkpoint/其实就是每隔1000ms发一次Barrier!

env.enableCheckpointing(1000);

if (SystemUtils.IS_OS_WINDOWS) {

env.setStateBackend(new FsStateBackend("file:///D:/ckp"));

} else {

env.setStateBackend(new FsStateBackend("hdfs://node1:8020/flink-checkpoint/checkpoint"));

}

//===========类型2:建议参数===========

//设置两个Checkpoint 之间最少等待时间,如设置Checkpoint之间最少是要等 500ms(为了避免每隔1000ms做一次Checkpoint的时候,前一次太慢和后一次重叠到一起去了)

//如:高速公路上,每隔1s关口放行一辆车,但是规定了两车之前的最小车距为500m

env.getCheckpointConfig().setMinPauseBetweenCheckpoints(500);//默认是0

//设置如果在做Checkpoint过程中出现错误,是否让整体任务失败:true是 false不是

//env.getCheckpointConfig().setFailOnCheckpointingErrors(false);//默认是true

env.getCheckpointConfig().setTolerableCheckpointFailureNumber(10);//默认值为0,表示不容忍任何检查点失败

//设置是否清理检查点,表示 Cancel 时是否需要保留当前的 Checkpoint,默认 Checkpoint会在作业被Cancel时被删除

//ExternalizedCheckpointCleanup.DELETE_ON_CANCELLATION:true,当作业被取消时,删除外部的checkpoint(默认值)

//ExternalizedCheckpointCleanup.RETAIN_ON_CANCELLATION:false,当作业被取消时,保留外部的checkpoint

env.getCheckpointConfig().enableExternalizedCheckpoints(CheckpointConfig.ExternalizedCheckpointCleanup.RETAIN_ON_CANCELLATION);

//===========类型3:直接使用默认的即可===============

//设置checkpoint的执行模式为EXACTLY_ONCE(默认)

env.getCheckpointConfig().setCheckpointingMode(CheckpointingMode.EXACTLY_ONCE);

//设置checkpoint的超时时间,如果 Checkpoint在 60s内尚未完成说明该次Checkpoint失败,则丢弃。

env.getCheckpointConfig().setCheckpointTimeout(60000);//默认10分钟

//设置同一时间有多少个checkpoint可以同时执行

env.getCheckpointConfig().setMaxConcurrentCheckpoints(1);//默认为1

//TODO ===配置重启策略:

//1.配置了Checkpoint的情况下不做任务配置:默认是无限重启并自动恢复,可以解决小问题,但是可能会隐藏真正的bug

//2.单独配置无重启策略

//env.setRestartStrategy(RestartStrategies.noRestart());

//3.固定延迟重启--开发中常用

env.setRestartStrategy(RestartStrategies.fixedDelayRestart(

3, // 最多重启3次数

Time.of(5, TimeUnit.SECONDS) // 重启时间间隔

));

//上面的设置表示:如果job失败,重启3次, 每次间隔5s

//4.失败率重启--开发中偶尔使用

/*env.setRestartStrategy(RestartStrategies.failureRateRestart(

3, // 每个测量阶段内最大失败次数

Time.of(1, TimeUnit.MINUTES), //失败率测量的时间间隔

Time.of(3, TimeUnit.SECONDS) // 两次连续重启的时间间隔

));*/

//上面的设置表示:如果1分钟内job失败不超过三次,自动重启,每次重启间隔3s (如果1分钟内程序失败达到3次,则程序退出)

//TODO 1.source-主题:flink-kafka1

//准备kafka连接参数

Properties props1 = new Properties();

props1.setProperty("bootstrap.servers", "node1:9092");//集群地址

props1.setProperty("group.id", "flink");//消费者组id

props1.setProperty("auto.offset.reset", "latest");//latest有offset记录从记录位置开始消费,没有记录从最新的/最后的消息开始消费 /earliest有offset记录从记录位置开始消费,没有记录从最早的/最开始的消息开始消费

props1.setProperty("flink.partition-discovery.interval-millis", "5000");//会开启一个后台线程每隔5s检测一下Kafka的分区情况,实现动态分区检测

//props1.setProperty("enable.auto.commit", "true");//自动提交(提交到默认主题,后续学习了Checkpoint后随着Checkpoint存储在Checkpoint和默认主题中)

//props1.setProperty("auto.commit.interval.ms", "2000");//自动提交的时间间隔

//使用连接参数创建FlinkKafkaConsumer/kafkaSource

//FlinkKafkaConsumer里面已经实现了offset的Checkpoint维护!

FlinkKafkaConsumer<String> kafkaSource = new FlinkKafkaConsumer<String>("flink_kafka1", new SimpleStringSchema(), props1);

kafkaSource.setCommitOffsetsOnCheckpoints(true);//默认就是true//在做Checkpoint的时候提交offset到Checkpoint(为容错)和默认主题(为了外部工具获取)中

//使用kafkaSource

DataStream<String> kafkaDS = env.addSource(kafkaSource);

//TODO 2.transformation-做WordCount

SingleOutputStreamOperator<String> result = kafkaDS.flatMap(new FlatMapFunction<String, Tuple2<String, Integer>>() {

private Random ran = new Random();

@Override

public void flatMap(String value, Collector<Tuple2<String, Integer>> out) throws Exception {

String[] arr = value.split(" ");

for (String word : arr) {

int num = ran.nextInt(5);

if(num > 3){

System.out.println("随机异常产生了");

throw new Exception("随机异常产生了");

}

out.collect(Tuple2.of(word, 1));

}

}

}).keyBy(t -> t.f0)

.sum(1)

.map(new MapFunction<Tuple2<String, Integer>, String>() {

@Override

public String map(Tuple2<String, Integer> value) throws Exception {

return value.f0 + ":" + value.f1;

}

});

//TODO 3.sink-主题:flink-kafka2

Properties props2 = new Properties();

props2.setProperty("bootstrap.servers", "node1:9092");

props2.setProperty("transaction.timeout.ms", "5000");

FlinkKafkaProducer<String> kafkaSink = new FlinkKafkaProducer<>(

"flink_kafka2", // target topic

new KeyedSerializationSchemaWrapper(new SimpleStringSchema()), // serialization schema

props2, // producer config

FlinkKafkaProducer.Semantic.EXACTLY_ONCE); // fault-tolerance

result.addSink(kafkaSink);

//TODO 4.execute

env.execute();

}

}

565

565

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?