线性回归:

先举个例子:比如你去银行贷款,那银行肯定会先对你进行调查,再确定是否对你进行放贷,或者放贷的额度,最终决定你个人贷款额度的指标称为特征。比如你的个人年龄,月收入,户口,家庭关系等。取两个最简单的特征,年龄和工资,设为x1,和x2,获得贷款的额度为y,β1为年龄的参数,β2为工资的参数(解释一下β的含义,这是一个系数,不一样的特征其对应的系数大小也不一样,如你的年龄在20-30之间,那银行对你放贷的额度正常来说会比50-60之间年龄的人的额度大,亦或者是特征月收入,你月薪10万去贷款肯定比月薪3k的人去贷款获得的额度大,这里所体现的就是β的大小)。

有了这些自变量,应变量和特征系数,我们可以得到一个给你贷款额度线性方程,为:

![]()

后面的计算中要运用矩阵进行计算,为了方便计算,我们要将这个矩阵变成一个方阵来辅助我们计算,我们需要给β0添加一个x0(x0=1),这样在变成方阵后不会影响计算的结果,反而会减少计算工作量。可以得到向量公式:

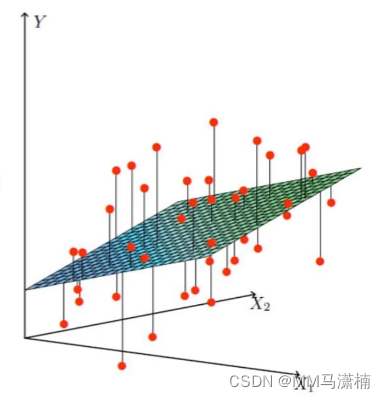

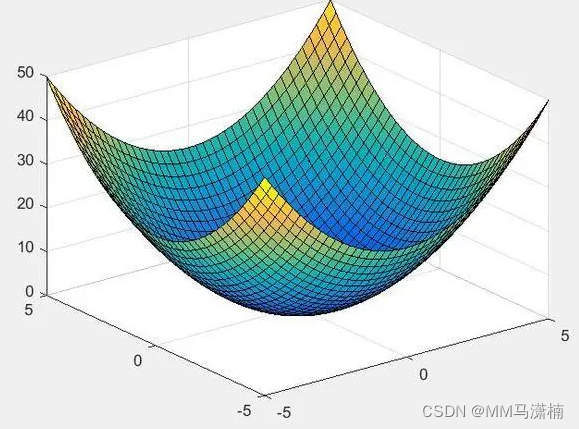

大致的图像可以表示成这样:

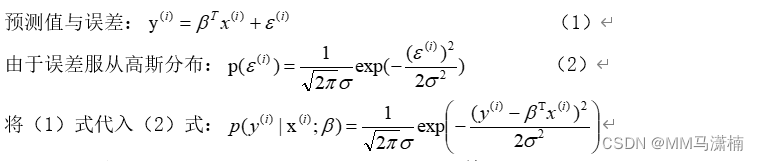

在真实计算中,所计算出来的值为预测值,与真实的值会有误差,所以我们加入一个来表示误差。对于每个样本,我么可以得到这样一个公式:

![]()

所得的所有数据点成正态分布,再数据越密集的地方,对应的误差也会越小,可以看到,对于每个点的

是独立且具有相应的分布,并且服从高斯分布:

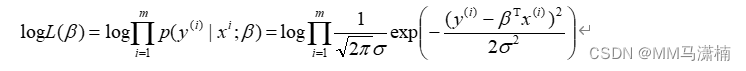

介绍一下似然函数,简单来说就是用于求什么样的参数跟我们的数据组合后恰好是真实值的函数。似然函数:![]()

由于这样的的乘法函数比较难求解,但如果我们能换成加法就会变得比较容易求解,由于对数里面的乘法可以转换成加法,所以我们可以直接将等式两边转换成对数来进行求解,转换后可得对数似然函数为:

我们将右侧式子展开,可得:

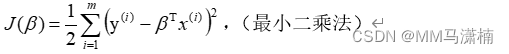

由于西格玛是一个常数,为常数,若让释然函数越大,就要让后面的变量越小,于是我们可以得到:

因为我们是要找最小值,所以可以对目标函数J(β)求偏导,灵丘偏导等于0,即可以得到改式子的最小值。

现在将式子转换成了矩阵的形式,就面临一个问题,并不是所有的矩阵都可你,如果矩阵X不可逆,我们就无法求出我们想要的β值。

梯度下降(优化算法):

接着上面得到的结果。当我们得到了这样一个目标函数后,经过一系列的求解,不一定可以得到最终的解,机器学习的许多算法中,是无法求解出真实的答案(线性回归是一个特例)。机器学习的套路就是我们给机器一堆数据,然后告诉它什么样的学习方式是对的(目标函数),然后让它朝着这个方向去实现。但是优化无法快速进行,我们需要慢慢地一步步完成迭代,每次优化一点点,最终得到我们想要的数据。

如图,假如我们最优解的值是最低的点,那我们可以对某个点做一定位置的移动,再判断新的点是否是我们想要的解。当然移动会有偏差,会往好的地方移动也会往不好的地方移动,所以这个迭代的过程非常缓慢。对于我们上面得到的公式,要求出所有样本平均的最优的方向(一共m个),所以我们要除m。

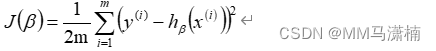

梯度下降,得到目标函数:

我们对其中一个β求偏导,设为,而其他的参数β都可以看作是常数,经过偏导操作后都为0。因为要找到最低的点的位置,所以要按当前点的切线的反方向运动。

批量梯度下降会得到最优解,但是当样本很大的时候,求解的速度非常慢。

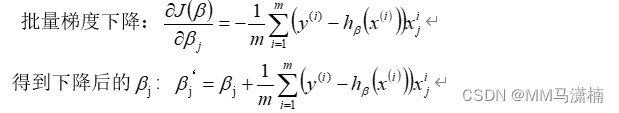

因为批量梯度下降是将所有的样本都进行求解,最后取解的平均值来获取最优解,但我们不用全部遍历的话,求解的速度将会大幅度提升。

随机梯度下降:![]()

虽然随机梯度下降的的迭代速度快了很多。但问题是,不一定每次的方向都是朝着收敛的方向,这样我们所得的解就不可控了,所得的解也会与真实情况有所偏差。既然批量梯度下降的速度慢,随机梯度下降的解质量不高,那我们能否得到一种模型,速度又快,解质量又高的呢?

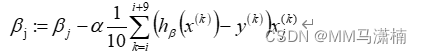

运用小批量梯度下降

每次更新选择一小部分的数据来算,可以根据电脑性能来选择样本的的大小,一般不小于64个样本。表示学习率,对结果会产生巨大的影响,学习率越大,数据更新的越大,学习率越小,数据更新的越小,一般选择小一些。

因为很多算法不存在最好的解,只有最优的解,所以我们要学会优化的思想,不断的去优化我们的算法,去获得最优解。

今天的学习到此为止,如果读者有耐心读到了这里,我深表感谢与荣幸,希望你们也越变越好。

4026

4026

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?