这是第二次刷机器学习做的笔记,第一次没做笔记,只是大体上理解了机器学习是干什么的,有了个框架

机器学习概述

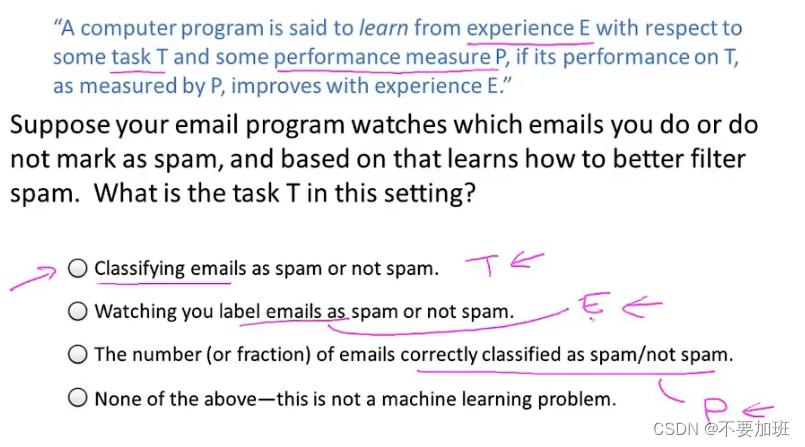

什么是机器学习

简单来说,就是让计算机具有自主学习的能力

监督学习 Supervised Learning与无监督学习 Unsupervised Learning

简单来说,监督学习就是我们教计算机做事,而无监督学习就是计算机自己学习。

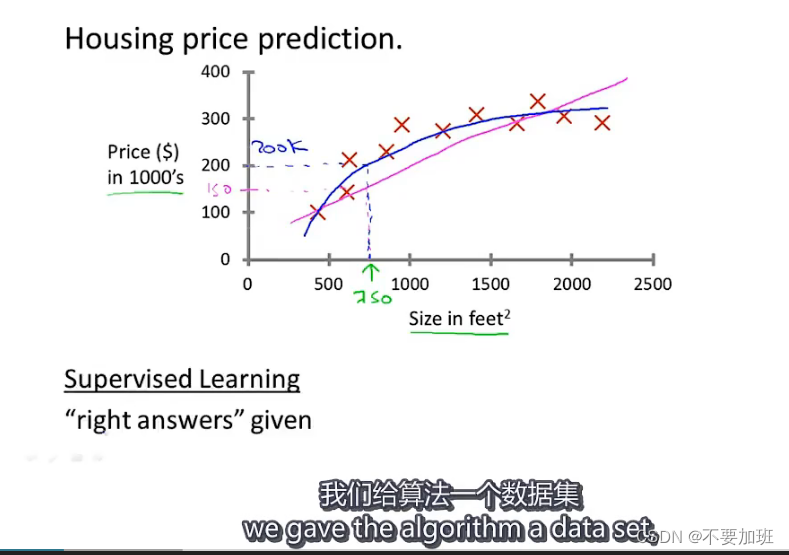

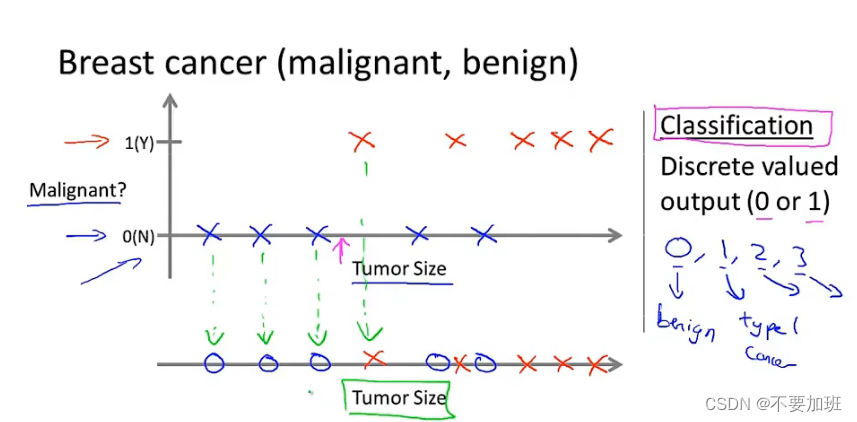

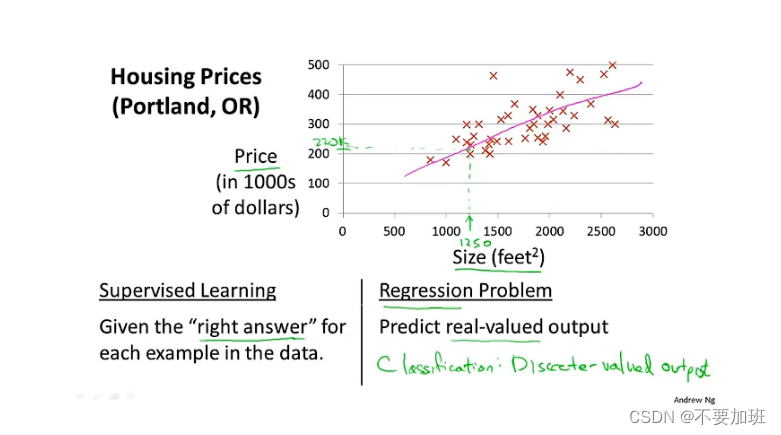

Supervised Learning

数据集里包含正确答案

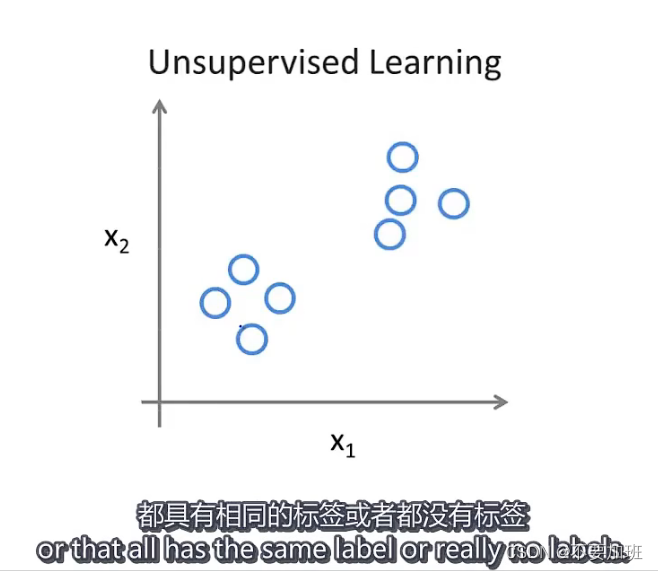

Unsupervised Learning

与监督学习不同,无监督学习的数据具有以下特点

线性回归 Linear Regression

模型描述

房价预测模型

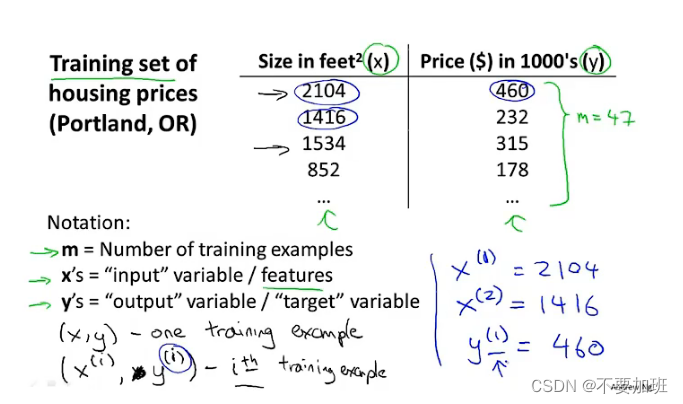

课程中训练集数据的表示方法

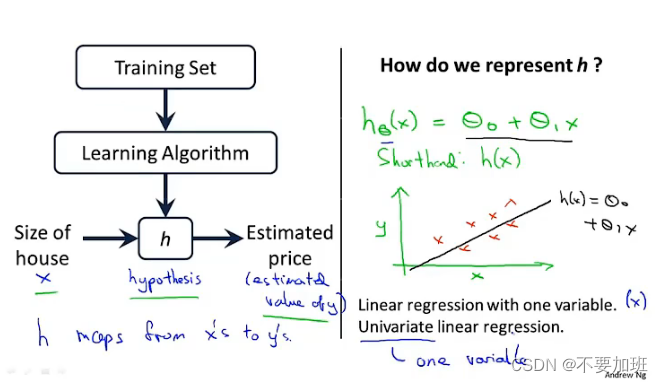

如何工作

首先获取训练集数据,之后由学习算法检验假设函数,获取对于当前训练集拟合程度最好的假设函数

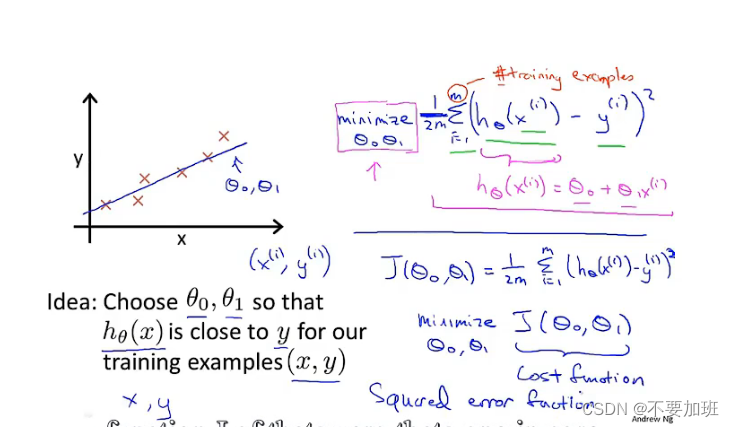

代价函数 Cost Function

代价函数目的及形式

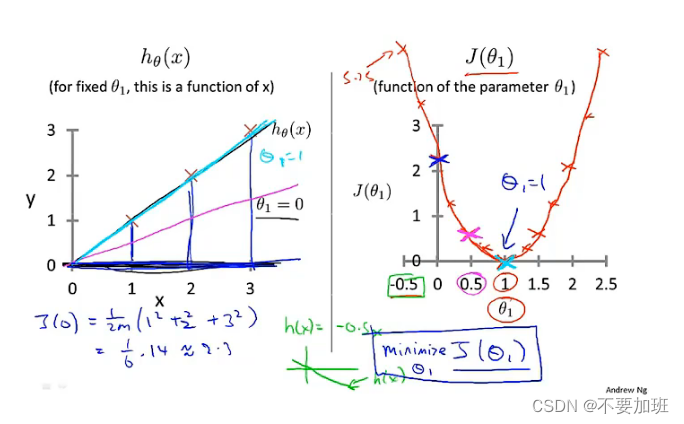

假设函数和代价函数的图形化直观理解

把假设函数简化为只有theta1,在图中可以看出,代价函数在theta1=1时取得最小值,但是不可能每次都人工来看代价函数的图像来寻找最小值,所以后面要学习梯度下降算法。

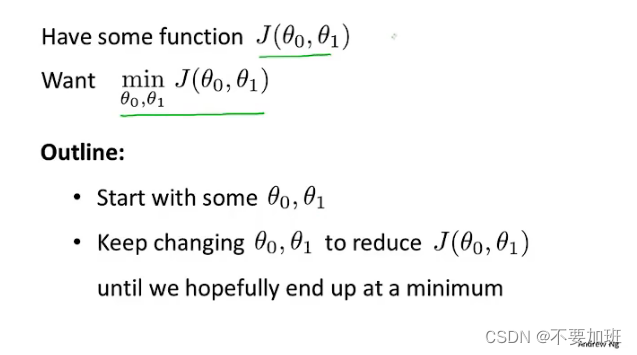

梯度下降 Gradient descent

概述

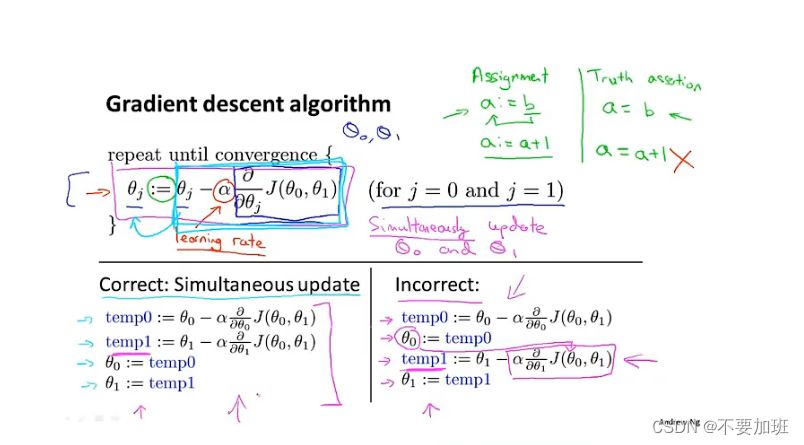

算法具体执行

alpha是学习率,控制的是梯度下降的幅度大小

导数项的意义

控制梯度下降的方向

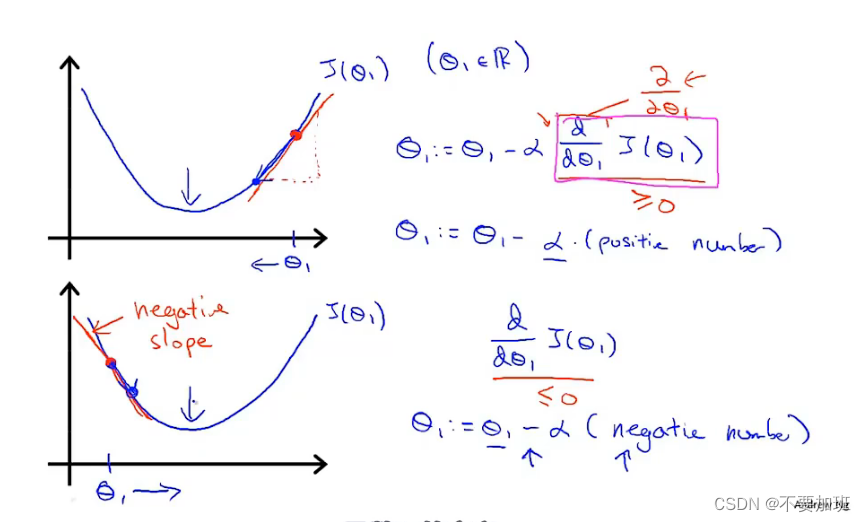

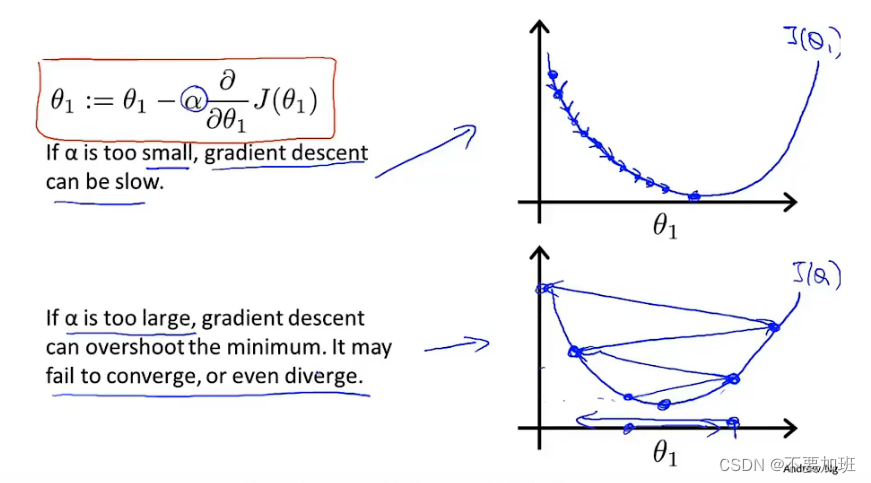

alpha的大小对于梯度下降的影响

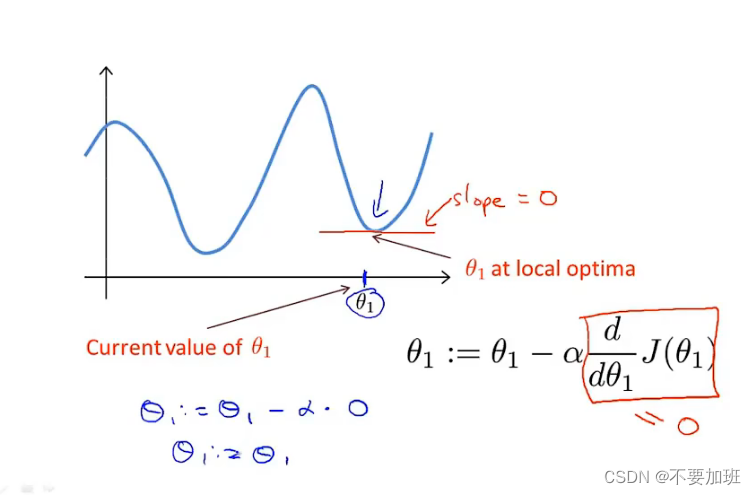

局部最优点的问题

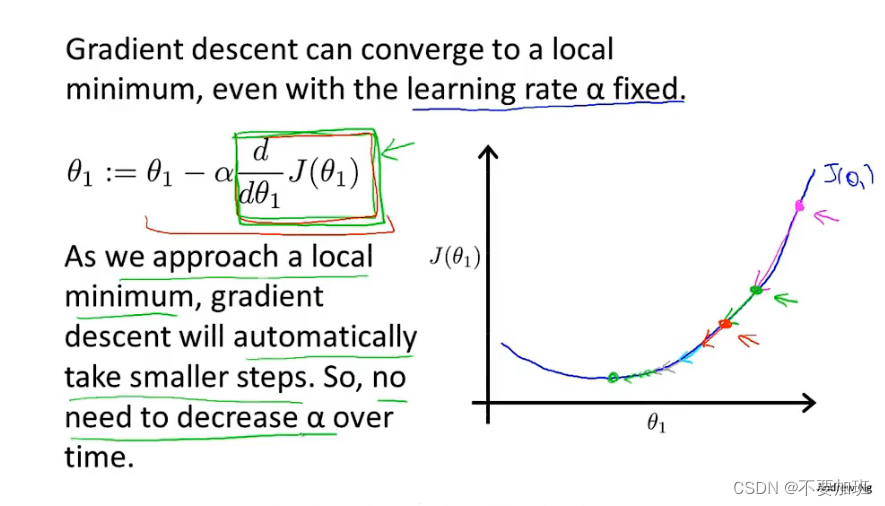

梯度下降过程中步幅会随着斜率的变化自动变化

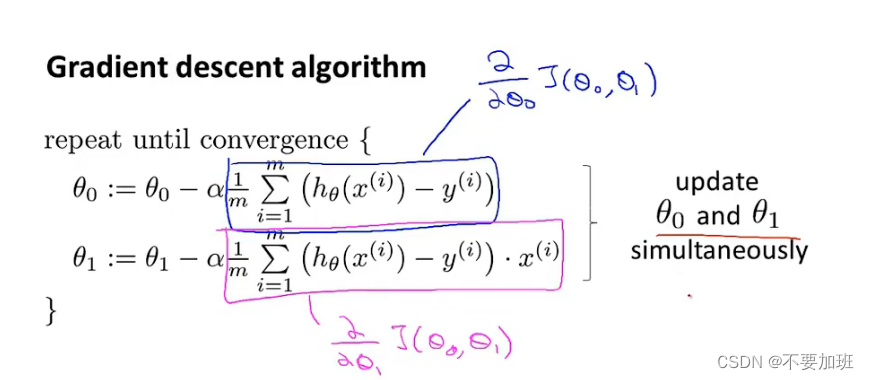

梯度下降应用于解决线性回归问题

算法具体执行

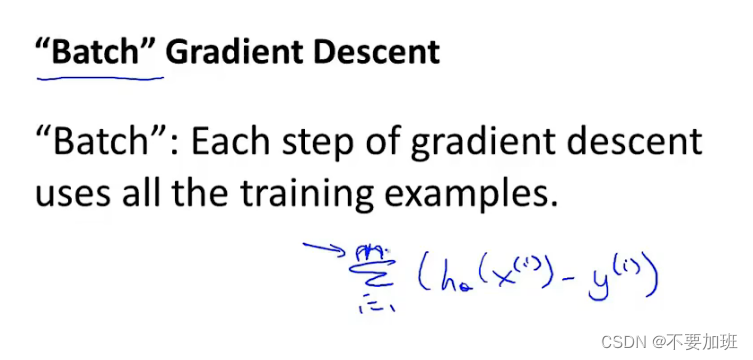

repeat until convergence

别名

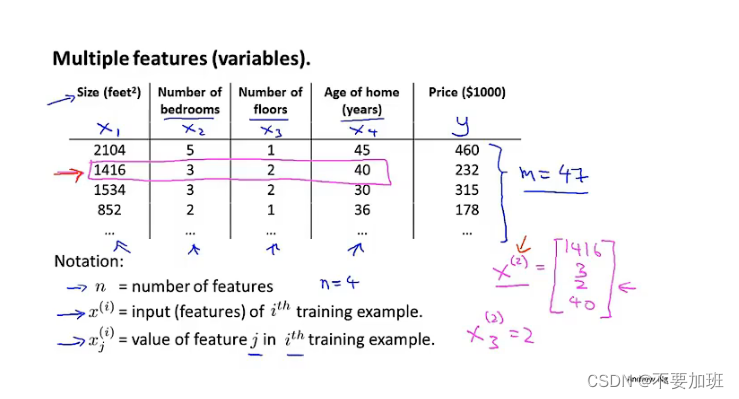

多元线性回归 Linear Regression with multiple variables

模型描述

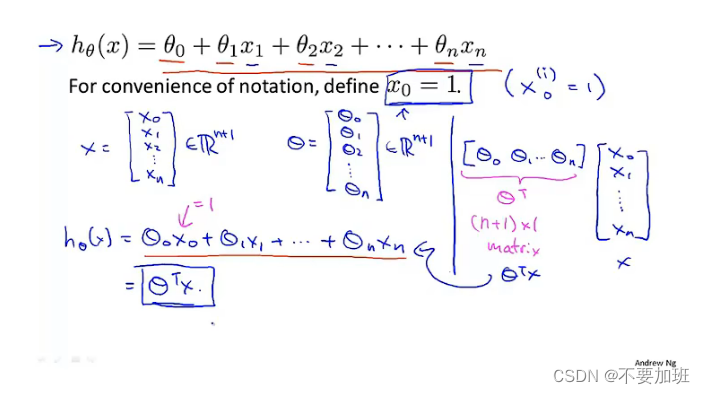

假设函数的建立及简化

多元梯度下降 Gradient descent for multiple variables

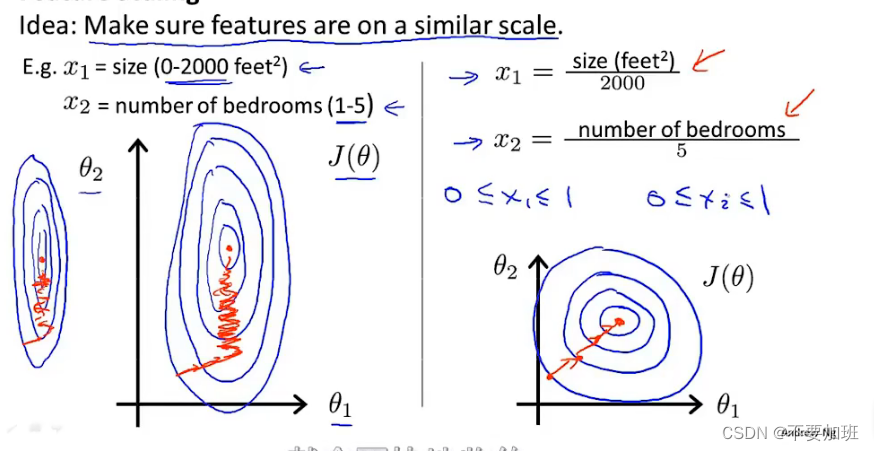

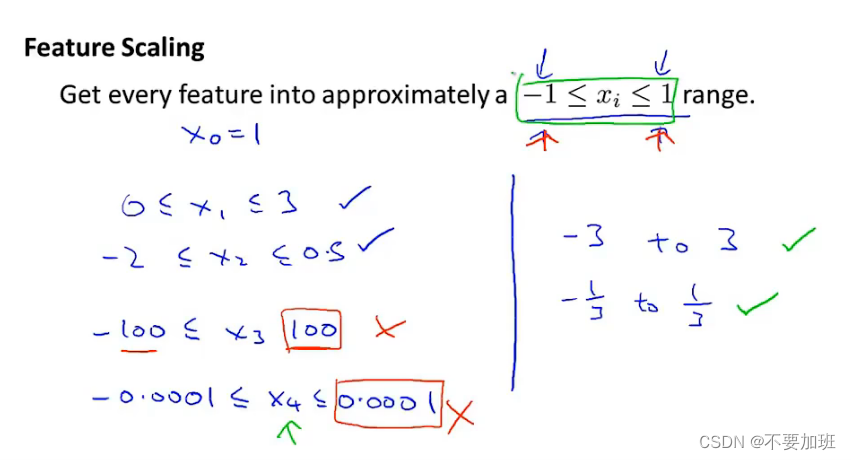

特征缩放 Feature Scaling

目的:使特征处于一个相似的范围,加快梯度下降收敛速度

适当的范围

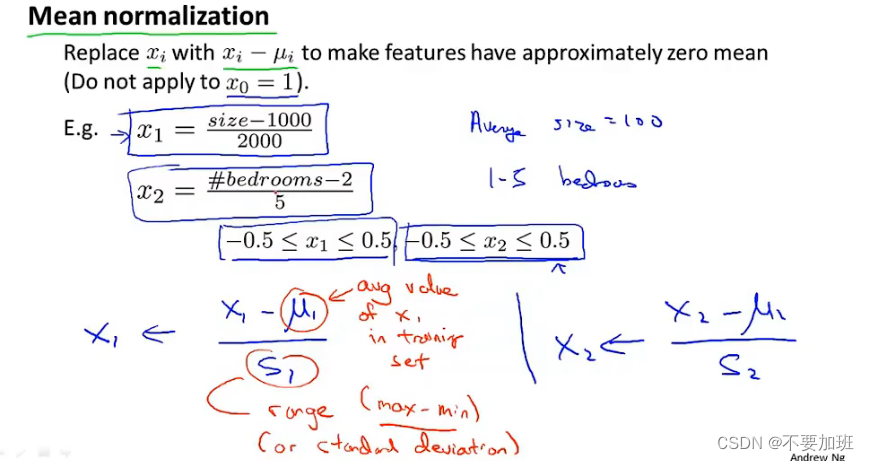

均值归一化

将不同特征的值映射到大小相近的区间(区间一定是接近于对称的),消除量纲对最终结果的影响,使不同的特征具有可比性,使得原本可能分布相差较大的特征对模型有相同权重的影响,提升模型的收敛速度,深度学习中数据归一化可以防止模型梯度爆炸。

S1可以是 max-min,或者是方差。

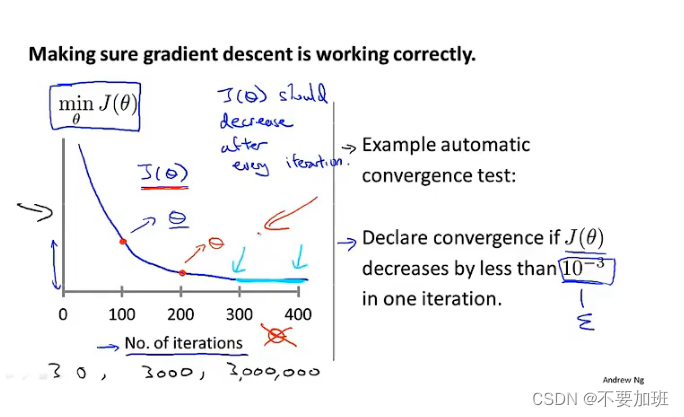

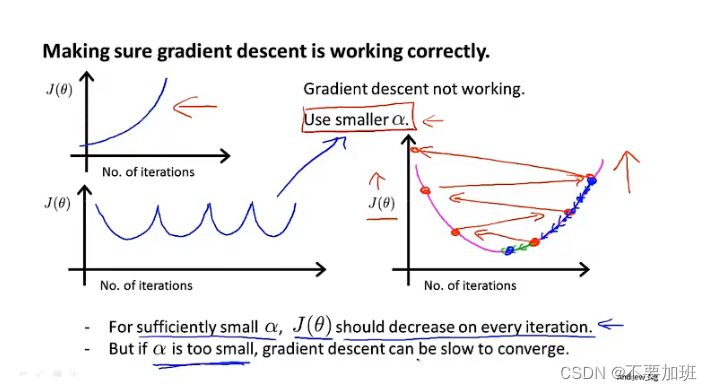

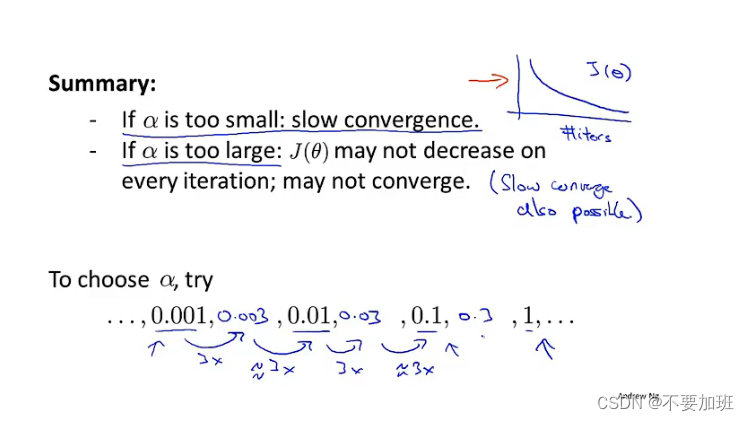

学习率 Learning rate

通过图像判断梯度下降算法是否正常工作

总结及alpha选择技巧

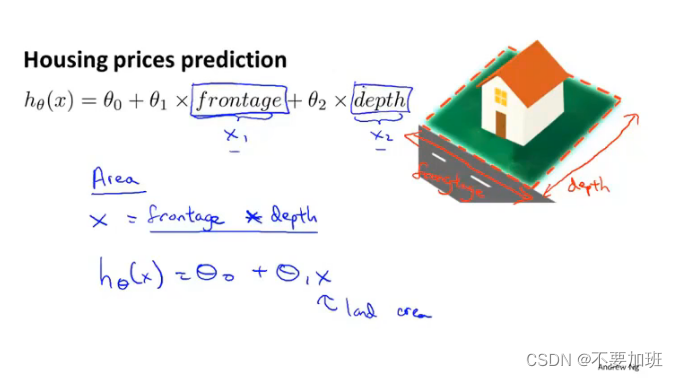

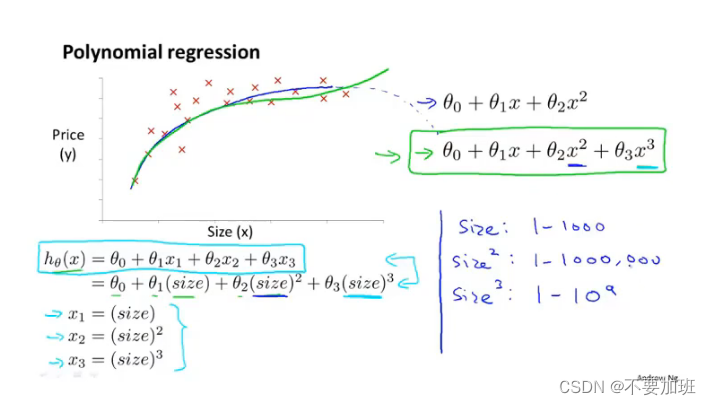

特征与多项式回归 Features and polynomial regression

选择新的特征去创建更好的模型

用多项式回归时注意特征缩放

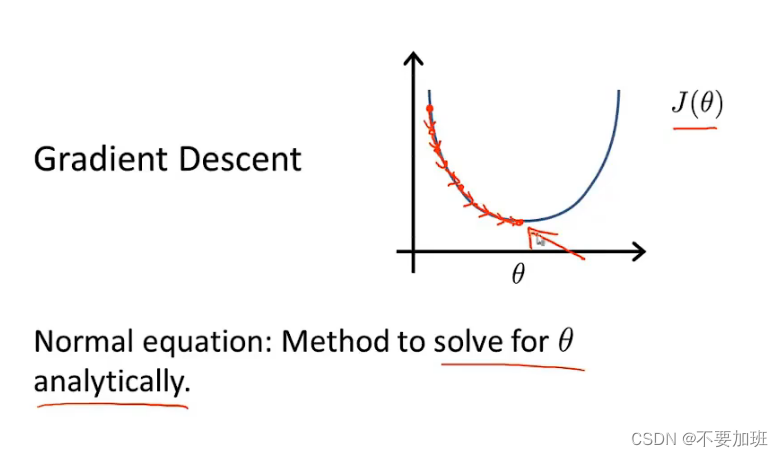

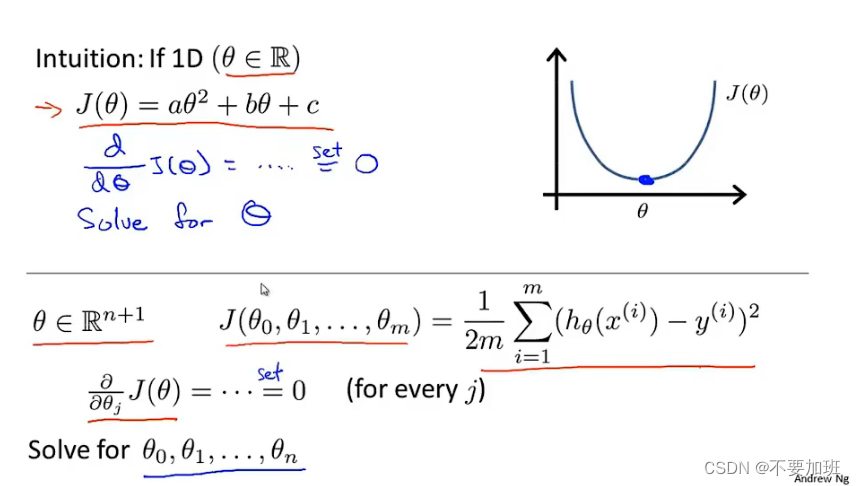

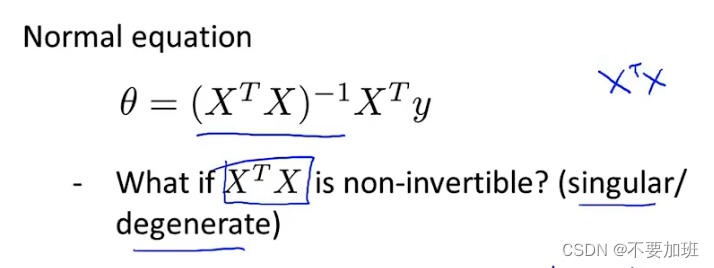

正规方程 Normal equation

直观的理解

运算量大

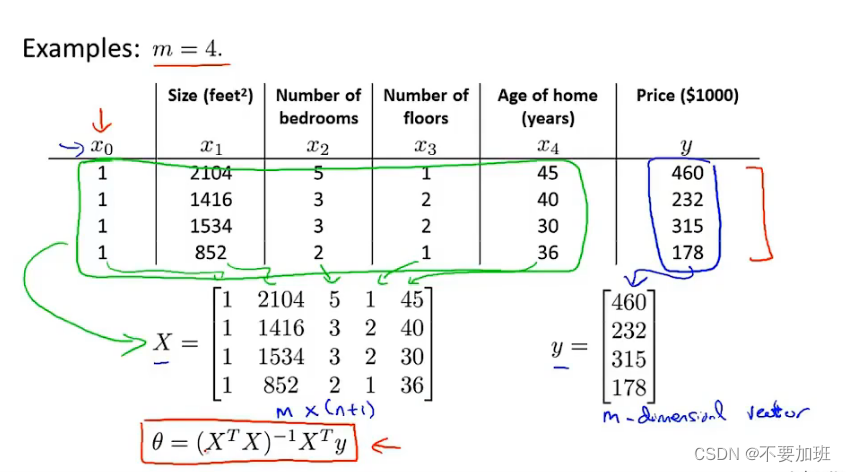

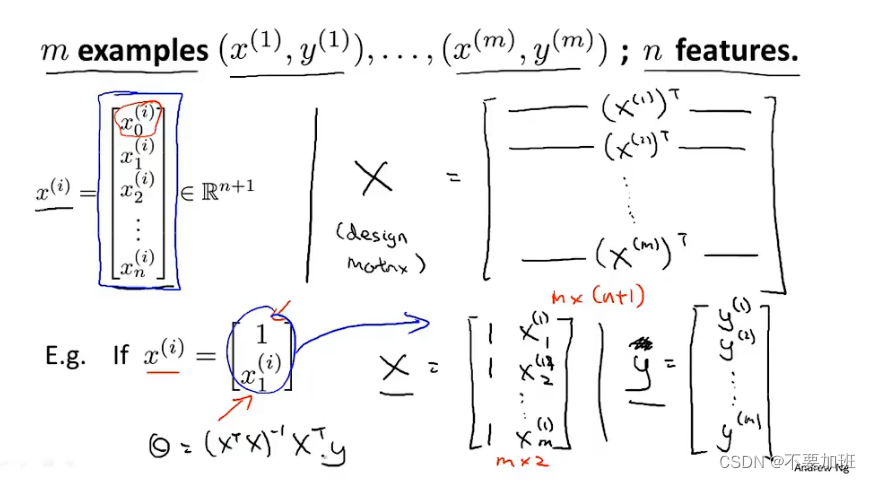

利用线性代数计算

利用线性代数计算

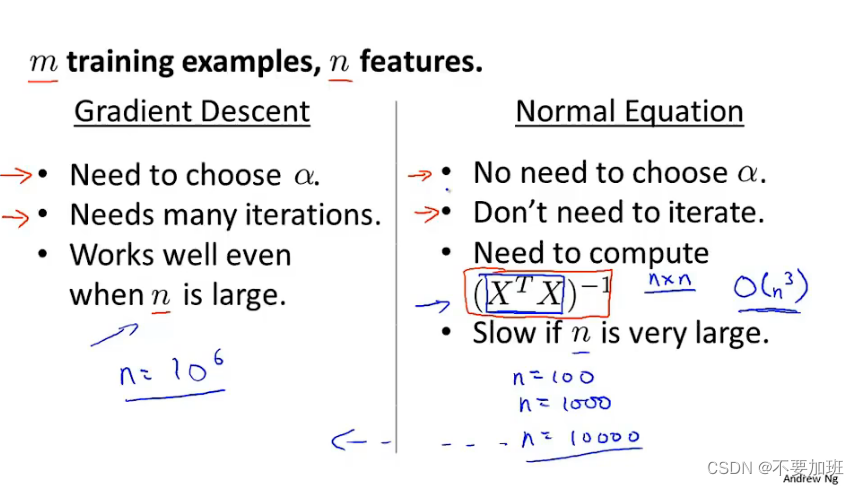

梯度下降和正规方程的优缺点对比

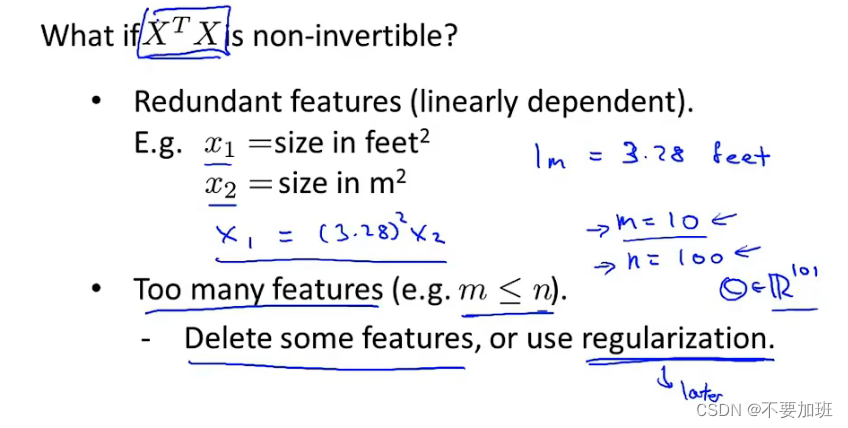

正规方程不可逆

原因

1897

1897

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?