引言:向量搜索的重要性

在现代人工智能技术的快速发展中,长期记忆能力已成为AI系统的一项基础功能。而在这一能力的核心,则是向量搜索技术。向量搜索不仅是AI长期记忆的关键,还广泛应用于搜索引擎、知识库、内容审核工具和推荐系统等大规模媒体处理系统中。可以说,向量搜索技术正处于人工智能和数据库管理系统的交叉点上,具有重要的理论价值和实际应用前景。

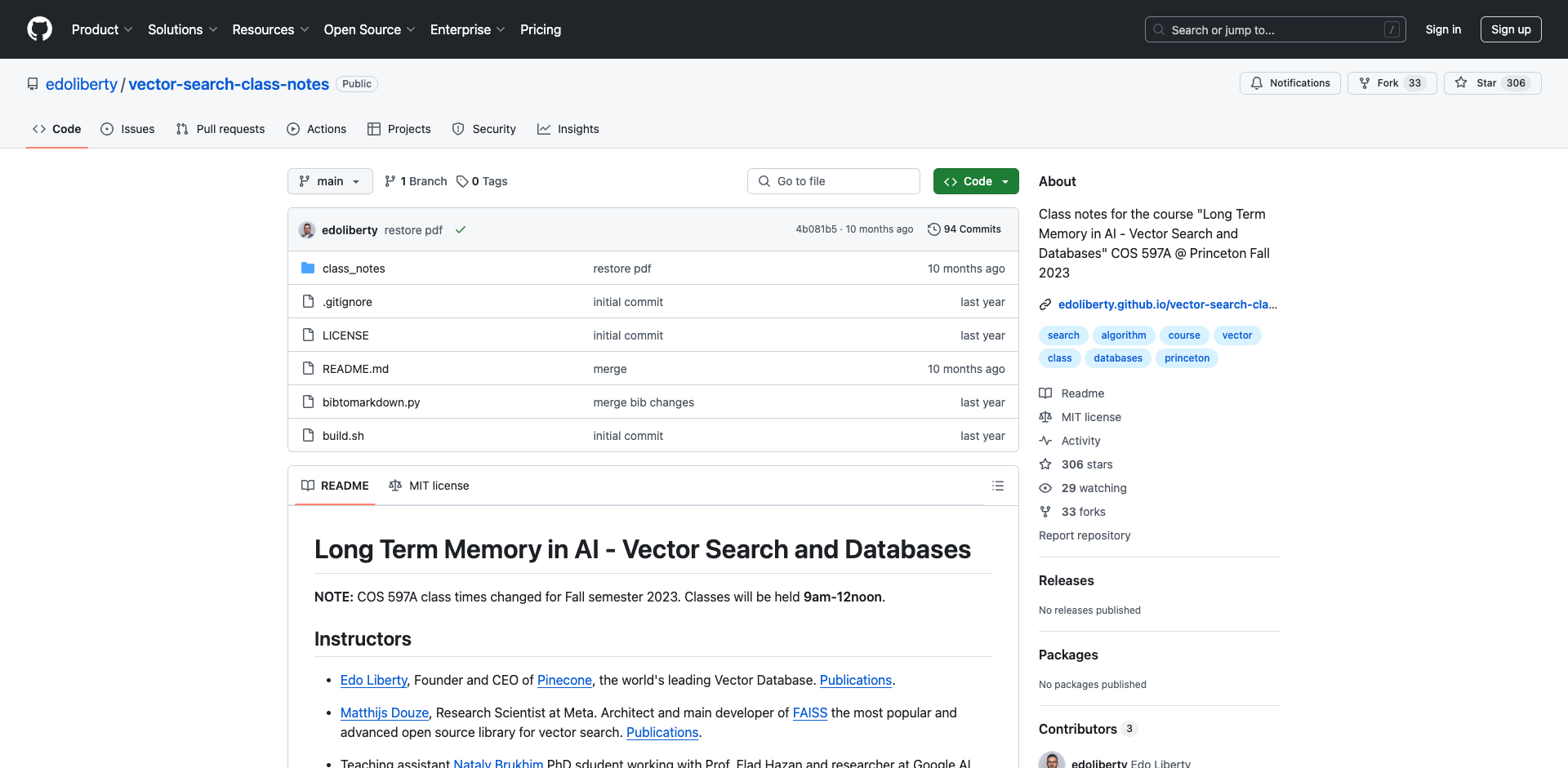

为了深入了解这一关键技术,普林斯顿大学开设了名为"人工智能中的长期记忆 - 向量搜索与数据库"的课程(课程代号COS 597A)。本文将对该课程的核心内容进行详细解析,帮助读者全面了解向量搜索技术的理论基础和实际应用。

课程概述

该课程由多位业界顶尖专家联合授课,包括:

- Edo Liberty:Pinecone(全球领先的向量数据库公司)的创始人兼CEO。

- Matthijs Douze:Meta公司的研究科学家,同时也是最受欢迎的开源向量搜索库FAISS的主要开发者。

- Nataly Brukhim:课程助教,普林斯顿大学博士生。

- Harsha Vardhan Simhadri:微软研究院高级首席研究员,DiskANN的创建者。

课程内容涵盖了向量搜索应用、算法和系统的理论基础和实际实现。学生需要完成项目并进行课堂展示作为评分依据。

课程大纲

课程共分为10个主题,每个主题深入探讨向量搜索技术的不同方面:

- 向量搜索简介

- 文本嵌入

- 图像嵌入

- 低维向量搜索

- 降维技术

- 近似最近邻搜索

- 聚类算法

- 向量压缩的量化技术

- 基于图的索引

- 学生项目和论文展示

向量搜索简介

课程伊始,讲师们介绍了嵌入作为信息瓶颈的概念。与端到端学习不同,嵌入被用作中间表示,这种方法具有可扩展性强、更新即时、可解释性好等优势。课程还讨论了典型的数据量和可扩展性问题,强调了嵌入是管理和访问大型数据库的唯一可行方法。

此外,课程还介绍了"嵌入契约"的概念,即嵌入提取器和嵌入索引器就距离的含义达成一致,从而实现关注点分离。学生们还学习了信息检索中的向量空间模型,以及机器学习中的向量嵌入技术。

文本嵌入

在文本嵌入部分,课程深入探讨了Word2vec和fastText等双层词嵌入技术。这些技术通过共现矩阵的分解获得,能够实现诸如"king + woman - man = queen"这样的嵌入算术运算(这已经基于相似性搜索)。

课程还涵盖了句子嵌入技术,包括其训练方法和属性。最后,讨论了大型语言模型,探讨了当训练集等同于整个网络时会发生什么。

图像嵌入

图像嵌入部分首先介绍了图像的像素结构和早期的直接像素索引工作。随后,课程讨论了传统的计算机视觉模型,包括全局描述符(如GIST)和局部描述符(如SIFT)。

课程还深入探讨了卷积神经网络,包括现成的模型和专门训练的模型(如对比学习、自监督学习)。最后,介绍了现代计算机视觉模型。

低维向量搜索

在低维向量搜索部分,课程首先定义了向量搜索问题,然后介绍了k-d树等空间划分数据结构。课程还提供了k-d树最坏情况的证明。

此外,课程回顾了基本的概率不等式(如马尔可夫不等式、切尔诺夫界、霍夫丁不等式),并讨论了测度集中现象。最后,探讨了高维空间中随机向量的正交性,以及维数灾难和空间划分的失效问题。

降维技术

降维技术是向量搜索中的重要组成部分。课程详细介绍了奇异值分解(SVD)及其应用,包括在谱范数和Frobenius范数下的秩-k近似。

此外,课程还涵盖了主成分分析(PCA)、最优平方损失降维、最近正交矩阵等主题。最后,讨论了SVD的计算方法(如幂法)以及随机投影技术。

近似最近邻搜索

近似最近邻搜索(ANNS)是向量搜索中的核心问题。课程首先定义了ANNS问题,并讨论了评估ANNS算法的关键标准,包括速度、准确性、内存使用、可更新性和索引构建时间。

随后,课程介绍了局部敏感哈希(LSH)的定义和示例,详细讲解了LSH算法及其正确性分析和渐近性能。

聚类算法

聚类是向量搜索中的另一个重要主题。课程重点讲解了K-means聚类算法,包括其均方误差准则和Lloyd算法。此外,还讨论了k-means与PCA的关系,以及固定维度的ε-net参数。

课程还介绍了基于采样的k-means种子选择方法,如k-means++算法。最后,讨论了倒排文件模型(IVF)在向量搜索中的应用。

向量压缩的量化技术

量化技术是实现向量压缩的重要手段。课程首先介绍了向量量化作为一种直接优化目标的方法,然后讨论了二进制量化和汉明比较。

随后,课程深入探讨了积量化、分块向量量化和优化向量量化等技术。此外,还介绍了加性量化及其在训练近似中的难点(如残差量化、CQ、TQ、LSQ等)。最后,比较了粗量化与倒排列表扫描的成本。

基于图的索引

课程的最后一个主题是基于图的索引技术。首先回顾了早期的分层k-means算法,然后介绍了邻域图及其构建方法(如最近邻下降法)。

课程还讨论了邻域图中的贪心搜索及其局限性,强调了长跳跃的必要性。最后,介绍了两种实用的基于图的索引方法:HNSW(层次型可导航小世界图)和NSG(演化k-NN图)。

项目要求

课程要求学生完成一个最终项目,占总成绩的50%,另外50%来自课堂展示。项目可以选择以下三种类型之一:

- 理论/研究:提出一个新算法或修改现有算法,解释其目标并提供实验证据或理论证明。

- 数据科学/AI:使用Pinecone创建一个有趣的向量搜索应用,解释所用数据、应用价值和获得的洞察。

- 工程/高性能计算:改进或扩展FAISS库,解释改进并展示实验结果。

项目时间安排如下:

- 11月24日:提交一页项目提案并获得讲师批准

- 12月1日:提交最终项目

- 12月1日:课堂展示

结语

普林斯顿大学的这门课程全面而深入地覆盖了向量搜索技术的各个方面,从理论基础到实际应用,为学生提供了系统的学习机会。通过学习这门课程,学生不仅能够掌握向量搜索的核心概念和算法,还能了解其在现代AI系统中的关键作用。

随着AI技术的不断发展,向量搜索作为实现长期记忆和大规模数据处理的基础技术,其重要性将日益凸显。无论是在学术研究还是工业应用中,对向量搜索技术的深入理解都将成为AI从业者的重要技能。

这门课程的开放性和实践性也值得称赞。通过鼓励学生参与项目开发和论文展示,课程不仅传授知识,还培养了学生的实践能力和创新思维。这种教学方式无疑将帮助学生更好地应对未来AI领域的挑战。

总的来说,普林斯顿大学的这门向量搜索课程为我们提供了一个深入了解AI长期记忆技术的绝佳窗口。随着这一领域的不断发展,我们期待看到更多创新性的应用和突破性的研究成果涌现。

项目链接:www.dongaigc.com/a/in-depth-analysis-vector-search

https://www.dongaigc.com/a/in-depth-analysis-vector-search

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?