目前玩机器学习的小伙伴,上来就是使用现有的sklearn机器学习包,写两行代码,调调参数就能跑起来,看似方便,实则有时不利于个人能力发展,要知道现在公司需要的算法工程师,不仅仅只是会调参(这种工作,入门几个月的人就可以干了),而是要深入底层,能优化代码,能自己搭。

本文章适合以下几类人:

1)初学者,了解机器学习的实现过程

2)想提升自己的代码能力

第一步:原理

什么是regression回归?

回归是一种用于预测连续数值输出的机器学习算法。回归的原理是基于统计学中的线性回归模型,它试图通过建立输入特征与输出目标之间的线性关系来进行预测。

在回归中,我们首先收集一组包含输入特征和相应输出目标的训练数据。然后,我们使用这些训练数据来拟合一个回归模型,该模型可以表示输入特征与输出目标之间的关系。最常见的回归模型是线性回归模型,它假设输入特征与输出目标之间存在一个线性关系。

线性回归模型可以表示为:y = b0 + b1*x1 + b2*x2 + ... + bn*xn,其中y是输出目标,x1、x2、...、xn是输入特征,b0、b1、b2、...、bn是回归系数。

回归模型的目标是找到最佳的回归系数,使得模型预测的输出值与真实的输出目标之间的差异最小化。常用的方法是最小二乘法,它通过最小化预测值与真实值之间的平方误差来确定最佳的回归系数。

通过训练好的回归模型,我们可以使用新的输入特征来进行预测,即根据输入特征的值计算出对应的输出目标值。

regression的推导,百度一下很多,这里就做一下搬运工了,可参考:机器学习实战 第八章 预测数值型数据:回归_数值预测_LuoY、的博客-CSDN博客

第二步:代码实现

#include <iostream>

#include <stdlib.h>

#include <string>

#include <math.h>

#include "matrix.h"

#include <fstream>

#include <sstream>

#include <stack>

using namespace std;

#define MAX 1000000

#define MIN -100000

/**

线性回归函数的实现,考虑一般的线性回归,最小平方和作为损失函数,则目标函数是一个无约束的凸二次规划问题,

由凸二次规划问题的极小值在导数为0处取到,且极小值为全局最小值,且有闭式解。根据数学表达式实现矩阵之间的运算求得参数w。

**/

/**

线性回归函数的实现,考虑一般的线性回归,最小平方和作为损失函数,则目标函数是一个无约束的凸二次规划问题,

由凸二次规划问题的极小值在导数为0处取到,且极小值为全局最小值,且有闭式解。根据数学表达式实现矩阵之间的运算求得参数w。

**/

int regression(Matrix x,Matrix y)

{

}

/**

局部加权线性回归是在线性回归的基础上对每一个测试样本(训练的时候就是每一个训练样本)在其已有的样本进行一个加权拟合,

权重的确定可以通过一个核来计算,常用的有高斯核(离测试样本越近,权重越大,反之越小),这样对每一个测试样本就得到了不一样的

权重向量,所以最后得出的拟合曲线不再是线性的了,这样就增加的模型的复杂度来更好的拟合非线性数据。

**/

//需要注意的是局部加权线性回归是对每一个样本进行权重计算,所以对于每一个样本都有一个权重w,所以下面的函数只是局部线性回归的一个主要辅助函数

Matrix locWeightLineReg(Matrix test,Matrix x,Matrix y,double k)

{

}

/**

通过调用上面的局部加权线性回归函数实现对每一个测试样例确定最后的参数,同样以列向量的形式存储,对n个特征的样本就n行,对m个样本就一个m列,

**/

int lwlrtest(Matrix x,Matrix y,double k)

{

int i,j;

Matrix test;

test.initMatrix(&test,1,x.row);

Matrix wsOne;

wsOne.initMatrix(&wsOne,x.row,1);

Matrix ws;

ws.initMatrix(&ws,x.row,x.col);

/**

每一个样本单独调用局部加权线性回归

**/

for(i=0;i<ws.row;i++)///ws以列为一个权重参数向量,m列表示m个样本

{

test=test.getOneCol(x,i);

wsOne=locWeightLineReg(test,x,y,k);

for(j=0;j<ws.col;j++)

{

ws.mat[j][i]=wsOne.mat[j][0];

}

}

for(i=0;i<ws.row;i++)

{

for(j=0;j<ws.col;j++)

{

cout<<ws.mat[j][i]<<" ";

}

cout<<endl;

}

Matrix yPredict;

yPredict.initMatrix(&yPredict,x.col,1);

/**验证局部加权线性回归的正确性*/

double yy;

for(i=0;i<ws.row;i++)

{

yy=0;

for(j=0;j<ws.col;j++)

{

yy+=ws.mat[j][i]*x.mat[i][j];

}

cout<<"y="<<yy<<endl;

yPredict.mat[i][0] = yy;

}

double corVal = y.correlation(y,yPredict);

cout<<"correlation val "<<corVal<<endl;

return 0;

}

/**

下面的岭回归函数只是在一般的线性回归函数的基础上在对角线上引入了岭的概念,不仅有解决矩阵不可逆的线性,同样也有正则项的目的,

采用常用的二范数就得到了直接引入lam的形式。

**/

int ridgeRegres(Matrix x,Matrix y,double lam)

{

}

int main()

{

dataToMatrix dtm;

cout<<"loadData"<<endl;

cout<<"----------------------"<<endl;

char file[30]="G:/data/regression.txt";

dtm.loadData(&dtm,file);

//dtm.print(dtm);

cout<<"x,y"<<endl;

cout<<"----------------------"<<endl;

Matrix x;

x.loadMatrix(&x,dtm);

Matrix y;

y.initMatrix(&y,x.col,1);

y=y.getOneRow(x,x.row - 1);

//y.print(y);

x.deleteOneRow(&x,x.row);

//x.print(x);

regression(x,y);///调用线性回归函数

//lwlrtest(x,y,1.0);///调用局部加权线性回归函数

//ridgeRegres(x,y,0.1);///调用岭回归函数

return 0;

}

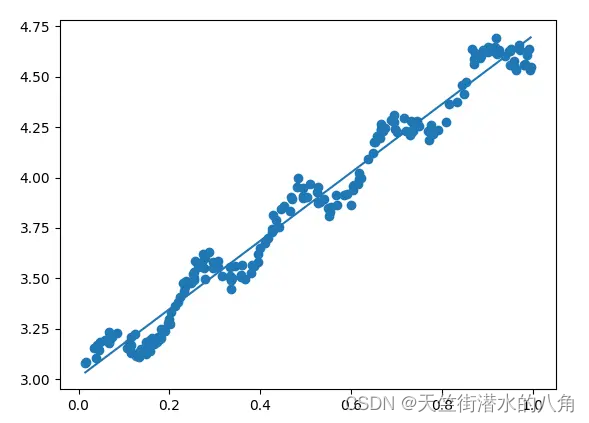

第三步:运行过程

运行结果

用到的软件是vs2010以上的版本都可以,不用额外配置什么,没调包,会用这个软件进行c++开发,就会使用这个软件

此程序由于不调用任何外源库,所以读者可以看清楚每一个算法的原理,要想学好机器学习算法,必须打好基础,不要好高骛远,另外,程序都是有备注,应该很好理解的,实在不懂,可以来问店主

代码的下载路径(新窗口打开链接):机器学习算法regression回归之c++实现(不调用外源库)

有问题可以私信或者留言,有问必答

359

359

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?