看:

哈哈是不是很漂亮?

但这些都不是真实存在的

直接通过 AI 生成的美女

达到如此逼真的地步

是怎么做到的呢?

那么接下来就是:

学习生成小姐姐的正确姿势

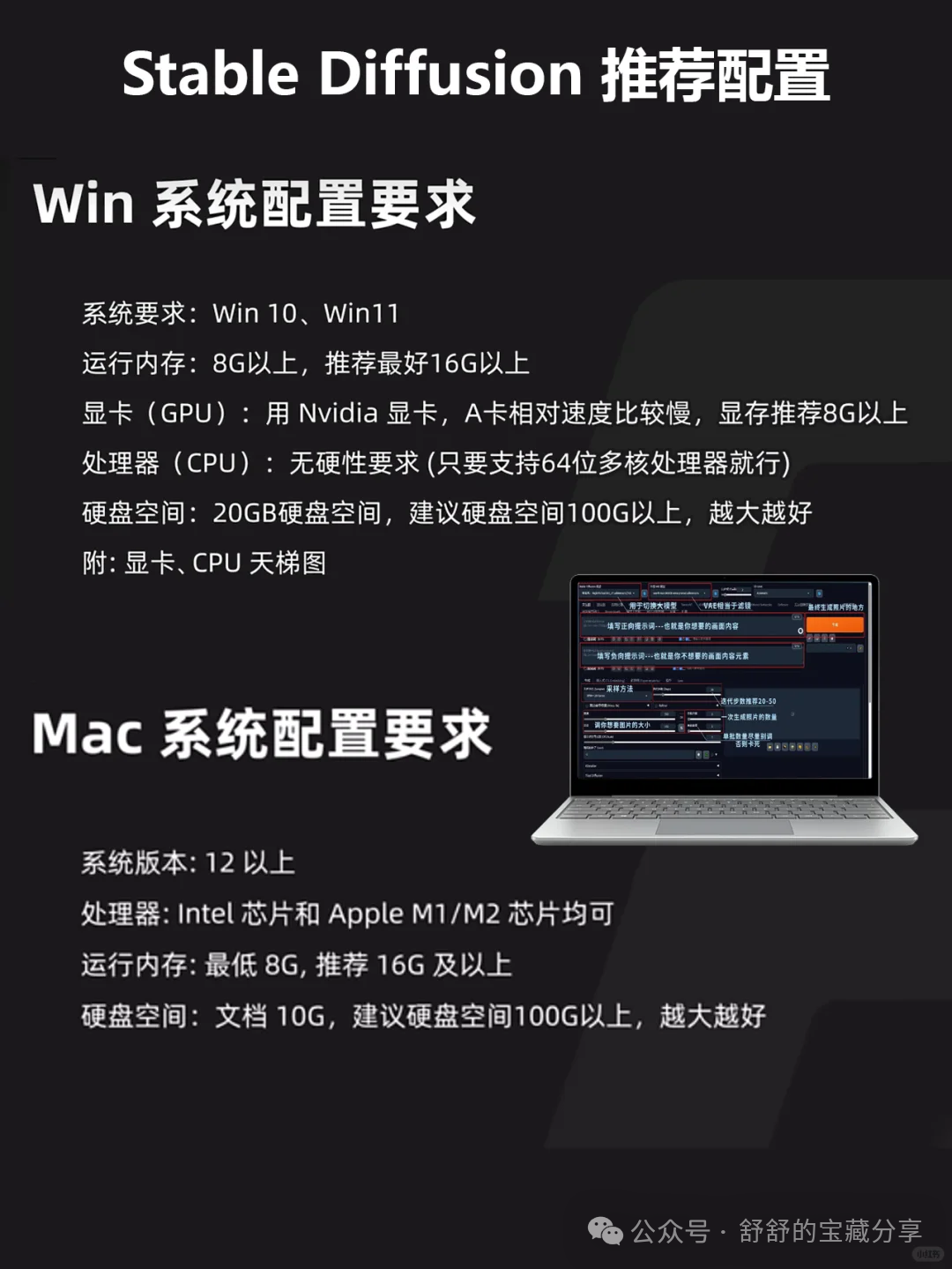

首先需要在你的电脑中

安装一个「stable-diffusion」

(关注下方公众号,点击右下角【联系我】→ 找我获取 )

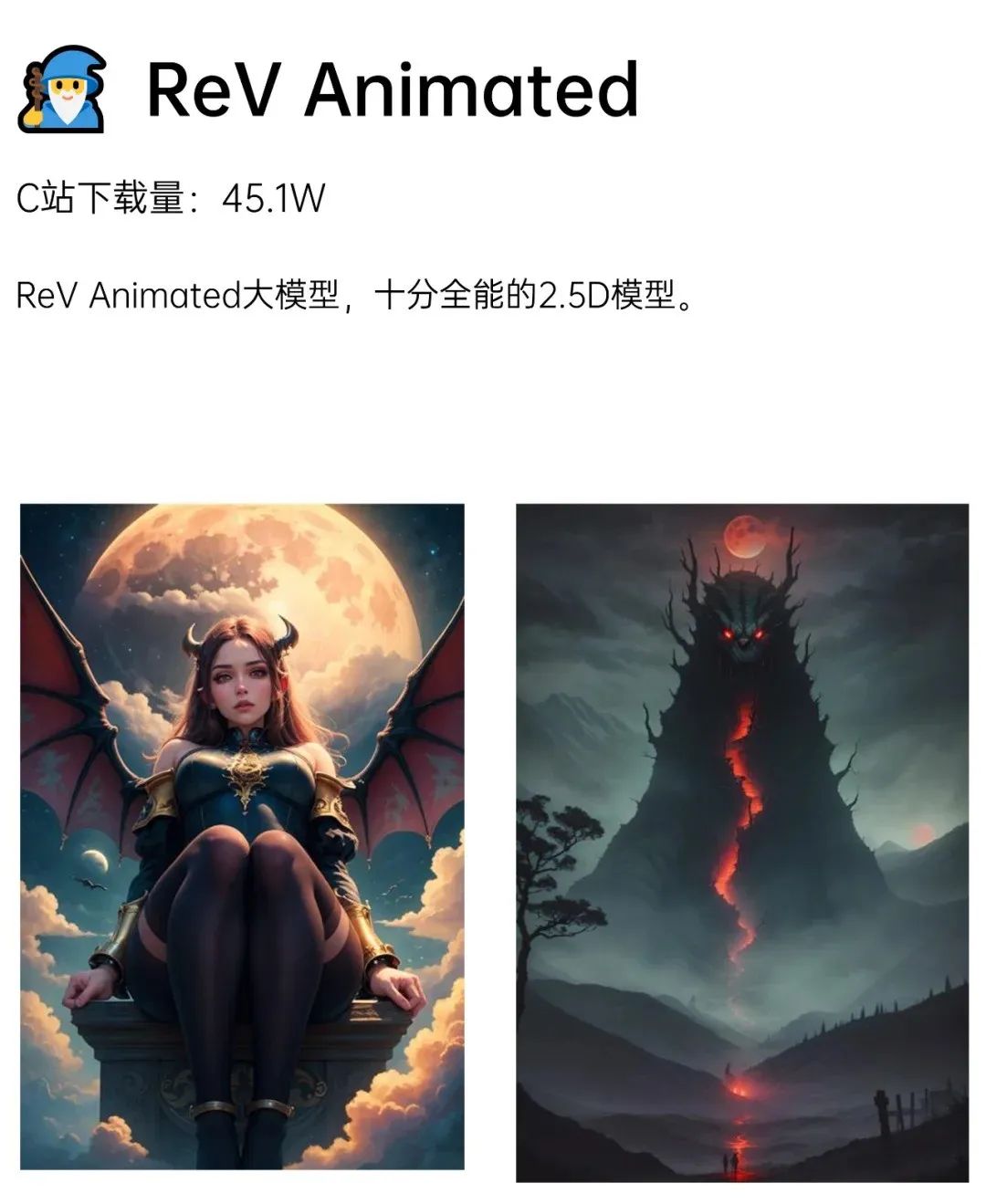

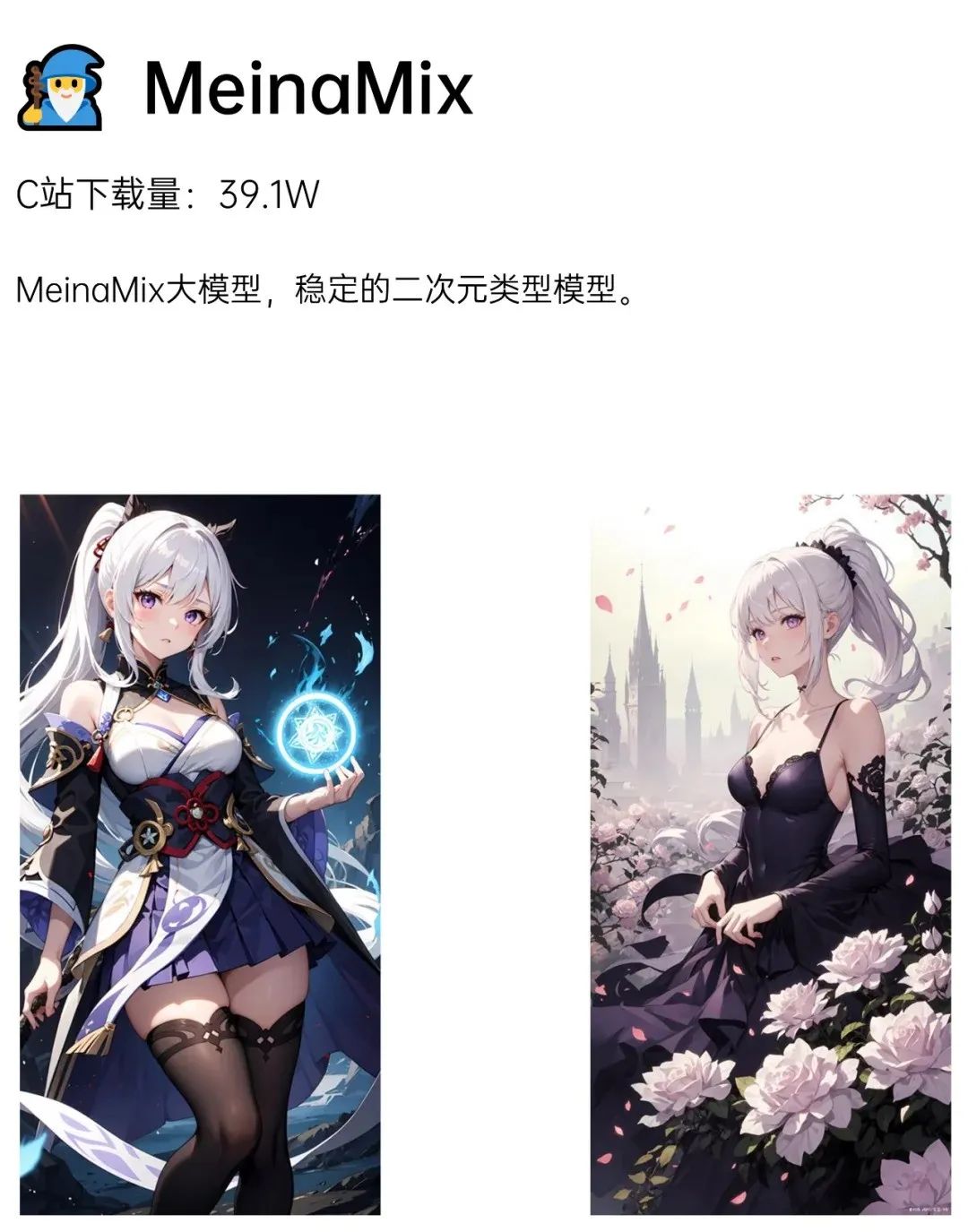

接下来就推荐几个大模型,以下均为个人根据SD软件出图的效果。

真人模型之赛博女友

1.纯欲天花板:majicmixRealistic_v6+ InstantPhotoX2+FilmVelvia2

大模型:majicmixRealistic_v6(v5效果也很好,v7目前没尝试)

LORA:InstantPhotoX2+FilmVelvia2(这个系列也出了3,3没有白底)

负面嵌入词:bad_pictures,negative_hand-negrepair_hand,DeepNagetive_V1 75T(这个是下载了防止所有手崩找的嵌入文件,必备)

麦橘系列+新手士坑必备,这个模型真的太爱了,搭配上摄影风格,什么女友系列。

2.空灵萌妹:mengxMixReal_v2+ADetailer

这个给我一种仙气飘飘的感觉,正如诗经里:“所谓伊人,在水一方”,当时我觉得她真的存在。强就强在只需要一个大模型加上ADetailer插件就能实现。

3.甜美模型LEOSAM’s HelloWorld 新世界 | SDXL真实感大模型_v1.0.

准确来说符合港风,我当时被作者的这个吸引了,质感很棒。我去现了这个图片,真的好看捏

** **

动漫模型之二次元老婆

这个一开始接触的,可以分享几个最近玩的

1.日式动漫风格_v1.0.safetensors

这个效果需要一个LORA, 仰拍视角,聪明的知友可能看出来如果加一个谁的lora,就可以出谁的仰拍视角。不过抛开lora不算,这个日式动漫风格已内置vae,推荐采样步数20+往上,无需开通脸部修复,高清修复推荐R-ESRGAN 4x+ ,重绘幅度建议0.5- 步数20-25

2.超级无敌可爱Rabbit|lovely_One

画风真的太可爱了,这个大模型二次元画风属于卡哇伊行,纯大模型和关键词出图的,可见关键词的作用了吧。参数配置和上面大同小异,

Steps: 20, Sampler: Euler a, CFG scale: 7.0,

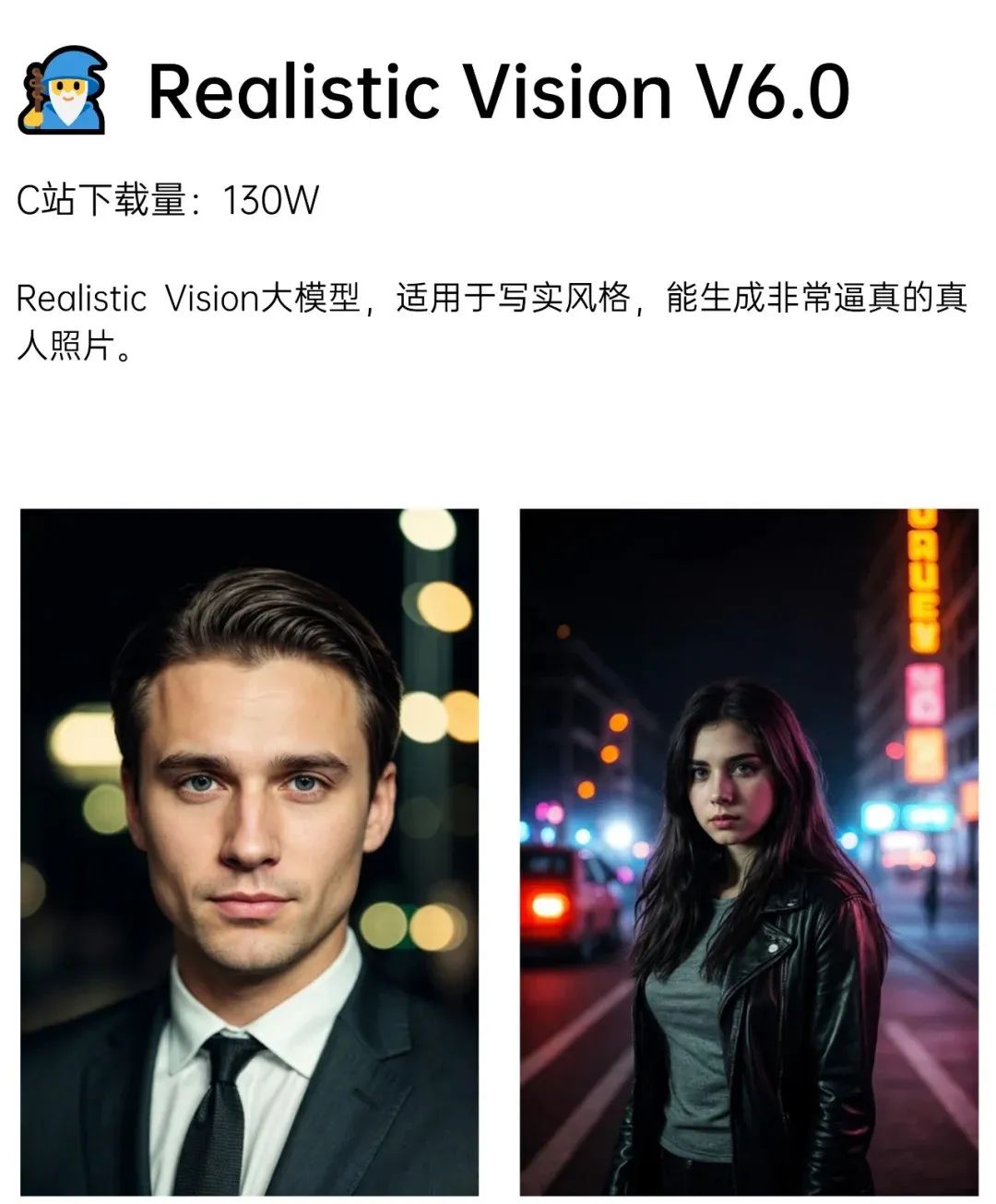

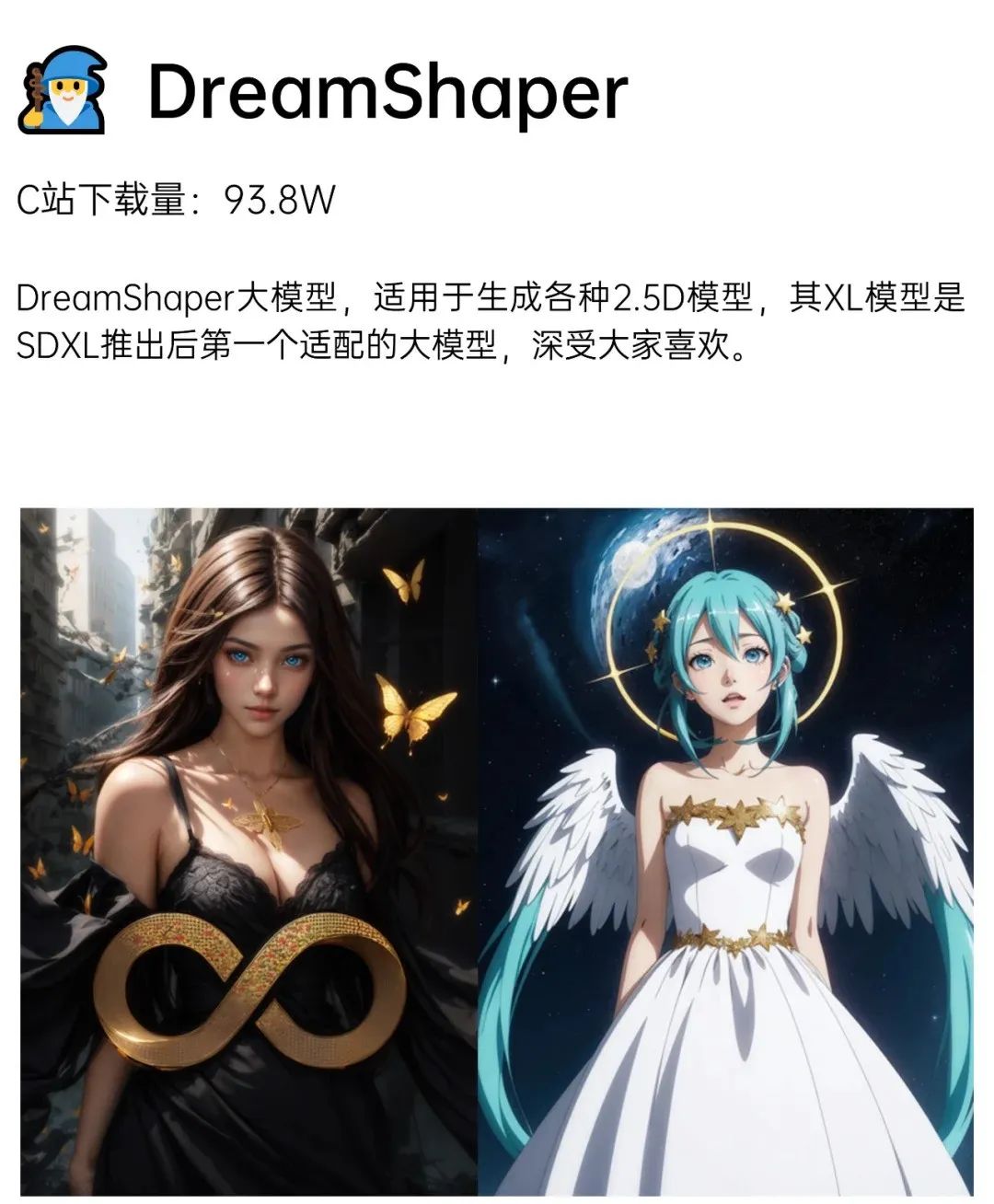

Stable Diffusion前10大模型推荐

关于AI绘画技术储备

学好 AI绘画 不论是就业还是做副业赚钱都不错,但要学会 AI绘画 还是要有一个学习规划。最后大家分享一份全套的 AI绘画 学习资料,给那些想学习 AI绘画 的小伙伴们一点帮助!

对于0基础小白入门:

如果你是零基础小白,想快速入门AI绘画是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以找到适合自己的学习方案

包括:stable diffusion安装包、stable diffusion0基础入门全套PDF,视频学习教程。带你从零基础系统性的学好AI绘画!

需要的可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

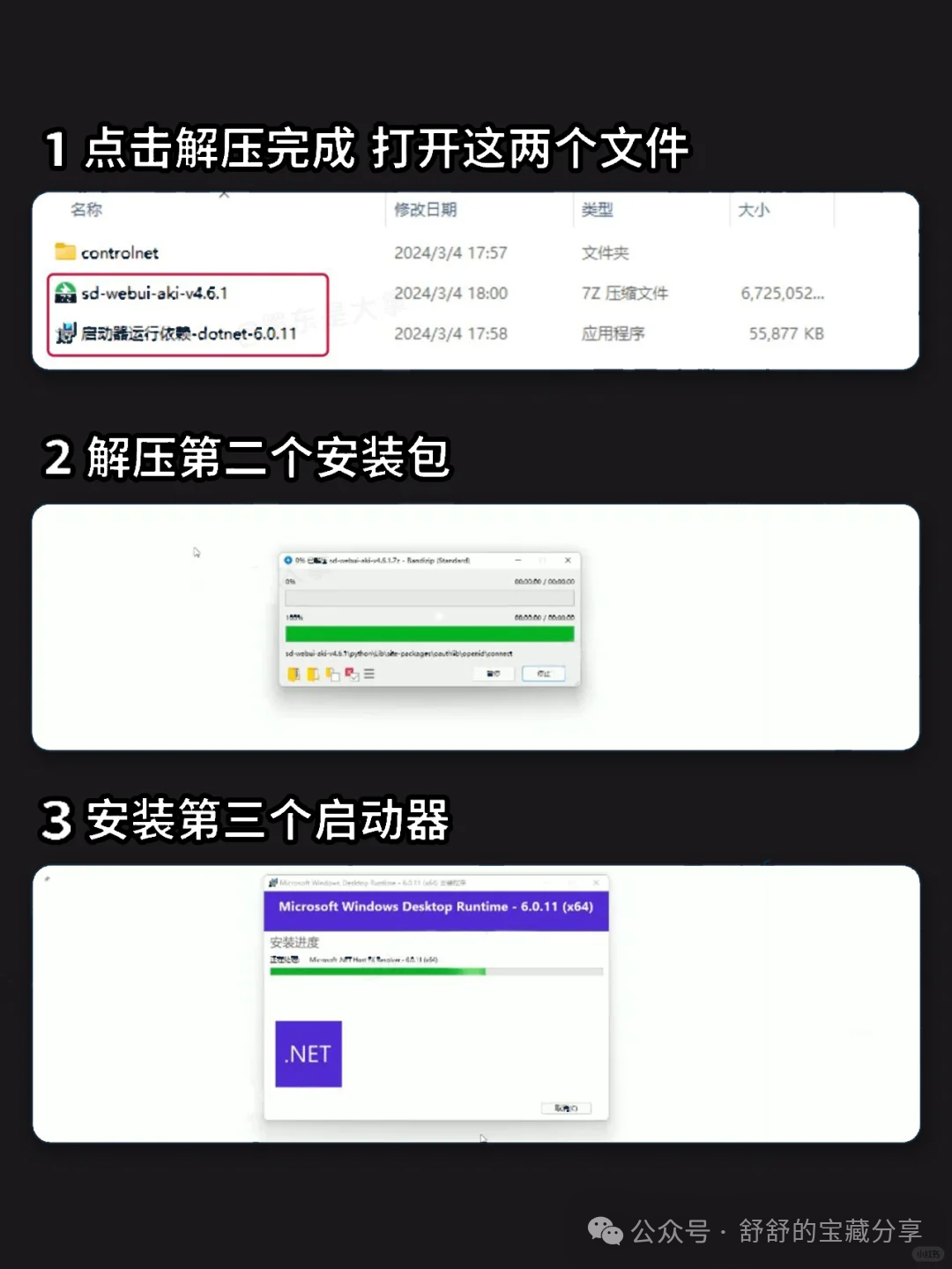

1.stable diffusion安装包 (全套教程文末领取哈)

随着技术的迭代,目前 Stable Diffusion 已经能够生成非常艺术化的图片了,完全有赶超人类的架势,已经有不少工作被这类服务替代,比如制作一个 logo 图片,画一张虚拟老婆照片,画质堪比相机。

最新 Stable Diffusion 除了有win多个版本,就算说底端的显卡也能玩了哦!此外还带来了Mac版本,仅支持macOS 12.3或更高版本。

2.stable diffusion视频合集

我们在学习的时候,往往书籍代码难以理解,阅读困难,这时候视频教程教程是就很适合了,生动形象加上案例实战,一步步带你入门stable diffusion,科学有趣才能更方便的学习下去。

3.stable diffusion模型下载

stable diffusion往往一开始使用时图片等无法达到理想的生成效果,这时则需要通过使用大量训练数据,调整模型的超参数(如学习率、训练轮数、模型大小等),可以使得模型更好地适应数据集,并生成更加真实、准确、高质量的图像。

4.stable diffusion提示词

提示词是构建由文本到图像模型解释和理解的单词的过程。可以把它理解为你告诉 AI 模型要画什么而需要说的语言,整个SD学习过程中都离不开这本提示词手册。

5.AIGC视频教程合集

观看全面零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

实战案例

纸上得来终觉浅,要学会跟着视频一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

这份完整版的学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

3859

3859

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?