自然语言处理(Natural Language Processing,NLP)是人工智能领域中一项关键技术,致力于使计算机能够理解、解释和生成人类语言。在NLP领域,NLTK(Natural Language Toolkit)被誉为Python中的语言大师,为开发者提供了丰富的工具和资源,帮助他们处理文本数据、构建语言模型,并进行各种语言分析。本文将深入探讨NLTK在自然语言处理中的应用、功能和最佳实践,帮助读者更好地理解并利用这一强大的工具。

NLTK简介

1.1 什么是NLTK?

NLTK是一个强大的Python库,专注于处理人类语言数据。它提供了易于使用的接口和丰富的资源,涵盖了从文本处理、词汇学、语法分析到语义分析等广泛的NLP任务。NLTK的目标是使NLP技术对所有人都可用,让开发者能够在自己的项目中轻松集成自然语言处理的功能。

1.2 NLTK的特点

-

全面的语言处理工具: NLTK涵盖了从基础文本处理到高级语义分析的全面工具集,满足了各种自然语言处理任务的需求。

-

大量语言资源: NLTK内置了大量的语言资源,包括语料库、语法规则和预训练模型,为开发者提供了强大的支持。

-

开源社区支持: 作为一个开源项目,NLTK拥有活跃的社区,用户可以从社区中获取支持、分享经验和贡献代码。

NLTK的基础功能

2.1 文本处理

NLTK提供了丰富的文本处理工具,包括分词、词干提取、词性标注等。这些功能使开发者能够更好地理解和处理文本数据。

# 例子:NLTK文本处理

from nltk.tokenize import word_tokenize

from nltk.stem import PorterStemmer

from nltk import pos_tag

# 分词

text = "NLTK is a powerful library for natural language processing."

words = word_tokenize(text)

print("Tokenized Words:", words)

# 词干提取

stemmer = PorterStemmer()

stemmed_words = [stemmer.stem(word) for word in words]

print("Stemmed Words:", stemmed_words)

# 词性标注

pos_tags = pos_tag(words)

print("POS Tags:", pos_tags)

2.2 语料库

NLTK包含了多个语言的语料库,开发者可以用来训练模型或进行语言分析。这些语料库涵盖了各种主题,包括新闻、小说、科技等。

# 例子:NLTK语料库

from nltk.corpus import brown

# 获取布朗大学语料库

brown_corpus = brown.sents(categories=['news'])

print("Brown Corpus Sentences:", brown_corpus[:2])

2.3 词袋模型

NLTK支持构建词袋模型,将文本数据转化为向量表示,为机器学习任务提供输入。

# 例子:NLTK词袋模型

from nltk.text import TextCollection

# 构建文本集合

texts = [

"NLTK is a powerful library for natural language processing.",

"It provides tools for text processing in multiple languages."

]

# 构建词袋模型

text_collection = TextCollection(texts)

tf_idf = text_collection.tf_idf("NLTK", texts[0])

print("TF-IDF Score for 'NLTK':", tf_idf)

NLTK的高级功能

3.1 语法分析

NLTK支持语法分析,包括句法树和依存句法分析。这使得开发者能够深入理解句子的结构和语法关系。

# 例子:NLTK语法分析

from nltk.parse import CoreNLPParser

# 使用Stanford CoreNLP进行句法分析

parser = CoreNLPParser(url='http://localhost:9000')

sentence = "NLTK is a powerful library for natural language processing."

tree = list(parser.parse(sentence.split()))[0]

tree.pretty_print()

3.2 语义分析

NLTK支持语义分析,包括词义消歧、命名实体识别等。这些功能使得开发者能够更深层次地理解文本的含义。

# 例子:NLTK语义分析

from nltk.wsd import lesk

from nltk import ne_chunk

# 词义消歧

sentence = "I saw bats flying in the cave."

ambiguous_word = "bats"

sense = lesk(sentence.split(), ambiguous_word)

print("Sense:", sense)

# 命名实体识别

sentence = "Barack Obama was born in Hawaii."

ne_tree = ne_chunk(pos_tag(word_tokenize(sentence)))

print("Named Entities:", ne_tree)

NLTK在实际项目中的应用

NLTK在实际项目中有广泛的应用,涵盖了许多领域,包括:

-

信息检索: NLTK提供了强大的文本处理和分析工具,用于构建搜索引擎和信息检索系统。

-

情感分析: NLTK支持情感分析任务,通过分析文本中的情感词汇和情感极性来判断文本的情感色彩。

-

机器翻译: NLTK的语言处理工具可用于构建机器翻译系统,将文本从一种语言翻译为另一种语言。

-

对话系统: NLTK支持构建对话系统,通过自然语言与用户进行交互。

NLTK的未来发展

NLTK作为一个开源项目,其未来发展方向包括:

-

性能优化: 针对大规模语料库和复杂模型的性能优化,提高NLTK的处理速度和效率。

-

深度学习整合: 结合深度学习技术,提供更先进的自然语言处理模型和算法。

-

多语言支持: 拓展NLTK的语言支持,使其能够更好地适应多语言环境。

以上就是“NLTK:自然语言处理的巫师,Python中的语言大师!”的全部内容,希望对你有所帮助。

关于Python技术储备

学好 Python 不论是就业还是做副业赚钱都不错,但要学会 Python 还是要有一个学习规划。最后大家分享一份全套的 Python 学习资料,给那些想学习 Python 的小伙伴们一点帮助!

一、Python所有方向的学习路线

Python所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

二、Python必备开发工具

三、Python视频合集

观看零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

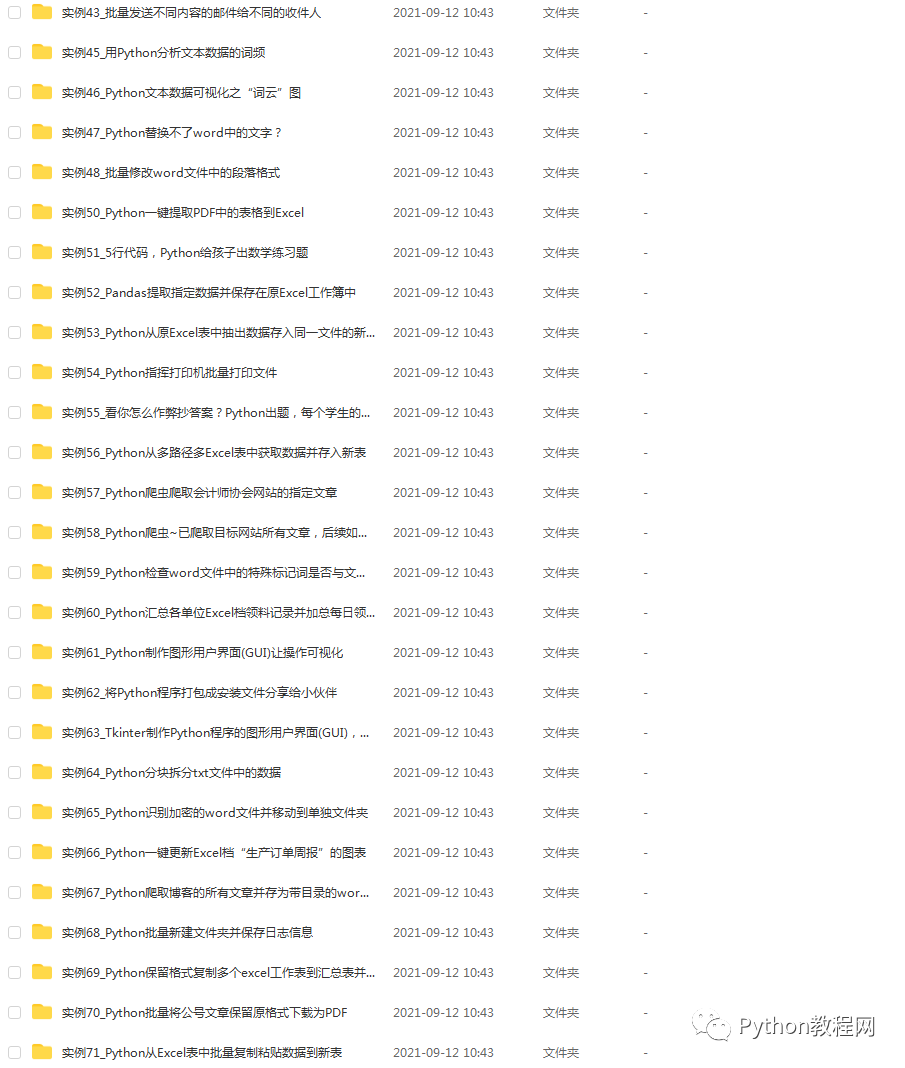

四、实战案例

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

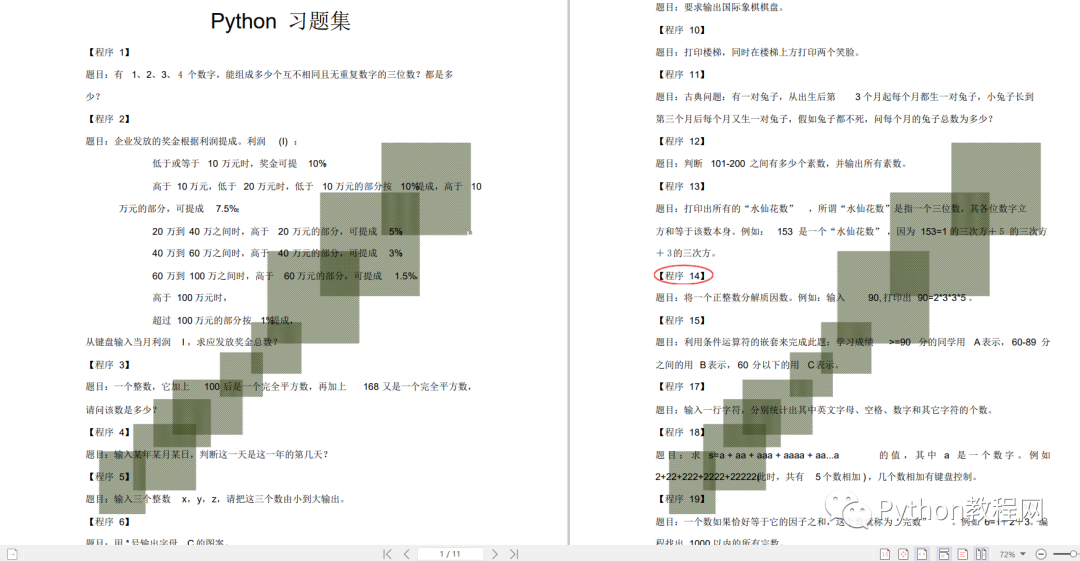

五、Python练习题

检查学习结果。

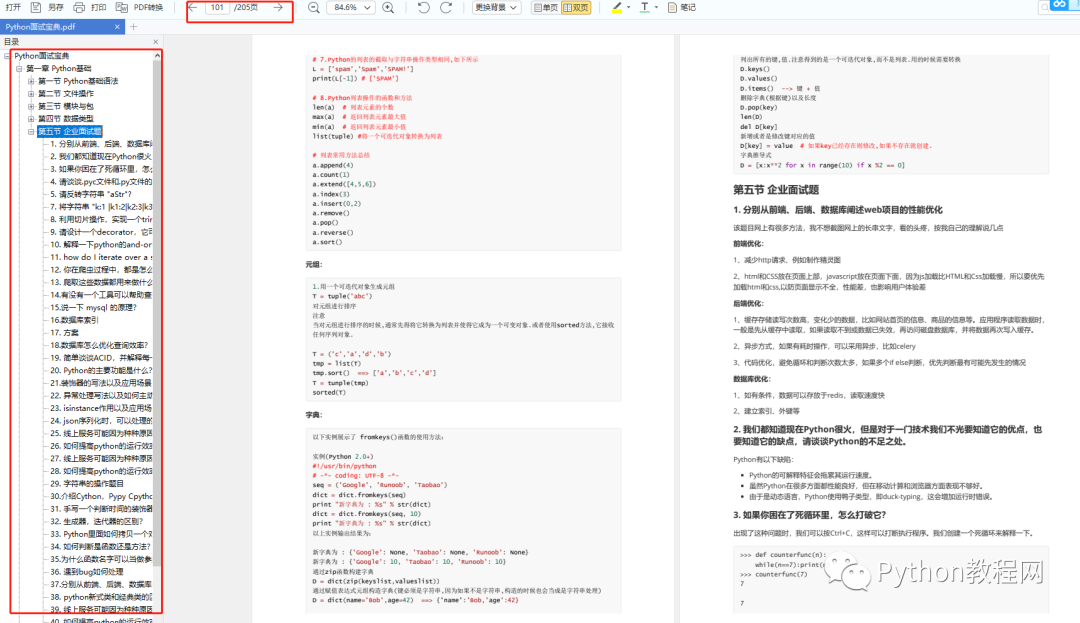

六、面试资料

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

最后祝大家天天进步!!

上面这份完整版的Python全套学习资料已经上传至CSDN官方,朋友如果需要可以直接微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】。

1972

1972

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?