网络上的数据量庞大且多种多样,而Python作为一种强大的编程语言,提供了丰富的爬虫工具和库,使得开发者能够轻松地从网页、API等数据源中获取所需信息。本文将深入介绍Python爬虫技术,包括基本概念、常用库和实用技巧,帮助开发者更好地理解和运用爬虫技术。

爬虫基础概念

1.1 什么是爬虫?

爬虫是一种通过自动化程序访问互联网,获取网页内容并进行处理的技术。爬虫通过模拟浏览器行为,可以获取网页上的文本、图片、链接等信息。

1.2 爬虫的应用场景

-

数据采集:从网页上获取大量数据,用于分析和研究。

-

数据更新:定期获取网站上的最新信息,保持数据的实时性。

-

数据分析:通过爬虫获取数据进行统计、分析和可视化。

爬虫库和工具

2.1 Requests库

Requests是Python中常用的HTTP库,用于发送HTTP请求和处理响应。

# 例子:使用Requests库发送GET请求

import requests

url = 'https://www.example.com'

response = requests.get(url)

print(response.text)

2.2 BeautifulSoup库

BeautifulSoup是一个HTML和XML解析库,用于从网页中提取数据。

# 例子:使用BeautifulSoup解析HTML

from bs4 import BeautifulSoup

html = '<html><body><p>Example</p></body></html>'

soup = BeautifulSoup(html, 'html.parser')

print(soup.p.text)

2.3 Scrapy框架

Scrapy是一个开源的爬虫框架,提供了强大的爬虫功能和结构化的数据处理。

# 例子:使用Scrapy创建爬虫项目

scrapy startproject myproject

2.4 Selenium库

Selenium是一个用于自动化浏览器操作的库,适用于需要执行JavaScript的爬虫任务。

# 例子:使用Selenium模拟浏览器操作

from selenium import webdriver

driver = webdriver.Chrome()

driver.get('https://www.example.com')

print(driver.page_source)

driver.quit()

爬虫实战技巧

3.1 处理动态加载内容

有些网页使用JavaScript动态加载内容,此时可以使用Selenium等工具模拟浏览器操作,或者通过分析XHR请求获取数据。

3.2 处理登录状态

对于需要登录才能访问的网站,可以使用Requests库或Selenium模拟登录,获取登录后的Cookie并在后续请求中使用。

3.3 避免被反爬虫策略

网站为了防止被爬虫抓取,可能会采取一些反爬虫策略,如设置User-Agent、限制访问频率等。爬虫需注意模拟正常用户行为,避免触发反爬虫机制。

数据处理和存储

4.1 数据清洗和处理

爬取的数据可能包含一些噪声和不规则的信息,需要进行数据清洗和处理,以便进一步分析和应用。

4.2 数据存储

爬取的数据可以存储到数据库、文件或其他数据存储介质中,以备后续使用。

# 例子:使用SQLite存储爬取的数据

import sqlite3

conn = sqlite3.connect('mydatabase.db')

cursor = conn.cursor()

cursor.execute('CREATE TABLE IF NOT EXISTS mytable (id INTEGER PRIMARY KEY, data TEXT)')

cursor.execute('INSERT INTO mytable (data) VALUES (?)', ('example data',))

conn.commit()

conn.close()

爬虫伦理和法律

5.1 爬虫伦理

爬虫开发者应该遵守网站的robots.txt文件,尊重网站所有者的权益,不进行恶意爬取和滥用爬虫技术。

5.2 法律风险

一些国家和地区对于爬虫活动有相关法规,开发者在进行爬虫任务时应当遵守当地法律法规,避免法律风险。

以上就是“Python爬虫技术:网络数据获取和处理的实用指南”的全部内容,希望对你有所帮助。

关于Python技术储备

学好 Python 不论是就业还是做副业赚钱都不错,但要学会 Python 还是要有一个学习规划。最后大家分享一份全套的 Python 学习资料,给那些想学习 Python 的小伙伴们一点帮助!

一、Python所有方向的学习路线

Python所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

二、Python必备开发工具

三、Python视频合集

观看零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

四、实战案例

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

五、Python练习题

检查学习结果。

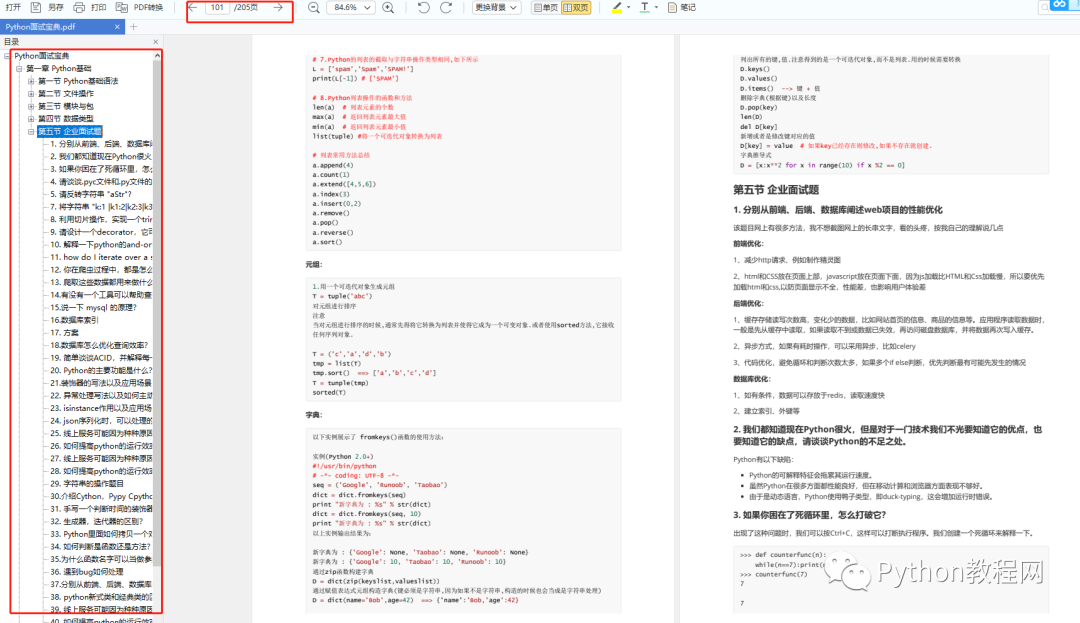

六、面试资料

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

最后祝大家天天进步!!

上面这份完整版的Python全套学习资料已经上传至CSDN官方,朋友如果需要可以直接微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】。

1845

1845

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?