引言

自动化测试是软件开发中不可或缺的一环,它极大提升了测试效率和覆盖率。然而,自动化测试的稳定性问题,如误报和资源浪费,可能成为开发过程中的隐患。本文将分享一系列策略和实践,帮助您稳固自动化测试基础,确保其性价比最大化。

自动化测试稳定性的挑战

自动化测试的稳定性挑战主要包括环境不一致性、测试数据管理不善、脚本脆弱性,以及外部依赖的不可控性。

策略:构建稳定的自动化测试框架

-

环境一致性:利用容器化技术确保测试环境的一致性。

-

测试数据管理:采用数据驱动方法,保证测试数据的准确性和可重复性。

-

脚本健壮性:编写可维护和健壮的测试脚本,减少测试失败。

-

外部依赖管理:使用 Mock 对象和存根技术隔离外部依赖。

实践:持续优化和反馈

-

持续集成(CI):集成自动化测试到 CI 流程,实现快速反馈。

-

监控和日志记录:实施详细的监控和日志记录机制。

-

错误分类和处理:对错误进行分类,并制定处理策略。

-

测试数据的健壮性检查:验证测试数据的完整性和正确性,进行边界值分析。

-

重试机制:为暂时性失败定义重试条件和次数。

持续集成(CI)实践

-

自动化测试集成:将自动化测试脚本集成到 CI 流程中,确保每次代码提交都能触发测试。

-

快速反馈:利用 CI 工具的即时通知功能,在测试失败时迅速通知开发团队。

# 伪代码示例:CI流程中的测试触发

def run_tests_on_commit(commit_hash):

print(f"Running tests for commit {commit_hash}")

# 执行测试逻辑

# ...

if tests_failed:

notify_team("Tests failed for commit", commit_hash)

else:

print("All tests passed successfully.")

监控和日志记录

-

实施监控:使用 APM 工具监控测试执行的性能和稳定性。

-

日志记录:确保所有测试执行都有详细的日志记录,便于问题追踪。

# Python代码示例:简单的日志记录

import logging

logging.basicConfig(filename='test.log', level=logging.INFO)

def log_test_results(results):

for test, status in results.items():

logging.info(f"Test {test} - Status: {status}")

# 使用示例

test_results = {'test1': 'PASS', 'test2': 'FAIL'}

log_test_results(test_results)

错误分类和处理

-

错误分类:根据错误的严重性和影响范围,将错误分为不同的类别。

-

自动化处理:对于已知的错误类型,实现自动化的处理流程,如重试机制。

# Python代码示例:错误分类和重试机制

def classify_error(error):

if isinstance(error, TimeoutError):

return 'Critical'

elif isinstance(error, ValueError):

return 'High'

else:

return 'Low'

def handle_test_error(test, error):

error_level = classify_error(error)

if error_level == 'Critical':

retry_test(test)

else:

log_error(test, error)

def retry_test(test):

print(f"Retrying test {test} due to critical error.")

# 重试测试逻辑

# ...

重试机制

在自动化测试中,某些测试失败可能是由于暂时性的外部因素导致的。为此,引入重试机制可以显著提高测试的稳定性和可靠性。

-

定义重试条件:确定哪些类型的失败是适合重试的,例如网络超时或资源锁定。

-

限制重试次数:为了避免无限重试,设定一个合理的重试次数上限。

-

重试间隔:设置重试之间的间隔,给予系统恢复的时间。

Python 代码示例:

import time

import unittest

class RetryDecorator:

def __init__(self, max_retries=3, retry_interval=5):

self.max_retries = max_retries

self.retry_interval = retry_interval

def __call__(self, func):

def wrapper(*args, **kwargs):

retries = 0

while retries < self.max_retries:

try:

return func(*args, **kwargs)

except Exception as e:

retries += 1

if retries < self.max_retries:

print(f"Retry {retries}/{self.max_retries}: {e}")

time.sleep(self.retry_interval)

else:

raise

return wrapper

class TestAutomation(unittest.TestCase):

@RetryDecorator(max_retries=3, retry_interval=5)

def test_network_sensitive_operation(self):

# 模拟网络请求或其他敏感操作

result = perform_network_request()

self.assertIsNotNone(result)

# 使用示例

if __name__ == "__main__":

unittest.main()

测试数据的健壮性检查

-

数据验证:在测试执行前,验证测试数据的完整性和正确性,确保数据符合预期格式和范围。

-

数据隔离:为不同的测试用例或测试套件提供独立的数据集,避免数据间的相互影响。

-

边界值分析:特别关注边界值和异常值的测试,确保测试数据覆盖了所有可能的输入情况。

-

数据生成策略:采用随机数据生成或规则性数据生成策略,以提高测试场景的覆盖率。

Python 代码示例:

import unittest

class TestDataValidation(unittest.TestCase):

def test_data_integrity(self, data):

# 检查数据完整性

self.assertTrue("required_field" in data)

self.assertIsInstance(data["required_field"], expected_type)

def test_boundary_values(self, data):

# 检查边界值

self.assertLessEqual(data["boundary_field"], max_value)

self.assertGreaterEqual(data["boundary_field"], min_value)

# 测试数据生成示例

def generate_test_data():

test_data = {

"required_field": generate_random_data(),

"boundary_field": generate_boundary_value(),

# 其他测试数据

}

return test_data

# 使用示例

test_data = generate_test_data()

test_case = TestDataValidation('test_data_integrity')

test_case.test_data_integrity(test_data)

案例分析

在案例分析部分,我们将展示一个实际的自动化测试优化案例,包括优化前后的对比和关键指标分析。

案例背景

-

项目描述:一个电商平台的自动化测试,涉及用户登录、搜索、结账等功能。

-

优化前问题:测试经常因为环境不一致和外部服务不稳定而失败。

优化措施

-

容器化测试环境:使用 Docker 容器确保所有测试都在相同的环境下执行。

-

数据驱动测试:通过参数化测试用例,减少硬编码数据,提高测试的灵活性。

优化结果

-

执行时间缩短:优化后测试执行时间缩短了 30%。

-

误报率降低:通过改进错误分类和处理,误报率降低了 50%。

Python 代码示例

# Python代码示例:数据驱动测试

import unittest

test_data = [

{"username": "user1", "password": "pass1", "expected": "success"},

{"username": "user2", "password": "wrong_pass", "expected": "failure"},

# 更多测试数据

]

class TestDataDrivenTests(unittest.TestCase):

def test_user_login(self, data):

result = perform_login(data['username'], data['password'])

self.assertEqual(result, data['expected'])

# 使用示例

for data in test_data:

test_case = TestDataDrivenTests('test_user_login')

test_case.test_user_login(data)

五、结论

实施上述策略和实践,可以有效解决自动化测试的稳定性问题,提高测试的性价比,加速软件交付流程。 最终还是要鼓励团队成员积极参与自动化测试的稳定性改进工作,共同推动软件质量的提升。

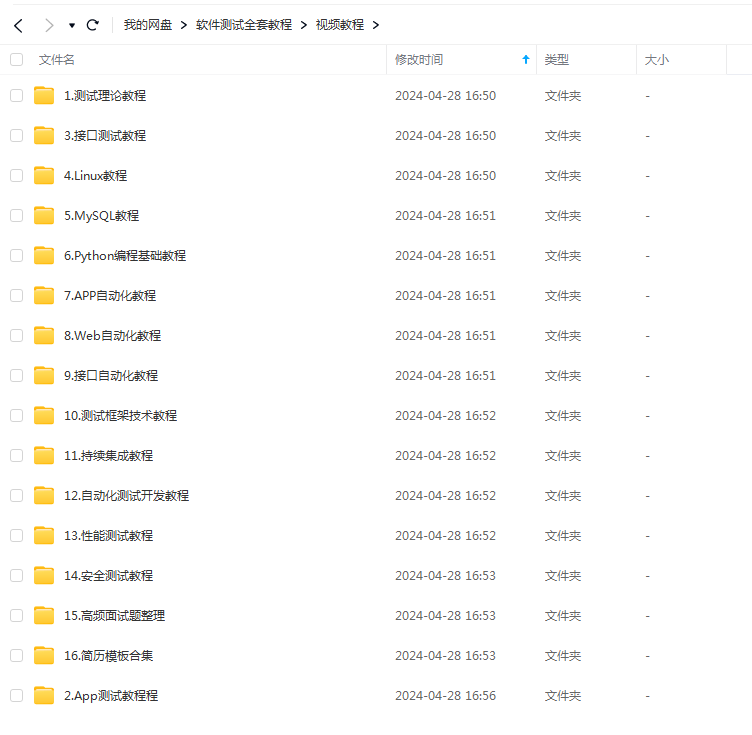

最后感谢每一个认真阅读我文章的人,看着粉丝一路的上涨和关注,礼尚往来总是要有的,虽然不是什么很值钱的东西,如果你用得到的话可以直接拿走!

软件测试面试文档

我们学习必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有字节大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

1049

1049

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?