现在能在网上找到很多很多的学习资源,有免费的也有收费的,当我拿到1套比较全的学习资源之前,我并没着急去看第1节,我而是去审视这套资源是否值得学习,有时候也会去问一些学长的意见,如果可以之后,我会对这套学习资源做1个学习计划,我的学习计划主要包括规划图和学习进度表。

分享给大家这份我薅到的免费视频资料,质量还不错,大家可以跟着学习

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

同时,也欢迎关注我的微信公众号 AlwaysBeta,更多精彩内容等你来。

如下为详细的 server.properties 参数配置,可根据真实业务场景来选择需要使用。

############################# System #############################

#唯一标识在集群中的ID,要求是正数。

broker.id=0

#服务端口,默认9092

port=9092

#监听地址,不设为所有地址

host.name=debugo01

处理网络请求的最大线程数

num.network.threads=2

处理磁盘I/O的线程数

num.io.threads=8

一些后台线程数

background.threads = 4

等待IO线程处理的请求队列最大数

queued.max.requests = 500

socket的发送缓冲区(SO_SNDBUF)

socket.send.buffer.bytes=1048576

socket的接收缓冲区 (SO_RCVBUF)

socket.receive.buffer.bytes=1048576

socket请求的最大字节数。为了防止内存溢出,message.max.bytes必然要小于

socket.request.max.bytes = 104857600

############################# Topic #############################

每个topic的分区个数,更多的partition会产生更多的segment file

num.partitions=2

是否允许自动创建topic ,若是false,就需要通过命令创建topic

auto.create.topics.enable =true

一个topic ,默认分区的replication个数 ,不能大于集群中broker的个数。

default.replication.factor =1

消息体的最大大小,单位是字节

message.max.bytes = 1000000

############################# ZooKeeper #############################

Zookeeper quorum设置。如果有多个使用逗号分割

zookeeper.connect=debugo01:2181,debugo02,debugo03

连接zk的超时时间

zookeeper.connection.timeout.ms=1000000

ZooKeeper集群中leader和follower之间的同步实际

zookeeper.sync.time.ms = 2000

############################# Log #############################

#日志存放目录,多个目录使用逗号分割

log.dirs=/var/log/kafka

当达到下面的消息数量时,会将数据flush到日志文件中。默认10000

#log.flush.interval.messages=10000

当达到下面的时间(ms)时,执行一次强制的flush操作。interval.ms和interval.messages无论哪个达到,都会flush。默认3000ms

#log.flush.interval.ms=1000

检查是否需要将日志flush的时间间隔

log.flush.scheduler.interval.ms = 3000

日志清理策略(delete|compact)

log.cleanup.policy = delete

日志保存时间 (hours|minutes),默认为7天(168小时)。超过这个时间会根据policy处理数据。bytes和minutes无论哪个先达到都会触发。

log.retention.hours=168

日志数据存储的最大字节数。超过这个时间会根据policy处理数据。

#log.retention.bytes=1073741824

控制日志segment文件的大小,超出该大小则追加到一个新的日志segment文件中(-1表示没有限制)

log.segment.bytes=536870912

当达到下面时间,会强制新建一个segment

log.roll.hours = 24*7

日志片段文件的检查周期,查看它们是否达到了删除策略的设置(log.retention.hours或log.retention.bytes)

log.retention.check.interval.ms=60000

是否开启压缩

log.cleaner.enable=false

对于压缩的日志保留的最长时间

log.cleaner.delete.retention.ms = 1 day

对于segment日志的索引文件大小限制

log.index.size.max.bytes = 10 * 1024 * 1024

#y索引计算的一个缓冲区,一般不需要设置。

log.index.interval.bytes = 4096

############################# replica #############################

partition management controller 与replicas之间通讯的超时时间

controller.socket.timeout.ms = 30000

controller-to-broker-channels消息队列的尺寸大小

controller.message.queue.size=10

replicas响应leader的最长等待时间,若是超过这个时间,就将replicas排除在管理之外

replica.lag.time.max.ms = 10000

是否允许控制器关闭broker ,若是设置为true,会关闭所有在这个broker上的leader,并转移到其他broker

controlled.shutdown.enable = false

控制器关闭的尝试次数

controlled.shutdown.max.retries = 3

每次关闭尝试的时间间隔

controlled.shutdown.retry.backoff.ms = 5000

如果relicas落后太多,将会认为此partition relicas已经失效。而一般情况下,因为网络延迟等原因,总会导致replicas中消息同步滞后。如果消息严重滞后,leader将认为此relicas网络延迟较大或者消息吞吐能力有限。在broker数量较少,或者网络不足的环境中,建议提高此值.

replica.lag.max.messages = 4000

#leader与relicas的socket超时时间

replica.socket.timeout.ms= 30 * 1000

leader复制的socket缓存大小

replica.socket.receive.buffer.bytes=64 * 1024

replicas每次获取数据的最大字节数

replica.fetch.max.bytes = 1024 * 1024

replicas同leader之间通信的最大等待时间,失败了会重试

replica.fetch.wait.max.ms = 500

每一个fetch操作的最小数据尺寸,如果leader中尚未同步的数据不足此值,将会等待直到数据达到这个大小

replica.fetch.min.bytes =1

leader中进行复制的线程数,增大这个数值会增加relipca的IO

num.replica.fetchers = 1

每个replica将最高水位进行flush的时间间隔

replica.high.watermark.checkpoint.interval.ms = 5000

是否自动平衡broker之间的分配策略

auto.leader.rebalance.enable = false

leader的不平衡比例,若是超过这个数值,会对分区进行重新的平衡

leader.imbalance.per.broker.percentage = 10

检查leader是否不平衡的时间间隔

leader.imbalance.check.interval.seconds = 300

客户端保留offset信息的最大空间大小

offset.metadata.max.bytes = 1024

#############################Consumer #############################

Consumer端核心的配置是group.id、zookeeper.connect

决定该Consumer归属的唯一组ID,By setting the same group id multiple processes indicate that they are all part of the same consumer group.

group.id

消费者的ID,若是没有设置的话,会自增

consumer.id

一个用于跟踪调查的ID ,最好同group.id相同

client.id = <group_id>

对于zookeeper集群的指定,必须和broker使用同样的zk配置

文末有福利领取哦~

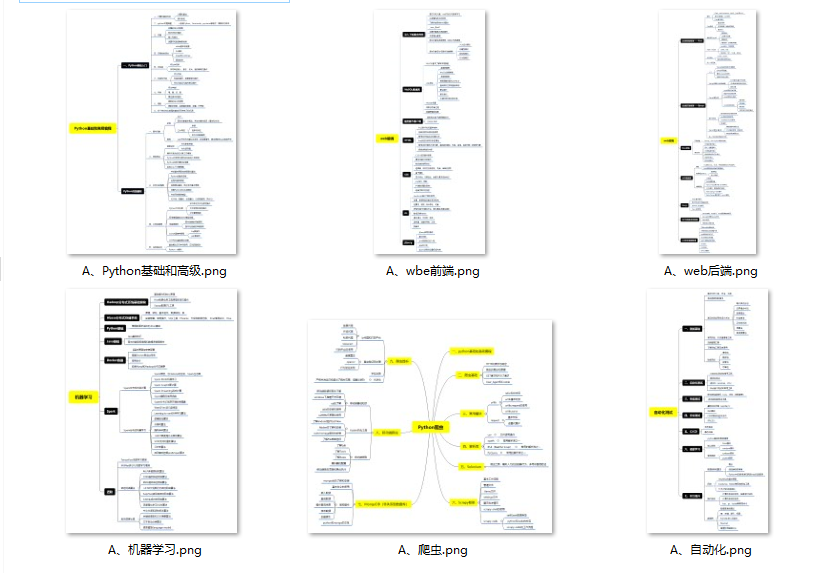

👉一、Python所有方向的学习路线

Python所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

👉二、Python必备开发工具

👉三、Python视频合集

观看零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

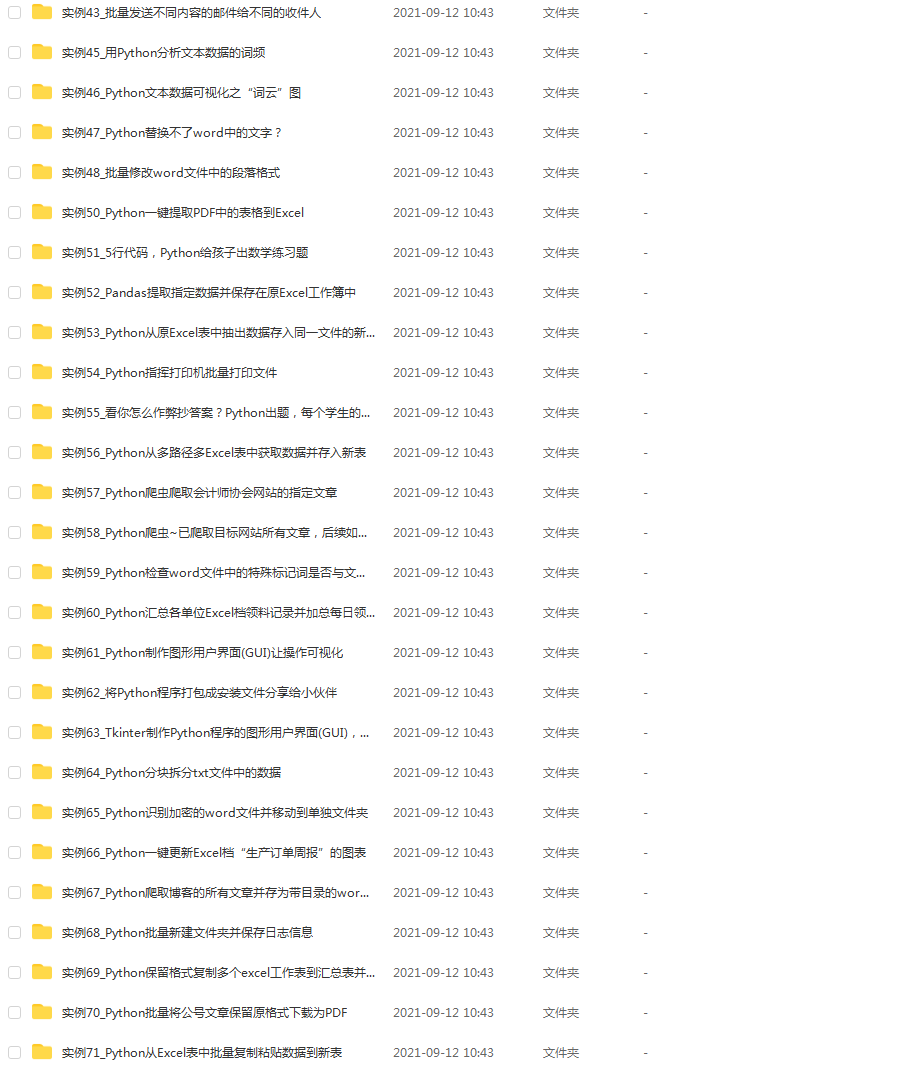

👉 四、实战案例

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。(文末领读者福利)

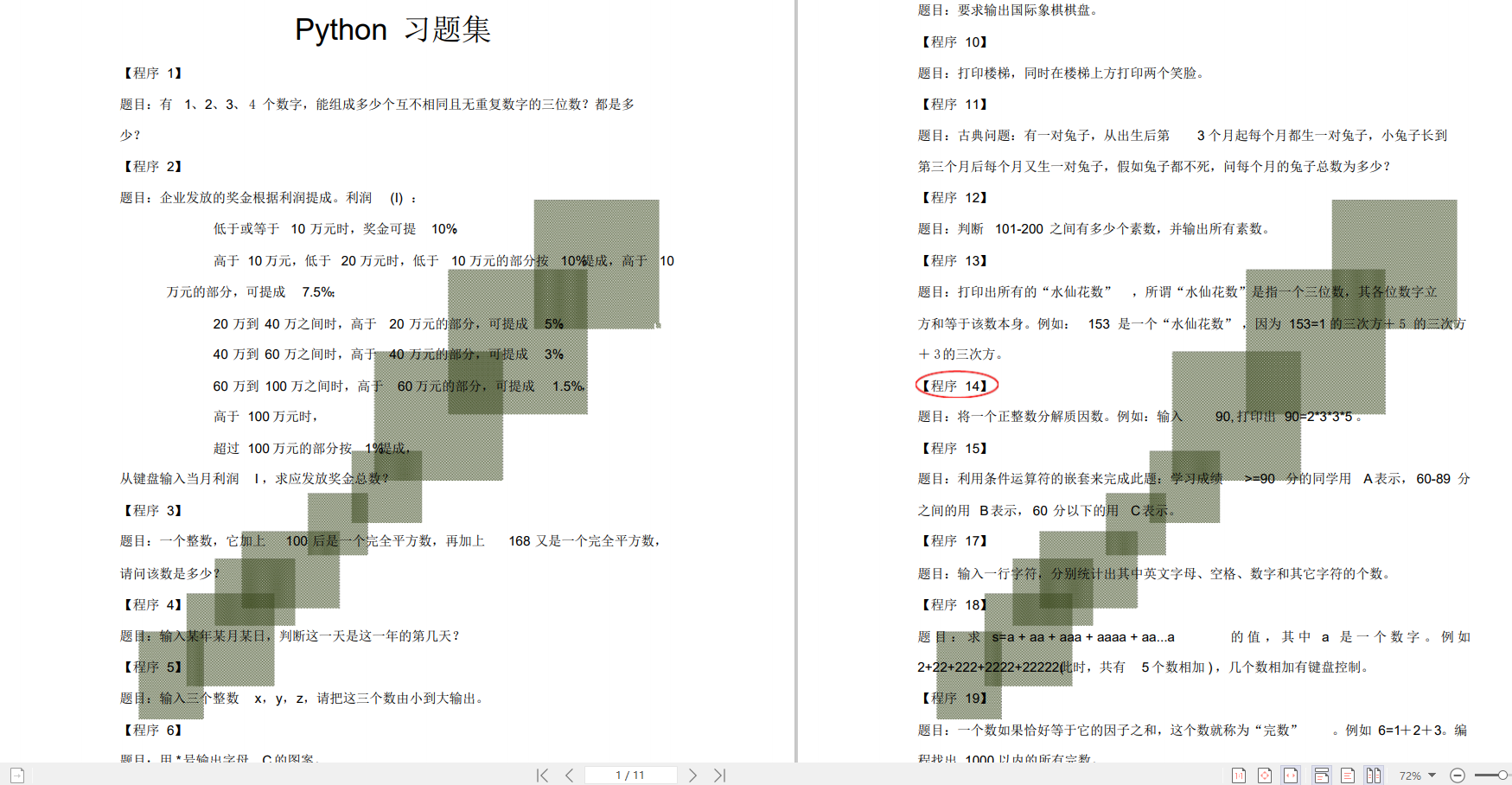

👉五、Python练习题

检查学习结果。

👉六、面试资料

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

👉因篇幅有限,仅展示部分资料,这份完整版的Python全套学习资料已经上传

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

674

674

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?