仔细回想,第一次接触机器学习还是一年半前在matlab官网的mathwork官网教程

在这之后也一直用机器学习解决一些问题,包括不限于数学建模C题,影像组学数据分类,生信分析,金融建模

西瓜书也是一年前买的,至今也就只在23年去南大在AI研究院门口打了个卡翻开来过

虽然如今手上事情也不少,但还是毅然决然地觉得得逼自己读下去,毕竟假期不读,更待何时读?

前三章的数学要求尚可,也有很多概念性的东西,在此记录几个印象深刻的点吧

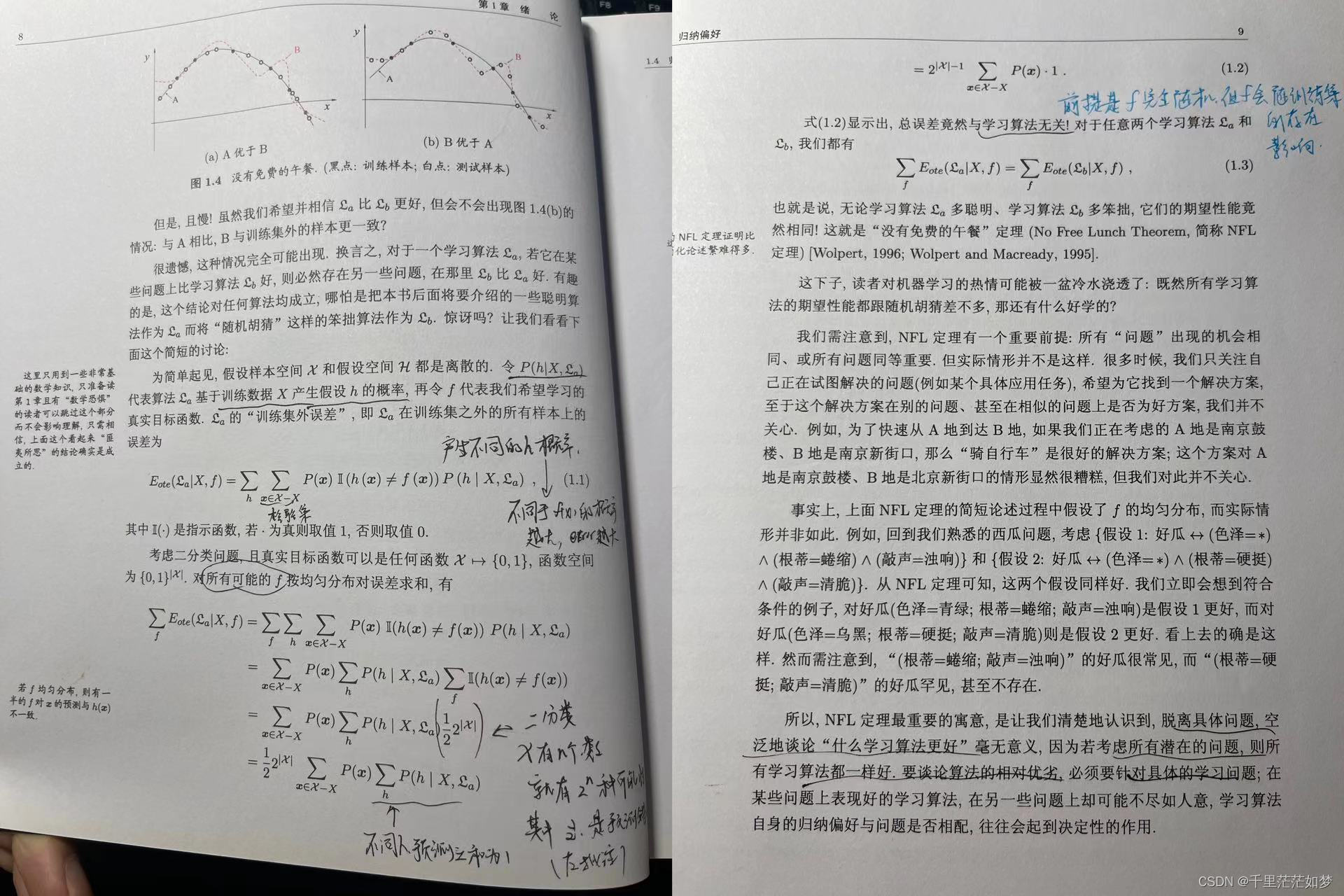

(1)奥卡姆剃刀和NFL(没有免费午餐定理)

当是完全随机的分布的时候,总误差与学习算法无关(初读的时候结合奥卡姆剃刀,我一度以为是说高斯噪声使得均方误差在远离均值处被放大,导致简单的模型会有最小的误差。)

这点初接触是很反直觉的,但数学推导不会说谎。

当然这个无关的结论是基于是完全随机的分布,而且也是完全被“瞎猜”的。南瓜书也指出了这一点,这两点也是最后找到“最好”算法的基础。

(2)前言、发展历史等等

这段草草带过,但觉得很多概念还是十分有趣的,“基于逻辑的归纳系统”、“广义归纳学习”、“归纳逻辑程序设计”、“统计学习”、“多释原则”等等,其中P22对机器学习的定义“不显示编程赋予计算机能力”高度概括了这个机器学习这个领域。多项式时间下通过经验误差最小化得到最优解,构造性证明P=NP,如此反推过拟合不可避免。

(3)自助法(bootstrapping)

集成学习里的一个很好的算法,在数据量较小时非常合适,但也改变了初始数据集的分布引起估计偏差

(4)性能度量

查全率查准率,F1,修正的F1。

ROC和AUC之前一直用,但目前才知道其是基于正例真假来判断的,而最理想的肯定是曲线迅速飙升,使得AUC接近1

代价敏感错误,罚分代价

比较检验全是数理统计的内容,又熟悉又陌生

(5)泛化误差

这一段我是真觉得很awesome,第一次将我脑中的欠拟合过拟合数学化的步骤

欠拟合在偏差项影响较大,此时由于不同的采样情况,导致距离会有较大的偏差

过拟合在方差项会有较大的影响,此时偏差项由于

的数量增加,偏差项的“方差”减小了(类似数理统计每次采样N份数量,其均值方差变为原本的1/N),而由于预测的值强拟合训练集的点,可能最后的结果与检验集数据相差较大

(6)线性模型

一笔带过,重点为最小二乘法、sigmoid函数和极大似然估计,涉及一点简答的矩阵运算,晚点还得去补一补线性代数hh

线性判敛的类内散度和类间散度让我想起数字图像处理OTSU的最大类间方差了,殊途重归吧

之后再慢慢更新后续

本文回顾作者一年半前初次接触机器学习的经历,探讨了奥卡姆剃刀、NFL定理,介绍了机器学习的发展历史、自助法(bootstrapping)、性能度量如F1和AUC,以及泛化误差的概念,强调了线性模型的基础方法。

本文回顾作者一年半前初次接触机器学习的经历,探讨了奥卡姆剃刀、NFL定理,介绍了机器学习的发展历史、自助法(bootstrapping)、性能度量如F1和AUC,以及泛化误差的概念,强调了线性模型的基础方法。

381

381

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?