Python爬虫实战:批量下载网站图片

最新推荐文章于 2024-05-13 14:00:47 发布

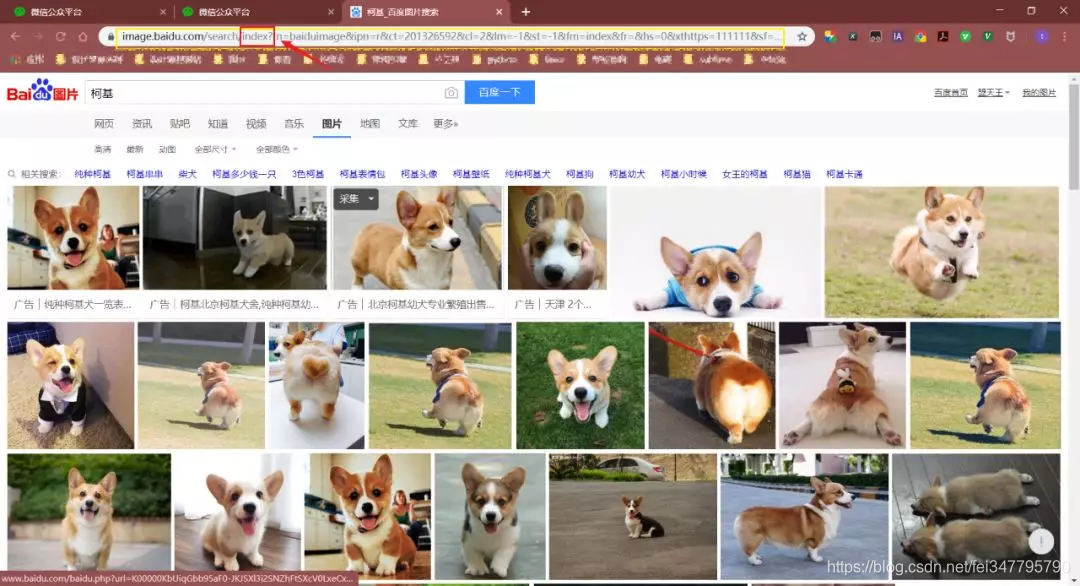

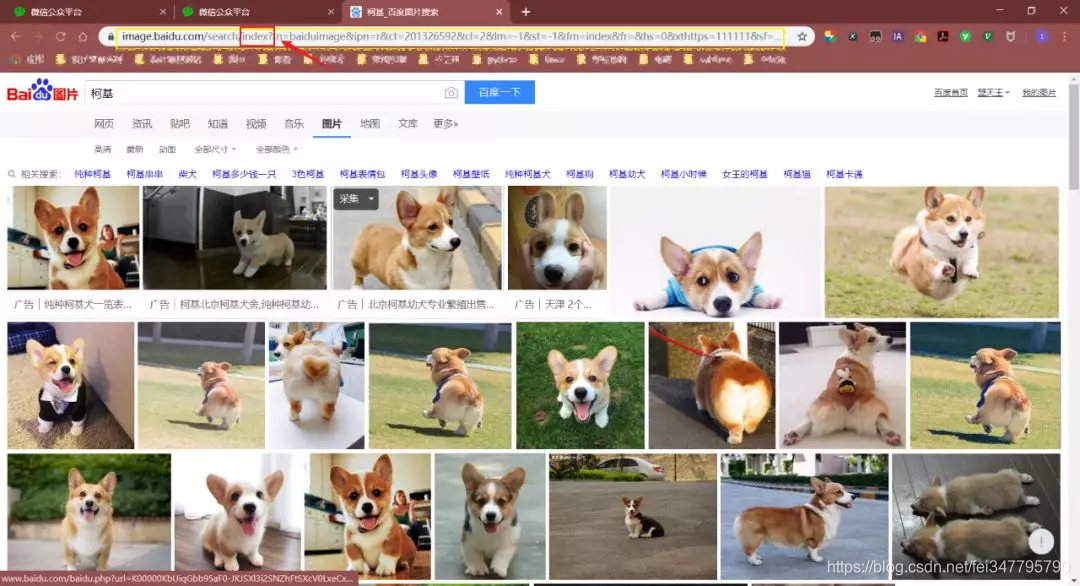

本文介绍了使用Python爬虫批量下载百度图片的方法。首先,通过分析百度图片的URL发现pn参数控制页数,每页最多60张图片。然后,利用正则表达式匹配网页源代码中的objURL,获取原始图片链接,并将其保存到本地。通过get_parse_page函数获取指定页数的图片链接,再调用save_to_txt函数创建文件夹并下载图片。

本文介绍了使用Python爬虫批量下载百度图片的方法。首先,通过分析百度图片的URL发现pn参数控制页数,每页最多60张图片。然后,利用正则表达式匹配网页源代码中的objURL,获取原始图片链接,并将其保存到本地。通过get_parse_page函数获取指定页数的图片链接,再调用save_to_txt函数创建文件夹并下载图片。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3172

3172

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?