1. 朴素贝叶斯基本原理

在实际应用中,朴素贝叶斯常被用于文本分类、垃圾邮件过滤等领域。

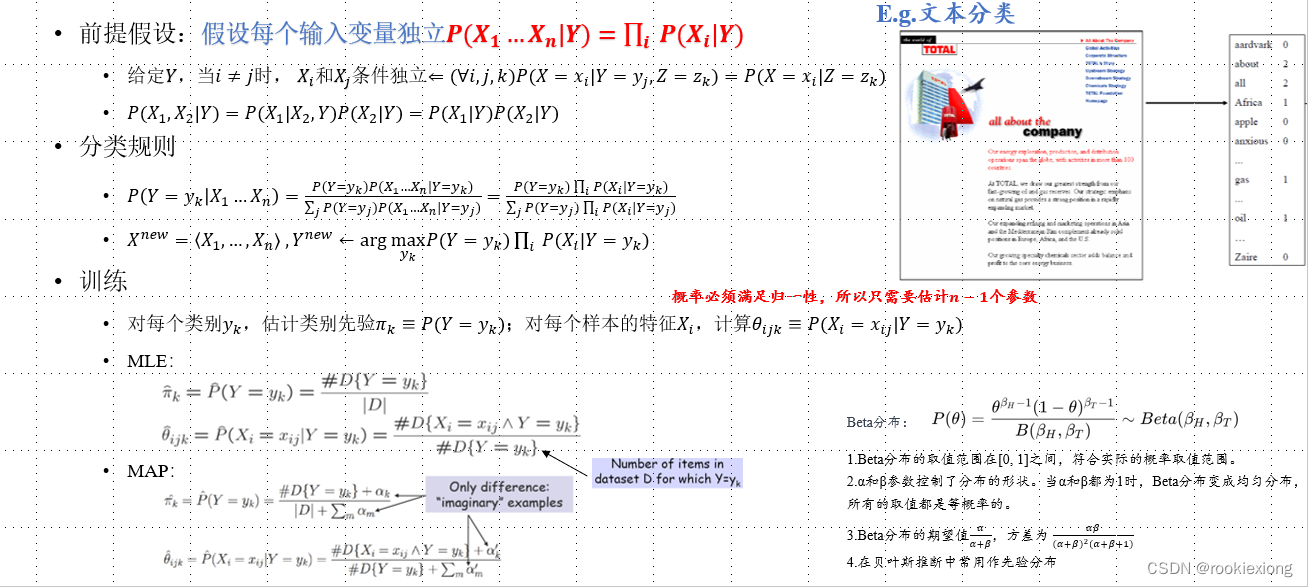

前提假设

朴素贝叶斯(Naive Bayes)是一种基于贝叶斯定理的分类算法。它假设特征之间相互独立,这是“朴素”(naive)的来源。尽管这一假设在现实中很少成立,但朴素贝叶斯在实际应用中表现良好,并且计算效率高。

朴素贝叶斯基于以下假设:

P ( x 1 , x 2 , … , x n ∣ C ) = P ( x 1 ∣ C ) ⋅ P ( x 2 ∣ C ) ⋅ … ⋅ P ( x n ∣ C ) P(x_1, x_2, \ldots, x_n | C) = P(x_1|C) \cdot P(x_2|C) \cdot \ldots \cdot P(x_n|C) P(x1,x2,…,xn∣C)=P(x1∣C)⋅P(x2∣C)⋅…⋅P(xn∣C)

其中 x 1 , x 2 , … , x n x_1, x_2, \ldots, x_n x1,x2,…,xn是特征, C C C是类别。

分类准则

给定一个类别变量 C C C 和一个特征变量向量 X = ( X 1 , X 2 , … , X n ) \mathbf{X} = (X_1, X_2, \ldots, X_n) X=(X1,X2,…,Xn),根据贝叶斯定理,后验概率可以表示为:

P ( C ∣ X ) = P ( X ∣ C ) ⋅ P ( C ) P ( X ) P(C|\mathbf{X}) = \frac{P(\mathbf{X}|C) \cdot P(C)}{P(\mathbf{X})} P(C∣X)=P(X)P(X∣C)⋅P(C)

其中:

- P ( C ∣ X ) P(C|\mathbf{X}) P(C∣X) 是给定特征 X \mathbf{X} X 条件下类别 C C C 的后验概率。

- P ( X ∣ C ) P(\mathbf{X}|C) P(X∣C) 是在类别 C C C 下观察到特征 X \mathbf{X} X 的概率。

- P ( C ) P(C) P(C) 是类别 C C C 的先验概率。

- P ( X ) P(\mathbf{X}) P(X) 是观察到特征 X \mathbf{X} X 的概率,它可以被忽略,因为在分类时我们主要关注后验概率的相对大小。

而朴素贝叶斯的分类则是通过计算每个类别的后验概率,然后选择具有最高后验概率的类别作为最终的预测结果。

y ^ = arg max c P ( C = c ∣ X ) \hat{y} = \arg\max_{c} P(C=c|\mathbf{X}) y^=argcmaxP(C=c∣X)

2. 离散特征的朴素贝叶斯

多项式朴素贝叶斯

在多项式朴素贝叶斯中,则先验概率 P ( C ) P(C) P(C)可以通过类别 C C C在训练数据中出现的频率来估计:

P ( C ) = 类别C在训练数据中的样本数 总样本数 P(C) = \frac{\text{类别C在训练数据中的样本数}}{\text{总样本数}} P(C)=总样本数类别C在训练数据中的样本数

假设特征 X i X_i Xi 的可能取值是 x i 1 , x i 2 , … , x i k x_{i1}, x_{i2}, \ldots, x_{ik} xi1,xi2,…,xik,则条件概率为:

P ( X i = x i j ∣ C = c ) = θ i j P(X_i = x_{ij}|C=c) = \theta_{ij} P(Xi=xij∣C=c)=θij

其中, θ i j \theta_{ij} θij 是在类别 C = c C=c C=c 下特征 X i X_i Xi 取值为 x i j x_{ij} xij 的概率。

模型参数的估计通常通过极大似然估计来进行。对于多项式朴素贝叶斯,参数估计可以表示为:

θ i j = N c ( x i j ) N c \theta_{ij} = \frac{N_{c}(x_{ij})}{N_{c}} θij=NcNc(xij)

其中, N c ( x i j ) N_{c}(x_{ij}) Nc(xij) 是在类别 C = c C=c C=c 下特征 X i X_i Xi 取值为 x i j x_{ij} xij 的样本数, N c N_{c} Nc 是类别 C = c C=c C=c 下的样本总数, k k k 是特征 X i X_i Xi 可能的取值个数。

而在实际问题中,为了避免概率为零的情况,通常会使用 Laplace 平滑(加法平滑)来估计概率。

θ i j = N i j + α N c + α ⋅ k \theta_{ij} = \frac{N_{ij} + \alpha}{N_{c} + \alpha \cdot k} θij=Nc+α⋅kNij+α

其中, N i j N_{ij} Nij 是在类别 C = c C=c C=c 下特征 X i X_i Xi 取值为 x i j x_{ij} xij 的样本数, N c N_c Nc 是类别 C = c C=c C=c 下的样本总数, k k k 是特征 X i X_i Xi 可能的取值个数, α \alpha α 是平滑参数。

二项式朴素贝叶斯

在二项式朴素贝叶斯中,假设特征 X i X_i Xi 的可能取值是二元的,即 x i 1 x_{i1} xi1 和 x i 2 x_{i2} xi2。先验概率与上述相同,而条件概率为:

P ( X i = x i j ∣ C = c ) = θ i j P(X_i = x_{ij}|C=c) = \theta_{ij} P(Xi=xij∣C=c)=θij

其中, θ i j \theta_{ij} θij 是在类别 C = c C=c C=c 下特征 X i X_i Xi 取值为 x i j x_{ij} xij 的概率。

参数估计通常通过极大似然估计来进行。对于二项式朴素贝叶斯,参数估计可以表示为:

θ i j = N c ( x i j ) + α N c + α ⋅ 2 \theta_{ij} = \frac{N_{c}(x_{ij}) + \alpha}{N_{c} + \alpha \cdot 2} θij=Nc+α⋅2Nc(xij)+α

其中, N c ( x i j ) N_{c}(x_{ij}) Nc(xij) 是在类别 C = c C=c C=c 下特征 X i X_i Xi 取值为 x i j x_{ij} xij 的样本数, N c N_{c} Nc 是类别 C = c C=c C=c 下的样本总数, α \alpha α 是平滑参数,取值通常为 1。

这样,我们涵盖了多项式、高斯和二项式朴素贝叶斯的基本原理及参数估计。

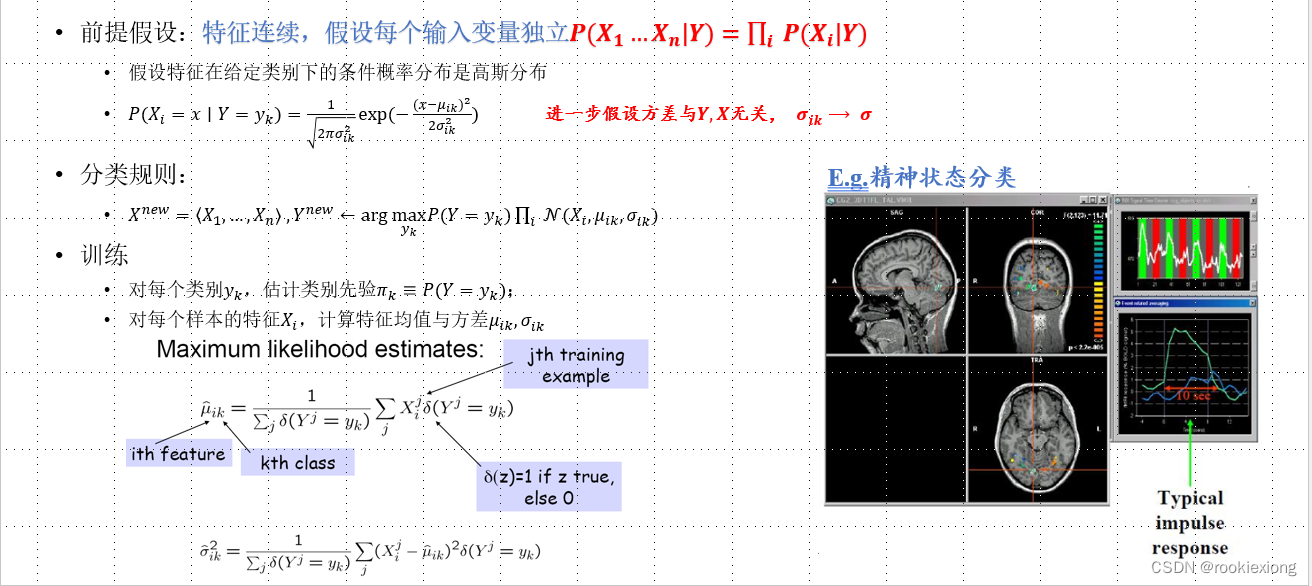

3. 连续特征的朴素贝叶斯

高斯朴素贝叶斯

在高斯朴素贝叶斯中,假设特征是连续的,且服从高斯分布。对于类别 C = c C=c C=c,特征 X i X_i Xi 的概率密度函数为:

P ( X i = x ∣ C = c ) = 1 2 π σ c i 2 exp ( − ( x − μ c i ) 2 2 σ c i 2 ) P(X_i=x|C=c) = \frac{1}{\sqrt{2\pi\sigma_{ci}^2}} \exp\left(-\frac{(x-\mu_{ci})^2}{2\sigma_{ci}^2}\right) P(Xi=x∣C=c)=2πσci21exp(−2σci2(x−μci)2)

其中, μ c i \mu_{ci} μci 和 σ c i 2 \sigma_{ci}^2 σci2 分别是在类别 C = c C=c C=c 下特征 X i X_i Xi 的均值和方差。

模型参数的估计可以通过计算样本均值 μ c i \mu_{ci} μci 和样本方差 σ c i 2 \sigma_{ci}^2 σci2 来进行。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?