首先在Pycharm安装scrapy框架,在终端中安装的时候记得把注释删除掉

pip install -i https://pypi.tuna.tsinghua.edu.cn/simple scrapy #这里加了清华源 安装会快一些安装完成后我们就可以使用了,因为之前看的好多教程都是在CMD上执行命令。感觉有点麻烦,因此分享一下自己学到的在Pycharm上进行的操作学习。

首先我们先传建一个scrapy项目文件,我们要打开pycharm在底部找到终端。(注:我用的是本地环境,不是虚拟环境) 之所以加 py -m 是因为我之前使用方法一创建出现了问题,查询后发现需要添加这个

在终端中输入:

# 我的在使用第一种方法创建scrapy项目报错,在另外一篇文章有讲到,如果有使用第一种报错的朋友

# 可以尝试使用第二种方法

scrapy startproject myspider # 方法一

py -m scrapy startproject myspider # 方法二

# 格式为

scrapy startproject + 项目名称

py -m scrapy startproject + 项目名称这是我们的项目已经创建成功了,然后我们需要进入所创建的项目文件中来创建项目(注:上一步是创建scrapy项目文件,这一步是创建项目,来让我们书写爬虫程序)

我们需要 cd + 项目名称 进入到项目名称下,如:cd baidu

想返回到上一级是 cd..

进入项目文件夹后我们就可以创建我们的爬虫程序了

# 再此还是两种方法,此处是以百度为例创建的项目

scrapy genspider baidu baidu.com # 方法一

py -m scrapy genspiderbaidu baidu.com # 方法二

# 格式为

scrapy genspider + 名称 + 域名

py -m scrapy genspider + 名称 + 域名注:我们在此处创建项目不可与第一步创建的项目文件名称相同

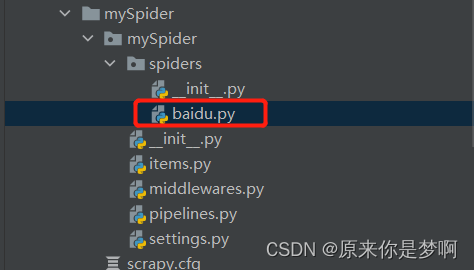

我们创建好后就可以进入到我们的程序来书写爬虫程序了

点击进入后我们就会看到以下内容

我们可以尝试parse中书写爬虫程序进行爬取东西,以百度为例

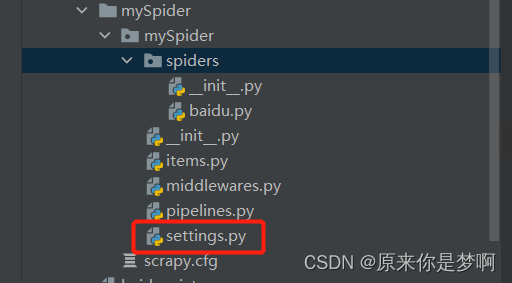

我们书写完代码后,然后我们可以在终端中尝试运行我们的爬虫程序,在此运行之前我们要找到项目的设置文件

我们书写完代码后,然后我们可以在终端中尝试运行我们的爬虫程序,在此运行之前我们要找到项目的设置文件

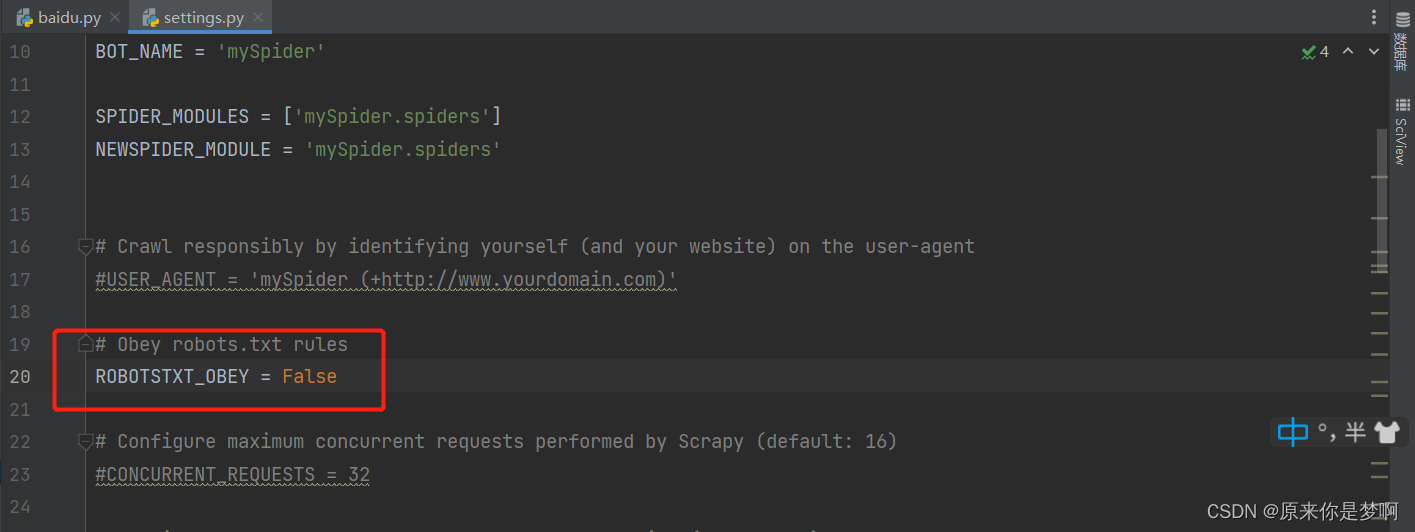

点击进入后 我们需要将20行的True 改为 False

然后我们就可以运行我们的爬虫程序了

首先我们来说第一种在终端中运行我们的爬虫程序,我们在终端在输入

# 此处仍然是两种方法

scrapy crawl baidu

py -m scrapy crawl baidu

# 格式为

scrapy crawl + 第二步的名称

py -m scrapy crawl + 第二步的名称

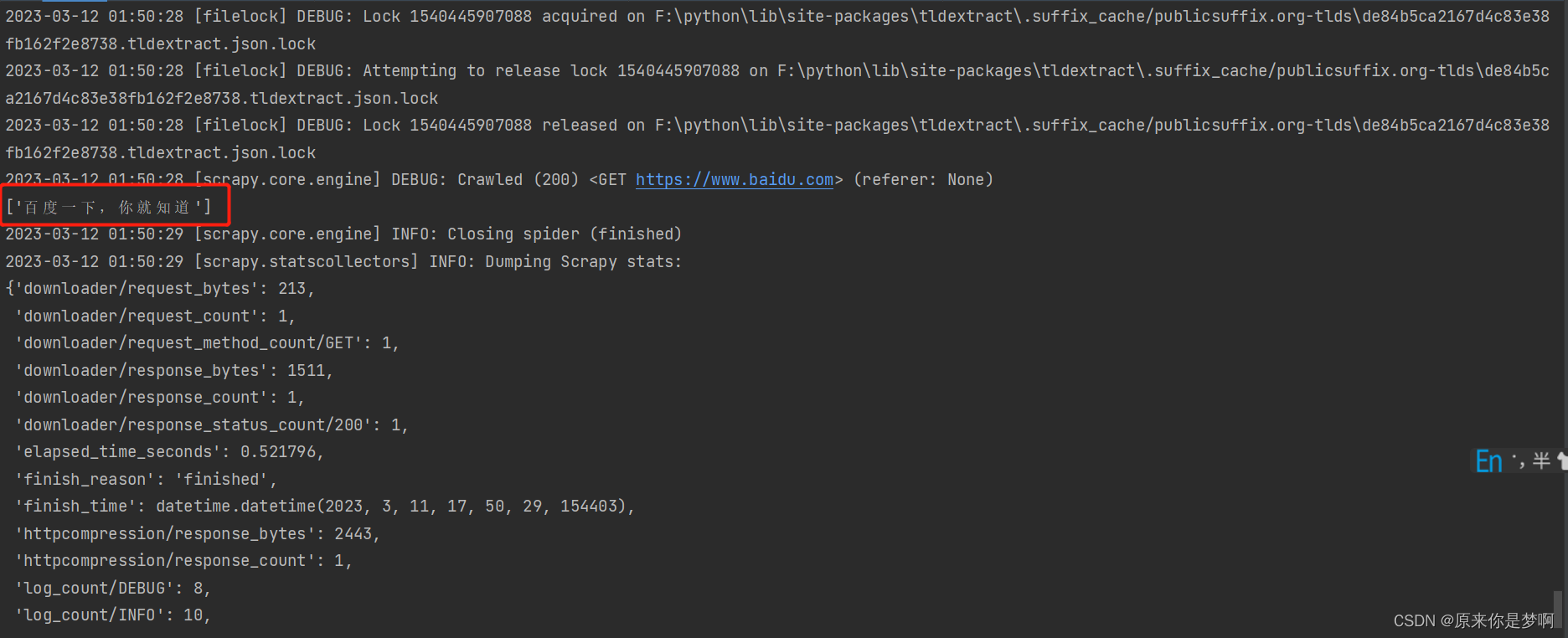

我们成功拿到标题,但是其他的以这些东西为日志,如果我们不想看的话可以在命令这样写

# 还是两种方法

scrapy crawl + baidu --nolog

py -m scrapy crawl + baidu --nolog

# 格式为

scrapy crawl + 名称 --nolog

py -m scrapy crawl + 名称 --nolog此处就不在展示结果,大家可以自己尝试一下

第二种运行是在程序中直接运行

if __name__ == '__main__':

from scrapy import cmdline

# 添加 --nolog是忽略日志输出

cmdline.execute('scrapy crawl baidu --nolog'.split(' '))在我们的爬虫程序下加入上面这段代码就可以直接运行

我们打印结果

到此,我们可以简单的使用我们的scrapy来进行爬取了,因本人才疏学浅,详细的教程就先不讲了,大家可以自行找相关视频学习。如有遇到其他问题,可以在评论区多多交流。至此,感谢观看。

4283

4283

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?