最后

Python崛起并且风靡,因为优点多、应用领域广、被大牛们认可。学习 Python 门槛很低,但它的晋级路线很多,通过它你能进入机器学习、数据挖掘、大数据,CS等更加高级的领域。Python可以做网络应用,可以做科学计算,数据分析,可以做网络爬虫,可以做机器学习、自然语言处理、可以写游戏、可以做桌面应用…Python可以做的很多,你需要学好基础,再选择明确的方向。这里给大家分享一份全套的 Python 学习资料,给那些想学习 Python 的小伙伴们一点帮助!

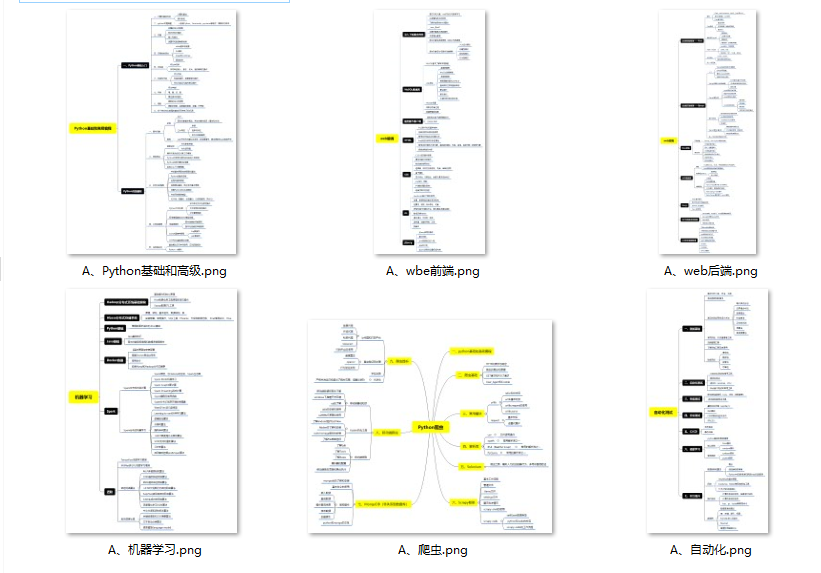

👉Python所有方向的学习路线👈

Python所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

👉Python必备开发工具👈

工欲善其事必先利其器。学习Python常用的开发软件都在这里了,给大家节省了很多时间。

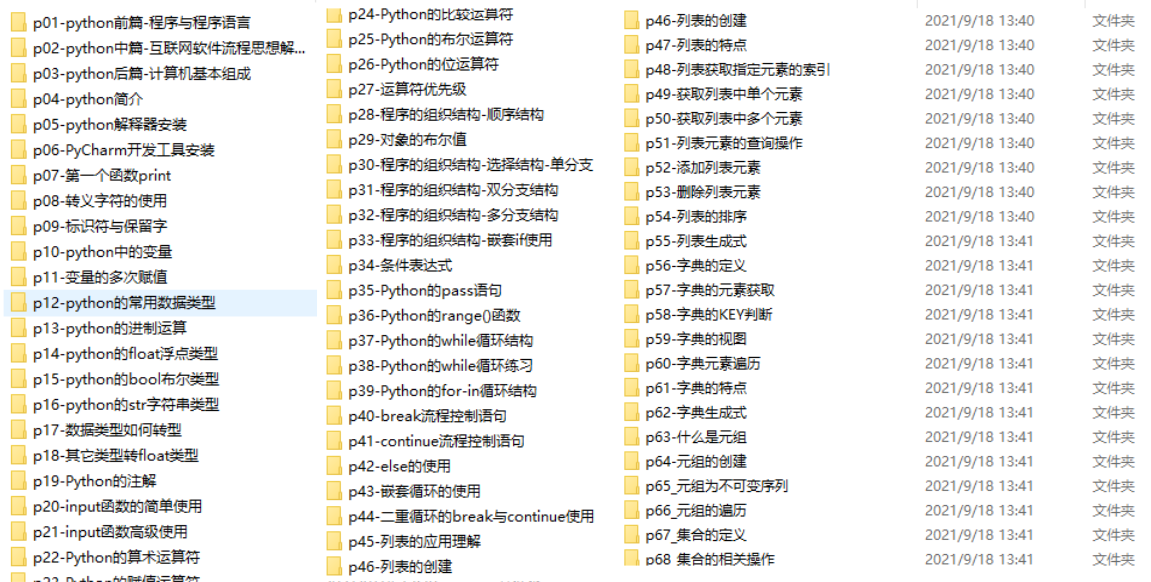

👉Python全套学习视频👈

我们在看视频学习的时候,不能光动眼动脑不动手,比较科学的学习方法是在理解之后运用它们,这时候练手项目就很适合了。

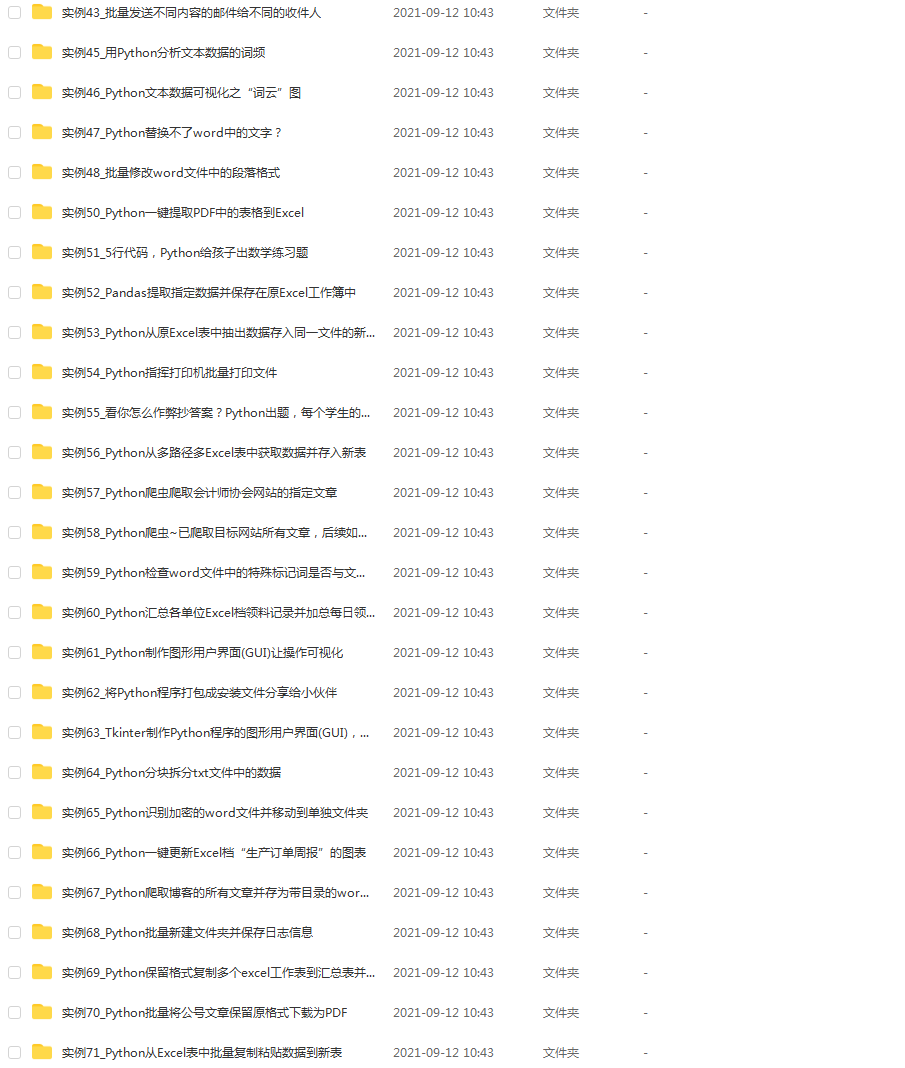

👉实战案例👈

学python就与学数学一样,是不能只看书不做题的,直接看步骤和答案会让人误以为自己全都掌握了,但是碰到生题的时候还是会一筹莫展。

因此在学习python的过程中一定要记得多动手写代码,教程只需要看一两遍即可。

👉大厂面试真题👈

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

The degree of the polynomial kernel. Will be ignored by the other

kernel functions.

gamma: float

Used in the rbf kernel function.

coef: float

Bias term used in the polynomial kernel function.

“”"

def init(self, C=1, kernel=rbf_kernel, power=4, gamma=None, coef=4):

self.C = C

self.kernel = kernel

self.power = power

self.gamma = gamma

self.coef = coef

self.lagr_multipliers = None

self.support_vectors = None

self.support_vector_labels = None

self.intercept = None

def fit(self, X, y):

n_samples, n_features = np.shape(X)

Set gamma to 1/n_features by default

if not self.gamma:

self.gamma = 1 / n_features

Initialize kernel method with parameters

self.kernel = self.kernel(

power=self.power,

gamma=self.gamma,

coef=self.coef)

Calculate kernel matrix

kernel_matrix = np.zeros((n_samples, n_samples))

for i in range(n_samples):

for j in range(n_samples):

kernel_matrix[i, j] = self.kernel(X[i], X[j])

Define the quadratic optimization problem

P = cvxopt.matrix(np.outer(y, y) * kernel_matrix, tc=‘d’)

q = cvxopt.matrix(np.ones(n_samples) * -1)

A = cvxopt.matrix(y, (1, n_samples), tc=‘d’)

b = cvxopt.matrix(0, tc=‘d’)

if not self.C:

G = cvxopt.matrix(np.identity(n_samples) * -1)

h = cvxopt.matrix(np.zeros(n_samples))

else:

G_max = np.identity(n_samples) * -1

G_min = np.identity(n_samples)

G = cvxopt.matrix(np.vstack((G_max, G_min)))

h_max = cvxopt.matrix(np.zeros(n_samples))

h_min = cvxopt.matrix(np.ones(n_samples) * self.C)

h = cvxopt.matrix(np.vstack((h_max, h_min)))

Solve the quadratic optimization problem using cvxopt

minimization = cvxopt.solvers.qp(P, q, G, h, A, b)

Lagrange multipliers

lagr_mult = np.ravel(minimization[‘x’])

Extract support vectors

Get indexes of non-zero lagr. multipiers

idx = lagr_mult > 1e-7

Get the corresponding lagr. multipliers

self.lagr_multipliers = lagr_mult[idx]

Get the samples that will act as support vectors

self.support_vectors = X[idx]

Get the corresponding labels

self.support_vector_labels = y[idx]

Calculate intercept with first support vector

self.intercept = self.support_vector_labels[0]

for i in range(len(self.lagr_multipliers)):

self.intercept -= self.lagr_multipliers[i] * self.support_vector_labels[

i] * self.kernel(self.support_vectors[i], self.support_vectors[0])

def predict(self, X):

一、Python所有方向的学习路线

Python所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照下面的知识点去找对应的学习资源,保证自己学得较为全面。

二、Python必备开发工具

工具都帮大家整理好了,安装就可直接上手!

三、最新Python学习笔记

当我学到一定基础,有自己的理解能力的时候,会去阅读一些前辈整理的书籍或者手写的笔记资料,这些笔记详细记载了他们对一些技术点的理解,这些理解是比较独到,可以学到不一样的思路。

四、Python视频合集

观看全面零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

五、实战案例

纸上得来终觉浅,要学会跟着视频一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

六、面试宝典

简历模板

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

2109

2109

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?