自注意力机制(self-attention mechanism)本身并没有直接对序列中不同位置的元素进行明确的区分。这是因为自注意力机制中计算权重的过程是通过对所有位置的元素同时进行加权平均,权重是通过计算输入序列中所有位置与当前位置的相关性得到的。

在自注意力机制中,给定一个输入序列,对于序列中的每个位置 i,通过计算与其他所有位置 j 之间的相关性(通常是通过点积计算)来得到权重,然后将这些权重作为对应位置元素的权重,从而计算加权平均。这样的计算方式是全局性的,没有直接考虑元素的相对位置。】

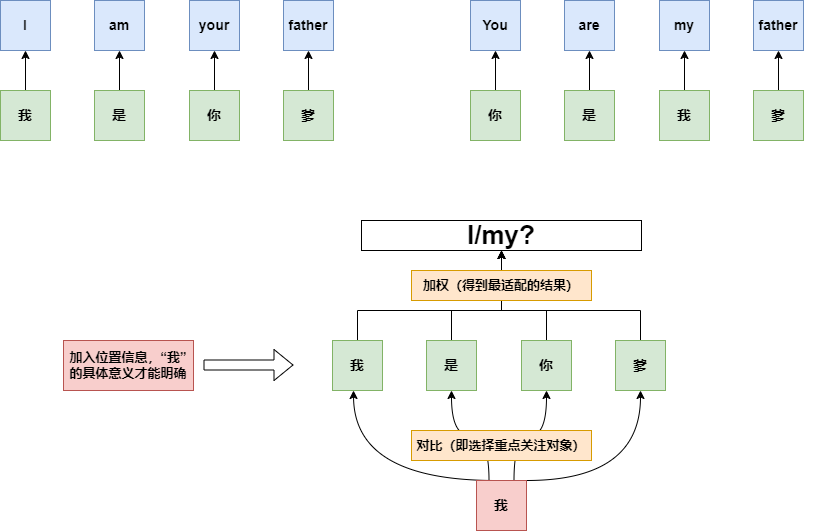

就比如“我是你爹”和“你是我爹”这两句话,如果没有位置区分,通过自注意力机制进行翻译后:“我”这个字翻译出来的结果应该都是一样的,要么都是“I”,要么都是“my”,因为“我”这个字在计算全局相关性并求解的时候,在这两句话中进行求解是没有任何区别的,这就是为什么要进行位置编码,让模型掌握相对位置信息。

因此,自注意力机制并没有显式地对不同位置的元素进行位置感知。这在某些任务中可能是一个缺陷,因为对于自然语言处理等任务,词语的顺序和位置通常是非常重要的。为了弥补这一缺陷,引入位置编码是一种常见的做法,它通过在输入序列的嵌入表示中添加位置信息,使模型能够更好地利用序列中元素的相对位置信息。

总的来说,自注意力机制虽然在某些任务中表现出色,但在处理涉及元素位置关系较为重要的序列任务时,需要结合位置编码等方法,以更好地捕捉元素的相对位置信息。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?