FCN-Transformer笔记

<!--精简版笔记,仅代表个人对网络结构的理解-->

摘要

作者提出了一种新的全尺寸分割架构,该架构利用Transformer在提取主分支中最重要的分割特征方面的优势,同时用二次全卷积分支弥补其在全尺寸预测方面的局限性。然后融合来自两个分支的结果特征。

介绍

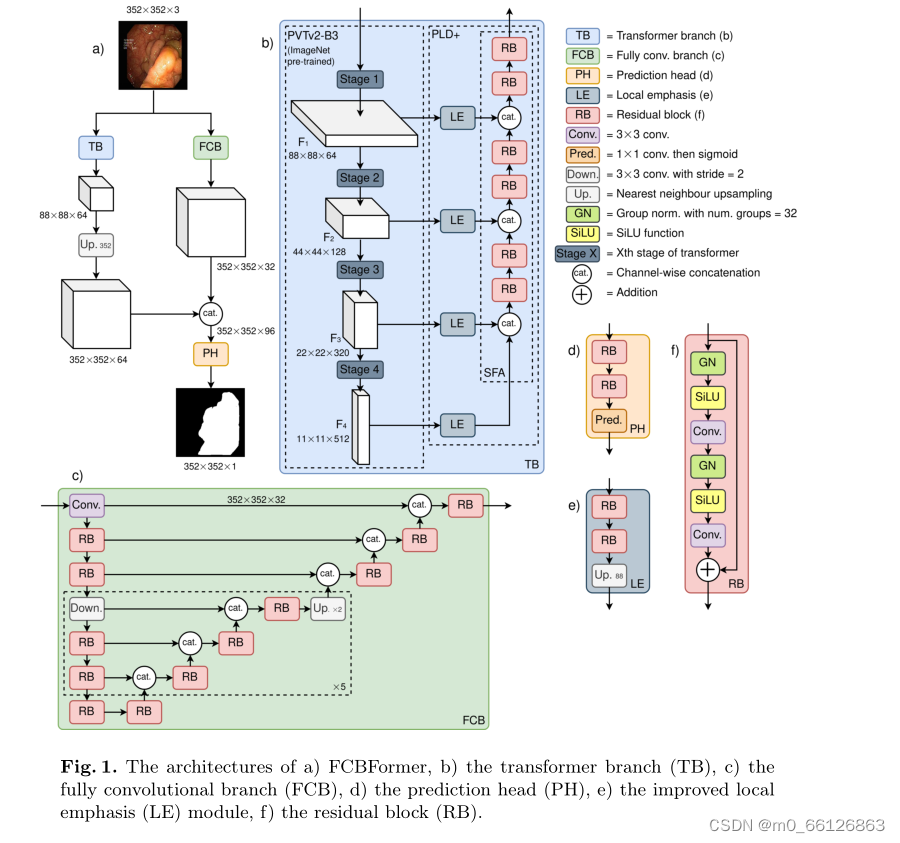

在本文中,作者提出了一种新的分割架构,该架构结合了全卷积网络和Transformer,以达到最先进的结构。有两个并行分支,两个并行分支的输入大小都是hxw,其一是全卷积分支(FCB),输出全尺寸特征映射(hxw),用于提取精细特征;其一是Transformer分支(TB),输出减小尺寸的特征映射(h/4xw/4),用于提取粗糙特征,然后上采样到全尺寸特征映射(hxw)和全卷积分支的输出进行拼接。然后输入到PH(Prediction Head:其功能仅仅是得到最终的分割图)得到最终的分割图。

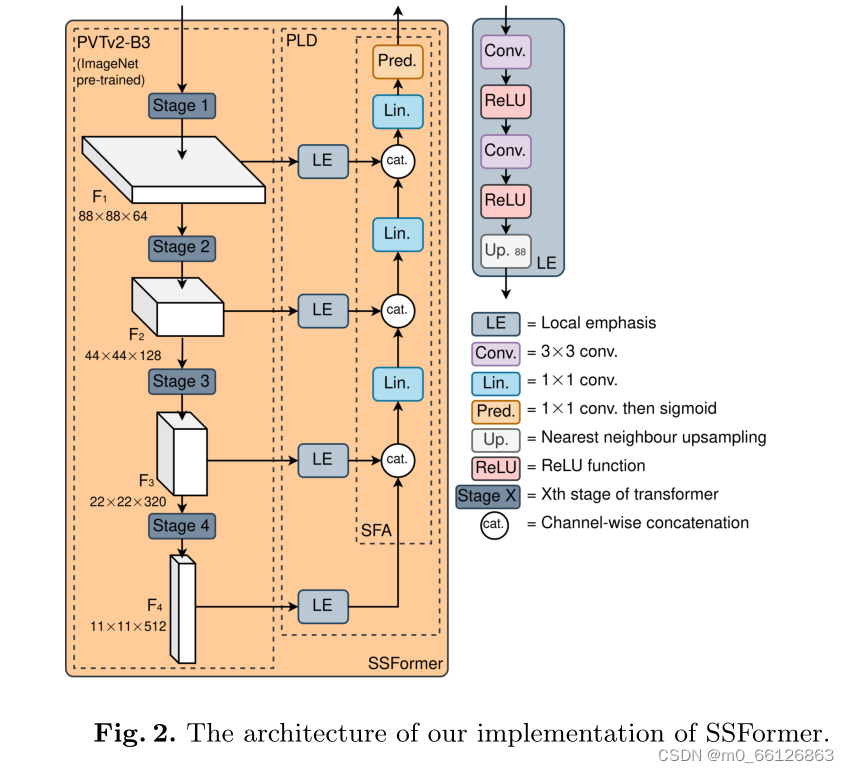

使用在ImageNet(一个大型的数据库)预训练的金字塔视觉变压器v2 (pyramid vision transformer:PVTv2)作为TB编码器。作者认为该网络在Transformer分支(TB)提取图像最重要的特征。TB主要参考了最近的论文SSFormer,该网络在缩小预测尺寸的情况下,得到了最好的效果。作者用一个新的渐进局部解码器(PLD)更新了SSFormer架构,它具有改进的局部强调(LE)和逐步特征聚合(SFA)。

对于FCB,采用高级FCN架构的形式,由残差块构成(RBs)。RBs包括包括组归一化、,SiLU激活函数、卷积层,和残差连接。PH(Prediction Head)由RBs和最后的像素级预测层组成,该预测层使用1×1内核进行卷积。

因此,这篇论文的主要新颖贡献是:

-

在密集预测的单一架构中引入了简单而有效的FCNs和Transformer方法,与之前的工作相比,通过在息肉分割方面的最先进性能,展示了优于这些单独模型类型的优势。

-

SSFormer引入的渐进式局部解码器(PLD)的改进,用于对TB编码器提取的特征进行解码。

FCBFormer

FCBFormer整体架构图

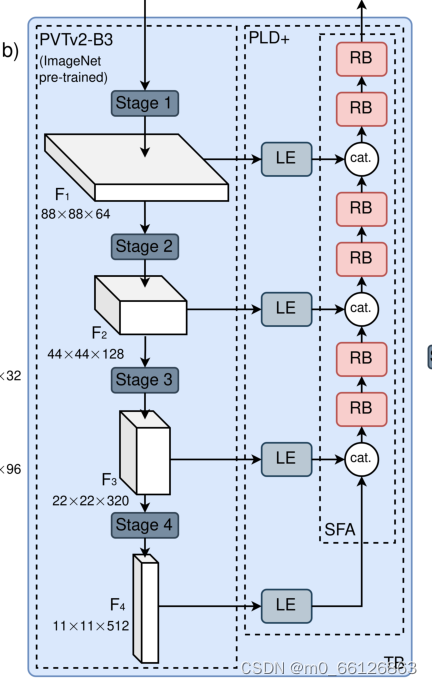

Transformer BranchTB)

TB主要参考了SSFormer。SSFormer使用在ImageNet上预训练的金字塔视觉Transformerv2 (PVTv2)作为图像编码器,它返回一个具有4层的特征金字塔,然后将其作为渐进局部解码器(PLD)的输入。在PLD中,金字塔的每一层都由一个局部强调(LE)模块单独处理,以解决基于变压器的模型在特征表示中表示局部特征时的弱点,然后通过逐步特征聚合(SFA)融合特征金字塔的局部强调级别。最后,利用融合的多尺度特征预测输入图像的分割图。

TB对于SSFormer的改进主要体现:

-

LE模块:详细见图

-

SFA模块:详细构成见图

值得注意的是,PLD的输入为编码器提取的多个尺度的特征,通道数分别为:64,128,320,512。在LE的第一个卷积层输出通道数均为64,在这之后的各个卷积层除了cat操作和预测层输出通道数均为64。

Fully convolutional branch (FCB)

这部分很简单,不做赘述

439

439

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?