一、书生大模型全链路开源开放体系概述

书生大模型全链路开源开放体系是一套覆盖“数据构建-模型训练-微调优化-应用部署”全流程的开源技术框架,其核心理念是开放共享与协同创新。该体系不仅开源了预训练模型参数,还提供了配套工具链、数据集、训练框架及行业解决方案,形成从底层技术到上层应用的完整闭环。

1. 技术架构分层

-

数据层:开放高质量多模态数据集,支持文本、图像、视频等跨模态训练。

-

模型层:提供不同参数量级的预训练模型(如百亿级、千亿级),涵盖自然语言处理、计算机视觉、多模态融合等领域。

-

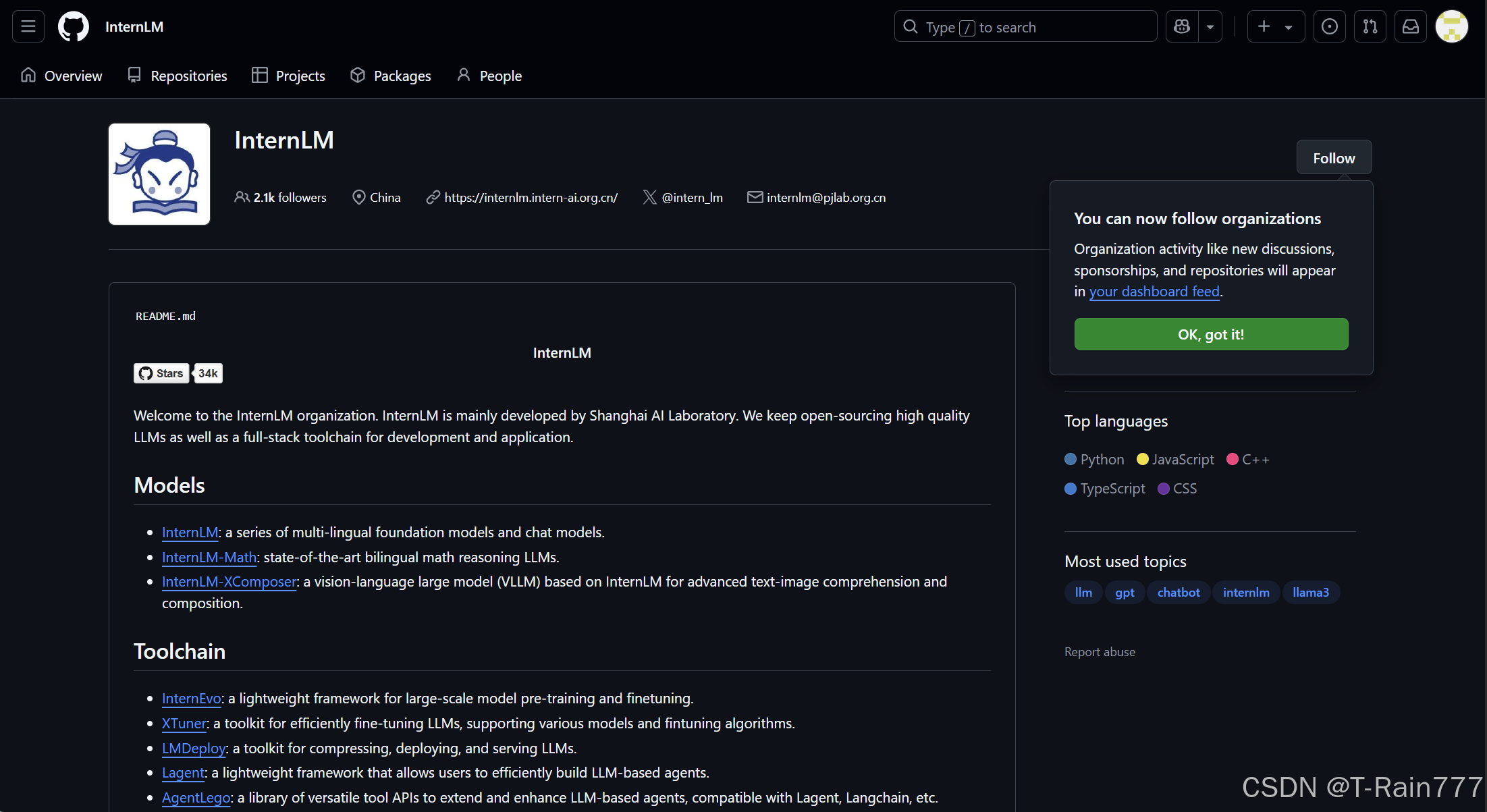

工具链:包括分布式训练框架、轻量化推理引擎、模型压缩工具等,优化训练效率与部署成本。

-

应用层:提供面向教育、医疗、金融等行业的开源解决方案,支持开发者快速定制场景化模型。

2. 开源生态特点

-

全链路透明化:从数据清洗到模型训练的全流程可复现,确保技术可信度。

-

模块化设计:开发者可按需调用数据、算法或工具模块,灵活适配业务需求。

-

社区驱动创新:通过开源社区汇聚开发者、企业与学术机构,共同迭代优化技术。

二、核心优势:破解大模型应用难题

1. 降低研发成本

-

数据开源:提供高质量标注数据集(如通用语料库、行业垂直数据),减少数据采集与标注成本。

-

高效训练框架:支持千卡级分布式训练,优化算力利用率,训练效率提升30%以上。

-

轻量化部署:通过模型剪枝、量化技术,将大模型压缩至10%以下体积,适配边缘设备。

2. 加速场景落地

-

行业适配工具包:如医疗领域的病历结构化工具、教育领域的智能批改API,缩短开发周期。

-

低代码开发平台:支持可视化模型微调,非专业开发者亦可快速构建定制化AI应用。

3. 推动技术民主化

-

避免重复造轮子:开源社区共享模型优化经验,减少企业“从零开始”的研发投入。

-

赋能中小企业:通过低成本接入大模型能力,助力中小厂商实现智能化升级。

三、典型应用场景

1. 教育领域

-

智能教学助手:基于多模态交互能力,提供个性化学习建议与习题讲解。

-

论文自动评审:通过文本理解与逻辑分析,辅助教师高效完成论文初筛。

2. 医疗健康

-

辅助诊断系统:结合医学知识库,分析患者症状与影像数据,生成诊断参考。

-

药物研发加速:利用分子结构预测模型,缩短新药候选化合物筛选周期。

3. 工业制造

-

设备故障预测:通过时序数据分析,提前预警产线设备异常,减少停机损失。

-

智能质检:基于视觉大模型,实现复杂零部件缺陷检测,准确率超99%。

4. 金融科技

-

智能投顾:分析市场数据与用户风险偏好,生成个性化投资策略。

-

合规审查:自动化扫描合同文本,识别潜在法律风险。

四、社会价值与行业影响

-

技术普惠化:打破巨头技术垄断,让更多企业与开发者共享AI红利。

-

推动产学研协同:开源社区成为高校、企业联合攻关的桥梁,加速技术转化。

-

伦理可控性:通过开放透明机制,便于公众监督大模型的公平性、安全性。

五、未来展望

书生大模型全链路开源开放体系将持续迭代,未来计划在以下方向深化:

-

多模态深度融合:支持跨文本、图像、语音的联合推理与生成。

-

绿色AI技术:研发低能耗训练算法,减少碳足迹。

-

全球化协作:构建多语言模型生态,服务“一带一路”等国际化场景。

结语

书生大模型全链路开源开放体系不仅是技术工具的革命,更是AI发展范式的创新。它以开源为纽带,连接技术研发与产业需求,推动人工智能从“精英游戏”走向“全民共创”。随着生态的不断完善,这一体系有望成为驱动千行百业智能化转型的核心引擎,为数字经济时代注入新动能。

2083

2083

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?