一、前期准备工作

1.建立一个虚拟机,并安装centos7

2.配置网络,能够ping外网(www.baidu.com)

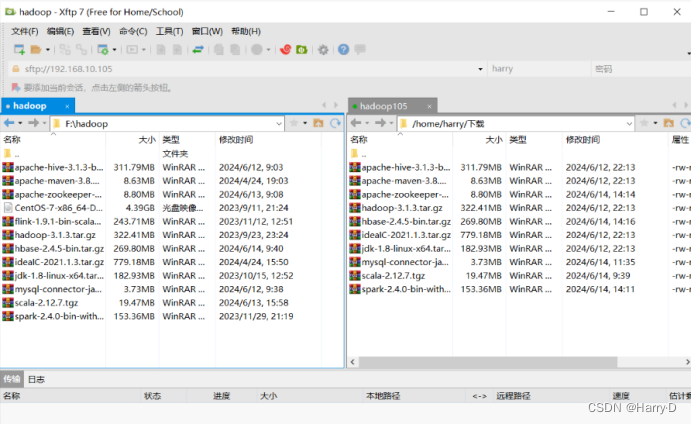

3.连接Shell,方便后续敲代码,以及传输文件,需要安装XShell7和 Xftp7

4.要用的文件都需要用XFTP 传输,拖过去或者双击

二、安装必要部件

1.JDK(1.8版本)

tar -zxvf jdk-8u361-linux-x64.tar.gz -C /opt

这是在压缩包路径下,进行解压,解压到指定位置 /opt

配环境变量

vim /etc/profile

在文件最后面加上这两行

export JAVA_HOME=/opt/jdk

export PATH=$JAVA_HOME/bin:$PATH

第一行的路径要填你jdk安装的路径,名字都要对。

文件生效

source /etc/profile

查看版本

java -version

2.Hadoop

同样解压,这些操作都一样

tar -zxvf hadoop-3.1.3.tar.gz

vim /etc/profile

配环境变量

加上这两行

export HADOOP_HOME=/opt/hadoop

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

source /etc/profile

三.搭建伪分布式

免密登录,可以搜搜其他博主的方法。

hadoop文件配置

1.HDFS

cd /opt/hadoop/etc/hadoop/

要配置的文件都在这个目录下

可以用

ll

查看

vim来编辑文件

core-site.xml

<!--配置hdfs文件系统的命名空间-->

<property>

<name>fs.defaultFS</name>

<value>hdfs://hadoop105:8020</value>

</property>

<!-- 配置临时数据存储目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/hadoop/tmp/</value>

</property>

hadoop105是我的主机名,你要改成自己的

hdfs-site.xml

<configuration>

<!-- nn web端访问地址-->

<property>

<name>dfs.namenode.http-address</name>

<value>hadoop105:9870</value>

</property>

<!-- 2nn web端访问地址-->

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>hadoop105:9868</value>

</property>

</configuration>

hadoop-env.sh

export JAVA_HOME=/opt/jdk

格式化

!!!只能格式化一次,每次格式化数据都会丢失。

hdfs namenode -format

2.YARN

yarn-site.xml

<!--RM的hostname-->

<property>

<name>yarn.resourcemanager.hostsname</name>

<value>hadoop</value>

</property>

<!--NodeManager上运行的附属服务。需配置成mapreduce_shuffle,才可运行MapReduce程序-->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

mapred-site.xml

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

四.启动服务用户定义

进入hadoop sbin

cd $HADOOP_HOME/sbin

vim start-dfs.sh

vim stop-dfs.sh

在头部加入这些内容

#!/usr/bin/env bash

HDFS_DATANODE_USER=root

HADOOP_SECURE_DN_USER=hdfs

HDFS_NAMENODE_USER=root

HDFS_SECONDARYNAMENODE_USER=root

同样

vim start-yarn.sh

vim stop-yarn.sh

#!/usr/bin/env bash

YARN_RESOURCEMANAGER_USER=root

HADOOP_SECURE_DN_USER=yarn

YARN_NODEMANAGER_USER=root

五.启动集群

start-all.sh

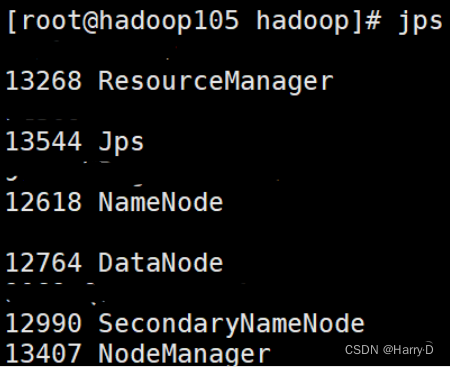

输入jps查看结果

若为下图 ,则启动成功

650

650

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?