得益于 Stable Diffusion 的开源特性,当下众多开发者推出了基于 SD 来生成动画和视频的应用技术以及扩展插件。

在众多此类技术当中,AnimateDiff 插件凭借“效果丝滑、稳定且无闪烁”等特性,成为目前 Stable diffusion 里效果最为出色的生成动画视频插件之一。

今天,我们就来为大家详细介绍这款在 Stable diffusion 中能够快速生成动画的插件——AnimateDiff。

AnimateDiff专用模型下载

AnimateDiff有其自身专门的运动模型mm_sd_v15_v2.ckpt 和 专属的镜头运动lora,需要放置在对应的位置。

stablediffusion位置:

运动模型放在stable-diffusion-webui\extensions\sd-webui-animatediff\model里面

运动lora放在stable-diffusion-webui\models\Lora里面

ComfyUI版位置:

运动模型放在ComfyUI_windows_portable\ComfyUI\custom_nodes\ComfyUI-AnimateDiff-Evolved\models里面

运动lora放在ComfyUI_windows_portable\ComfyUI\custom_nodes\ComfyUI-AnimateDiff-Evolved\motion_lora里面

代码版animatediff位置:

运动模型和运动lora都可以放在animatediff-cli-prompt-travel\data\models\motion-module里面

下载链接:

链接:https://pan.quark.cn/s/55a0cff30b9b

1、Webui版AnimateDiff

在stablediffusion webui扩展界面,点击从网址安装,复制https://github.com/continue-revolution/sd-webui-animatediff到扩展git仓库网址,点击安装即可,等待安装完毕,重启一下SD UI界面。

Webui版AnimateDiff具体功能如下:

2、Comfyui版AnimateDiff

Win和Mac都可以安装Comfyui版AnimateDiff

Win ComfyUI安装

1、下载和解压提供的WIN & MAC 通用Comfyui安装包。

2、在里面的updata文件夹里面,先双击运行一下update_comfyui.bat 升级一下最新版本

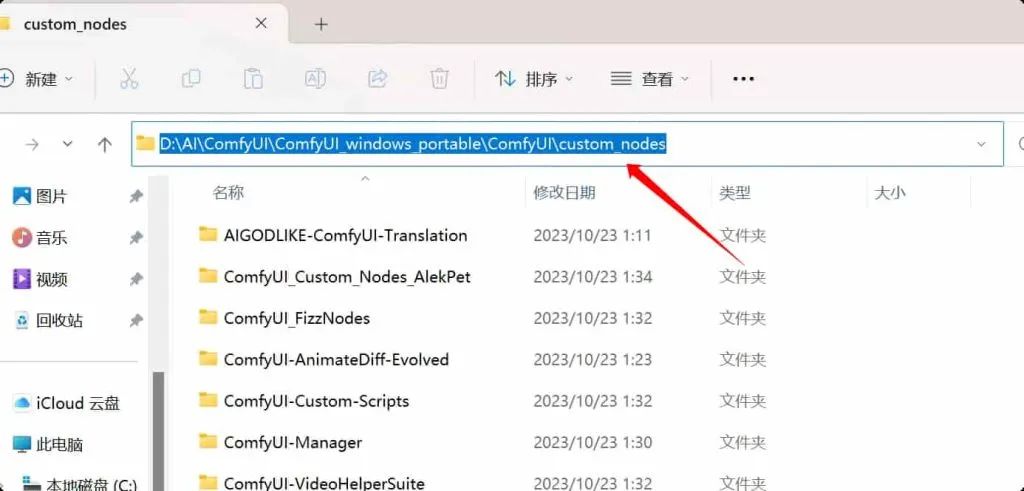

3、进入ComfyUI_windows_portable\ComfyUI\custom_nodes文件夹,在箭头的导航栏位置输入cmd回车

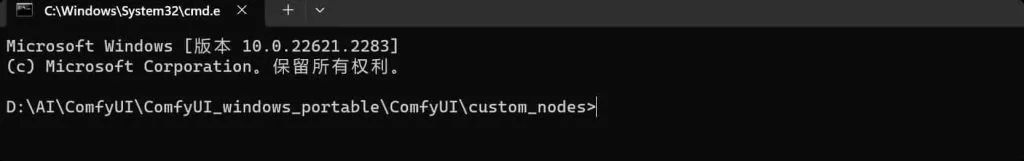

确保命令代码已经在这个custom_nodes目录内

然后依次输入下面3段代码安装3个插件,切记要分开一段段输入,回车安装(如果显示不是内部命令,证明没有安装git,本教程页面最下面的第3点方法安装git)

git clone https://github.com/ltdrdata/ComfyUI-Manager

git clone https://github.com/AIGODLIKE/AIGODLIKE-ComfyUI-Translation.git

git clone https://github.com/Kosinkadink/ComfyUI-AnimateDiff-Evolved

4、按照本页教程最上面AnimateDiff专用模型的放置位置放置模型。

而Stablediffusion常用的大模型则是放在ComfyUI_windows_portable\ComfyUI\models\checkpoints里面,

Lora则放在ComfyUI_windows_portable\ComfyUI\models\loras里面

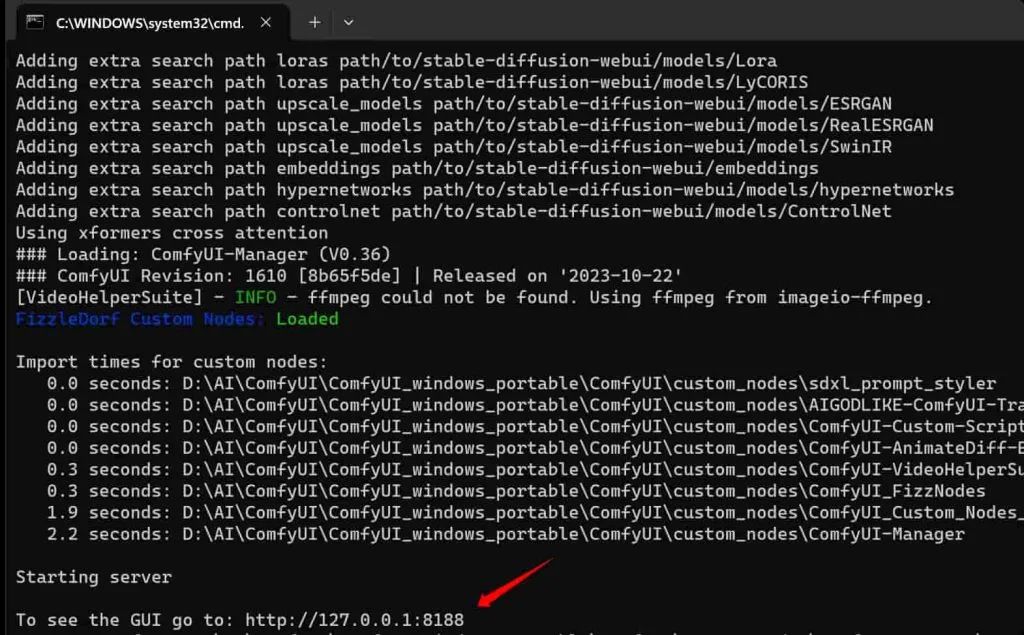

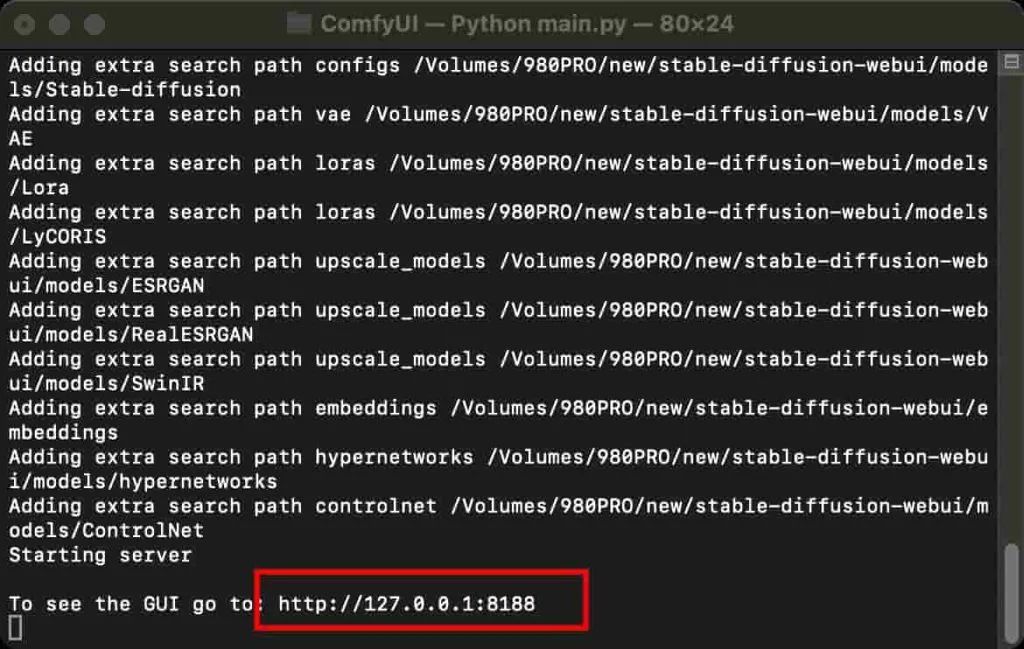

5、运行ComfyUI_windows_portable文件夹里面的run nvidia gpu.bat,看到有http://127.0.0.1:8188/地址出现,把这个地址在浏览器打开即可进入ComfyUI界面。

Mac ComfyUI安装

1、下载和解压提供的WIN & MAC 通用Comfyui安装包,下载链接。

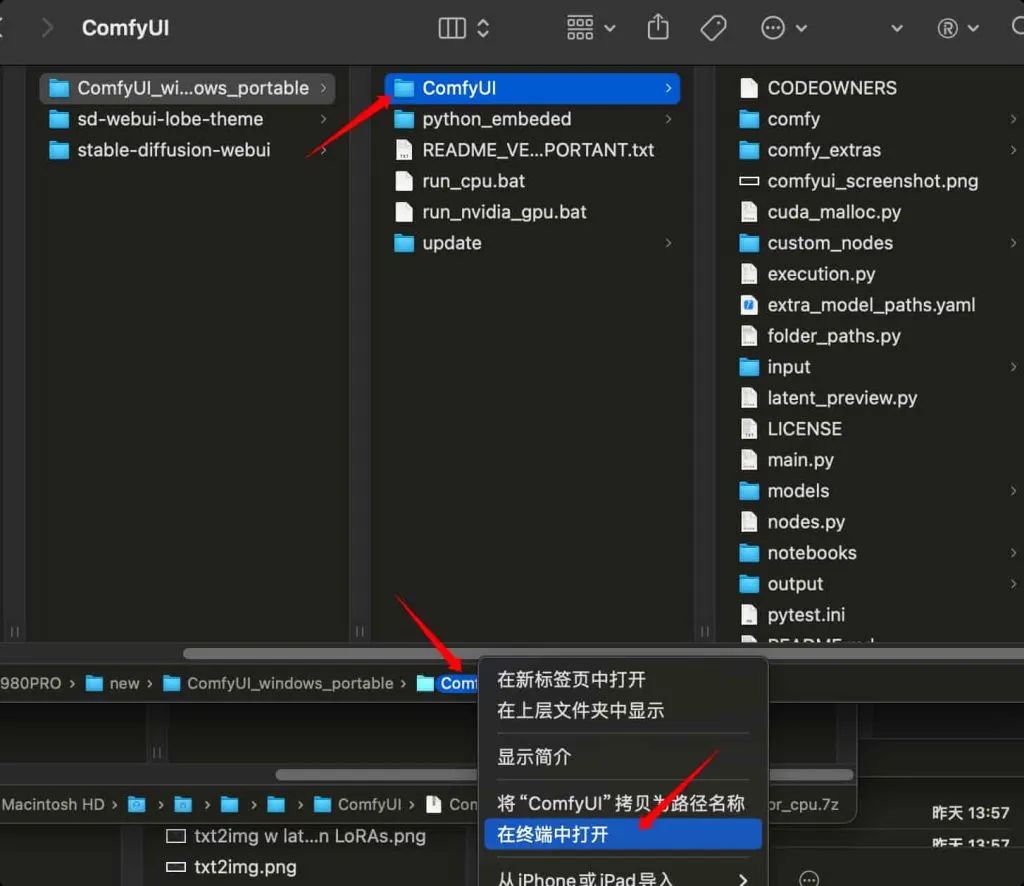

2、用终端打开里面的ComfyUI

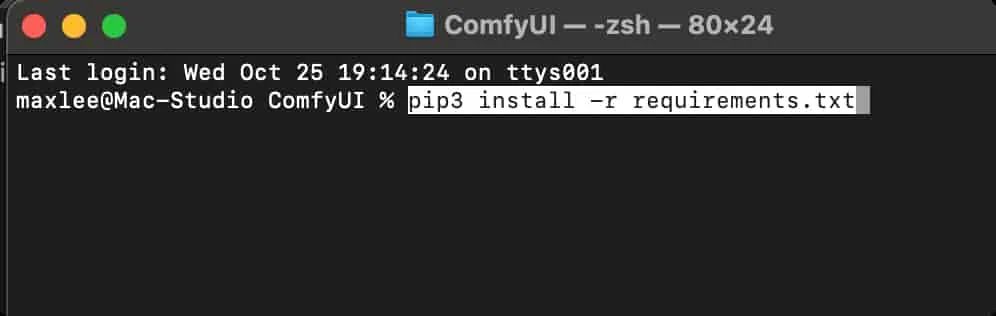

3、确保终端代码能定位到ComfyUI这个文件夹,然后输入pip install -r requirements.txt 或者 pip3 install -r requirements.txt

4、这时候关闭终端,去到ComfyUI_windows_portable/ComfyUI/custom_nodes文件夹,用第二步的方式用终端打开custom_nodes这个文件夹。然后依次输入下面3段代码安装3个插件,切记要分开一段段输入,回车安装(如果显示不是内部命令,证明没有安装git,本教程页面最下面的第3点方法安装git)

git clone https://github.com/ltdrdata/ComfyUI-Manager

git clone https://github.com/AIGODLIKE/AIGODLIKE-ComfyUI-Translation.git

git clone https://github.com/Kosinkadink/ComfyUI-AnimateDiff-Evolved

5、按照本页教程最上面AnimateDiff专用模型的放置位置放置模型。(注意AnimateDiff专用模型和stablediffusion大模型放置的路径是不一样的)

而Stablediffusion常用的大模型则是放在ComfyUI_windows_portable\ComfyUI\models\checkpoints里面,

Lora则放在ComfyUI_windows_portable\ComfyUI\models\loras里面

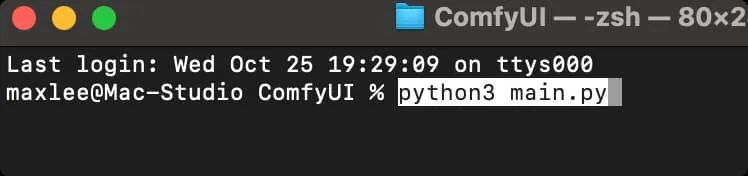

6、回到comfyui文件夹,用终端运行这个文件夹,输入python main.py或者python3 main.py

看到有http://127.0.0.1:8188地址出现,把这个地址在浏览器打开即可进入ComfyUI界面。

3、代码版animatediff-cli-prompt-travel

目前官方只提供win版本的安装步骤,安装其实非常简单,一步步回车即可

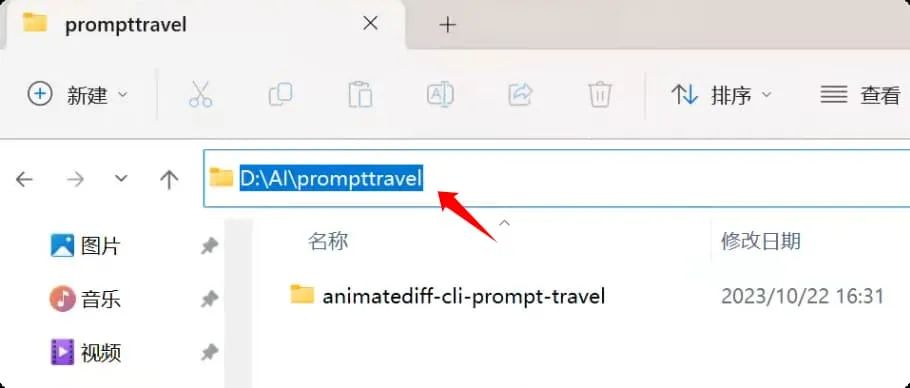

1、新建一个用于安装代码版animatediff的文件夹,要英文命名,整个路径不要有中文。

2、在这个文件夹的导航栏上输入cmd

3、然后在命令提示符里面依次输入12个代码,一个一个来,输入后回车等待执行完毕再输入下一个代码。(注意,下面第7个代码比较长,请完整复制)全程需要魔法网络。

git clone https://github.com/s9roll7/animatediff-cli-prompt-travel.git

cd animatediff-cli-prompt-travel

py \-3.10 -m venv venv

venv\\Scripts\\activate.bat

set PYTHONUTF8=1

python -m pip install --upgrade pip

python -m pip install torch==2.0.1+cu118 torchvision==0.15.2+cu118 torchaudio==2.0.2 --index-url https://download.pytorch.org/whl/cu118

python -m pip install -e .

python -m pip install xformers

python -m pip install -e .\[stylize\]

python -m pip install -e .\[dwpose\]

python -m pip install -e .\[stylize\_mask\]

4、按照本页教程最上面AnimateDiff专用模型的放置位置放置模型。

而Stablediffusion的大模型和Lora放置在animatediff-cli-prompt-travel/data/models/sd文件夹里面。

5、运行方法:

在animatediff-cli-prompt-travel目录上放导航栏位置输入cmd,输入

venv\\Scripts\\activate.bat

然后输入

animatediff generate -c config/prompts/对应的名称.json -W 512 -H 768 -L 128 -C 16

意思是产出宽512 x 高768 的视频,一共128帧长度,16帧每秒的帧速率,按照文档“对应的名称.json”的脚本来运行。

4、常见错误问题

1、确保全程网络通畅,需要科学魔法网络才能安装部署成功。

2、所有安装路径避免有中文,用全英文路径。

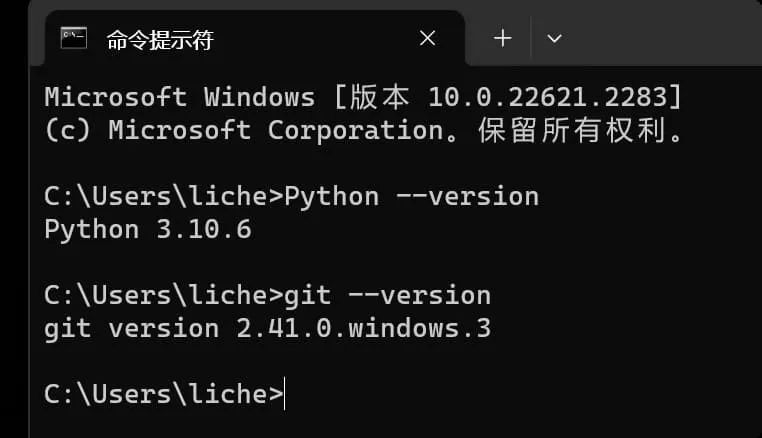

3、确保安装了python和git,可以在CMD里面或者终端里面输入下面的代码,检查是否已经安装对应的部件,当返回版本号证明已经安装正确。

Python --version 或者 python3 -V

git --version

查询不到的话,按照下面的教程里面的手动安装方式,有讲解怎么安装python和git

https://cgmi.com/archives/326

4、使用生成不了视频的话,按照安装包第四项,安装ffmpeg,安装包内有安装教程。

5、如果还是生成不了视频,SDwebui版本要更新最新的客户端版本,包括启动器也要更新,秋叶更新最新的4.4。comfyui版本要在菜单里面点击更新全部。

如何学习Stable Diffusion ?

2023年,AIGC绘画元年,从年初以来,以Midjourney和Stable Diffusion 为代表的AIGC绘画迎来春天,掀起了一场生产力革命。

Stable diffuson最大的优势在于它的可控性以及免费开源。很多人想学习和使用stable diffusion,网上一搜,往往在安装这一步就劝退了很多人。

也因为Stable diffusion中的参数非常非常多,极其容易劝退,但事实是,对于我们来说,只需要熟练使用即可,并不需要深入的去研究它的原理。

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的StableDiffusion学习资料包括:StableDiffusion学习思维导图、StableDiffusion必备模型,精品AI学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

第一阶段(10天)Stable Diffusion初始入门

该阶段让大家对StableDiffusion有一个最前沿的认识,规避碎片化学习,对SD的理解将超过 95% 的人。可以在相关讨论发表高级、不跟风、又接地气的见解,成为AI艺术创作领域的佼佼者。

-

1.Stable Diffusion的起源及工作原理

-

2.Midjourney跟Stable Diffusion之间的的区分指南

-

3.Stable Diffusion一键包快速实现部署

-

4.Stable Diffusion启动器参数

-

5.Stable Diffusion的“Settings”页面高效配置Al模型

-

6.Stable Diffusion的插件安装指南

-

7.汉化Stable Diffusion界面实操

-

8.Stable Diffusion中的大模型使用指南

-

9.Stable Diffusion VAE模型

-

10.txt2img文本提示转换成图像实操

-

11.生成(Generate)功能相关的系列按钮

-

12.单批跟总批的配比选择指南

-

13.采样方法

-

14.生成图像的引导迭代步数

-

…

第二阶段(30天)Stable Diffusion进阶应用

该阶段我们正式进入StableDiffusion进阶实战学习,学会构造私有知识库,扩展不同的艺术风格。快速根据甲方的要求改动高效出图。掌握智能绘图最强的AI软件,抓住最新的技术进展,适合所有需出图行业。真·生产力大爆发!!!

-

1.涂鸦Sketch功能

-

2.涂重绘鸦Inpainting Sketch功能

-

3.局部重绘Inpainting功能详解

-

4.上传蒙版Inpainting upload功能

-

5.segment anything辅助抠图功能

-

6.inpaint anything蒙版获取功能

-

7.ControlNet的起源及工作原理

-

8.ControlNet插件扩展功能

-

9.ControlNet基础界面使用指南

-

10.ControlNet五种线稿模型

-

11…ControlNet重绘修复模型

-

12.ControlNet 图像提示迁移模型实战

-

…

第三阶段(30天)专属Lora模型训练

恭喜你,如果学到这里,所有设计类岗位你将拥有优先选择权,自己也能训练Lora 了!通过对模型进行微调有效减少模型的参数量和计算量,以生成特定的人物、物品或画风,掌握更多技术方案。

到此为止,大概2个月的时间。你已经成为了一名“AI小子”。那么你还想往下探索吗?

-

1.定制个人的LORA模型适配个性化需求

-

2.高质量素材过程中的重要事项收集指南

-

3.birme工具批量化的处理图片实战

-

4.BooruDatasetTagManager工具打标图片实战

-

5.正则化训练集使用指南

-

6.SD-tainerLORA训练工具

-

7.SD-tainer工具训练自己的Lora操作

-

8.LORA模型测试指南

-

…

第四阶段(20天):商业闭环

对氛围性场景,关键词技巧,图生图实操流程等方面有一定的认知,教你「精准控制」所有图片细节,可以在云端和本地等多种环境下部署StableDiffusion,找到适合自己的项目/创业方向,做一名被 AI 武装的社会主义接班人。

-

1.CodeFomer模型实战

-

2.固定同一人物形象IP实战

-

3.广告设计

-

4.电商海报设计

-

5.制作3D质感

-

6.室内设计全案例流程

-

7.AI赋能电商新视觉

-

8.老照片修复

-

9.小说推文

-

10.影视游戏制作

-

11.游戏开发设计

-

12.三维软件去精准辅助SD出高质量图实战

-

13.GFPGAN模型实战

-

…

学习是一个过程,只要学习就会有挑战。天道酬勤,你越努力,就会成为越优秀的自己。

如果你能在15天内完成所有的任务,那你堪称天才。然而,如果你能完成 60-70% 的内容,你就已经开始具备成为一名AI绘图大神的正确特征了。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

1468

1468

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?