文章目录

MapReduce 案例倒排索引

一、案例分析

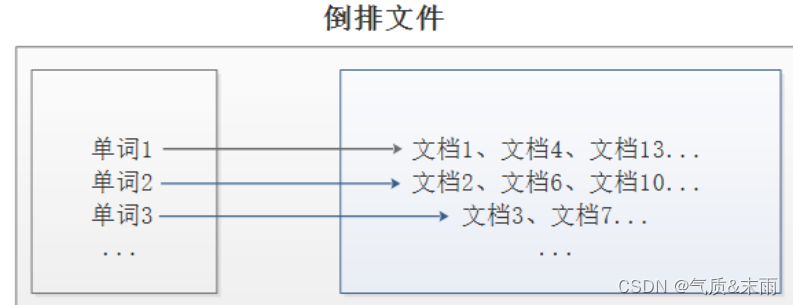

1、倒排索引介绍

倒排索引是文档检索系统中最常用的数据结构,被广泛应用于全文搜索引擎。倒排索引主要用来存储某个单词(或词组)在一组文档中的存储位置的映射,提供了可以根据内容来查找文档的方式,而不是根据文档来确定内容,因此称为倒排索引(Inverted Index)。带有倒排索引的文件我们称为倒排索引文件,简称倒排文件(Inverted File)。

2、案例需求及分析

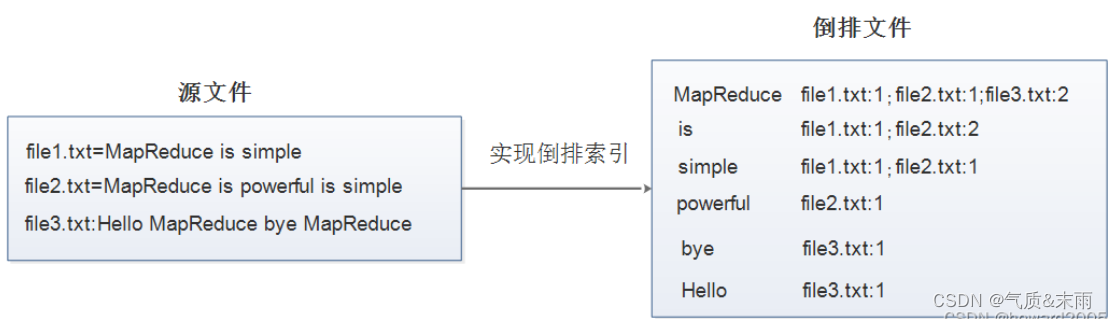

现假设有三个源文件file1.txt、file2.txt和file3.txt,需要使用倒排索引的方式对这三个源文件内容实现倒排索引,并将最后的倒排索引文件输出。

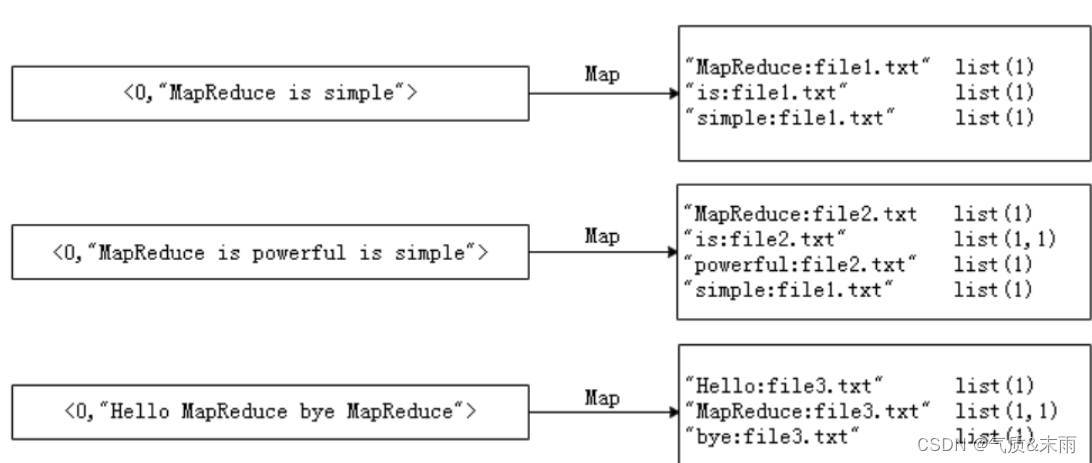

首先,使用默认的TextInputFormat类对每个输入文件进行处理,得到文本中每行的偏移量及其内容。Map过程首先分析输入的<key,value>键值对,经过处理可以得到倒排索引中需要的三个信息:单词、文档名称和词频。

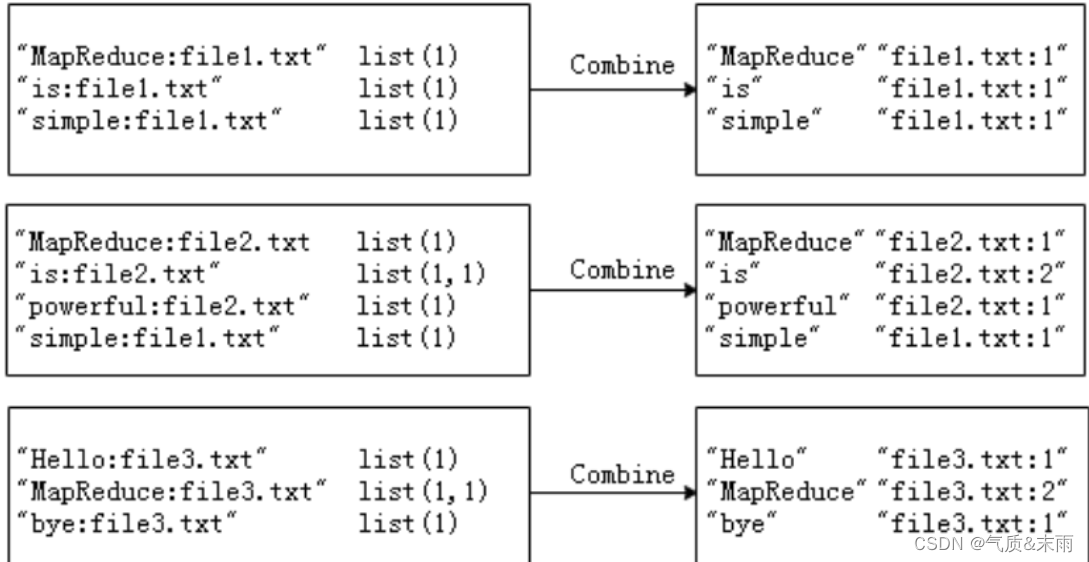

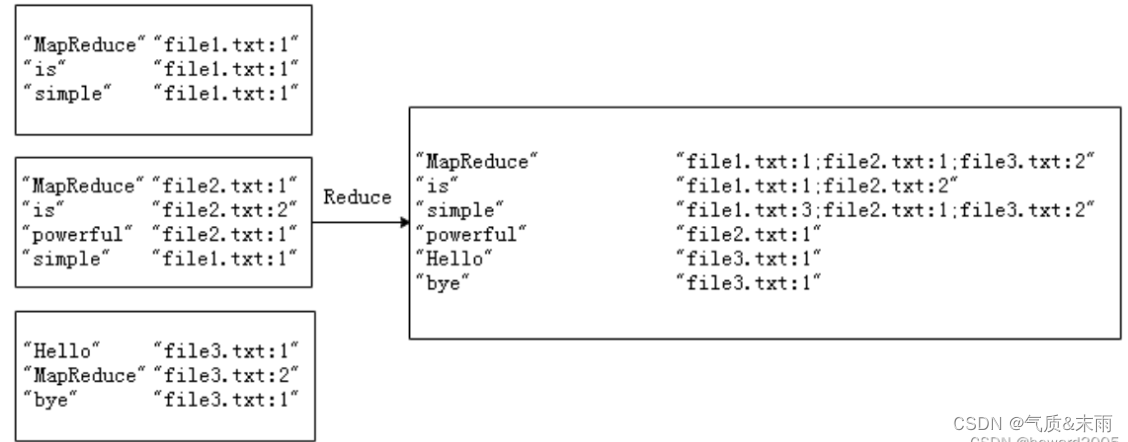

经过Map阶段数据转换后,同一个文档中相同的单词会出现多个的情况,而单纯依靠后续Reduce阶段无法同时完成词频统计和生成文档列表,所以必须增加一个Combine阶段,先完成每一个文档的词频统计。

经过上述两个阶段的处理后,Reduce阶段只需将所有文件中相同key值的value值进行统计,并组合成倒排索引文件所需的格式即可。

二、MapReduce倒排索引编程实现

1、准备数据文件

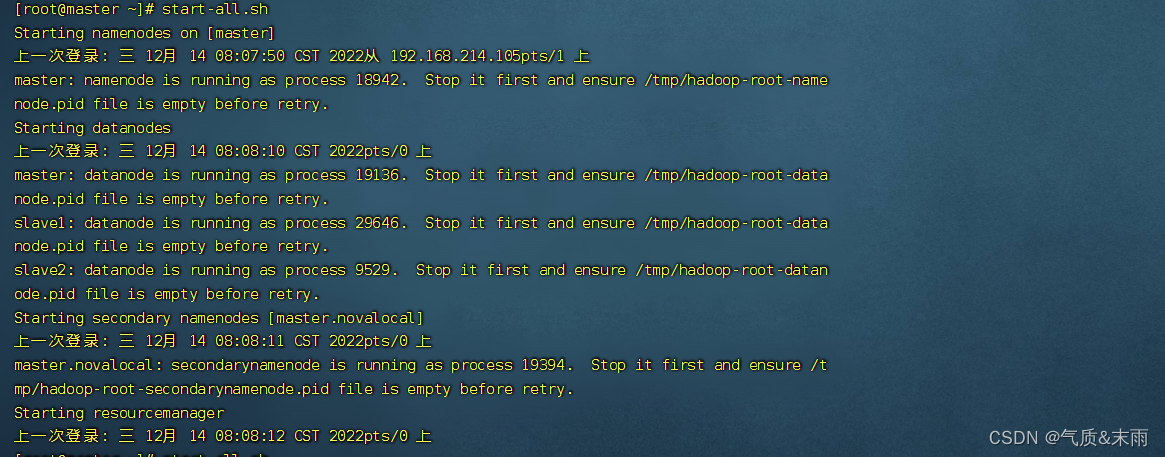

启动hadoop服务,输入命令:start-all.sh

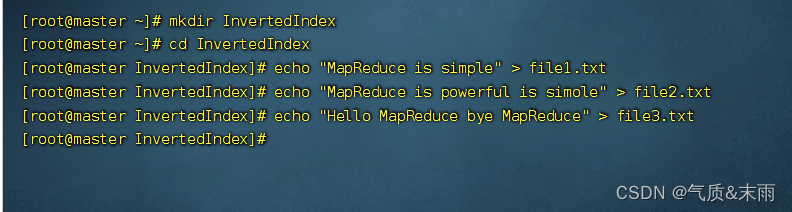

(1) 在虚拟机上创建文本文件

创建InvertedIndex目录,在里面创建三个文本文件 file1.txt、file2.txt、file3.txt

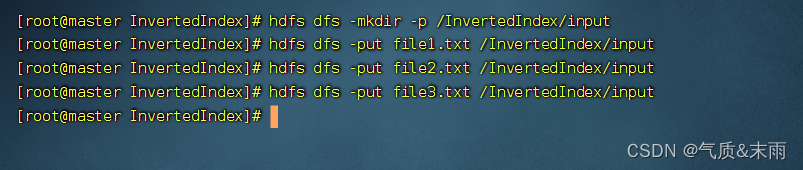

(2) 上传到HDFS指定文件

创建/InvertedIndex/input目录,执行命令:hdfs dfs -mkdir -p /InvertedIndex/input

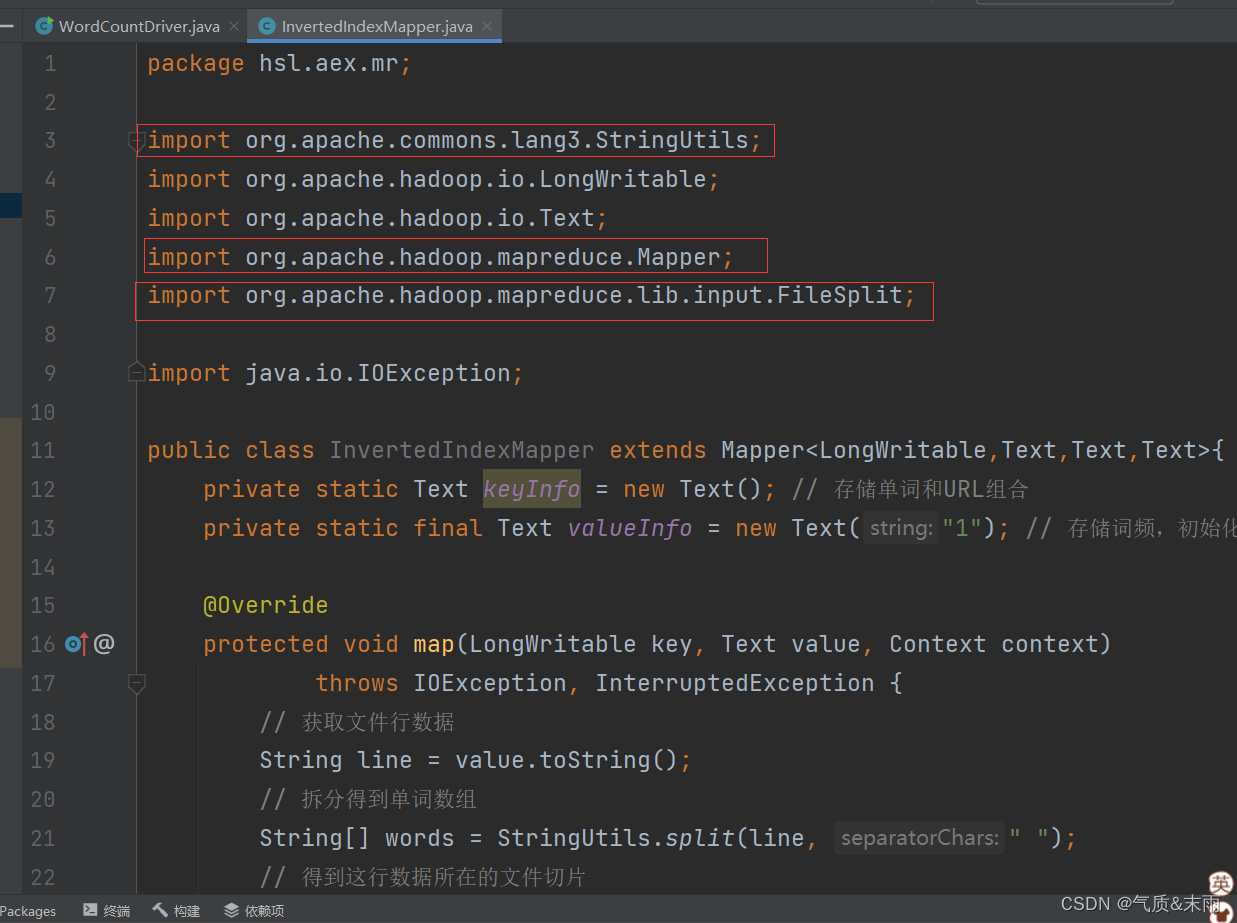

2、map阶段实现

首先,使用IntelliJ开发工具创建Maven项目InvertedIndex,并且新创建hsl.aex.mr包,在该路径下编写自定义Mapper类InvertedIndexMapper,主要用于将文本中的单词按照空格进行切割,并以冒号拼接,“单词:文档名称”作为key,单词次数作为value,都以文本方式输出至Combine阶段。

(1) 创建倒排索引映射器类

创建hsl.aex.mr包,在包里创建InvertedIndexMapper类

package hsl.aex.mr;

import org.apache.commons.lang3.StringUtils;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Mapper;

import org.apache.hadoop.mapreduce.lib.input.FileSplit;

import java.io.IOException;

public class InvertedIndexMapper extends Mapper<LongWritable,Text,Text,Text>{

private static Text keyInfo = new Text(); // 存储单词和URL组合

private static final Text valueInfo = new Text("1"); // 存储词频,初始化为1

@Override

protected void map(LongWritable key, Text value, Context context)

throws IOException, InterruptedException {

// 获取文件行数据

String line = value.toString();

// 拆分得到单词数组

String[] words = StringUtils.split(line, " ");

// 得到这行数据所在的文件切片

FileSplit fileSplit = (FileSplit) context.getInputSplit();

// 根据文件切片得到文件名

String fileName = fileSplit.getPath().getName();

for (String word : words) {

// key值由单词和URL组成,如“MapReduce:file1.txt”

keyInfo.set(word + ":" + fileName);

// 将键值对数据传入下一个阶段

context.write(keyInfo, valueInfo);

}

}

}

注意包不要导入错了

3、Combine阶段实现

根据Map阶段的输出结果形式,在hsl.aex.mr包下,自定义实现Combine阶段的类InvertedIndexCombiner,对每个文档的单词进行词频统计。

创建倒排索引合并器类

在hsl.aex.mr包里创建InvertedIndexCombiner类

package hsl.aex.mr;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Reducer;

import java.io.IOException;

public class InvertedIndexCombiner extends Reducer<Text,Text,Text,Text>{

private static Text info = new Text();

// 输入: <MapReduce:file3.txt {1,1,...}>

// 输出: <MapReduce file3.txt:2>

@Override

protected void reduce(Text key, Iterable<Text> values, Context context)

throws IOException, InterruptedException {

// 统计词频

int sum = 0;

for (Text value : values) {

sum += Integer.parseInt(value.toString());

}

// 获取分隔符冒号的位置

int splitIndex = key.toString().indexOf(":");

// 重新设置value值由URL和词频组成

info.set(key.toString().substring(splitIndex + 1) + ":" + sum);

// 重新设置key值为单词

key.set(key.toString().substring(0, splitIndex));

// 将键值对数据传入下一个阶段

context.write(key, info);

}

}

4、Reduce阶段实现

根据Combine阶段的输出结果形式,同样在hsl.aex.mr包下,自定义Reducer类InvertedIndexMapper,主要用于接收Combine阶段输出的数据,并最终案例倒排索引文件需求的样式,将单词作为key,多个文档名称和词频连接作为value,输出到目标目录。

创建倒排索引归并器类

在hsl.aex.mr包里创建InvertedIndexReducer类

package hsl.aex.mr;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Reducer;

import java.io.IOException;

public class InvertedIndexReducer extends Reducer<Text,Text,Text,Text>{

private static Text result = new Text();

// 输入:<MapReduce file3.txt:2>

// 输出:<MapReduce file1.txt:1;file2.txt:1;file3.txt:2;>

@Override

protected void reduce(Text key, Iterable<Text> values, Context context)

throws IOException, InterruptedException {

// 生成文档列表

String fileList = new String();

for (Text value : values) {

fileList += value.toString() + ";";

}

// 设置结果数据

result.set(fileList);

// 将键值对数据输出

context.write(key, result);

}

}

5、Driver主类实现

编写MapReduce程序运行主类InvertedIndexDriver,主要用于设置MapReduce工作任务的相关参数,对HDFS上/InvertedIndex/input目录下的源文件实现倒排索引,并将结果输入到HDFS的/InvertedIndex/output目录下。

创建倒排索引驱动器类

在hsl.aex.mr包里创建InvertedIndexDriver类

package hsl.aex.mr;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FSDataInputStream;

import org.apache.hadoop.fs.FileStatus;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IOUtils;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

import java.net.URI;

public class InvertedIndexDriver {

public static void main(String[] args) throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 获取作业实例

Job job = Job.getInstance(conf);

// 设置作业启动类

job.setJarByClass(InvertedIndexDriver.class);

// 设置Mapper类

job.setMapperClass(InvertedIndexMapper.class);

// 设置map任务输出键类型

job.setMapOutputKeyClass(Text.class);

// 设置map任务输出值类型

job.setMapOutputValueClass(Text.class);

// 设置Combiner类

job.setCombinerClass(InvertedIndexCombiner.class);

// 设置Reducer类

job.setReducerClass(InvertedIndexReducer.class);

// 设置reduce任务输出键类型

job.setOutputKeyClass(Text.class);

// 设置reduce任务输出值类型

job.setOutputValueClass(Text.class);

// 定义uri字符串

String uri = "hdfs://master:9000";

// 创建输入目录

Path inputPath = new Path(uri + "/InvertedIndex/input");

// 创建输出目录

Path outputPath = new Path(uri + "/InvertedIndex/output");

// 获取文件系统

FileSystem fs = FileSystem.get(new URI(uri), conf);

// 删除输出目录

fs.delete(outputPath, true);

// 给作业添加输入目录

FileInputFormat.addInputPath(job, inputPath);

// 给作业设置输出目录

FileOutputFormat.setOutputPath(job, outputPath);

// 等待作业完成

job.waitForCompletion(true);

// 输出统计结果

System.out.println("======统计结果======");

FileStatus[] fileStatuses = fs.listStatus(outputPath);

for (int i = 1; i < fileStatuses.length; i++) {

// 输出结果文件路径

System.out.println(fileStatuses[i].getPath());

// 获取文件输入流

FSDataInputStream in = fs.open(fileStatuses[i].getPath());

// 将结果文件显示在控制台

IOUtils.copyBytes(in, System.out, 4096, false);

}

}

}

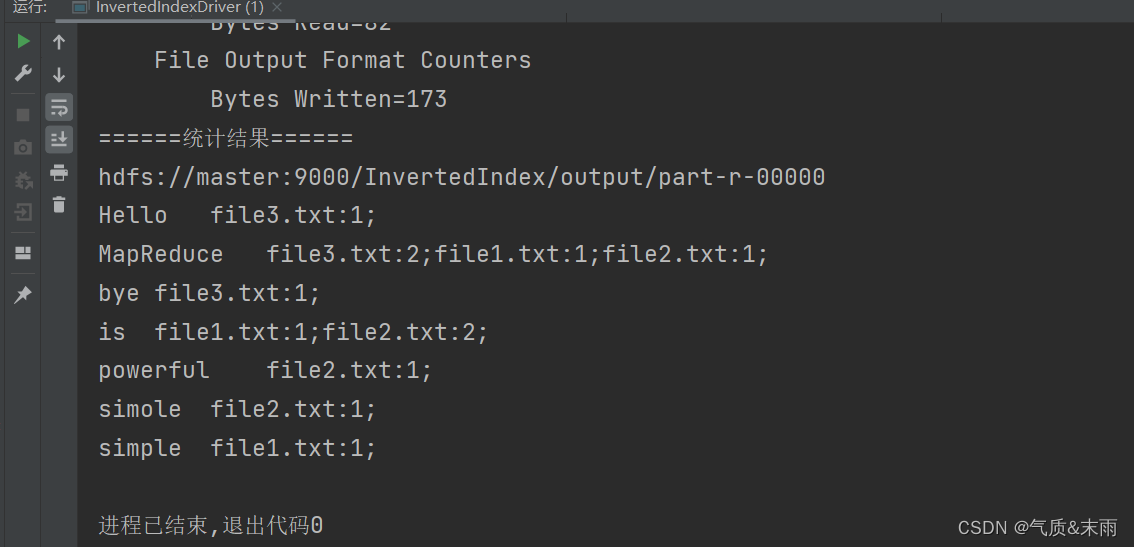

6、运行倒排索引驱动器类,查看结果

458

458

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?