文章目录

前言

本文将分享如何在群晖NAS上本地部署并运行一个基于大语言模型Llama 2的个人聊天机器人,并结合内网穿透工具实现公网远程访问。由于本地部署对设备配置有一定要求,建议使用高性能的服务器以获得更好的体验。

目前,大多数大语言模型产品都是基于在线服务的。如果希望在本地自行部署一个大语言模型,应该如何操作呢?接下来,我们将介绍一款可以在本地运行的大语言模型——Llama 2。

Llama 2是一款开源的大语言模型,其训练数据量已达到7B级别,在上下文长度为4K的单轮和多轮对话中表现优异。要成功部署和运行Llama 2,需要借助一个名为Ollama的框架。

Ollama是一个强大的框架,旨在简化在Docker容器中部署大型语言模型(LLM)的过程。它通过提供简单的安装指令,使用户能够轻松在本地运行大型开源语言模型。

利用Ollama框架,可以方便地运行Llama 2大语言模型。同时,为了与模型进行交互,还需要部署一个Web交互界面——Chatbot-Ollama。

Chatbot-Ollama是基于Ollama框架的聊天机器人前端应用。它利用Ollama提供的接口和功能,将大型语言模型集成到聊天机器人中,使其能够与用户进行互动,并提供多种聊天服务。

通过将Chatbot-Ollama接入本地Ollama框架运行的Llama 2大语言模型,我们可以轻松创建一个本地聊天机器人。然而,Chatbot-Ollama的本地部署仅限于本地访问,无法提供远程访问。因此,我们还需要安装内网穿透工具cpolar,以便让本地聊天机器人能够被远程访问。

1. 拉取相关的Docker镜像

运行Llama 2需要借助Ollama镜像,对语言模型进行交互需要用到Chatbot-Ollama前端界面,所以我们需要拉取这两个docker镜像,本例群晖版本由于无法直接在群晖控制面板docker界面搜索下载镜像,所以采用命令行方式进行镜像下载,首先开启群晖ssh连接,然后使用工具通过ssh连接上群晖,分别执行下面docker命令 拉取

*拉取Ollama镜像命令

sudo docker pull ollama/ollama:latest

*拉取Chatbot-Ollama镜像命令

sudo docker pull ghcr.io/ivanfioravanti/chatbot-ollama:main

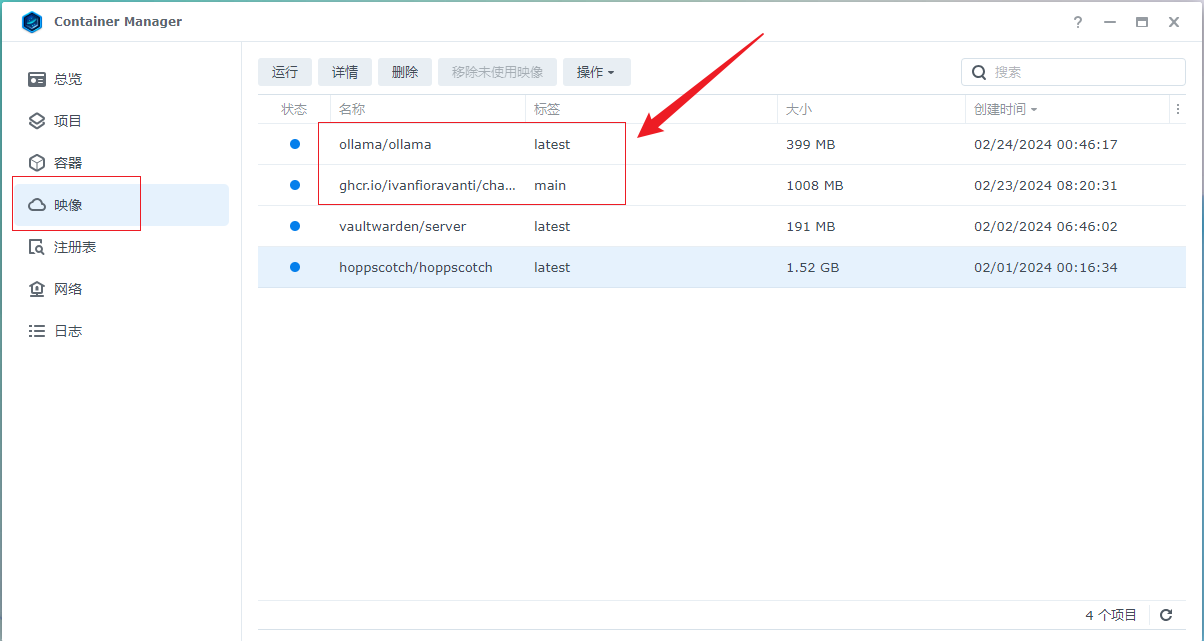

拉取成功后,我们可以在Docker界面看到拉取的两个镜像,下面开始运行两个镜像,首先运行ollama

2. 运行Ollama 镜像

选

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

6650

6650

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?