1. 概述

1.1 Agent是什么

长期以来,研究者们一直在追求与人类相当、乃至超越人类水平的通用人工智能(Artificial General Intelligence,AGI)。早在 1950 年代,Alan Turing 就将「智能」的概念扩展到了人工实体,并提出了著名的图灵测试。这些人工智能实体通常被称为 —— 代理(Agent)。「代理」这一概念起源于哲学,描述了一种拥有欲望、信念、意图以及采取行动能力的实体。在人工智能领域,这一术语被赋予了一层新的含义:具有自主性、反应性、积极性和社交能力特征的智能实体。

从那时起,代理的设计就成为人工智能社区的焦点。然而,过去的工作主要集中在增强代理的特定能力,如符号推理或对特定任务的掌握(国际象棋、围棋等)。这些研究更加注重算法设计和训练策略,而忽视了模型固有的通用能力的发展,如知识记忆、长期规划、有效泛化和高效互动等。事实证明,增强模型固有能力是推动智能代理进一步发展的关键因素。

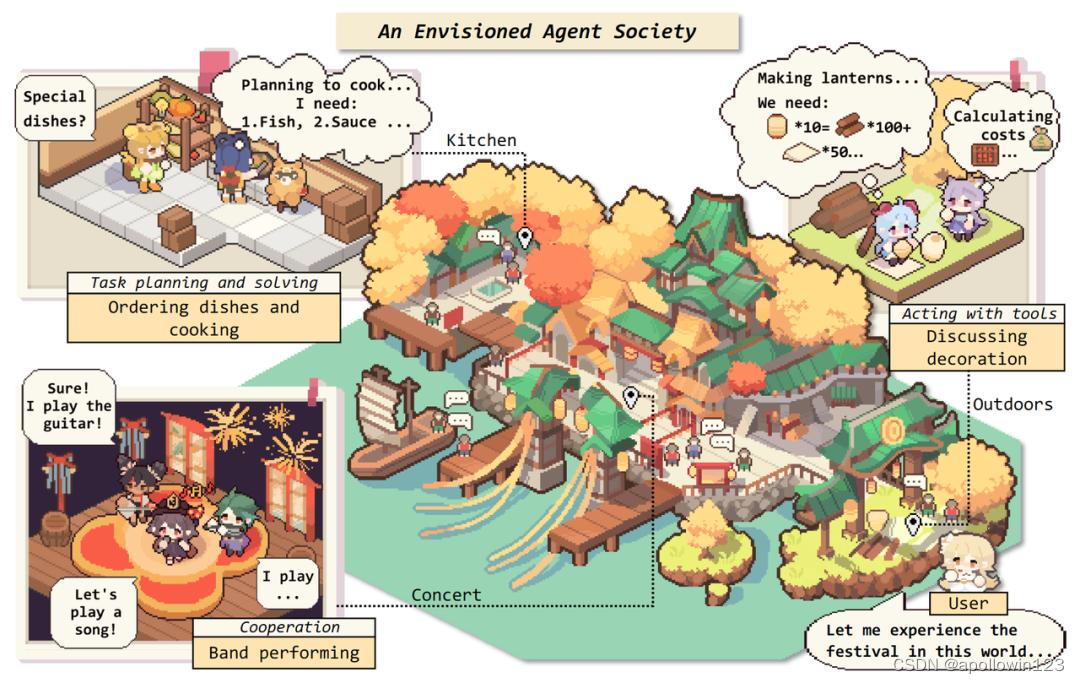

大型语言模型(LLMs)的出现为智能代理的进一步发展带来了希望。如果将 NLP 到 AGI 的发展路线分为五级:语料库、互联网、感知、具身和社会属性,那么目前的大型语言模型已经来到了第二级,具有互联网规模的文本输入和输出。在这个基础上,如果赋予 LLM-based Agents 感知空间和行动空间,它们将达到第三、第四级。进一步地,多个代理通过互动、合作解决更复杂的任务,或者反映出现实世界的社会行为,则有潜力来到第五级 —— 代理社会。

1.2 Lagent 是什么

Lagent 是一个轻量级开源智能体框架,旨在让用户可以高效地构建基于大语言模型的智能体。同时它也提供了一些典型工具以增强大语言模型的能力。

Lagent 目前已经支持了包括 AutoGPT、ReAct 等在内的多个经典智能体范式,也支持了如下工具:

- Arxiv 搜索

- Bing 地图

- Google 学术搜索

- Google 搜索

- 交互式 IPython 解释器

- IPython 解释器

- PPT

- Python 解释器

1.3 AgentLego 是什么

AgentLego 是一个提供了多种开源工具 API 的多模态工具包,旨在像是乐高积木一样,让用户可以快速简便地拓展自定义工具,从而组装出自己的智能体。通过 AgentLego 算法库,不仅可以直接使用多种工具,也可以利用这些工具,在相关智能体框架(如 Lagent,Transformers Agent 等)的帮助下,快速构建可以增强大语言模型能力的智能体。

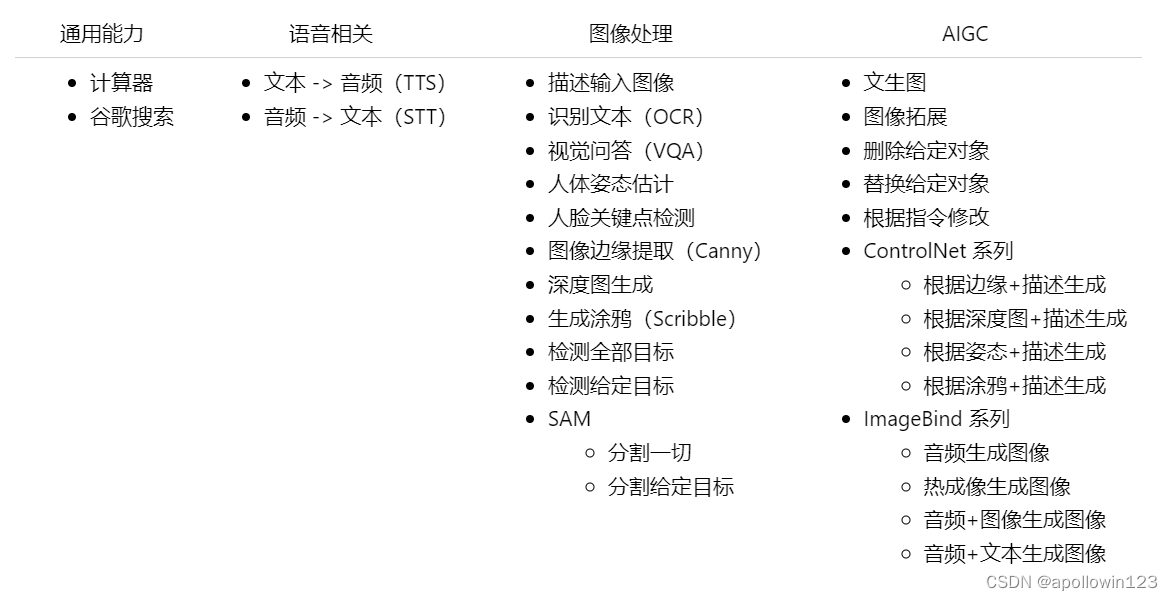

AgentLego 目前提供了如下工具:

1.4 两者的关系

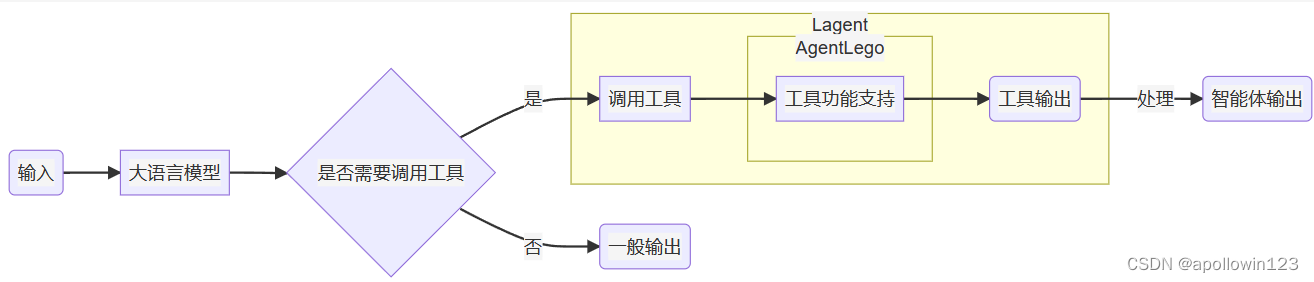

经过上面的介绍,我们可以发现,Lagent 是一个智能体框架,而 AgentLego 与大模型智能体并不直接相关,而是作为工具包,在相关智能体的功能支持模块发挥作用。

两者之间的关系可以用下图来表示:

1.5 环境配置

1.5.1 创建开发机和 conda 环境

进入开发机后,为了方便使用,我们需要配置一个环境以同时满足 Lagent 和 AgentLego 运行时所需依赖。在开始配置环境前,我们先创建一个用于存放 Agent 相关文件的目录,可以执行如下命令:

mkdir -p /root/agent 接下来,我们开始配置 conda 环境,可以输入如下指令:

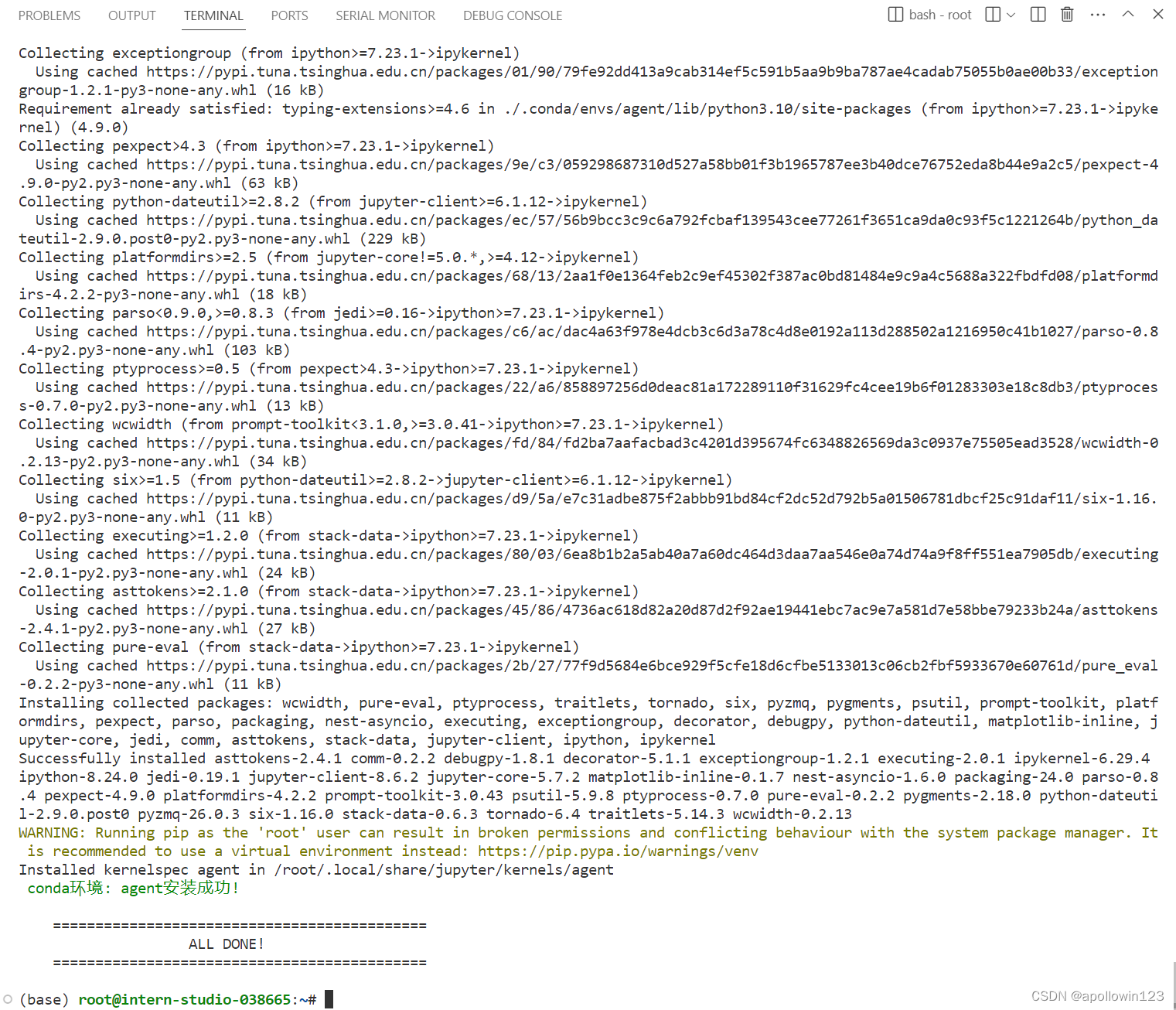

studio-conda -t agent -o pytorch-2.1.2 显示下图就是初始化环境成功了。

1.5.2 安装 Lagent 和 AgentLego

Lagent 和 AgentLego 都提供了两种安装方法,一种是通过 pip 直接进行安装,另一种则是从源码进行安装。为了方便使用 Lagent 的 Web Demo 以及 AgentLego 的 WebUI,我们选择直接从源码进行安装。 此处附上源码安装的相关帮助文档:

- Lagent:安装方式 — Lagent

- AgentLego:安装 — AgentLego 0.2.0 文档

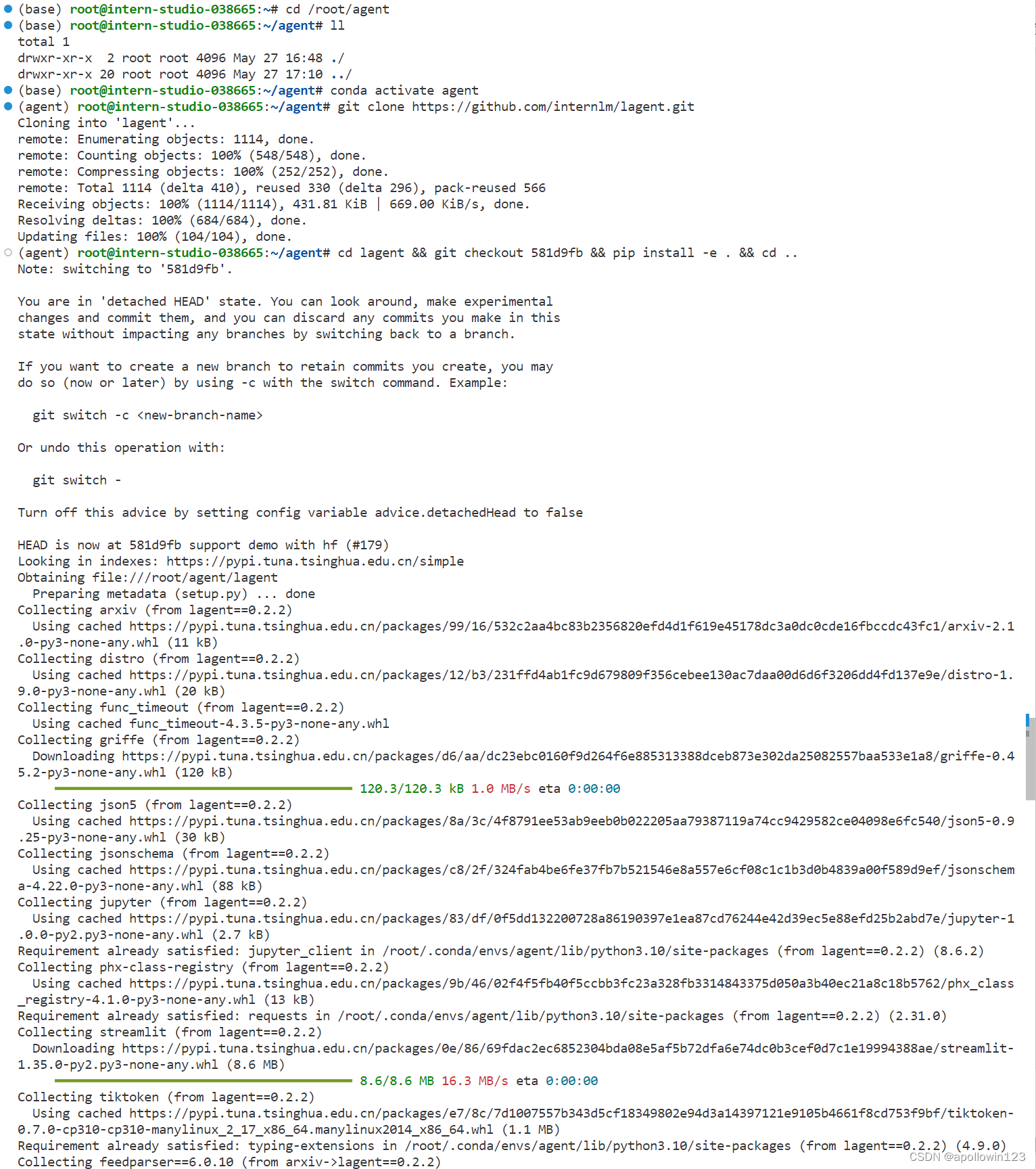

可以执行如下命令进行安装:

安装Lagent

cd /root/agent conda activate agent

git clone https://gitee.com/internlm/lagent.git

cd lagent && git checkout 581d9fb && pip install -e . && cd ..

安装过程:

安装成功后显示如下结果:

Successfully installed altair-5.3.0 anyio-4.4.0 argon2-cffi-23.1.0 argon2-cffi-bindings-21.2.0 arrow-1.3.0 arxiv-2.1.0 async-lru-2.0.4 attrs-23.2.0 babel-2.15.0 beautifulsoup4-4.12.3 bleach-6.1.0 blinker-1.8.2 cachetools-5.3.3 cffi-1.16.0 click-8.1.7 colorama-0.4.6 defusedxml-0.7.1 distro-1.9.0 fastjsonschema-2.19.1 feedparser-6.0.10 fqdn-1.5.1 func_timeout-4.3.5 gitdb-4.0.11 gitpython-3.1.43 griffe-0.45.2 h11-0.14.0 httpcore-1.0.5 httpx-0.27.0 ipywidgets-8.1.2 isoduration-20.11.0 json5-0.9.25 jsonpointer-2.4 jsonschema-4.22.0 jsonschema-specifications-2023.12.1 jupyter-1.0.0 jupyter-console-6.6.3 jupyter-events-0.10.0 jupyter-lsp-2.2.5 jupyter-server-2.14.0 jupyter-server-terminals-0.5.3 jupyterlab-4.2.1 jupyterlab-pygments-0.3.0 jupyterlab-server-2.27.2 jupyterlab-widgets-3.0.10 lagent-0.2.2 markdown-it-py-3.0.0 mdurl-0.1.2 mistune-3.0.2 nbclient-0.10.0 nbconvert-7.16.4 nbformat-5.10.4 notebook-7.2.0 notebook-shim-0.2.4 overrides-7.7.0 pandas-2.2.2 pandocfilters-1.5.1 phx-class-registry-4.1.0 prometheus-client-0.20.0 protobuf-4.25.3 pyarrow-16.1.0 pycparser-2.22 pydeck-0.9.1 python-json-logger-2.0.7 pytz-2024.1 qtconsole-5.5.2 qtpy-2.4.1 referencing-0.35.1 regex-2024.5.15 rfc3339-validator-0.1.4 rfc3986-validator-0.1.1 rich-13.7.1 rpds-py-0.18.1 send2trash-1.8.3 sgmllib3k-1.0.0 smmap-5.0.1 sniffio-1.3.1 soupsieve-2.5 streamlit-1.35.0 tenacity-8.3.0 terminado-0.18.1 tiktoken-0.7.0 tinycss2-1.3.0 toml-0.10.2 tomli-2.0.1 toolz-0.12.1 types-python-dateutil-2.9.0.20240316 tzdata-2024.1 uri-template-1.3.0 watchdog-4.0.1 webcolors-1.13 webencodings-0.5.1 websocket-client-1.8.0 widgetsnbextension-4.0.10

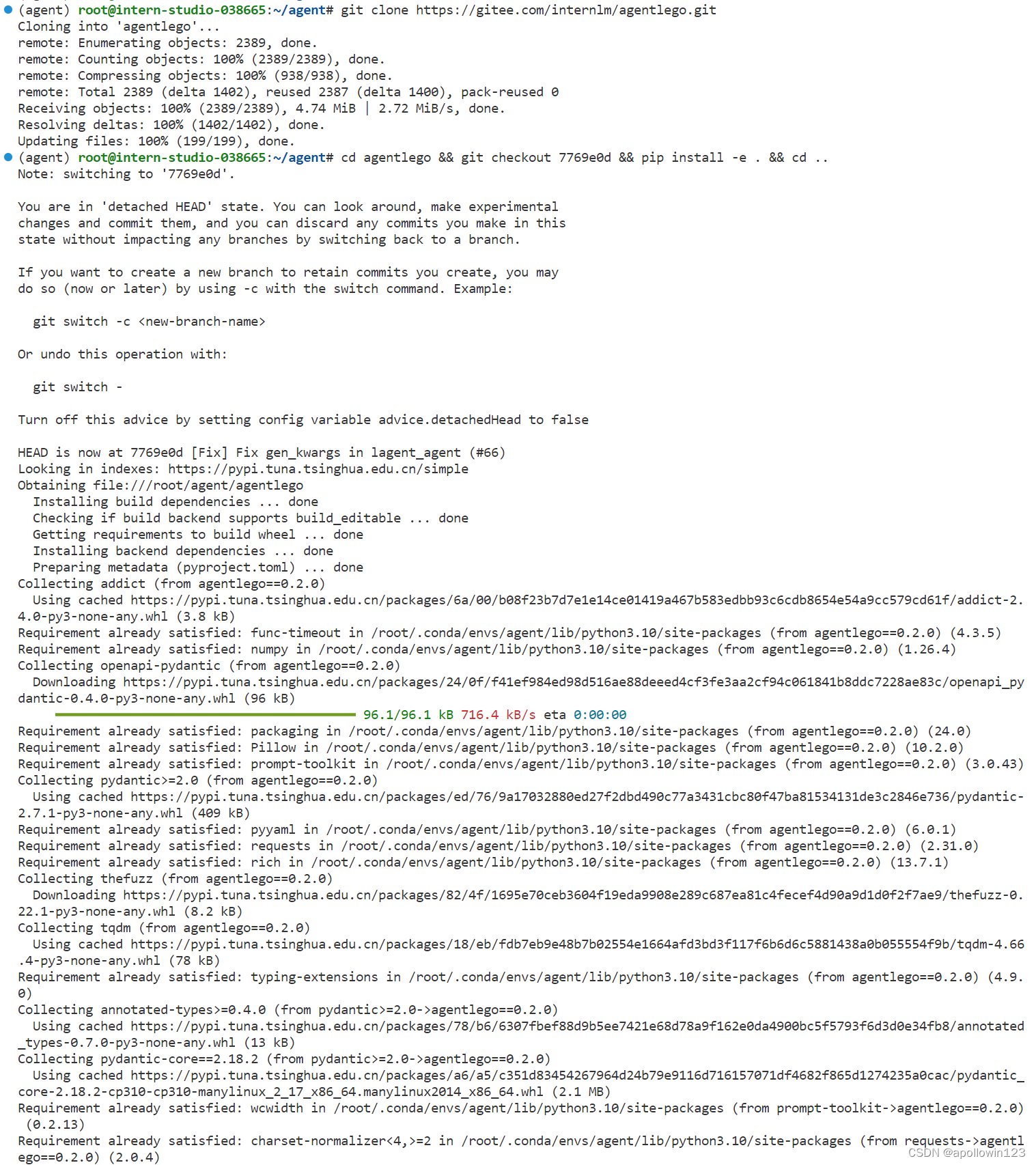

安装agentlego

git clone https://gitee.com/internlm/agentlego.git

cd agentlego && git checkout 7769e0d && pip install -e . && cd ..

安装过程如下:

安装成功后显示如下结果:

Successfully installed addict-2.4.0 agentlego-0.2.0 annotated-types-0.7.0 openapi-pydantic-0.4.0 pydantic-2.7.1 pydantic-core-2.18.2 rapidfuzz-3.9.1 thefuzz-0.22.1 tqdm-4.66.4

1.5.3 安装其他依赖

在这一步中,我们将会安装其他将要用到的依赖库,如 LMDeploy,可以执行如下命令:

命令:

onda activate agent

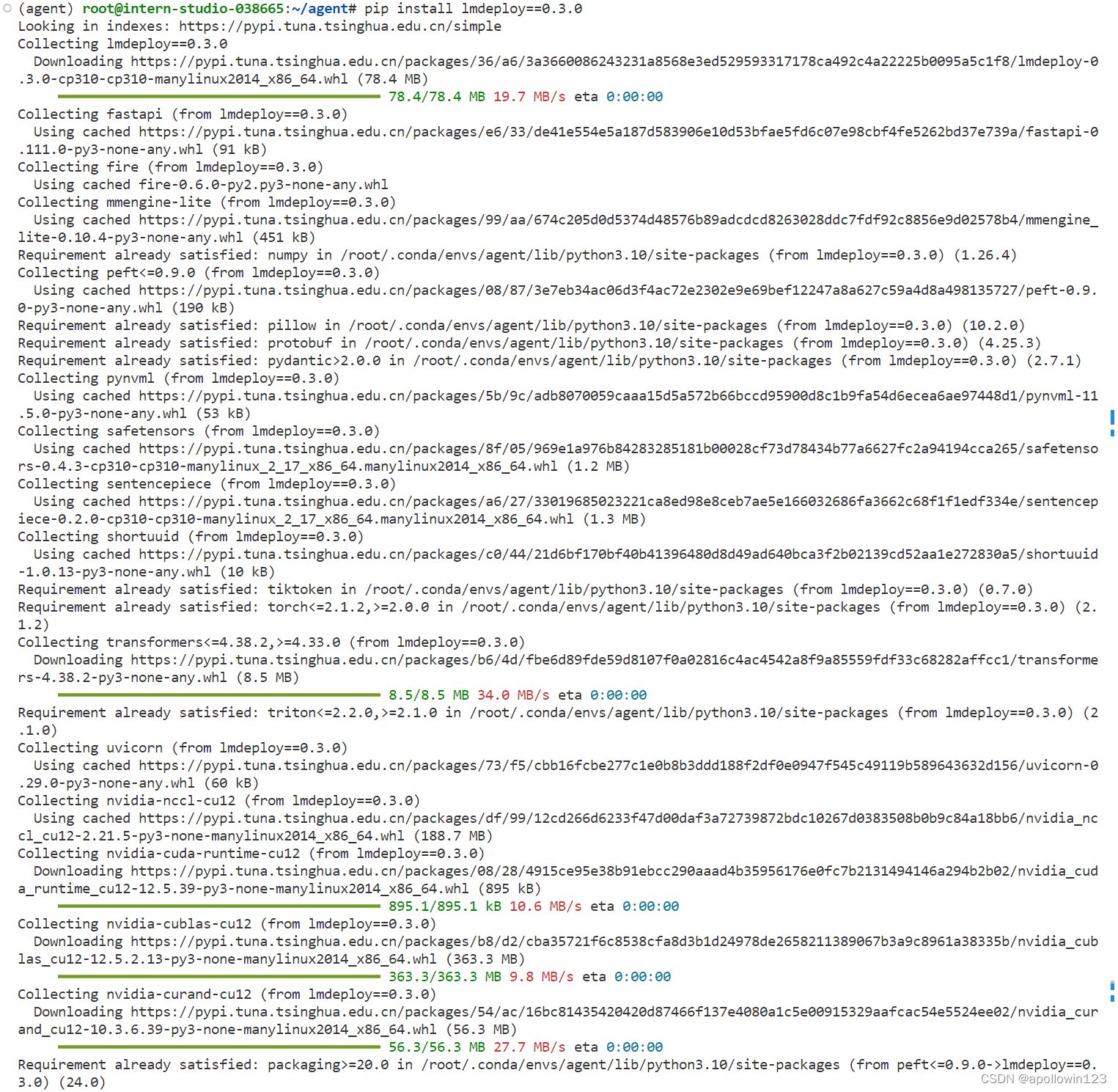

pip install lmdeploy==0.3.0 安装过程如下:

安装成功显示如下结果:

Installing collected packages: sentencepiece, zipp, websockets, uvloop, uvicorn, ujson, termcolor, shortuuid, shellingham, safetensors, python-multipart, python-dotenv, pynvml, orjson, nvidia-nccl-cu12, nvidia-curand-cu12, nvidia-cuda-runtime-cu12, nvidia-cublas-cu12, httptools, fsspec, dnspython, watchfiles, starlette, importlib-metadata, huggingface-hub, fire, email_validator, yapf, typer, tokenizers, accelerate, transformers, mmengine-lite, fastapi-cli, peft, fastapi, lmdeploy

Successfully installed accelerate-0.30.1 dnspython-2.6.1 email_validator-2.1.1 fastapi-0.111.0 fastapi-cli-0.0.4 fire-0.6.0 fsspec-2024.5.0 httptools-0.6.1 huggingface-hub-0.23.2 importlib-metadata-7.1.0 lmdeploy-0.3.0 mmengine-lite-0.10.4 nvidia-cublas-cu12-12.5.2.13 nvidia-cuda-runtime-cu12-12.5.39 nvidia-curand-cu12-10.3.6.39 nvidia-nccl-cu12-2.21.5 orjson-3.10.3 peft-0.9.0 pynvml-11.5.0 python-dotenv-1.0.1 python-multipart-0.0.9 safetensors-0.4.3 sentencepiece-0.2.0 shellingham-1.5.4 shortuuid-1.0.13 starlette-0.37.2 termcolor-2.4.0 tokenizers-0.15.2 transformers-4.38.2 typer-0.12.3 ujson-5.10.0 uvicorn-0.29.0 uvloop-0.19.0 watchfiles-0.21.0 websockets-12.0 yapf-0.40.2 zipp-3.19.0

1.4.4 准备 Tutorial

由于后续的 Demo 需要用到 tutorial 已经写好的脚本,因此我们需要将 tutorial 通过 git clone 的方法准备好,以备后续使用:

cd /root/agent git clone -b camp2 https://gitee.com/internlm/Tutorial.git2. Lagent:轻量级智能体框架

在这一部分中,我们将带大家体验 Lagent 的 Web Demo,使用 Lagent 自定义工具,并体验自定义工具的效果。

详细文档可以访问:Lagent:轻量级智能体框架。

1. Lagent Web Demo

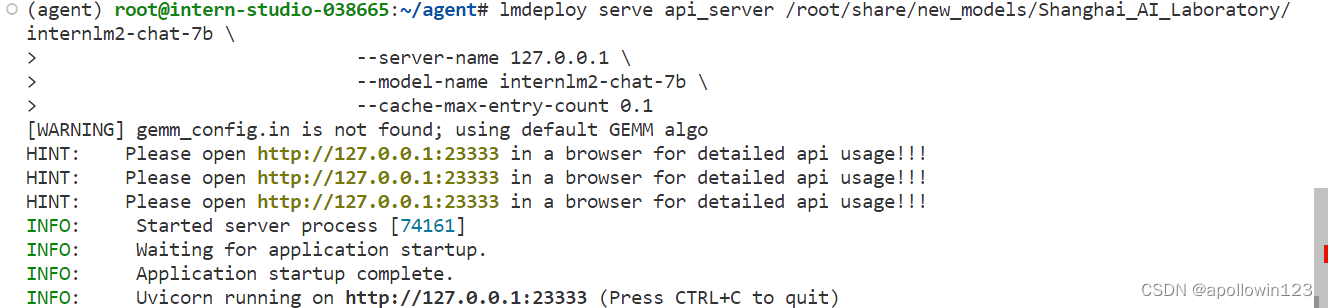

1.1 使用 LMDeploy 部署

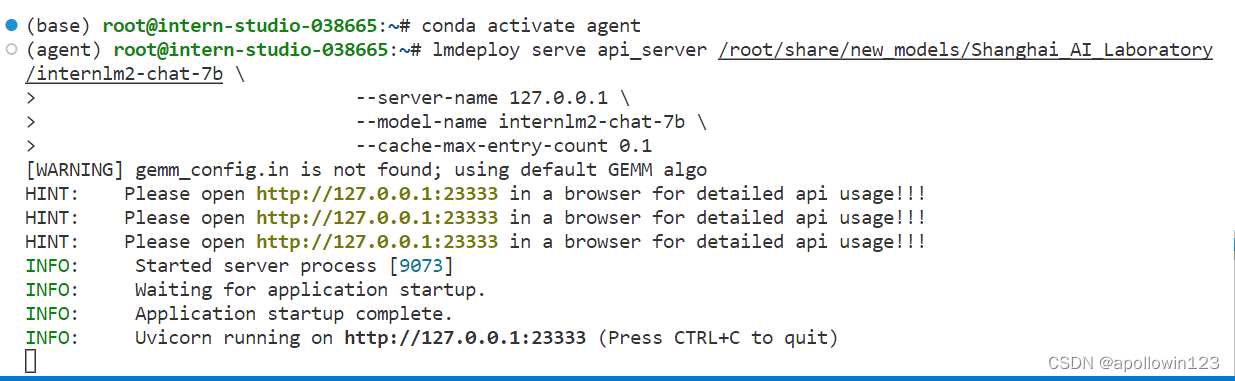

由于 Lagent 的 Web Demo 需要用到 LMDeploy 所启动的 api_server,因此我们首先按照下图指示在 vscode terminal 中执行如下代码使用 LMDeploy 启动一个 api_server。

conda activate agent

lmdeploy serve api_server /root/share/new_models/Shanghai_AI_Laboratory/internlm2-chat-7b \ --server-name 127.0.0.1 \ --model-name internlm2-chat-7b \ --cache-max-entry-count 0.1

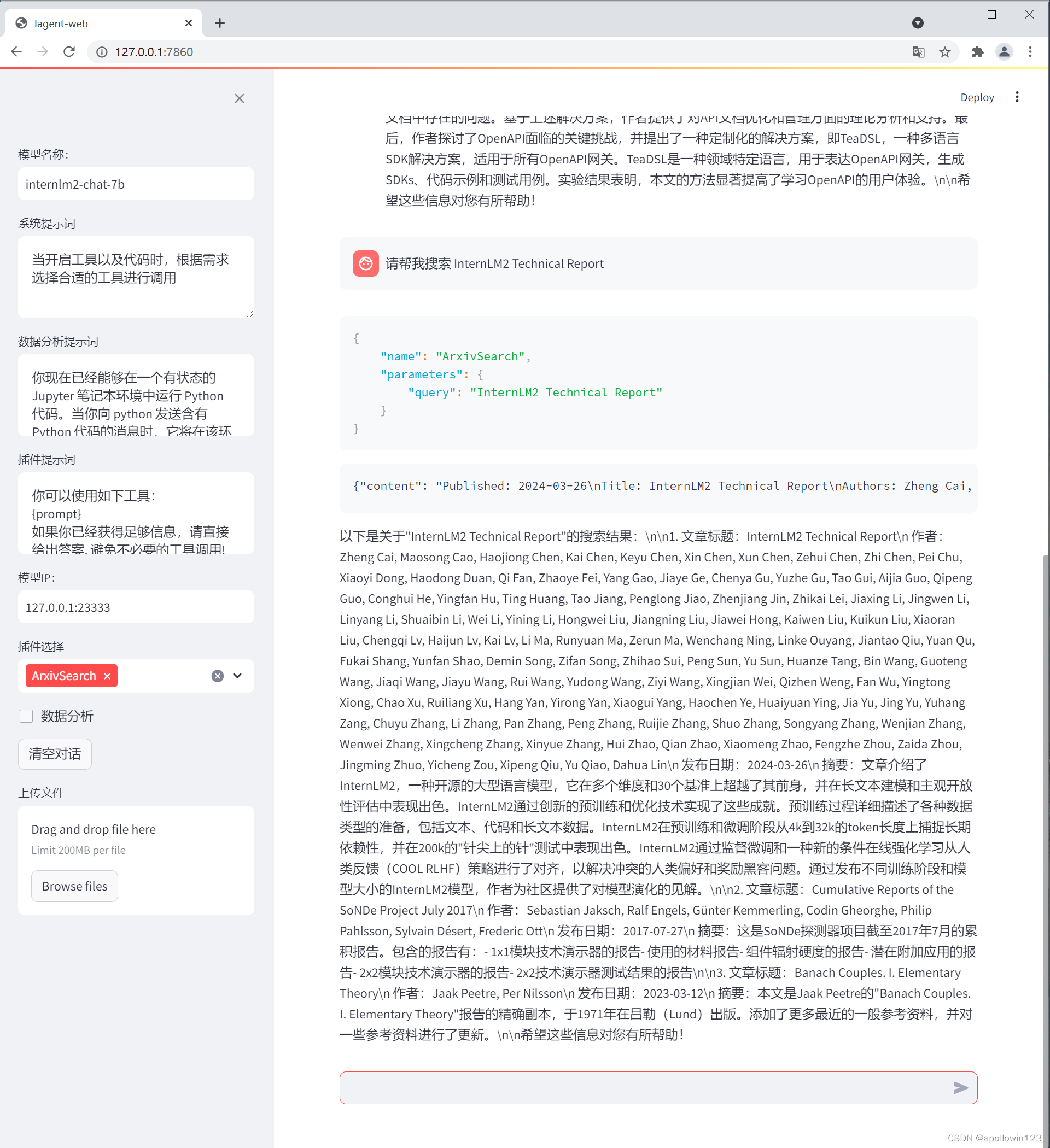

1.2 启动并使用 Lagent Web Demo

接下来我们按照下图指示新建一个 terminal 以启动 Lagent Web Demo。在新建的 terminal 中执行如下指令:

conda activate agent

cd /root/agent/lagent/examples

streamlit run internlm2_agent_web_demo.py --server.address 127.0.0.1 --server.port 7860我们输入“请帮我搜索 InternLM2 Technical Report” 以让模型搜索书生·浦语2的技术报告。效果如下图所示,可以看到模型正确输出了 InternLM2 技术报告的相关信息。尽管还输出了其他论文,但这是由 arxiv 搜索 API 的相关行为导致的。

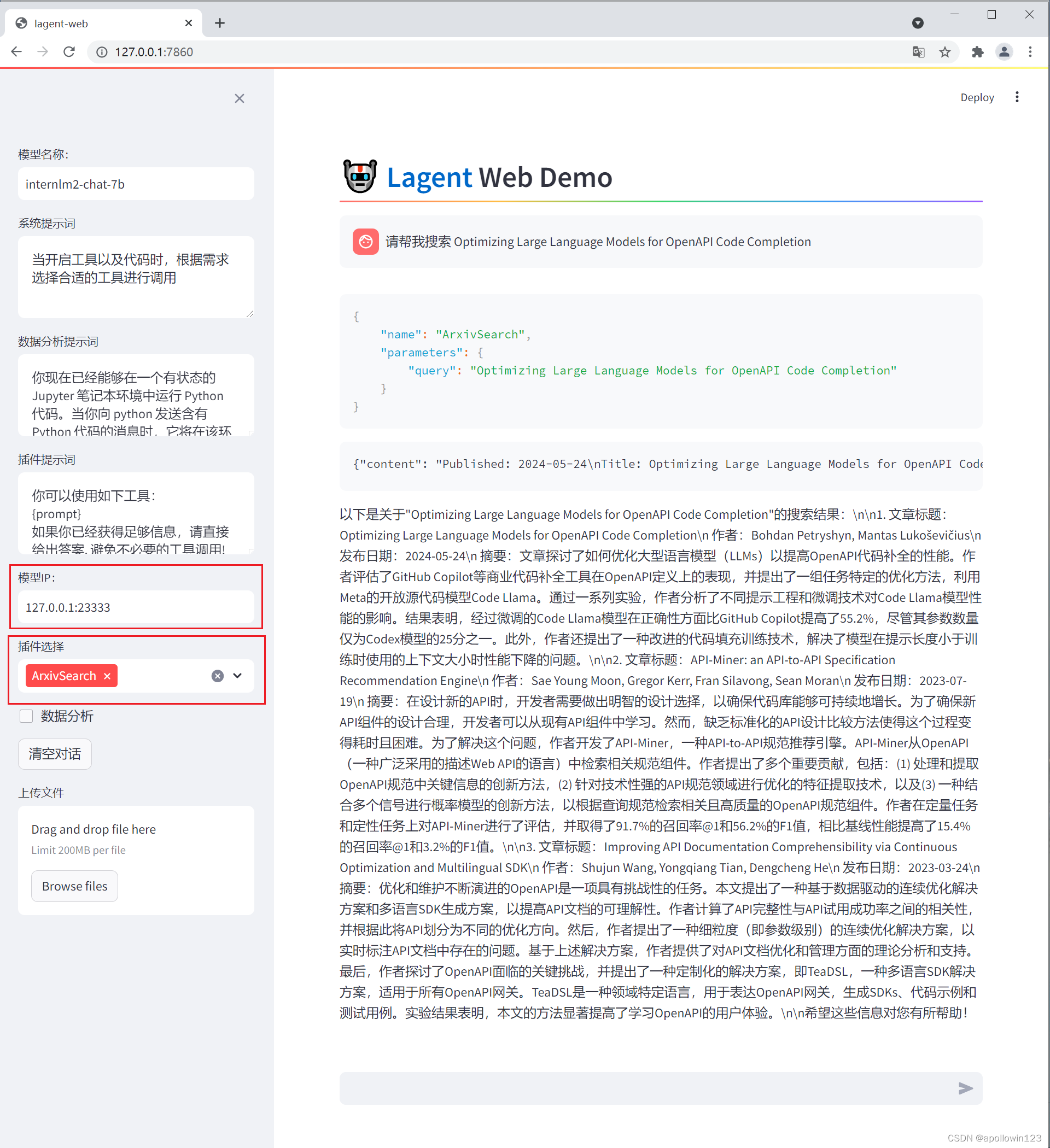

也可以换一个主题让Agent搜索,比如“请帮我搜索 Optimizing Large Language Models for OpenAPI Code Completion”,效果如下:

2. 用 Lagent 自定义工具

在本节中,我们将基于 Lagent 自定义一个工具。Lagent 中关于工具部分的介绍文档位于 动作 — Lagent 。使用 Lagent 自定义工具主要分为以下几步:

- 继承 BaseAction 类

- 实现简单工具的 run 方法;或者实现工具包内每个子工具的功能

- 简单工具的 run 方法可选被 tool_api 装饰;工具包内每个子工具的功能都需要被 tool_api 装饰

下面我们将实现一个调用和风天气 API 的工具以完成实时天气查询的功能。

2.1 创建工具文件

首先通过 touch /root/agent/lagent/lagent/actions/weather.py(大小写敏感)新建工具文件,该文件内容如下:

import json

import os

import requests

from typing import Optional, Type

from lagent.actions.base_action import BaseAction, tool_api

from lagent.actions.parser import BaseParser, JsonParser

from lagent.schema import ActionReturn, ActionStatusCode

class WeatherQuery(BaseAction):

"""Weather plugin for querying weather information."""

def __init__(self,

key: Optional[str] = None,

description: Optional[dict] = None,

parser: Type[BaseParser] = JsonParser,

enable: bool = True) -> None:

super().__init__(description, parser, enable)

key = os.environ.get('WEATHER_API_KEY', key)

if key is None:

raise ValueError(

'Please set Weather API key either in the environment '

'as WEATHER_API_KEY or pass it as `key`')

self.key = key

self.location_query_url = 'https://geoapi.qweather.com/v2/city/lookup'

self.weather_query_url = 'https://devapi.qweather.com/v7/weather/now'

@tool_api

def run(self, query: str) -> ActionReturn:

"""一个天气查询API。可以根据城市名查询天气信息。

Args:

query (:class:`str`): The city name to query.

"""

tool_return = ActionReturn(type=self.name)

status_code, response = self._search(query)

if status_code == -1:

tool_return.errmsg = response

tool_return.state = ActionStatusCode.HTTP_ERROR

elif status_code == 200:

parsed_res = self._parse_results(response)

tool_return.result = [dict(type='text', content=str(parsed_res))]

tool_return.state = ActionStatusCode.SUCCESS

else:

tool_return.errmsg = str(status_code)

tool_return.state = ActionStatusCode.API_ERROR

return tool_return

def _parse_results(self, results: dict) -> str:

"""Parse the weather results from QWeather API.

Args:

results (dict): The weather content from QWeather API

in json format.

Returns:

str: The parsed weather results.

"""

now = results['now']

data = [

f'数据观测时间: {now["obsTime"]}',

f'温度: {now["temp"]}°C',

f'体感温度: {now["feelsLike"]}°C',

f'天气: {now["text"]}',

f'风向: {now["windDir"]},角度为 {now["wind360"]}°',

f'风力等级: {now["windScale"]},风速为 {now["windSpeed"]} km/h',

f'相对湿度: {now["humidity"]}',

f'当前小时累计降水量: {now["precip"]} mm',

f'大气压强: {now["pressure"]} 百帕',

f'能见度: {now["vis"]} km',

]

return '\n'.join(data)

def _search(self, query: str):

# get city_code

try:

city_code_response = requests.get(

self.location_query_url,

params={'key': self.key, 'location': query}

)

except Exception as e:

return -1, str(e)

if city_code_response.status_code != 200:

return city_code_response.status_code, city_code_response.json()

city_code_response = city_code_response.json()

if len(city_code_response['location']) == 0:

return -1, '未查询到城市'

city_code = city_code_response['location'][0]['id']

# get weather

try:

weather_response = requests.get(

self.weather_query_url,

params={'key': self.key, 'location': city_code}

)

except Exception as e:

return -1, str(e)

return weather_response.status_code, weather_response.json()2.2 获取 API KEY

为了获得稳定的天气查询服务,我们首先要获取 API KEY。首先打开 开发文档 | 和风天气开发服务 后,点击右上角控制台。(如下图所示)

2.3 体验自定义工具效果

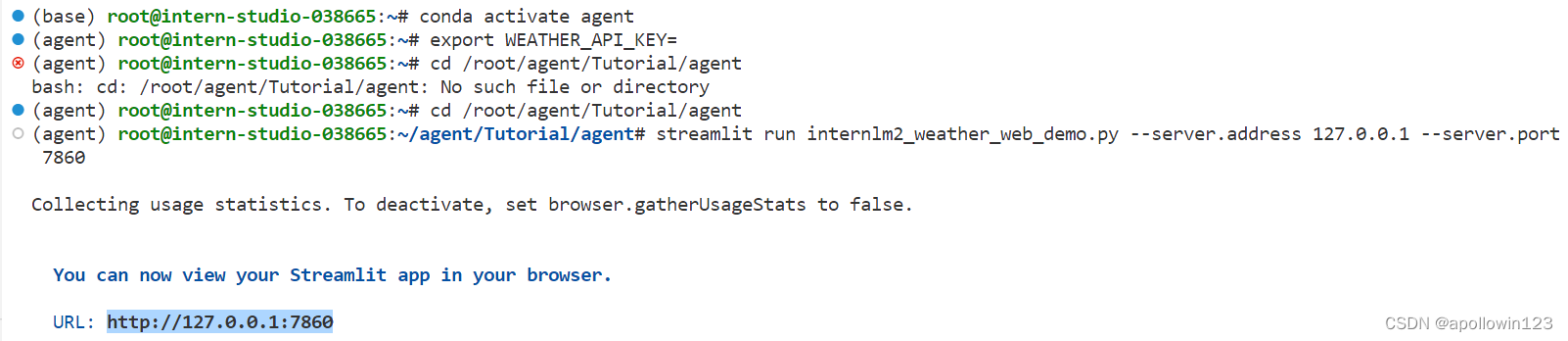

与 1.2 部分类似,我们在两个 terminal 中分别启动 LMDeploy 服务和 Tutorial 已经写好的用于这部分的 Web Demo:

在 vscode terminal 中执行如下代码使用 LMDeploy 启动一个 api_server。

conda activate agent

lmdeploy serve api_server /root/share/new_models/Shanghai_AI_Laboratory/internlm2-chat-7b \ --server-name 127.0.0.1 \ --model-name internlm2-chat-7b \ --cache-max-entry-count 0.1 在 vscode terminal 中执行如下代码启动 lagent。

export WEATHER_API_KEY=在2.2节获取的API KEY

# 比如 export WEATHER_API_KEY=1234567890abcdef

conda activate agent

cd /root/agent/Tutorial/agent

streamlit run internlm2_weather_web_demo.py --server.address 127.0.0.1 --server.port 7860

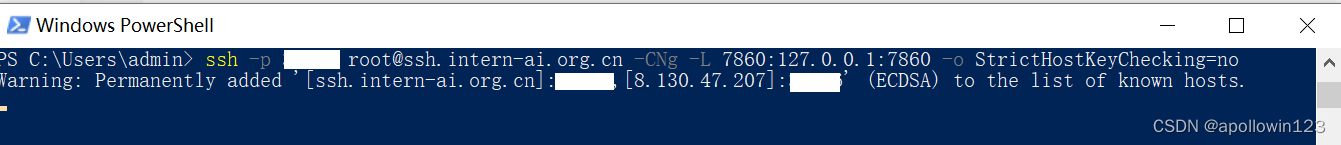

在powershell中进行端口映射

ssh -p <开发机端口> root@ssh.intern-ai.org.cn -CNg -L 7860:127.0.0.1:7860 -o StrictHostKeyChecking=no

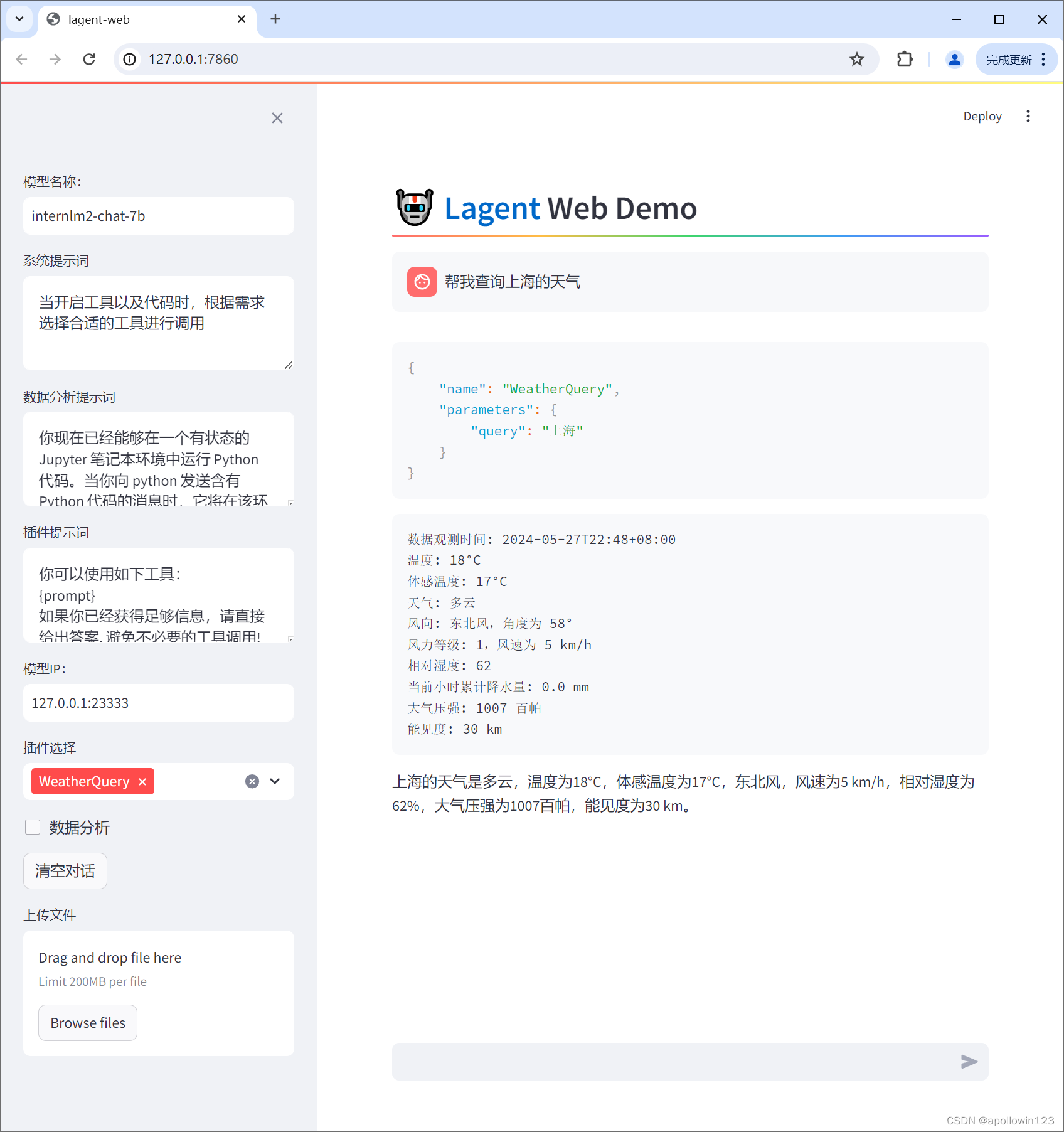

浏览器打开http://127.0.0.1:7860,修改IP为127.0.0.1:23333,插件选择WeatherQuery,等待模型加载完成,就可以使用llm调用工具进行天气查询了,如下所示:

3. AgentLego:组装智能体“乐高”

在这一部分中,我们将带大家直接使用 AgentLego 工具,体验 AgentLego 的 WebUI,以及基于 AgentLego 自定义工具并体验自定义工具的效果。

1. 直接使用 AgentLego

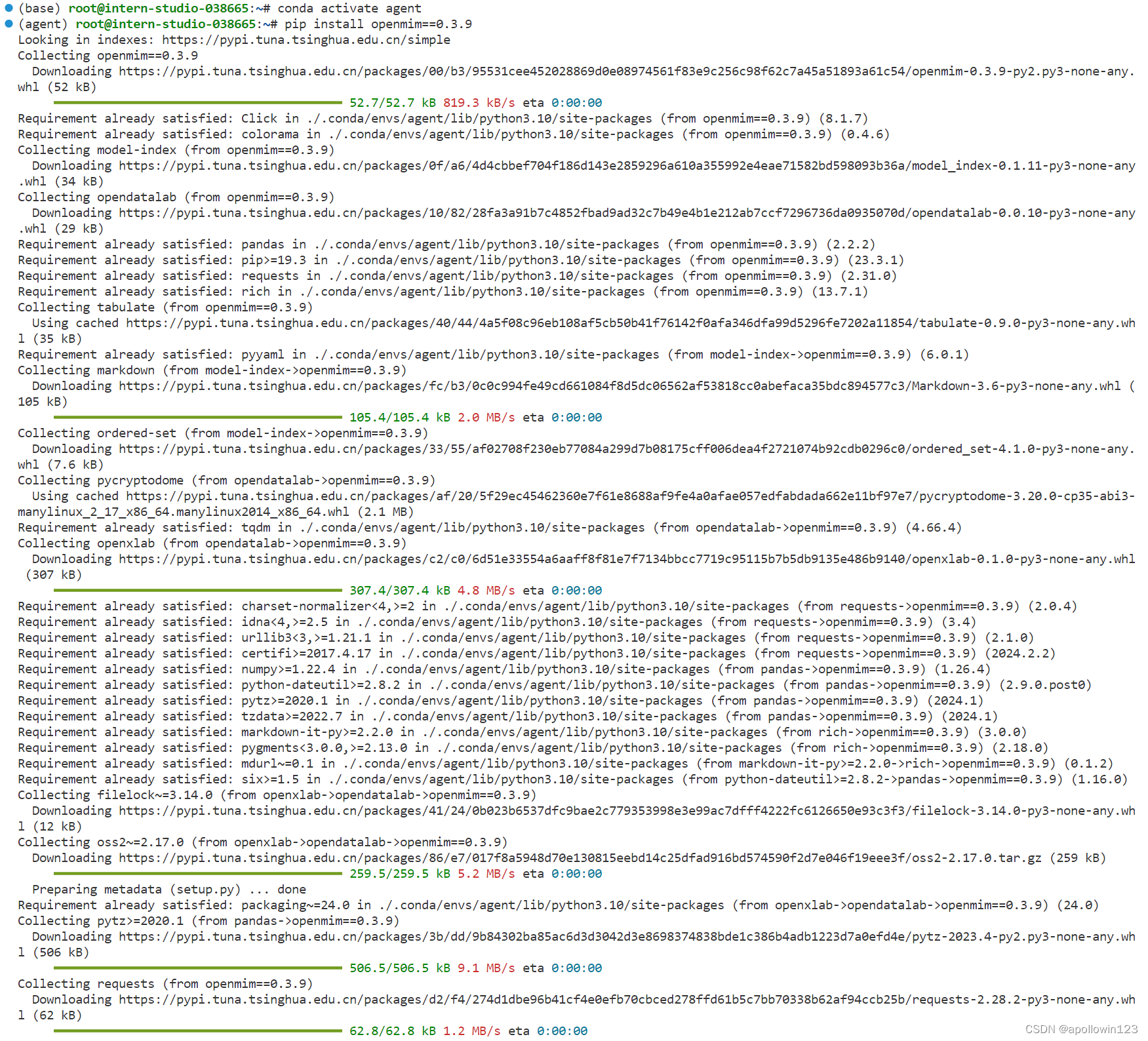

1.1安装 mmdet (MMDetection) 算法库

首先下载 demo 文件:

cd /root/agent

wget http://download.openmmlab.com/agentlego/road.jpg 由于 AgentLego 在安装时并不会安装某个特定工具的依赖,因此我们接下来准备安装目标检测工具运行时所需依赖。

AgentLego 所实现的目标检测工具是基于 mmdet (MMDetection) 算法库中的 RTMDet-Large 模型,因此我们首先安装 mim,然后通过 mim 工具来安装 mmdet。这一步所需时间可能会较长,请耐心等待。

conda activate agent

pip install openmim==0.3.9

安装完成后提示如下

Successfully installed aliyun-python-sdk-core-2.15.1 aliyun-python-sdk-kms-2.16.3 crcmod-1.7 cryptography-42.0.7 filelock-3.14.0 jmespath-0.10.0 markdown-3.6 model-index-0.1.11 opendatalab-0.0.10 openmim-0.3.9 openxlab-0.1.0 ordered-set-4.1.0 oss2-2.17.0 pycryptodome-3.20.0 pytz-2023.4 requests-2.28.2 rich-13.4.2 setuptools-60.2.0 tabulate-0.9.0 tqdm-4.65.2 urllib3-1.26.18

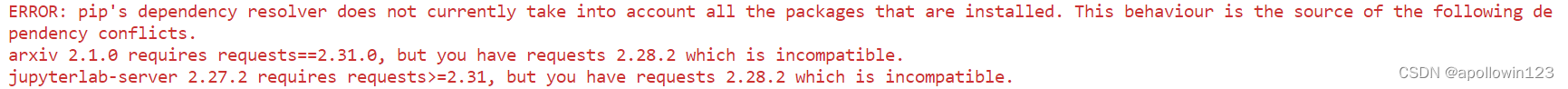

在安装完成后,可能会观察到以下现象(如下图所示),但请放心,这是正常现象,这并不会影响到我们的使用。

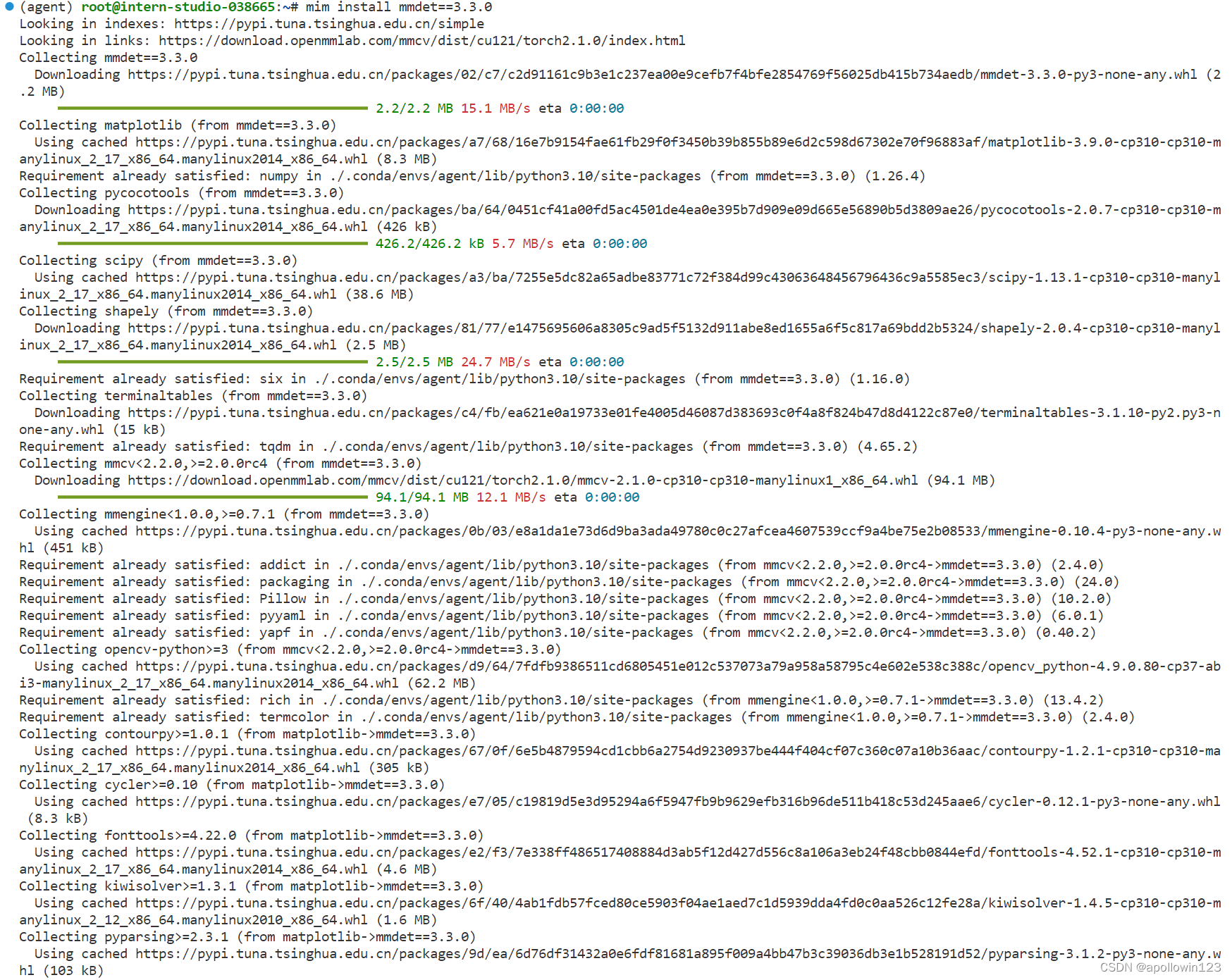

安装 mmdet (MMDetection) 算法库

mim install mmdet==3.3.0

安装过程如下:

安装成功提示如下:

Installing collected packages: terminaltables, shapely, scipy, pyparsing, opencv-python, kiwisolver, fonttools, cycler, contourpy, matplotlib, pycocotools, mmengine, mmcv, mmdet

Successfully installed contourpy-1.2.1 cycler-0.12.1 fonttools-4.52.1 kiwisolver-1.4.5 matplotlib-3.9.0 mmcv-2.1.0 mmdet-3.3.0 mmengine-0.10.4 opencv-python-4.9.0.80 pycocotools-2.0.7 pyparsing-3.1.2 scipy-1.13.1 shapely-2.0.4 terminaltables-3.1.10

1.2直接使用 AgentLego 调用mmdet (MMDetection) 算法库

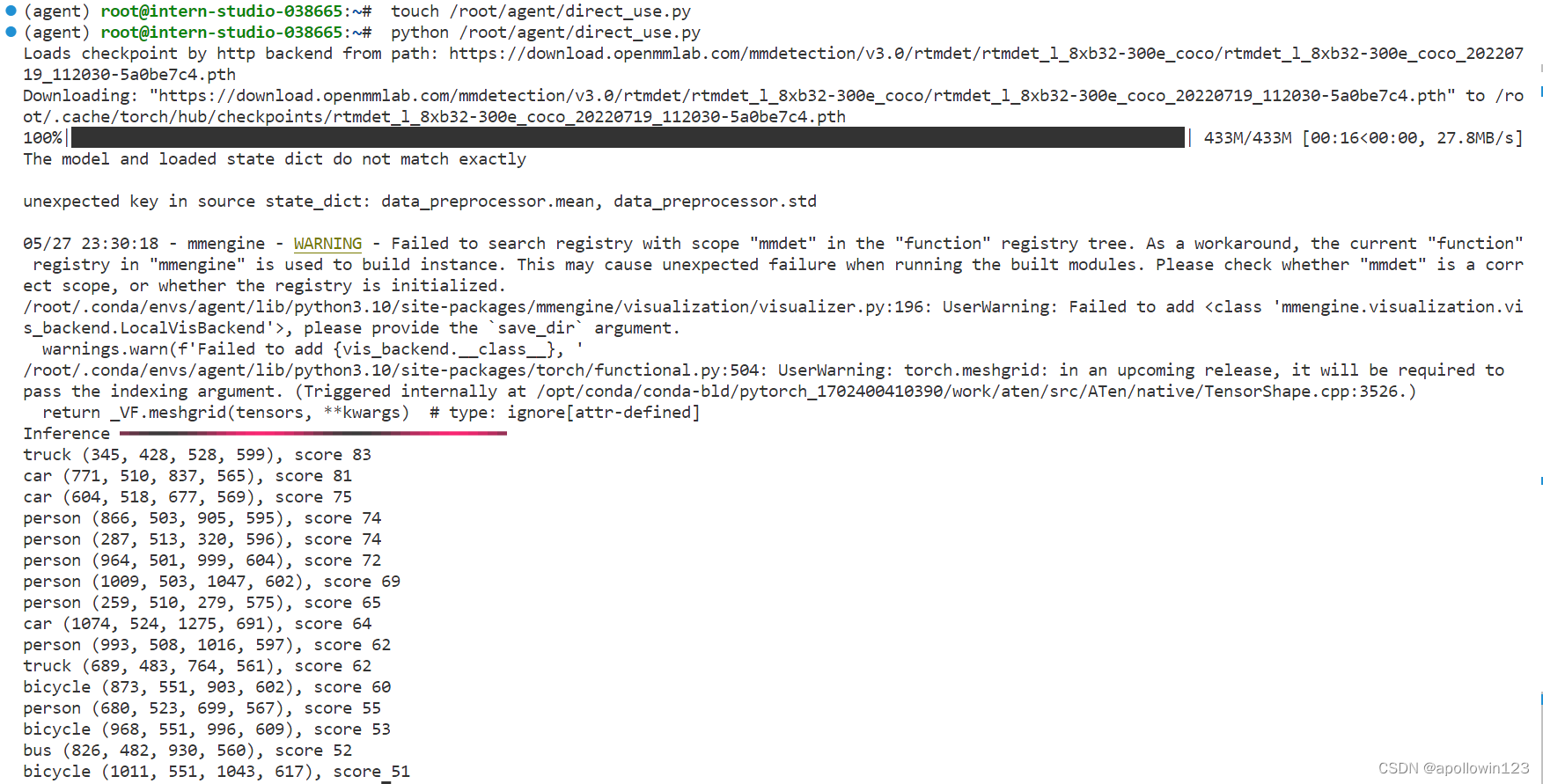

通过 touch /root/agent/direct_use.py(大小写敏感)的方式在 /root/agent 目录下新建 direct_use.py 以直接使用目标检测工具,direct_use.py 的代码如下:

import re

import cv2

from agentlego.apis import load_tool

# load tool

tool = load_tool('ObjectDetection', device='cuda')

# apply tool

visualization = tool('/root/agent/road.jpg')

print(visualization)

# visualize

image = cv2.imread('/root/agent/road.jpg')

preds = visualization.split('\n')

pattern = r'(\w+) \((\d+), (\d+), (\d+), (\d+)\), score (\d+)'

for pred in preds:

name, x1, y1, x2, y2, score = re.match(pattern, pred).groups()

x1, y1, x2, y2, score = int(x1), int(y1), int(x2), int(y2), int(score)

cv2.rectangle(image, (x1, y1), (x2, y2), (0, 255, 0), 1)

cv2.putText(image, f'{name} {score}', (x1, y1), cv2.FONT_HERSHEY_SIMPLEX, 0.8, (0, 255, 0), 1)

cv2.imwrite('/root/agent/road_detection_direct.jpg', image)运行结果如下:

查看检测标注的图片如下:

2 作为智能体工具使用

2.1 修改相关文件

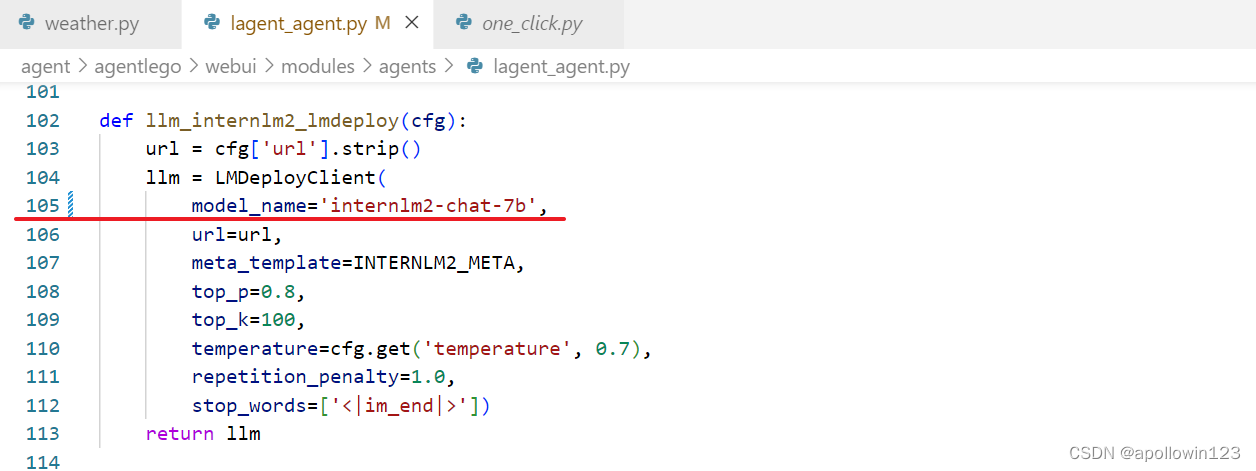

由于 AgentLego 算法库默认使用 InternLM2-Chat-20B 模型,因此我们首先需要修改 /root/agent/agentlego/webui/modules/agents/lagent_agent.py 文件的第 105行位置,将 internlm2-chat-20b 修改为 internlm2-chat-7b,即

2.2 使用 LMDeploy 部署

由于 AgentLego 的 WebUI 需要用到 LMDeploy 所启动的 api_server,因此我们首先按照下图指示在 vscode terminal 中执行如下代码使用 LMDeploy 启动一个 api_server。

conda activate agent lmdeploy serve api_server /root/share/new_models/Shanghai_AI_Laboratory/internlm2-chat-7b \ --server-name 127.0.0.1 \ --model-name internlm2-chat-7b \ --cache-max-entry-count 0.1

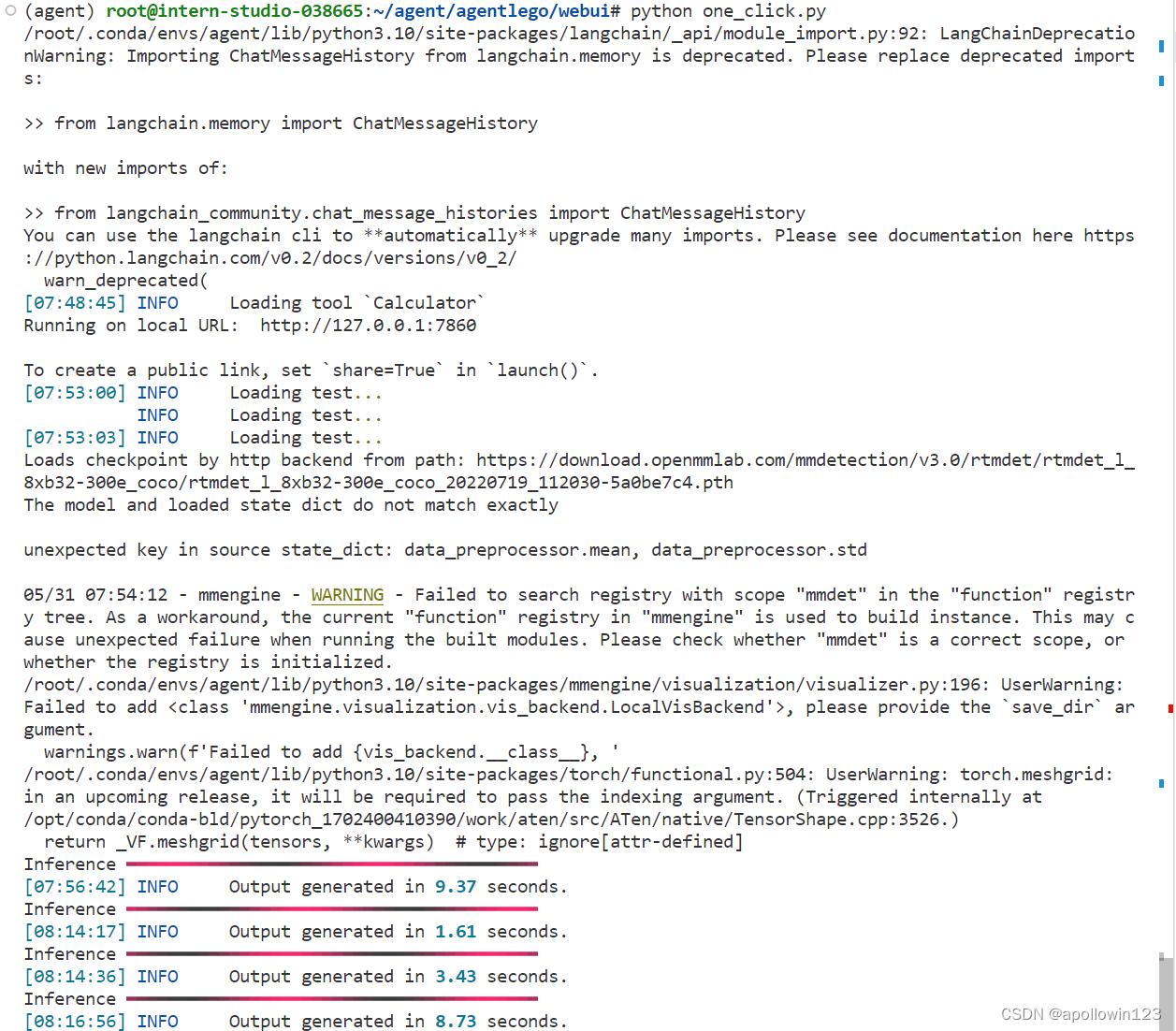

2.3 启动 AgentLego WebUI

接下来我们按照下图指示新建一个 terminal 以启动 AgentLego WebUI。在新建的 terminal 中执行如下指令:

conda activate agent

cd /root/agent/agentlego/webui

python one_click.py运行结果如下,第一次运行会自动安装一些python库,速度慢一些

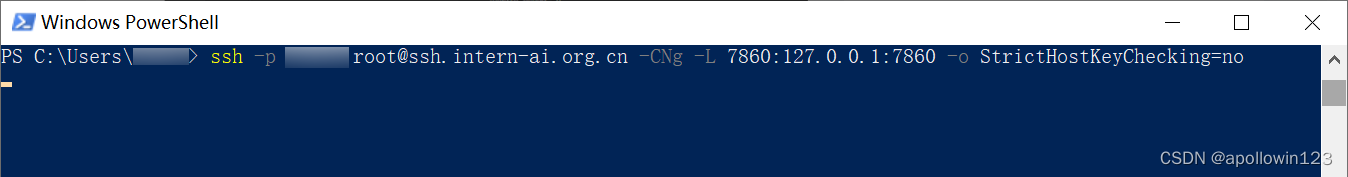

在等待 LMDeploy 的 api_server 与 AgentLego WebUI 完全启动后(如下图所示),在本地进行端口映射,将 LMDeploy api_server 的23333端口以及 AgentLego WebUI 的7860端口映射到本地。可以执行:

ssh -p 35316 root@ssh.intern-ai.org.cn -CNg -L 7860:127.0.0.1:7860 -o StrictHostKeyChecking=no

端口映射如下图:

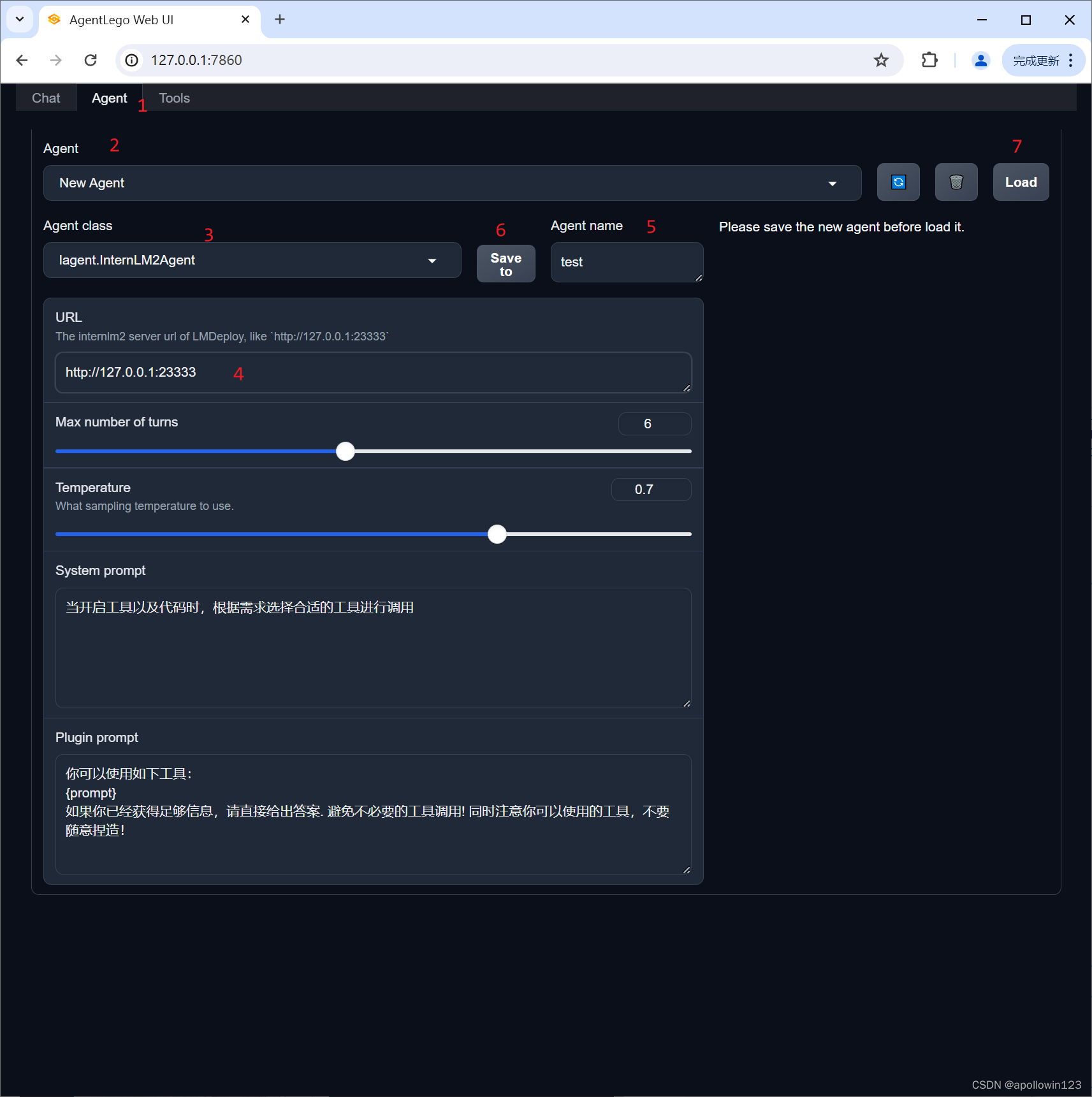

2.4 使用 AgentLego WebUI

在本地的浏览器页面中打开 http://localhost:7860 以使用 AgentLego WebUI。首先来配置 Agent,如下图所示。

- 点击上方 Agent 进入 Agent 配置页面。(如①所示)

- 点击 Agent 下方框,选择 New Agent。(如②所示)

- 选择 Agent Class 为 lagent.InternLM2Agent。(如③所示)

- 输入模型 URL 为 http://127.0.0.1:23333 。(如④所示)

- 输入 Agent name,自定义即可,图中输入了 internlm2。(如⑤所示)

- 点击 save to 以保存配置,这样在下次使用时只需在第2步时选择 Agent 为 internlm2 后点击 load 以加载就可以了。(如⑥所示)

- 点击 load 以加载配置。(如⑦所示)

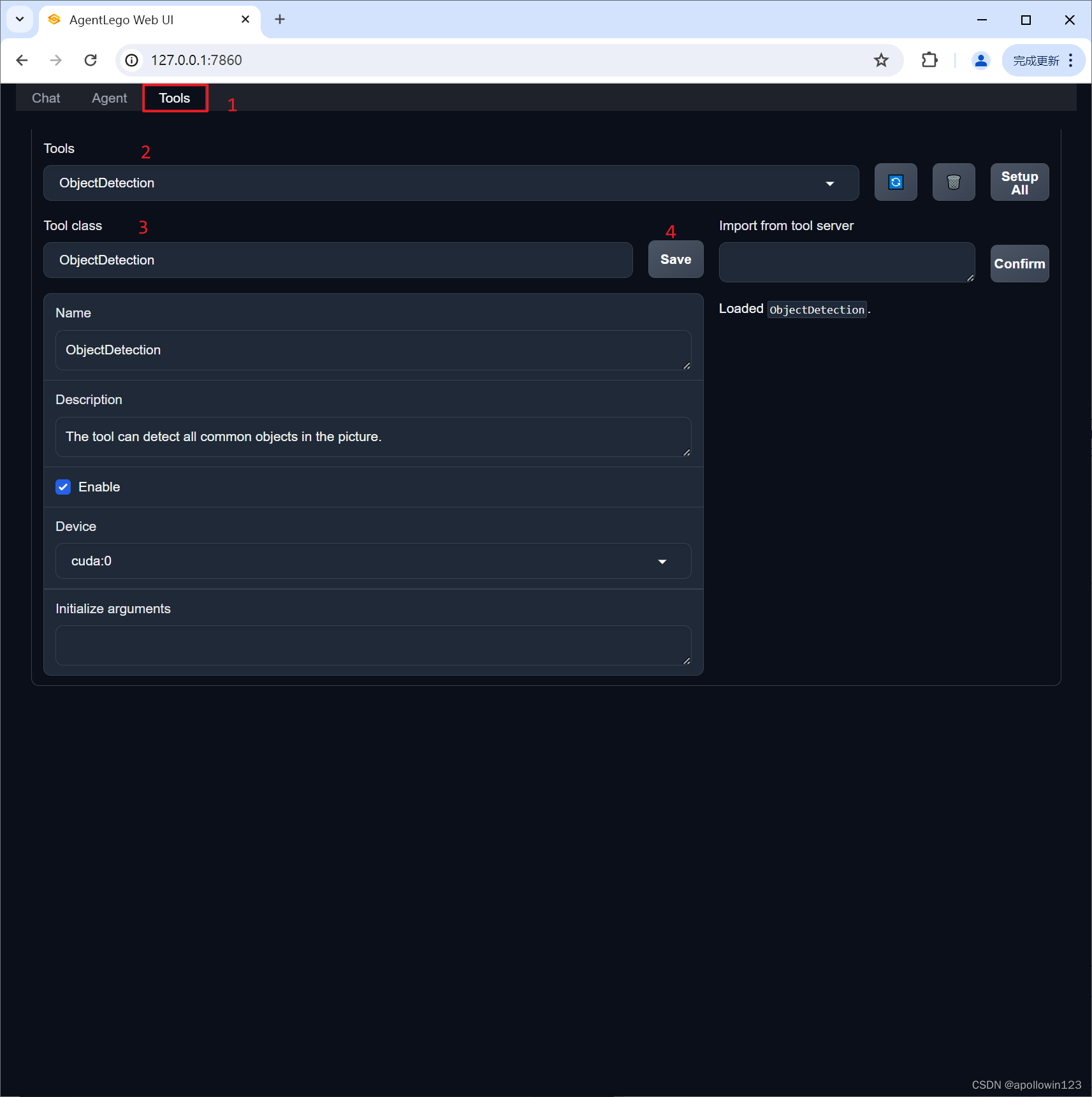

然后配置工具,如下图所示。

- 点击上方 Tools 页面进入工具配置页面。(如①所示)

- 点击 Tools 下方框,选择 New Tool 以加载新工具。(如②所示)

- 选择 Tool Class 为 ObjectDetection。(如③所示)

- 点击 save 以保存配置。(如④所示)

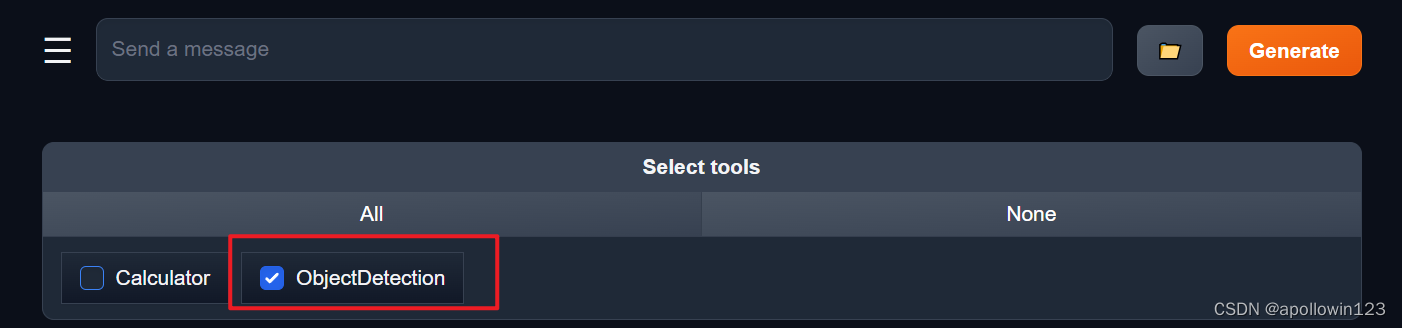

等待工具加载完成后,点击上方 Chat 以进入对话页面。在页面下方选择工具部分只选择 ObjectDetection 工具,如下图所示。为了确保调用工具的成功率,请在使用时确保仅有这一个工具启用。

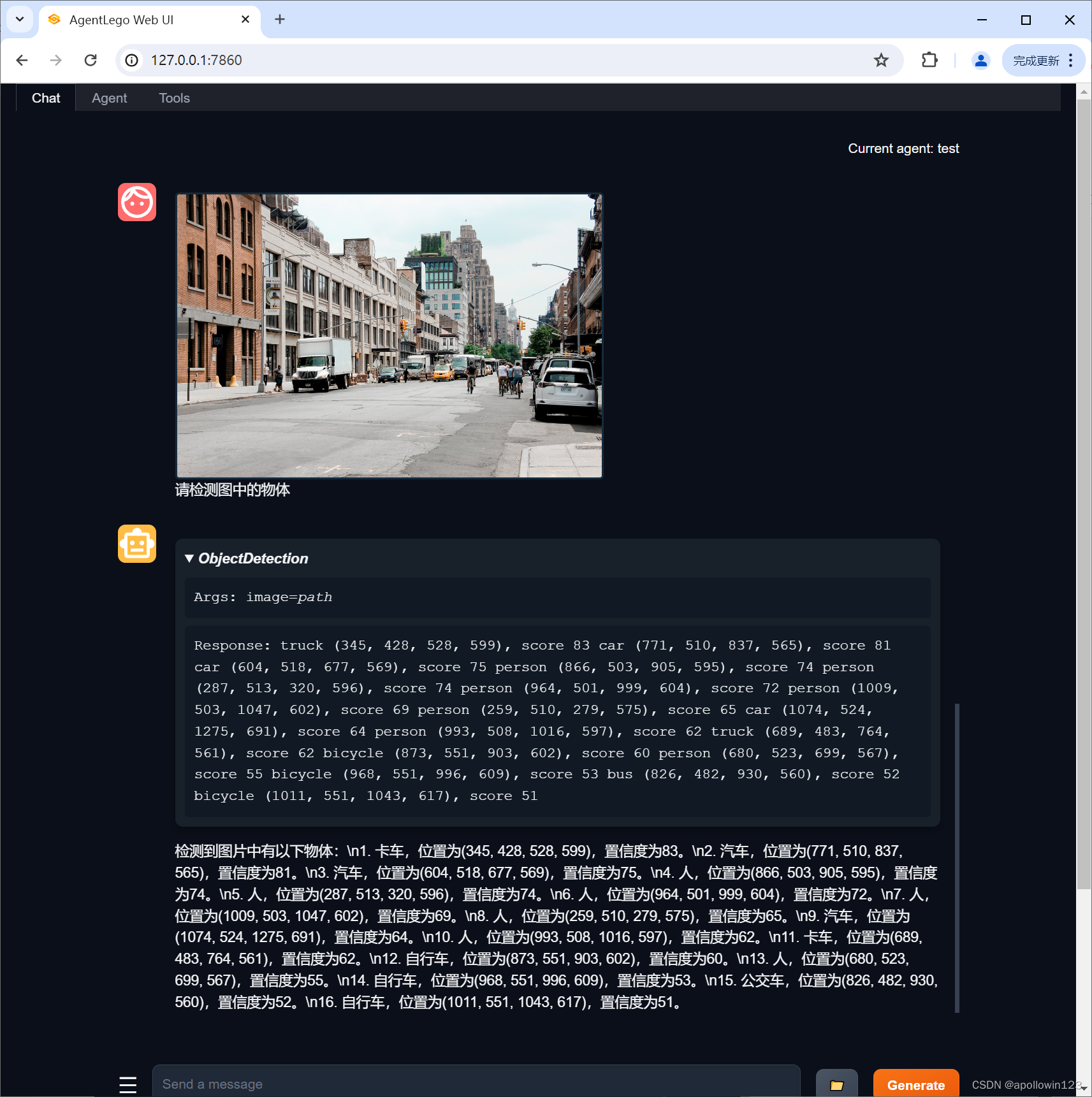

接下来就可以愉快地使用 Agent 了。点击右下角文件夹以上传图片,上传图片后输入指令并点击 generate 以得到模型回复。如下图所示,我们上传了 demo 图片,模型成功地调用了工具,并详细地告诉了我们图中的内容。

3. 用 AgentLego 自定义工具

在本节中,我们将基于 AgentLego 构建自己的自定义工具。AgentLego 在这方面提供了较为详尽的文档,文档地址为 自定义工具 — AgentLego 0.2.0 文档 。自定义工具主要分为以下几步:

- 继承 BaseTool 类

- 修改 default_desc 属性(工具功能描述)

- 如有需要,重载 setup 方法(重型模块延迟加载)

- 重载 apply 方法(工具功能实现)

其中第一二四步是必须的步骤。下面我们将实现一个调用 MagicMaker 的 API 以实现图像生成的工具。

MagicMaker 是汇聚了优秀 AI 算法成果的免费 AI 视觉素材生成与创作平台。主要提供图像生成、图像编辑和视频生成三大核心功能,全面满足用户在各种应用场景下的视觉素材创作需求。体验更多功能可以访问 Magic Maker 。

3.1 创建工具文件

首先通过 touch /root/agent/agentlego/agentlego/tools/magicmaker_image_generation.py(大小写敏感)的方法新建工具文件。该文件的内容如下:

4. Agent 工具能力微调

在这一部分中,我们将介绍 OpenAI Function Calling 的相关内容,以及带大家使用 XTuner 来实现 Agent 工具能力的微调。

详细文档可以访问:Agent 工具能力微调。

参考文献:

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?