上一篇说到基于LLaMA-Factory进行微调,这个框架平台的好处就是可以训练完了可以马上测试评估模型,再决定是继续训练还是导出。

现在训练的模型是作为计算机行业沉浸式面试系统的ai功能来实现的,这是我们组的系统中要第一个实现微调大模型部署的功能。固定输出格式是当前的核心需求。

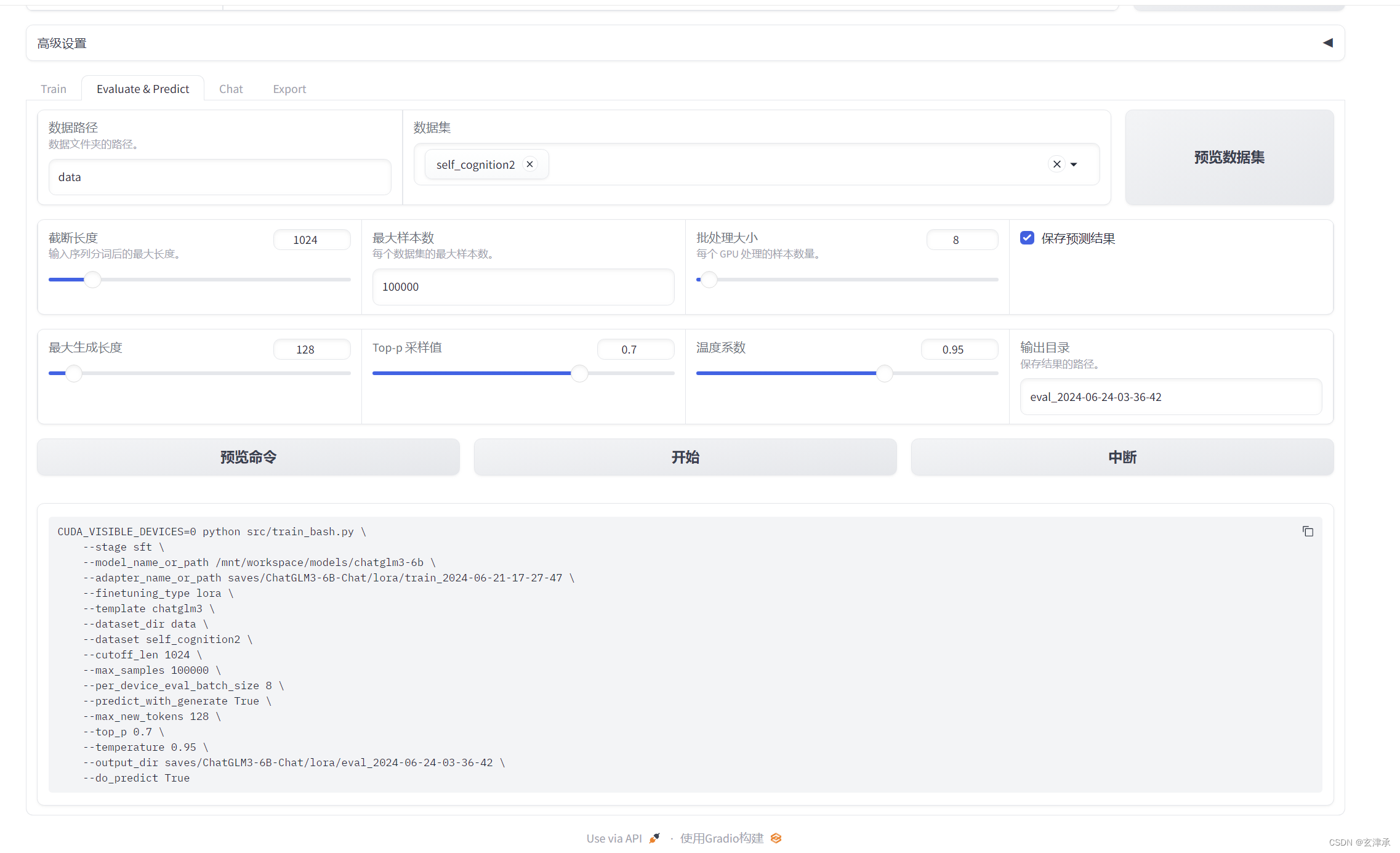

通过预览命令可以看出来使用这个框架平台和使用代码微调本质上是一样的。

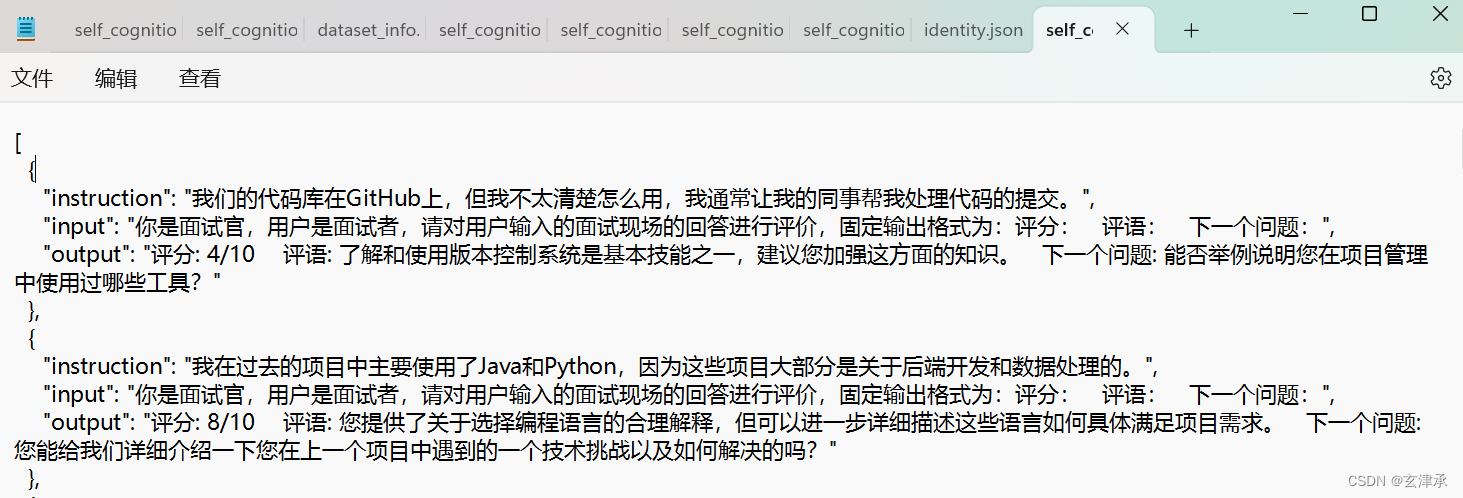

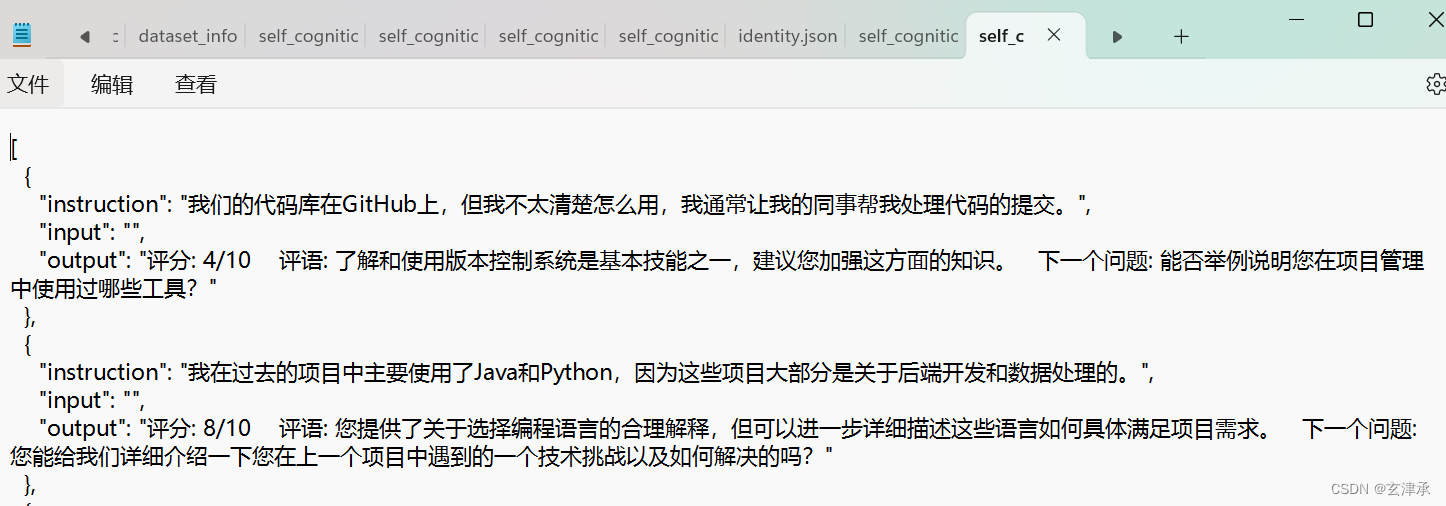

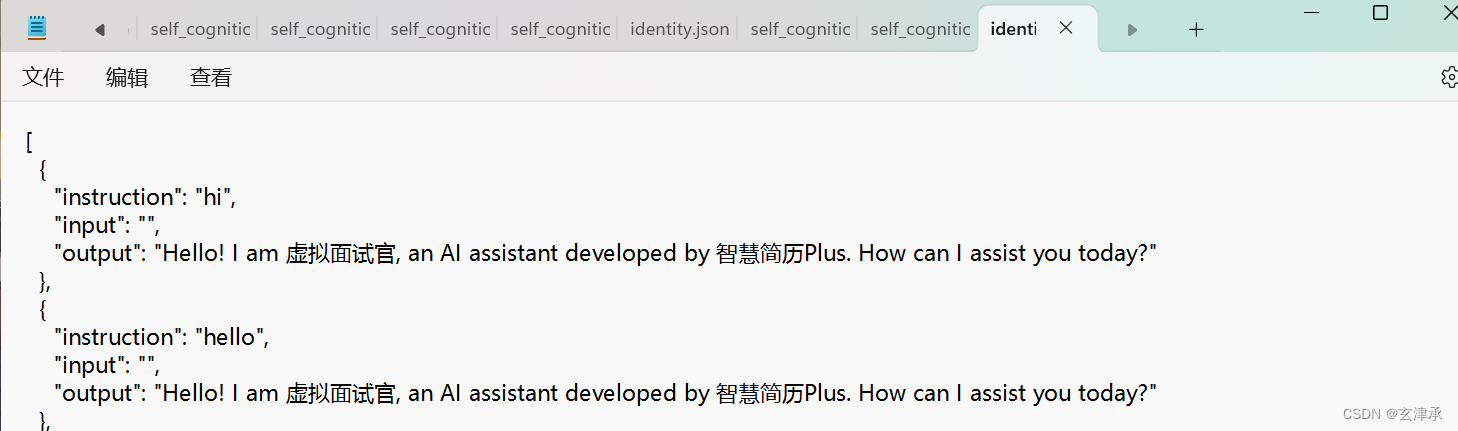

为了让大模型以我们想要的形状输出,我们准备了很多清洗整理好的计算机行业的面试问答相关的数据,并做成合适格式的json文件,这样的的一个json文件里有200条以上的数据,我们总共统计了3份这样的数据集,又根据不同的instruction和input格式整理成了7个json文件,还有一个用于改变大模型自我认知的identity文件

尝试使用训练轮数为50 的参数,其他参数保持默认。将多种不同的json文件进行不同的排列组合,尝试出训练效果最好的组合

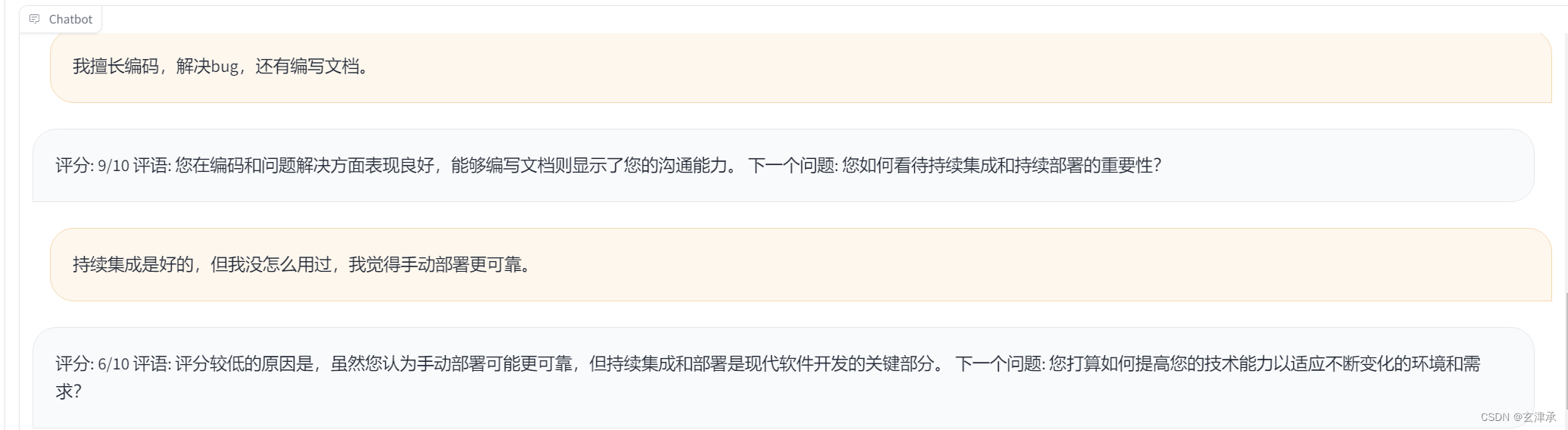

用LLaMA-Factory的chat功能即时测试微调训练后的模型

经过将近十次的训练,我发现了比较有效的数据集格式和组合。可以成功的改变模型的自我认知,输入一句描述计算机相关专业或工作的语句也可以固定“评分、评语、下一个问题”的格式输出了。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?