目录

Big Data Tools插件

安装插件

下面通过idea进行演示

配置windows

解压

解压时会碰到下面的提示:

提示无法创建符号链接,是因为打包的时候,里面有一些Linux的软链接,对于windows系统来说,并不支持Linux系统的软链接,因此会有这种提示,我们不需要管它,忽略即可。

设置环境变量

将HADOOP_HOME加入到path中:

下载

在黑马程序员的课程资料中下载这两个文件

将下载的这两个文件放到$HADOOP_HOME/bin中

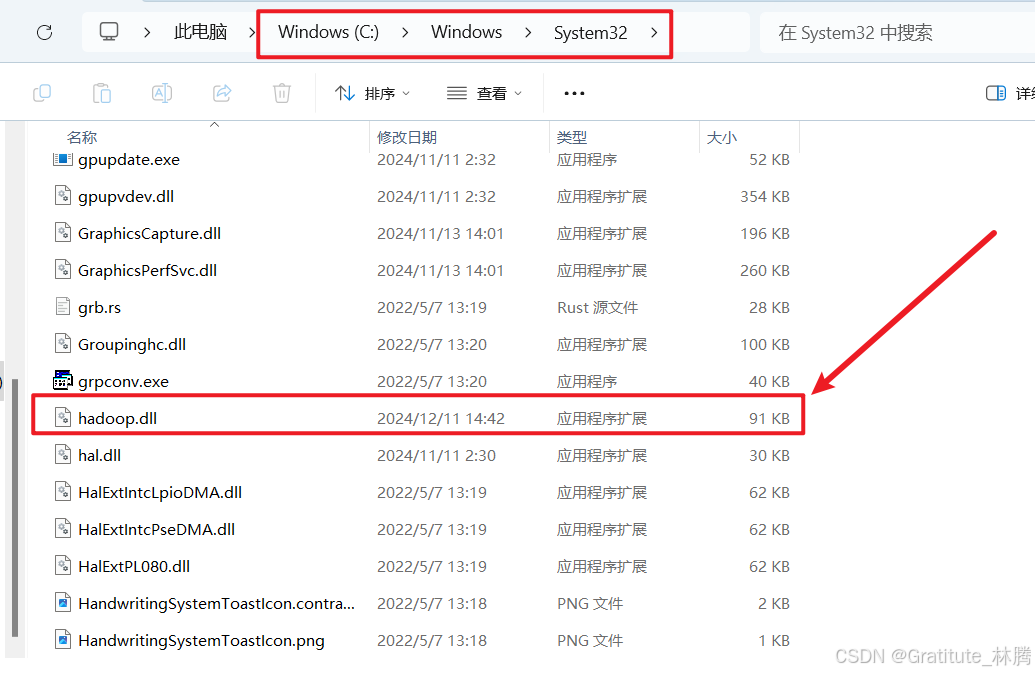

将hadoop.dll放到C:\Windows\System32下:

配置完后,重启idea。

配置Big Data Tools插件

打开插件

选择HDFS

方式一

选择配置文件的路径,并点击测试

如果使用上面这种方式,还需要将Hadoop的整个配置文件进行打包。

在node1节点中,切换到hadoop用户

su - hadoop并进入到/export/server/hadoop/etc/hadoop

cd /export/server/hadoop/etc/hadoop将里面的配置文件全部打包

tar -zcvf etc.tar.gz *将这个压缩包下载下来

sz etc.tar.gz将windows里面原来的配置文件全部删掉

然后把下载下来的压缩包里面的文件全部复制到windows里面原来的配置文件所在位置

也可以输入nameNode的主机名和端口,以及HDFS启动用户

注:使用这种方式可能会报错。只需要在hadoop里建个文件或目录就可以连接了(就是在启动HDFS的那台虚拟机里,切换到hadoop用户,并启动HDFS,然后创建文件或目录)

hdfs dfs -mkdir /a

显示测试成功,说明能正常连接:

文件操作

连接好后,就可以对HDFS文件系统进行文件或文件夹的相关操作了:

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?