一、前言

(一)、什么是目标检测

目标检测是指在图像或视频中准确地识别和定位出现的特定目标物体的任务。目标检测通常包括以下几个步骤:

-

目标分类:确定图像中出现的物体属于哪一类别,例如汽车、行人、狗等。

-

目标定位:确定图像中物体的位置,通常通过绘制边界框或遮罩来标识物体的位置。

-

目标识别:将检测到的目标与预定义的类别进行匹配,以便为目标添加语义标签。

-

多目标检测:在一张图像中检测并识别多个目标,包括重叠目标和不同尺寸的目标。

目标检测技术的发展主要借助于深度学习和卷积神经网络等方法,其中一些流行的目标检测算法包括YOLO (You Only Look Once)、RCNN (Region-based Convolutional Neural Networks)、SSD (Single Shot MultiBox Detector)等。目标检测在许多领域中有广泛的应用,如自动驾驶、智能监控、医学图像分析等。

总的来说,目标检测是一个复杂的过程,涉及到图像处理、机器学习和模式识别等多个技术领域。随着技术的不断进步,目标检测的准确性和应用范围都在不断扩大。

文章以课堂学习为要求,分享自己完成yolo目标检测实验操作流程。

(二)、什么是YOLO算法

YOLO算法(You Only Look Once)是一种端到端的目标检测方法,以速度快和操作简便而著称。

YOLO算法的核心思想是将目标检测任务当作一个回归问题来解决,它通过一个单独的神经网络同时预测物体的类别和位置。这种方法的名称来源于它的设计理念——“你只需要看一次”(You Only Look Once),意味着对图像的检测只需一次前向传播即可完成,这与传统的需要多次扫描图像的方法不同。

以下是YOLO算法的主要特点:

- 端到端学习:YOLO使用单个卷积神经网络(CNN)模型进行端到端的学习和预测,从输入到输出直接得到检测结果。

- 实时性能:由于整个检测流程只需要一次前向传播,所以YOLO能够在实时应用中快速地执行目标检测任务。

- 网络结构:原始的YOLO网络结构借鉴了GoogLeNet,包含24个卷积层和2个全连接层。在后续的版本中,网络结构有所改进以提高检测精度。

- 简化流程:YOLO算法简化了目标检测的流程,不需要像传统方法那样先生成候选区域再进行分类,而是一步到位完成检测任务。

- 灵活适用:YOLO可以应用于多种场景,包括车辆检测、行人检测等,适应范围广泛。

- 版本迭代:自2015年提出以来,YOLO经历了多个版本的更新,如YOLOv2、YOLOv3等,每个版本都在速度和准确度上有所提升。

总的来说,YOLO算法因其高效的检测速度和不错的准确率,在计算机视觉领域得到了广泛的应用,特别是在需要实时处理视频流的应用场景中,如自动驾驶和监控安全等。

二、实验准备

硬件设备:确保有足够的计算资源来进行模型训练,特别是如果打算使用较大的模型或进行长时间的训练。(训练结果需要花费很长时间)

软件环境:安装必要的软件和库(Python3.8和PyTorch),并确保它们与硬件兼容。

开发工具:选择合适的集成开发环境(IDE),如PyCharm,以便于编写和调试代码。

数据集准备:准备或收集适合实验需求的数据集,提前找好充足的训练照片,并将其按照YOLOv4的格式进行转换。

模型选择:根据您选择合适的YOLO模型版本。

三、实验步骤

(一)、模型下载

需要获取YOLOv4的源代码,可以通过GitHub上的链接进行克隆或下载ZIP包。可以从GitHub上的一个开源项目获取,具体链接为:GitHub - bubbliiiing/yolov4-pytorch at bilibili。

(二)、环境配置

根据项目要求和硬件条件,配置适合的训练环境,包括安装必要的软件依赖和库。确保计算机安装了较新版本的Python3.8和PyTorch。

(三)数据集准备

准备或收集适合您实验需求的数据集,并进行标注。实验所需图片可以分为训练集和测试集,训练集至少需要100张图片来确保模型的准确度,测试集几十张即可。

将训练集图片保存至代码文件的JPEGImages目录文件中:

yolov4-pytorch-master\VOCdevkit\VOC2007\JPEGImages

(四)数据预处理

对数据集进行预处理,以提高模型的泛化能力。

(五)、图像标注

1.打开框选软件labelImg.exe作为标注工具;

2.首先打开“Change Save Dir”选择框选完的图片保存位置:yolov4-pytorch-master\VOCdevkit\VOC2007\Annotations

3.“open”打开JPEGImages文件夹选择图片;

4.使用“Create\nRectBox”框选目标,且输入识别标签并保存,保存好的图片就会生成对应的xml文件,其中包含目标物体的边界框坐标、类别等信息。

(六)、运行代码

1.修改检测类别名文件:coco_classes.txt和voc_classes.txt文本文件,将里面的标签名改为自己前面设置的标签名,每个类别占一行,确保类别的命名准确且一致;

2.数据处理:需要使用voc_annotation.py脚本来生成训练所需的2007_train.txt和2007_val.txt文件。这两个文件包含了训练集和验证集中图片的路径以及对应的标注信息。运行结果如下:

3.训练模型:运行代码train.py

需要训练数据集300次,时间较长请提前准备好。

(七)、训练结果预测

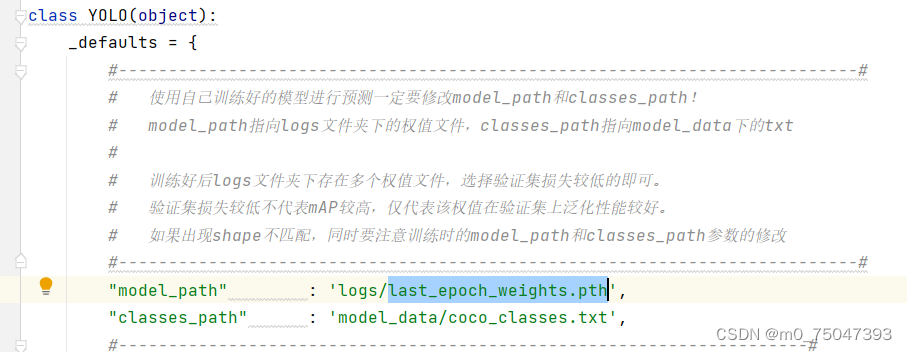

1.主要文件:预测时,主要使用yolo.py和predict.py。在yolo.py中,需修改model_path和classes_path指向正确的模型权重和类别文件。

model_path指向训练好的权重文件

classes_path指向类别文本文件(.txt)

2.训练权重: 在yolo.py文件里面,在如下部分修改model_path和classes_path使其对应训练好的文件就可以运行predict.py文件来进行预测了。

训练完成后会在目录yolov4-pytorch-master\logs下生成last_epoch_weights.pth文件,并将此文件路径替换至下图所选位置(已替换)

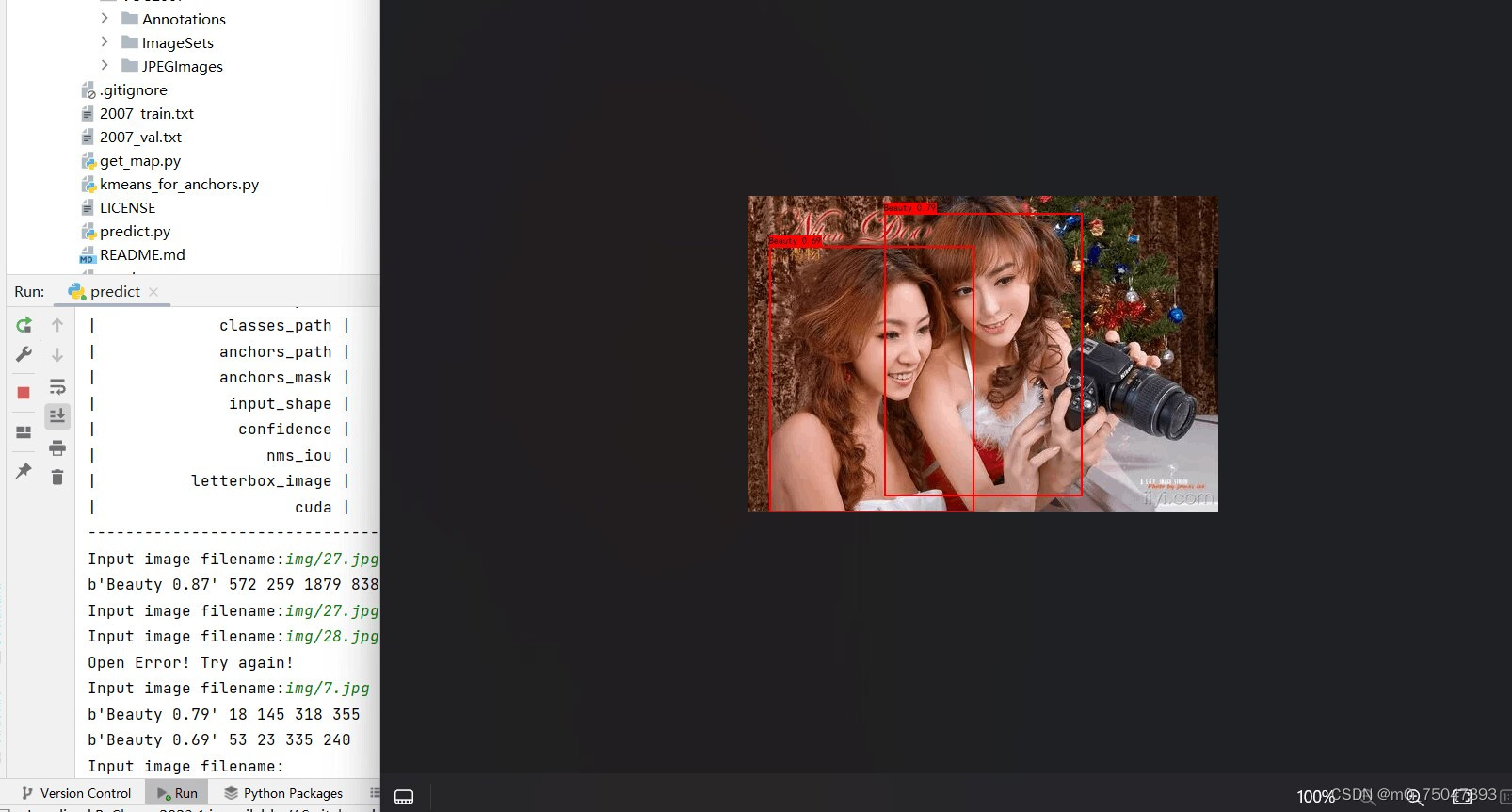

3.输入预测图片:最后选择需要预测的图片就能预测结果了(如图)

四、总结

在进行yolo目标检测项目的过程中,我学到了许多关于计算机视觉和深度学习的知识。以下是我的一些总结心得:

-

数据准备是关键:在进行目标检测项目之前,必须准备好高质量的数据集。这包括标注数据,并确保数据集覆盖了各种不同的情况和角度。

-

模型选择和调参:在选择yolo模型时,要考虑自己的项目需求和计算资源。还要对模型进行适当的调参,以获得最佳的性能。

-

训练过程:在训练模型时,要确保使用适当的优化器和学习率。还要定期监控模型的性能,并根据需要调整训练参数。

-

模型评估和改进:在完成训练后,要对模型进行评估,以确保其在未见过的数据上的泛化性能。如果需要进一步改进,可以考虑调整数据集或模型结构。

-

应用部署:最后,要将训练好的模型部署到实际应用中,并确保其在生产环境中的性能表现良好。

总的来说,yolo目标检测项目是一个很有挑战性的任务,但通过不懈的努力和实践,我们可以不断提升自己的技能并取得成功。

本文介绍了目标检测的基本概念,重点讲解了YOLO算法的工作原理及其在深度学习中的应用。作者详细阐述了YOLO算法的特点,以及如何进行实验准备、数据预处理和模型训练,分享了yolo目标检测项目的实战经验。

本文介绍了目标检测的基本概念,重点讲解了YOLO算法的工作原理及其在深度学习中的应用。作者详细阐述了YOLO算法的特点,以及如何进行实验准备、数据预处理和模型训练,分享了yolo目标检测项目的实战经验。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?