MusicLM-Pytorch: AI音乐生成的开源实现

在人工智能快速发展的今天,AI创作音乐已经不再是科幻小说中的场景。谷歌研究院最近发布的MusicLM模型展示了AI在音乐创作领域的巨大潜力,引发了广泛关注。而现在,开源社区也在积极推动这项技术的发展和应用。GitHub上的MusicLM-Pytorch项目就是其中的佼佼者,它为开发者和研究人员提供了一个可以本地运行的MusicLM开源实现。

项目背景与目标

MusicLM-Pytorch项目由开源AI研究者Phil Wang发起,旨在复现Google的MusicLM模型。该项目使用PyTorch深度学习框架,实现了MusicLM的核心架构和功能。它的目标是让更多人能够理解、使用和改进这种先进的AI音乐生成技术。

核心技术解析

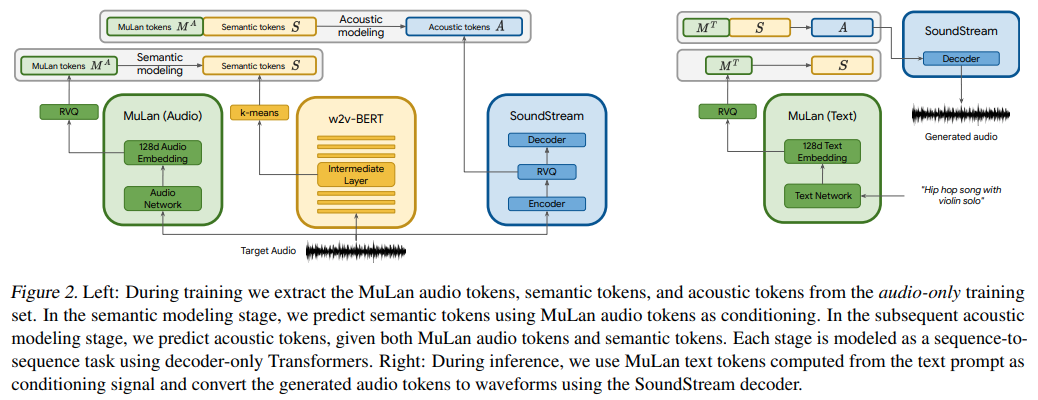

MusicLM-Pytorch的核心是将文本条件的AudioLM与MuLan(一种文本-音频对比学习模型)相结合。具体来说,它包含以下关键组件:

-

MuLan模型: 这是一个联合音频-文本嵌入模型,用于将音频和文本映射到同一潜在空间。

-

AudioLM: 一个强大的音频语言模型,用于生成高质量的音频序列。

-

MuLaNEmbedQuantizer: 用于量化MuLan的输出嵌入,并将其映射到AudioLM可接受的维度。

-

语义、粗糙和精细三阶段转换器: 这些转换器协同工作,逐步生成从语义级别到精细音频细节的音乐。

使用方法

要使用MusicLM-Pytorch,开发者需要按以下步骤操作:

- 安装依赖:

pip install musiclm-pytorch

- 训练MuLan模型:

from musiclm_pytorch import MuLaN, AudioSpectrogramTransformer, TextTransformer

# 初始化和训练MuLan模型

- 设置MuLaNEmbedQuantizer:

from musiclm_pytorch import MuLaNEmbedQuantizer

quantizer = MuLaNEmbedQuantizer(

mulan = mulan,

conditioning_dims = (1024, 1024, 1024),

namespaces = ('semantic', 'coarse', 'fine')

)

-

训练AudioLM的三个转换器(语义、粗糙、精细)。

-

最后,使用训练好的模型生成音乐:

from musiclm_pytorch import MusicLM

musiclm = MusicLM(

audio_lm = audio_lm,

mulan_embed_quantizer = quantizer

)

music = musiclm('the crystalline sounds of the piano in a ballroom', num_samples = 4)

项目优势与特点

MusicLM-Pytorch项目具有以下几个显著特点:

-

开源性: 完全开源,允许研究者深入了解模型内部工作原理。

-

灵活性: 使用PyTorch框架,便于修改和扩展。

-

模块化设计: 各个组件可以独立使用和优化。

-

社区支持: 活跃的开发者社区,持续更新和改进。

未来发展方向

项目维护者列出了一些待完成的任务,包括:

- 实现解耦对比学习

- 支持可变长度音频输入

- 优化频谱图超参数

- 增加与开源CLIP模型的兼容性

这些计划显示了项目团队对持续改进的承诺,以及对最新AI研究趋势的关注。

结语

MusicLM-Pytorch为AI音乐生成领域带来了新的可能性。它不仅是一个强大的研究工具,也为音乐创作者提供了激发灵感的新方式。随着项目的不断发展和完善,我们可以期待看到更多令人惊叹的AI生成音乐作品。

正如Jack Kerouac所说:"音乐是唯一的真理。"在AI时代,这句话似乎有了新的含义。MusicLM-Pytorch正在探索人工智能如何理解和创造音乐这一人类文明的精髓,为音乐创作开辟了一个全新的领域。

无论你是AI研究者、音乐爱好者,还是对未来技术感兴趣的普通人,MusicLM-Pytorch都值得你关注。它不仅代表了AI音乐生成的最新进展,更象征着技术与艺术融合的美好未来。

项目链接:www.dongaigc.com/a/musiclm-pytorch-ai-music-generation

https://www.dongaigc.com/a/musiclm-pytorch-ai-music-generation

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?