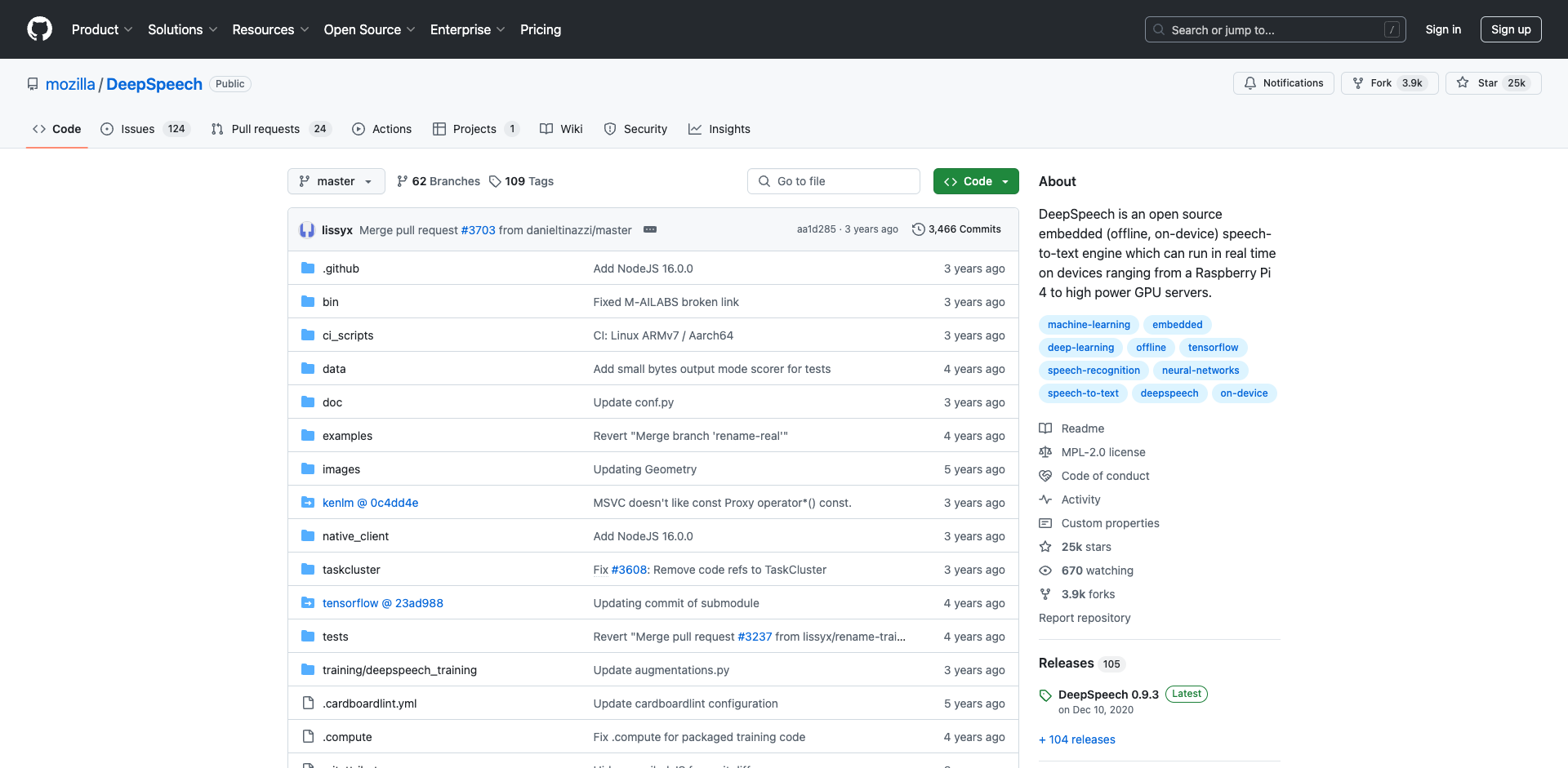

DeepSpeech:开源嵌入式语音识别引擎

DeepSpeech是一个由Mozilla开发的开源语音识别引擎,它可以在各种设备上实现离线、实时的语音转文本功能。无论是树莓派这样的嵌入式设备,还是高性能的GPU服务器,DeepSpeech都能很好地运行。本文将全面介绍DeepSpeech项目的背景、特点、应用场景及使用方法。

DeepSpeech的诞生背景

DeepSpeech项目最初是基于百度2014年发表的研究论文《Deep Speech: Scaling up end-to-end speech recognition》而开发的。该论文提出了一种全新的端到端语音识别方法,使用深度学习技术直接从原始音频数据学习转录文本,无需传统语音识别中的音素等中间表示。

Mozilla看到了这种方法的潜力,决定基于TensorFlow框架实现一个开源版本,以推动语音识别技术的发展和应用。经过多年的开发和优化,DeepSpeech已经成为一个功能强大、性能优异的语音识别引擎。

DeepSpeech的主要特点

DeepSpeech具有以下几个突出特点:

-

开源免费:DeepSpeech采用MPL 2.0开源协议,任何人都可以自由使用、修改和分发。

-

嵌入式设计:DeepSpeech可以在资源受限的嵌入式设备上运行,支持离线语音识别。

-

实时性能:通过优化算法和模型,DeepSpeech可以实现实时的语音转文本。

-

多平台支持:提供Python、C++、Java、JavaScript等多种编程语言的API。

-

可定制性强:用户可以使用自己的数据集训练定制化模型。

-

持续更新:Mozilla和开源社区不断优化DeepSpeech的性能和功能。

DeepSpeech的工作原理

DeepSpeech的语音识别过程主要包含两个步骤:

-

声学模型:将音频信号转换为字符概率序列。这一步使用了深度神经网络(DNN)来学习音频特征与文本的映射关系。

-

语言模型:对声学模型输出的字符序列进行优化,提高识别准确率。DeepSpeech使用N-gram语言模型来实现这一功能。

整个过程可以简单概括为:原始音频 → 特征提取 → 声学模型 → 解码 → 语言模型 → 最终文本。

DeepSpeech的应用场景

DeepSpeech的离线、实时、嵌入式等特性,使其在多个领域都有广泛的应用前景:

-

智能家居:为智能音箱、家电等设备提供语音控制功能。

-

车载系统:实现离线的语音导航和控制。

-

辅助技术:帮助听障人士实时转录语音。

-

会议记录:自动生成会议纪要和字幕。

-

客户服务:为呼叫中心提供实时语音转文本服务。

-

移动应用:在手机App中集成语音识别功能。

如何使用DeepSpeech

要开始使用DeepSpeech,可以按照以下步骤操作:

-

安装DeepSpeech:

pip install deepspeech -

下载预训练模型: 从GitHub Releases页面下载最新的模型文件。

-

使用Python API进行语音识别:

import deepspeech import numpy as np # 加载模型 model = deepspeech.Model('path/to/model.pbmm') model.enableExternalScorer('path/to/scorer.scorer') # 读取音频文件 audio = np.frombuffer(open('audio.wav', 'rb').read(), np.int16) # 进行识别 text = model.stt(audio) print(text) -

实时识别: DeepSpeech还提供了流式API,可以实现实时语音识别。详细用法可参考官方文档。

DeepSpeech的性能与局限性

DeepSpeech在多个公开数据集上都取得了不错的识别准确率。例如,在LibriSpeech测试集上,DeepSpeech的词错误率(WER)可以达到5.97%。这个性能虽然还不及一些商业语音识别系统,但考虑到其开源、离线的特性,已经是非常优秀的表现。

然而,DeepSpeech也存在一些局限性:

-

资源消耗:虽然可以在嵌入式设备上运行,但对内存和计算能力仍有一定要求。

-

语言支持:目前主要支持英语,其他语言的模型和性能还有待提升。

-

噪声敏感:在嘈杂环境下的识别准确率会明显下降。

-

定制化成本:训练自定义模型需要大量的标注数据和计算资源。

DeepSpeech的未来发展

作为一个活跃的开源项目,DeepSpeech正在持续改进和发展。未来的发展方向可能包括:

- 提升多语言支持

- 优化模型大小和推理速度

- 增强噪声环境下的识别能力

- 改进流式识别的延迟

- 探索新的神经网络架构

结语

DeepSpeech作为一个开源的嵌入式语音识别引擎,为开发者和研究人员提供了一个强大的工具,推动了语音识别技术的民主化。虽然在某些方面还不及商业系统,但其开放性、可定制性和持续改进的特点,使其在特定应用场景中具有独特优势。随着技术的不断进步和社区的共同努力,DeepSpeech必将在语音识别领域发挥越来越重要的作用。

文章链接:www.dongaigc.com/a/deepspeech-open-source-voice-recognition

https://www.dongaigc.com/a/deepspeech-open-source-voice-recognition

www.dongaigc.com/p/mozilla/DeepSpeech

https://www.dongaigc.com/p/mozilla/DeepSpeech

2533

2533

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?