写在前面

- 若有图片加载失败,请科学上网 。

- 全文经软件学院刘老师所讲的复习重点总结所得,

应该对考点进行了全覆盖,仅供复习参考。(谢谢刘老师!)- 2023年5月30日更新:所有考的内容都在复习提纲里面,好好背了应该可以拿个不错的分数,再次感谢刘老师!

文章目录

并行计算

1、矩阵向量乘法

题目

串行代码

答案

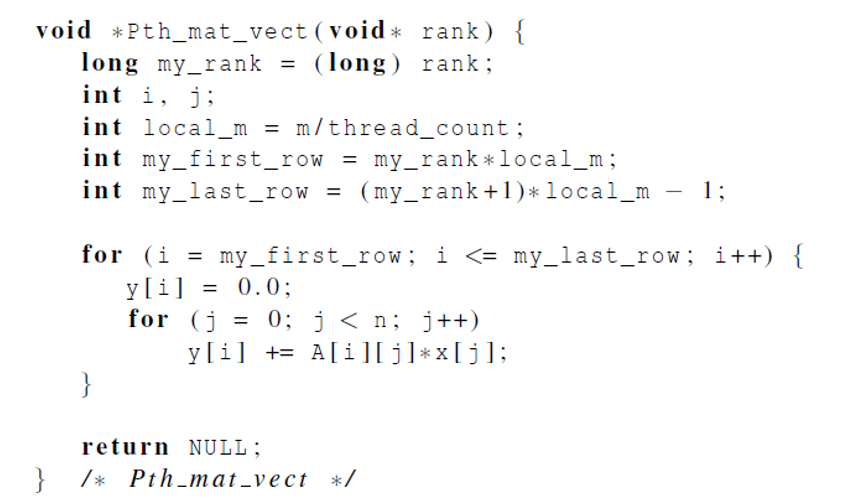

Pthreads可整除代码

Pthreads不可整除的计算

注意:老师给的代码是 n / p,但题目设定是m、t,所以要把下面的 n、p 改成 m、t,即:

quotient = m / t;

remainder = m % t;

2、MPI_Reduce() 运算题

题目

解答

若 Process 0 为目标进程,则执行结束后,b = 1 + 2 + 1 = 4; d = 2 + 1 + 2 = 5;

若 Process 1 为目标进程,则执行结束后,d = 1 + 2 + 1 = 4; b = 2 + 1 + 2 = 5;

3、SISD、SIMD解释题

题目

在冯·诺依曼系统中加人缓存和虚拟内存改变了它作为SISD系统的类型吗?如果加人流水线呢?多发射或硬件多线程呢?

答案

最基本的缓存和虚拟内存的实现不会改变同时可以执行的指令数量或可以操作的数据量。

我们可以将流水线视为将一个复杂的指令应用于多个数据项。因此,它有时被认为是SIMD的一种。

多发射和硬件多线程试图将可能不同的指令应用于不同的数据项。因此,它们可以被认为是MIMD的例子。

4、Cache缓存命中题目

题目

答案

由于C语言是行主序存储,故按行访问更快。

第一个双重 for 循环的内层循环是按行访问,cache 命中率高,速度更快;

第二个双重 for 循环的内层循环是按列访问,cache 命中率低,速度更慢。

5、流水线计算题

题目

答案

第一题

2+1+1+1+1+1+2 = 9 ns

第二题

9 × \times × 1000 = 9000 ns

第三题

| TIME | 取指令 | 比较 | 移位 | 相加 | 规格化 | 舍入 | 存储 |

|---|---|---|---|---|---|---|---|

| 0 | 0 | ||||||

| 1 | 0 | ||||||

| 2 | 1 | 0 | |||||

| 3 | 1 | 0 | |||||

| 4 | 2 | 1 | 0 | ||||

| 5 | 2 | 1 | 0 | ||||

| 6 | 3 | 2 | 1 | 0 | |||

| 7 | 3 | 2 | 1 | 0 | |||

| 8 | 4 | 3 | 2 | 1 | 0 | ||

| 9 | 4 | 3 | 2 | 1 | |||

| 10 | 5 | 4 | 3 | 2 | 1 | ||

| 11 | 5 | 4 | 3 | 2 | |||

| 12 | 6 | ··· | 4 | 3 | 2 | ||

| 13 | 6 | ··· | 4 | 3 |

7 + (1000 × \times × 2) = 2007 ns

6、MPI数据划分题

块划分、循环划分、块-循环划分

题目

12任务,3线程,如何进行三种划分?

14任务,3线程,如何进行三种划分?

答案

1、

2、

| Process | 块 | 循 | 环 | 块 | - | 循 | 环 | |||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 0 | 0 | 1 | 2 | 3 | 4 | 0 | 3 | 6 | 9 | 12 | 0 | 1 | 6 | 7 | 12 | 13 |

| 1 | 5 | 6 | 7 | 8 | 9 | 1 | 4 | 7 | 10 | 13 | 2 | 3 | 8 | 9 | ||

| 2 | 10 | 11 | 12 | 13 | 2 | 5 | 8 | 11 | 4 | 5 | 10 | 11 |

7、点对点通讯与问答题

题目

点对点通讯与集合通讯的联系或区别?

答案

1、在通信子中的所有进程都必须调用相同的集合通信函数。

2、每个进程传递给 MPI 集合通信函数的参数必须是相容的。

3、参数 output_data_p 只用在 dest_process 上,然而,所有进程仍需要传递一个与之相对应的实际参数,即使参数的值是 NULL 也可以。

4、点对点通信是通过标签和通信子来匹配的。集合通信不使用标签,只通过通信子和调用的顺序来进行匹配。

8、cache一致性问题

题目

如何保证 cache 一致性,有哪些方法?各方法有什么特点?

答案

1、监听Cache一致性协议

- 多个核共享一个总线。

- 总线上的传递的信号能被连接到总线的所有核所看到。

- 当核 0 更新它在 Cache 中 x 的副本时,它能将该信息通过总线传播。

- 当核 1 监听总线时,他看到了 x 已经被修改,就能将自己 Cache 中的 x 副本标记为非法的,到主存中找 x 。

2、基于目录的Cache一致性协议

- 使用一个叫做目录的数据结构,目录记载了每个 cache 缓存行的状态。

- 当一个变量被更新时,会查询当前目录,并且在 cache 中包含该变量的cache行的核的缓存控制器将失效。

- 当一个节点需要访问或者修改一个 cache 行时,可以通过目录来确定是否需要向其他节点发送请求或无效信号。

3、区别或联系:

- 由于广播的代价较大,基于目录的 cache 一致性协议比监听 cache 一致性协议更容易拓展,它不依赖总线。

- 基于目录的 cache 一致性协议更复杂,因为要维护额外的目录结构。

9、循环依赖问题

题目

答案

# pragma omp parallel for num_threads(thread_count) \

default(none) private(i) shared(a, n)

for (i = 0; i < n; i++)

a[i] = i * (i + 1) / 2;

10、OpenMP宏定义问题

问题

答案

#include <iostream>

#ifdef _OPENMP

#include <omp.h>

#endif

using namespace std;

int main() {

#ifdef _OPENMP

cout << _OPENMP << endl;

#else

cout << "未定义" << endl;;

#endif

return 0;

}

输出:201511,表示表示编译器支持 2015 年 11 月发布的 OPENMP 规范。

11、CUDA计算一维向量和计算题

题目

串行代码

答案

kernel 函数

12、CUDA二维向量和计算题

本题考代码纠错,要明白源代码中各变量含义,会计算 offset 。

串行

CUDA并行代码

o f f s e t = r o w ∗ N + c o l u m n offset = row * N + column offset=row∗N+column

int col = blockIdx.x * blockDim.x + threadIdx.x;

int row = blockIdx.y * blockDim.y + threadIdx.y;

int index = row * N + col;

13、CUDA二维矩阵乘

本题考代码纠错,要明白代码中各变量含义,尤其是 k 代表的含义以及 k 的位置。

串行代码

CUDA并行代码

14、CUDA reduction

题目

下段代码存在什么潜在的问题?如何解决?

答案

分析

1、取余操作(%)慢:由于 CUDA 没有硬件支持的取余运算,所以会把取余运算编译成20条左右的指令,会导致GPU性能很低。

2、这段代码是 highly divergent 的,因为 CUDA 的 GPU 采用了 SIMT 架构,所以无法让同一 warp 的线程执行不同指令;并且 GPU 无法进行分支预测,所以就导致了在该 warp 中,if 判断语句计算 tid 是否为偶数,会导致有一半的线程(即奇数号线程)空闲,导致分支严重,性能下降严重。

解决

1、用乘法计算 index,去掉取余操作。

2、if 分支写成 index < blockDim.x,连续条件判断,使得同一个 warp 中的线程统一执行或统一不执行该语句,大幅提升性能。

本文是关于并行计算的复习资料,涵盖了矩阵向量乘法、MPI操作如MPI_Reduce、SISD与SIMD概念、Cache缓存命中、流水线计算、MPI数据划分、点对点通讯、cache一致性问题等多个考点。还提供了OpenMP宏定义、CUDA计算向量和矩阵乘法的代码示例及问题解答,适合备考复习。

本文是关于并行计算的复习资料,涵盖了矩阵向量乘法、MPI操作如MPI_Reduce、SISD与SIMD概念、Cache缓存命中、流水线计算、MPI数据划分、点对点通讯、cache一致性问题等多个考点。还提供了OpenMP宏定义、CUDA计算向量和矩阵乘法的代码示例及问题解答,适合备考复习。

2541

2541

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?