- 参考文章 - http://www.open-open.com/lib/view/open1453175029339.html

- 软件版本 - hadoop-2.7.3.tar.gz(下载传送门 http://hadoop.apache.org/releases.html)

本文基于hadoop的版本是2.7.3,结合参考文章的配置,亲测可用。

前置条件

一台linux服务器,已成功配置ssh(在集群环境下可配置免密码ssh登陆,本文未作验证);

linux服务器安装java,并配置好环境变量;

hadoop-2.7.3.tar.gz文件;

以上请自行google或百度

安装配置

本文直接使用root账号进行的操作,为了安全可创建hadoop账号来进行管理

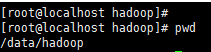

hadoop安装目录 ${HADOOP_HOME}=/data/hadoop

1、解压hadoop,解压到hadoop安装目录,并将解压后的文件移动到该目录下

cd ${HADOOP_HOME}

tar zxvf hadoop-2.7.3.tar.gz

cd hadoop-2.7.3

mv -f * ../

cd ..

rm -rf hadoop-2.7.3

2、设置临时文件夹和hdfs的name和data文件夹

可依照个人喜好进行设置,本文直接在hadoop安装目录中设置

cd ${HADOOP_HOME}

mkdir tmp

mkdir hdfs

mkdir hdfs/name

mkdir hdfs/data

3、配置信息的修改(配置文件位于${HADOOP_HOME}/etc/hadoop文件夹下)

(1)hadoop-env.sh

修改JAVA_HOME=...处,更改为jdk的路径

(2)core-site.xml

<configuration>元素下增加

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/data/hadoop/tmp</value>

</property>

(3)mapred-site.xml

<configuration>元素下增加

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/data/hadoop/tmp</value>

</property>

(4)hdfs-site.xml

<configuration>元素下增加

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/data/hadoop/hdfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/data/hadoop/hdfs/data</value>

</property>

<property>

<name>dfs.replication</name>

<value>2</value>

</property>

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>localhost:9001</value>

</property>

(5)yarn-site.xml

<configuration>元素下增加

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.auxservices.mapreduce.shuffle.class</name>

<value>org.apache.hadoop.mapred.ShuffleHandler</value>

</property>

<property>

<name>yarn.resourcemanager.address</name>

<value>localhost:8032</value>

</property>

<property>

<name>yarn.resourcemanager.scheduler.address</name>

<value>localhost:8030</value>

</property>

<property>

<name>yarn.resourcemanager.resource-tracker.address</name>

<value>localhost:8031</value>

</property>

<property>

<name>yarn.resourcemanager.admin.address</name>

<value>localhost:8033</value>

</property>

<property>

<name>yarn.resourcemanager.webapp.address</name>

<value>localhost:8088</value>

</property>注意:

(1)为了配置方便,可以在hosts文件中增加host,替换掉上述配置文件中的localhost

(2)slaves是对于slaver的配置信息,在配置集群时可以添加对应slaver的host信息,由于是单机环境,localhost既是namenode又是datanode,所以slaves中有localhost文本

4、启动hadoop进行测试

cd ${HADOOP_HOME}/sbin

./start-all.sh(相应的关闭hadoop使用stop-all.sh命令)

之后可用jps命令查看hadoop的启动状态,确保namenode和datanode都成功启动,否则后面报错

5、格式化hdfs

cd ${HADOOP_HOME}/bin

./hdfs namenode -format

测试hadoop-mapreduce-examples-2.7.1.jar,功能为统计文本中的单词数量

1、在hdfs文件系统根目录创建input文件夹

cd ${HADOOP_HOME}/bin

./hadoop fs -mkdir /input(在hdfs文件系统中创建input文件夹)

./hadoop fs -ls /(查看文件夹是否被创建)

2、将txt文件上传到hdfs中

/data/temp/text1.txt

hello hadoop,this is my first hadoop demo

./hadoop fs -put /data/temp/text1.txt /input

./hadoop fs -ls /input(查看文件是否上传)

运行测试jar

./hadoop jar ../share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.1.jar wordcount /input /output

./hadoop fs -ls /output(运行完毕查看输出文件夹output,如果报错请自行排错)

./hadoop fs -cat /output/part-r-00000(查看输出结果)

至此,hadoop单机环境搭建完成。

921

921

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?