lecture 6:主元分析PCA

目录

1PCA思想

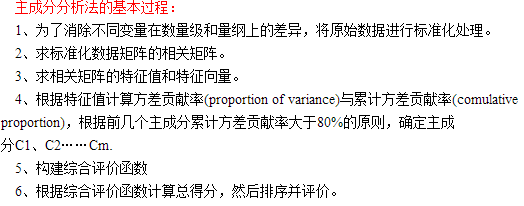

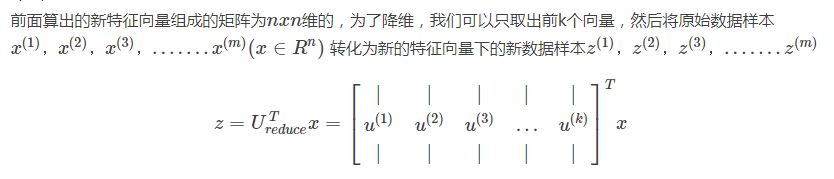

- PCA通过线性变换将原始数据,变换为一组各维度线性无关的表示

PCA通过原变量的线性组合,寻找一组能最大限度携带原变量的有用信息,且相互不相关的一组新变量,一般通过主元回归检验法、主元贡献率累积和百分比法来确定新变量个数,即降维后样本的维数。

LDA与PCA的比较

(1)PCA与LDA非常类似,LDA输入数据带标签,是有监督的学习,LDA可以作为独立算法存在,给定训练数据得到判别函数,对数据预测。

(2)PCA输入数据不带标签,是无监督的学习,数据预处理方法,将原始数据降低维度,降维后的数据之间方差最大(投影误差最小)

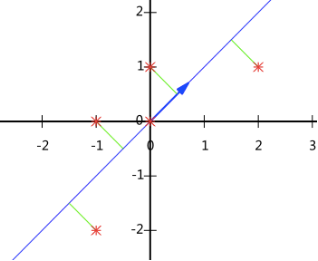

有一组N维向量,降到K维(K 小于N),如何选择K个基,才能最大程度的保留原有信息

选择一个方向,所有数据投影到这个方向的直线上,用投影值表示原始记录,二维降到一维,希望投影后的投影值尽可能分散,寻找一组基,使得所有数据,变换为这个基上的坐标表示后,方差最大

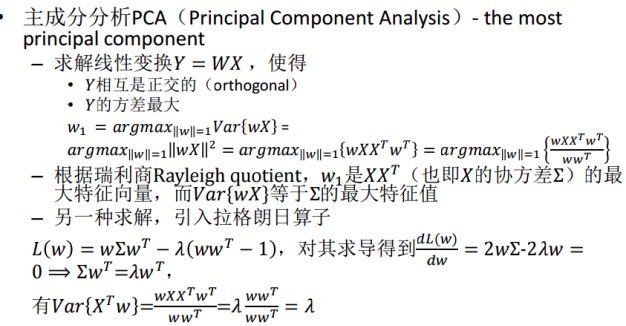

2最大方差法

3PCA一般步骤

(1)数据预处理,消除数据在数量级和量纲上的差异,且进行零均值化

(2)m个n维样本,求出协方差矩阵

C=1mXXT

C

=

1

m

X

X

T

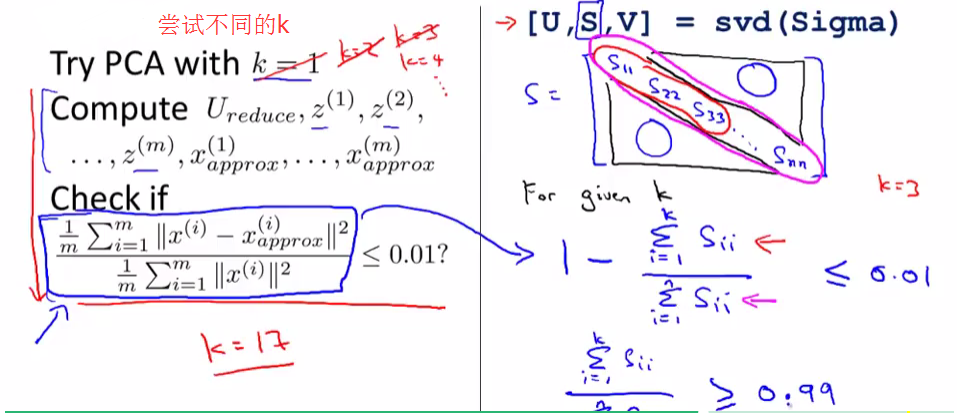

(3)求出C的特征值,特征向量,将特征值排序

(4)选出前面最大的几个特征值,其和占所有特征值和的80%以上,找出对应的特征向量组成矩阵P

(5)Y=PX即为降维后的数据

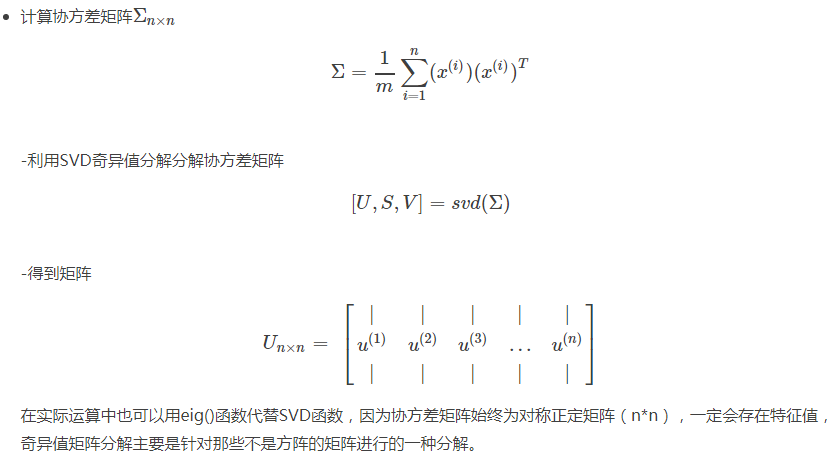

4PCA协方差SVD分解

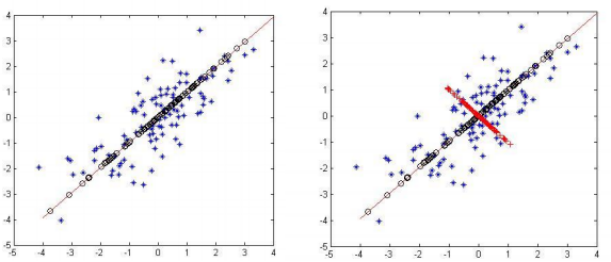

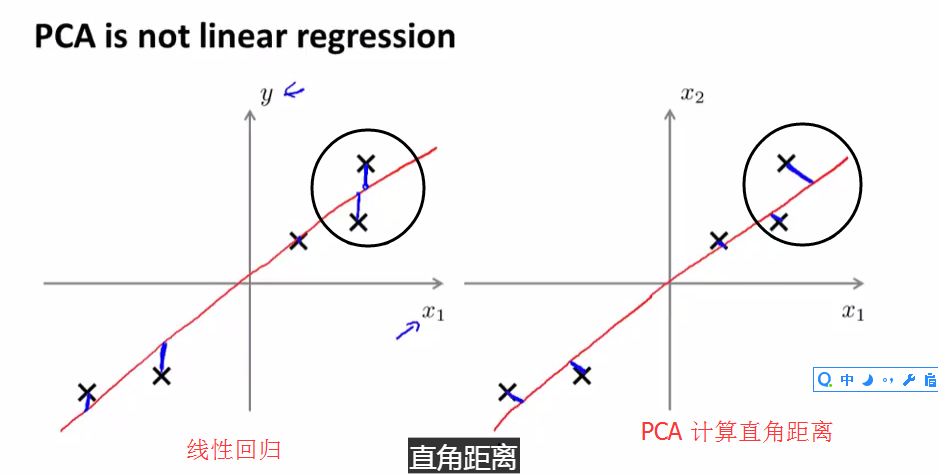

下面介绍线性回归与2维PCA的区别:虽然都是找一条直线去拟合但是计算loss的方式不同(垂直),PCA没有标签Y(非监督)。

- PCA和LR是不同的算法,PCA计算的是投影误差,而LR计算的是预测值与实际值的误差。 PCA中只有特征没有标签数据y,LR中既有特征样本也有标签数据。

- 求出协方差矩阵的特征值及对应的特征向量(使用svd函数)。

- 特征向量最能代表原数据

SVD可以分解不是方阵的矩阵

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?