最近还是在搞GCN,使用GCN处理EEG,结果做出来了,我们需要对模型结果进行解释,那如何解释呢?从模型原理公式和数据塑造上解释:

论文:

Towards Robust Fidelity for Evaluating Explainability of Graph Neural Networks

作者:

Xu Zheng1∗, Farhad Shirani1∗, Tianchun Wang2, Wei Cheng3, Zhuomin Chen1, Haifeng Chen3,Hua Wei4, Dongsheng Luo1

学校:

-

Florida International University;

-

Pennsylvania State University

-

NEC Laboratories America

-

Arizona State University

本文中了2024年的ICLR!

BACKGROUND:

如何评估解释子图的quality是 Explainable GNNs中一个重要问题。 现有的评估方法通常有两种,一通过和Ground Truth (GT)进行比较,二为通过Fidelity进行评估。 Fidelity核心思想是比较子图预测结果和原图预测结果的差异。 本文展示了Fidelity指标 (包括 、Fid+、Fid-、Fid. )固有的局限性。原因是在计算Fidelity的时候忽略了子图和原图的分布差异(Out-of-Distribution, OOD),导致了子图的预测结果并不可靠。 为解决这一问题,本文提出了一类 robust Fidelity指标,理论分析表明该指标能有效缓解 OOD 带来的影响。 文中使用合成数据集和真实数据集进行试验验证,实验结果表明本文提出的 robust Fidelity 指标与 gold standard metrics保持一致。

论文地址[1]:https://openreview.net/forum?id=up6hr4hIQH

项目地址:https://trustai4s-lab.github.io/fidelity.html

代码地址:https://github.com/AslanDing/Fidelity

Explaining Deep Learning Models:

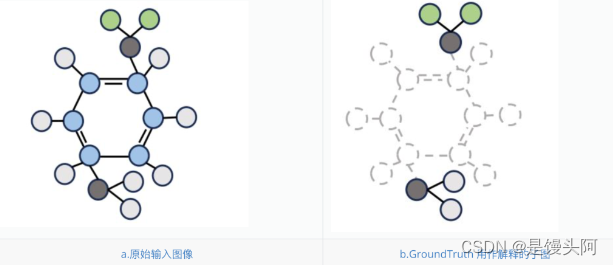

可解释的人工智能可以帮助我们理解模型如何做出预测。在graph中,解释通常是子图,例如 Mutag 数据集中的 NH2 和 NO2。在 NLP 任务中,解释是最重要的词。对于时间序列,解释是时间戳。在图像中,解释是模型关注的前景。在本文中,我们首先介绍我们在graph上的方法。下图展示了在 Mutag 数据集中,什么是原始图和用作解释的子图[2]。

Fidelity and Out-of-Distribution (OOD) Issues:

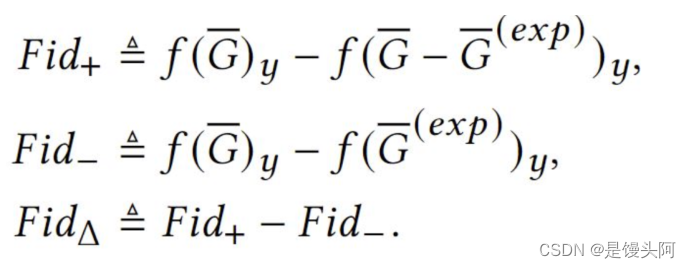

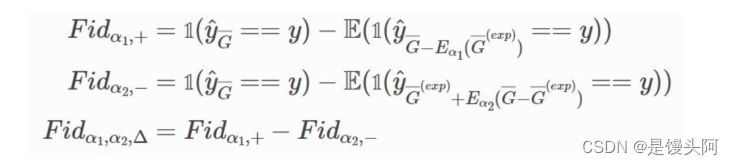

在Explainable GNNs领域,Fidelity 是用来评估可解释子图最常用的指标。 直观的想法是,如果用作解释的子图对于预测模型很重要,则意味着 1)去掉这部分子图会对预测结果产生较大影响。 2)模型可以只从该子图中推断出预测结果。 基于这个想法,其数学表达式如下:

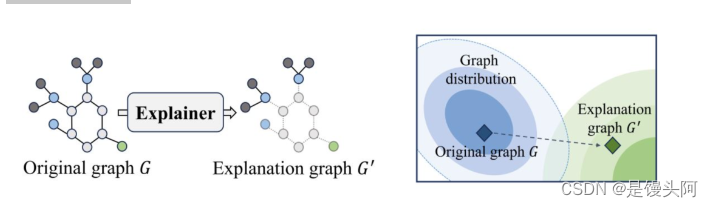

其中,f 是要解释的GNN模型。 G是输入图, Gexp是用作解释的子图。 根据该定义,我们可以看到 f 被用来预测子图的label。这种用法会导致OOD问题,即子图和 f 的训练集分布不同,从而导致结果的不可靠,在同期工作也有提及该问题,如OAR[3] 和 GInx-eval[4]。 我们使用下面一张图来说明这一现象[2]。

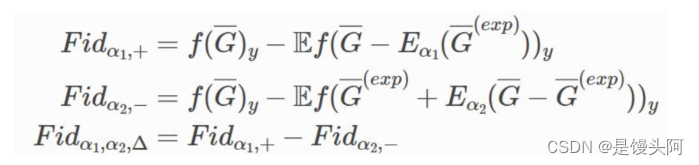

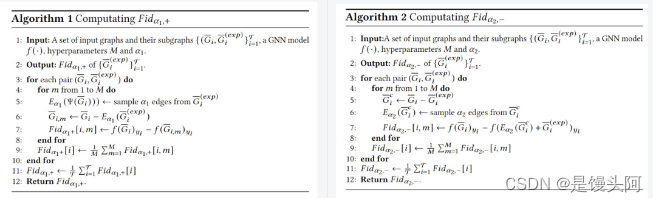

为了缓解OOD 问题对 Fidelity 的影响,本文引入了一个新的指标,即robust Fidelity 。在该方法中,通过使用随机删除部分可解释/非可解释子图来缓解OOD问题,并使用随机采样来近似无OOD的结果。在该方法中,使用超参数 来控制每次删除边的概率。基于此,robust Fidelity 的数学形式可以表示为如下

类似地,我们可以得到基于准确性的robust Fidelity :

该算法的流程可以总结如下:

Experiment:

文中我们使用了两个图分类数据和节点分类数据. 实验以 GT 可解释子图作为基准,用不同的Edit Distanace的样本求robust Fidelity 和 Fidelity 。Edit Distanace大意味着可解释子图与GT之间差距大,子图的解释准确性就越差。 所以一个好的 Fid+应该与 Edit Distanace 负相关, Fid-则是正相关。 通过Spearman相关系数实验结果可以看出,原本的 idelity 在图分类和点分类任务中的表现并不一致。但robust Fidelity 在绝大多数情况下保持了高度的一致性。

通过实验表明,本文提出的robust 能够更好的反应可解释子图是否忠于模型。更多实验结果请参考论文。

Conclusion:

这个工作分析了Fidelity 作为指标的问题,并提出了robust Fidelity 缓解该问题,通过理论和实验进行分析验证该方法的有效性。

Reference

[1]. Zheng, Xu, et al. "Towards robust fidelity for evaluating explainability of graph neural networks." arXiv preprint arXiv:2310.01820 (2023).

[2]. Chen, Zhuomin, et al. "Interpreting Graph Neural Networks with In-Distributed Proxies." arXiv preprint arXiv:2402.02036 (2024).

[3]. Fang, Junfeng, et al. "Evaluating post-hoc explanations for graph neural networks via robustness analysis." Advances in Neural Information Processing Systems 36 (2024).

[4]. Amara, Kenza, Mennatallah El-Assady, and Rex Ying. "GInX-Eval: Towards In-Distribution Evaluation of Graph Neural Network Explanations." arXiv preprint arXiv:2309.16223 (2023).

本文探讨了图神经网络可解释性中的Fidelity问题,指出其在评估子图质量时忽视了分布差异。作者提出了robustFidelity指标,通过随机操作减少OOD影响,并通过实验验证其在各类任务中的稳健一致性。

本文探讨了图神经网络可解释性中的Fidelity问题,指出其在评估子图质量时忽视了分布差异。作者提出了robustFidelity指标,通过随机操作减少OOD影响,并通过实验验证其在各类任务中的稳健一致性。

1502

1502

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?