随着上一代库存逐渐清理到位,苏妈与老黄终于要把新一代主流级显卡掏出来了。

根据外网消息,AMD 这边主要是 RX 7600XT 与 7600 等型号,发布日期定为 5 月 25 日。

AMD 保密措施做得挺到位的,目前除了部分厂商爆出的包装与产品图外,详细规格暂时了解并不多。

来源:videocardz

据说 RX 7600 具有 32 个 RDNA 3 计算单元、2048 个流处理器、8G GDDR6 显存。

来源:videocardz

整体规格相比上代 RX 6600 并没有什么实质性提升,妥妥的挤牙膏了。

咱开个价,249 美元,希望 AMD 不要不识好歹!

NVIDIA 这边已确定 5 月 24 日发布 RTX 4060 Ti 8G。

原本计划日期是 5 月 29 日来着,就为了比 AMD 提前这么一天,硬是改成了 24 日。

不管你俩咋相爱相杀,反正咱消费者不介意早点看到产品。

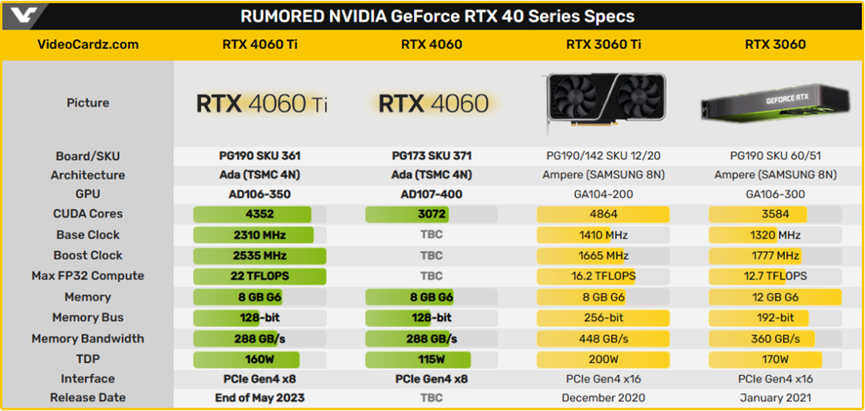

RTX 4060 Ti 规格咱们之前讲过,在老黄倒吸牙膏操刀下果然没让我们失望。

来源:videocardz

CUDA 核心数大砍,显存位宽阉割麻了,大家也有吐槽这个级别显卡仍用的 8G 显存。

不过似乎是为了回应玩家需求?老黄随后又整出了 RTX 4060 Ti 16GB 版。

来源:videocardz

当然也仅限于增加显存容量,CUDA 数量不变,显存位宽依然是可怜的 128-bit。

核心从 4060 Ti 8G 的 AD 106 - 350 换成了 AD 106 – 351,功耗可能会增加那么一丢丢。

RTX 4060 Ti 16G 版上市日期则推迟在 7 月份,预计与 RTX 4060 同一节点。

另外根据 VideoCards 爆料,RTX 4060 三款显卡首次在 PCIe 接口上砍了一刀,仅支持 8 通道。

例如隔壁 AMD RX6600XT 为 PCIe 4.0 * 8 通道,RX6500XT 甚至为 4 通道。

NVIDIA 这边倒还是第一次出现对 PCIe 通道下手。

虽说 PCIe 4.0 * 8 带宽也能 RTX 4060 Ti 这个级别显卡需求。

但要放在 PCIe 3.0 主板上就会降级为 PCIe 3.0 * 8,性能多少会受到些影响。

这么做的好处只有一个,节省成本!

这节省下来的成本能不能体现在最终售价上,这就不得而知了。

AMD计划于5月25日发布RX7600XT和7600显卡,规格相比上代RX6600变化不大。NVIDIA的RTX4060Ti则提前至5月24日发布,包括8GB和16GB版本,CUDA核心减少,显存位宽被削减。RTX4060Ti16GB版和RTX4060可能在7月上市,且新款RTX4060系列显卡首次采用PCIe4.0*8通道,节省成本但可能影响性能。

AMD计划于5月25日发布RX7600XT和7600显卡,规格相比上代RX6600变化不大。NVIDIA的RTX4060Ti则提前至5月24日发布,包括8GB和16GB版本,CUDA核心减少,显存位宽被削减。RTX4060Ti16GB版和RTX4060可能在7月上市,且新款RTX4060系列显卡首次采用PCIe4.0*8通道,节省成本但可能影响性能。

4233

4233

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?