今天上班,接着昨天的工作继续往下安装

1.Ranger-usersync的安装配置

cp/opt/incubator-ranger/target/ranger-0.6.0-SNAPSHOT-usersync.tar.gz /opt/

cd /opt

tar –zxvf ranger-0.6.0-SNAPSHOT-usersync.tar.gz

cd ranger-0.6.0-SNAPSHOT-usersync

#打开usersync Plugin里install.properties文件,修改参数的值如下所示:

vi install.properties

POLICY_MGR_URL=http://localhost:6080

SYNC_SOURCE=unix

#同步周期,1分钟

SYNC_INTERVAL=1

logdir=/var/log/ranger/usersync

#安装usersync Plugin

./setup.sh

#启用usersync Plugin插件

./ranger-usersync-services.sh start

2.HDFS-Plugin的安装配置

cp/opt/incubator-ranger/target/ranger-0.6.0-SNAPSHOT-hdfs-plugin.tar.gz /opt

cd /opt

tar –zxvf ranger-0.6.0-SNAPSHOT-hdfs-plugin.tar.gz

cd ranger-0.6.0-SNAPSHOT-hdfs-plugin

#打开HDFS Plugin里install.properties文件,修改参数的值如下所示:

vi install.properties

POLICY_MGR_URL=http://localhost:6080

SQL_CONNECTOR_JAR=/usr/share/java/mysql-connector-java.jar

REPOSITORY_NAME=hadoopdev

XAAUDIT.DB.IS_ENABLED=true

XAAUDIT.DB.FLAVOUR=MYSQL

XAAUDIT.DB.HOSTNAME=localhost

XAAUDIT.DB.DATABASE_NAME=ranger_audit

XAAUDIT.DB.USER_NAME=root

XAAUDIT.DB.PASSWORD=root

#组件对应的用户,这里设置为空.一般Hadoop的内置用户是HDFS或则hadoop

CUSTOM_USER=root

CUSTOM_GROUP=root

#启用HDFS Plugin插件

[root@localhost ranger-0.5.0-hdfs-plugin]#./enable-hdfs-plugin.sh

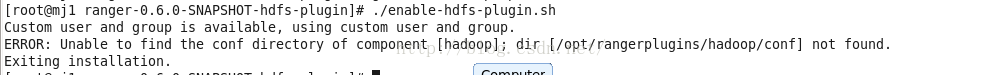

出现以下错误:

注:这里报错,需要额外将HADOOP的conf做个软连接到/root/hadoop/conf.

ln -s /opt/hadoop-2.7.2/etc/hadoop/ /opt/rangerplugins/hadoop/conf

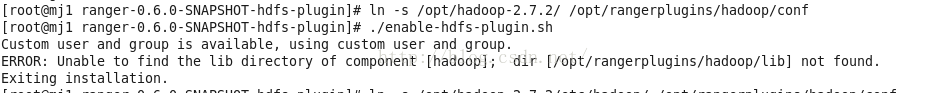

之后出现了如下错误:

#这里需要将HDFS Plugin内的jar和HADOOP包含的HDFS jar都指向/root/hadoop/lib

cp /opt/ranger-0.6.0-SNAPSHOT-hdfs-plugin/lib/ranger-hdfs-plugin-impl/*.jar /opt/hadoop-2.7.2/share/hadoop/hdfs/lib/

mkdir /opt/hadoop/lib

ln -s /opt/hadoop-2.7.2/share/hadoop/hdfs/lib/ /opt/hadoop/lib/m

#再一次启用HDFS Plugin插件

[root@localhost ranger-0.5.0-hdfs-plugin]# ./enable-hdfs-plugin.sh

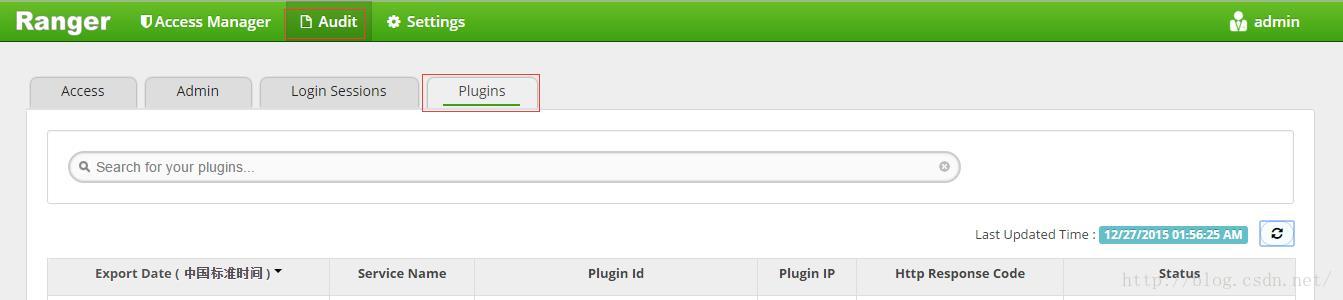

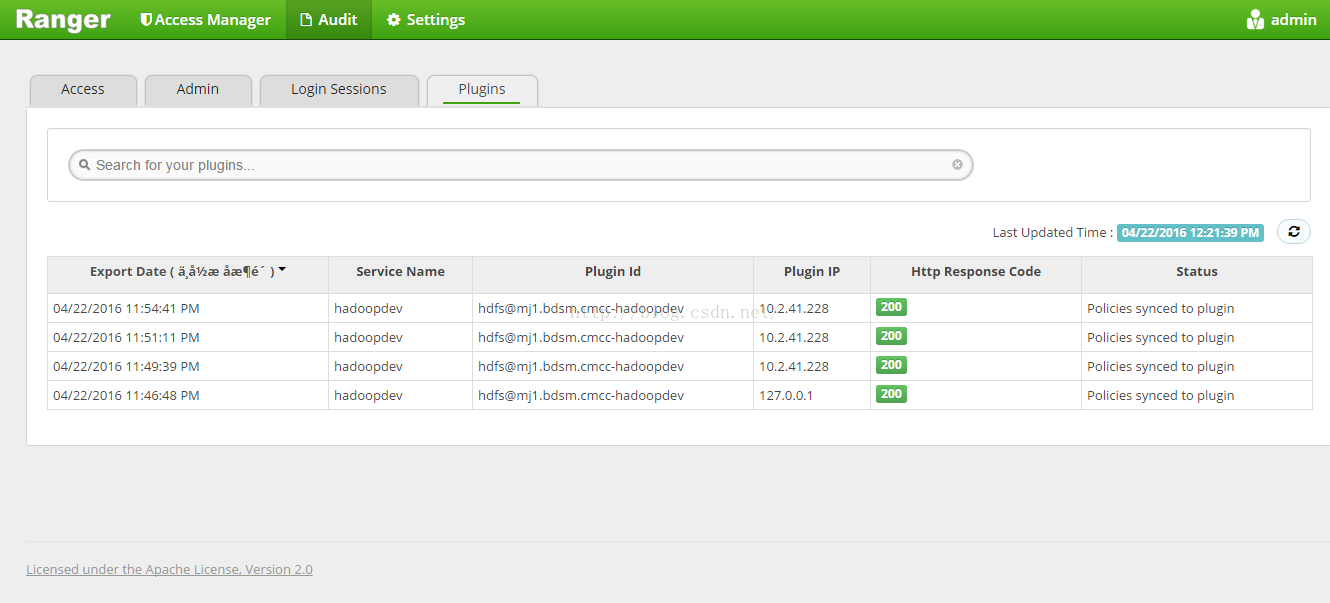

#验证HDFS Plugin服务,这时登录Ranger的管理员界面验证下HDFS plugin是够加载成功,发现并没有.

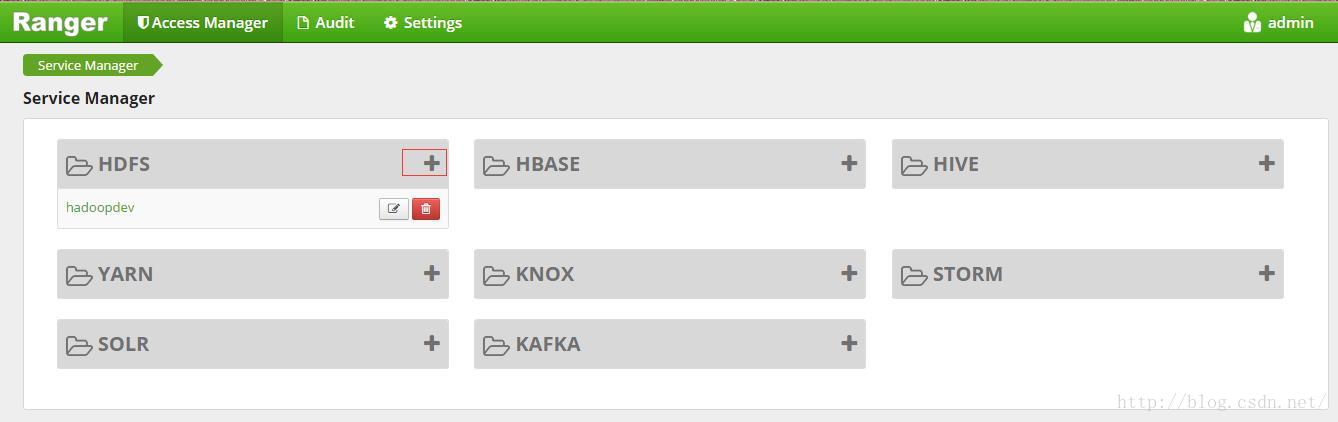

原因是安装HDFS plugin时install.properties文件里定义的REPOSITORY_NAME(值为hadoopdev)并未通过Ranger Admin在HDFS插件里的服务管理里注册成服务(名hadoopdev).

解决方案:

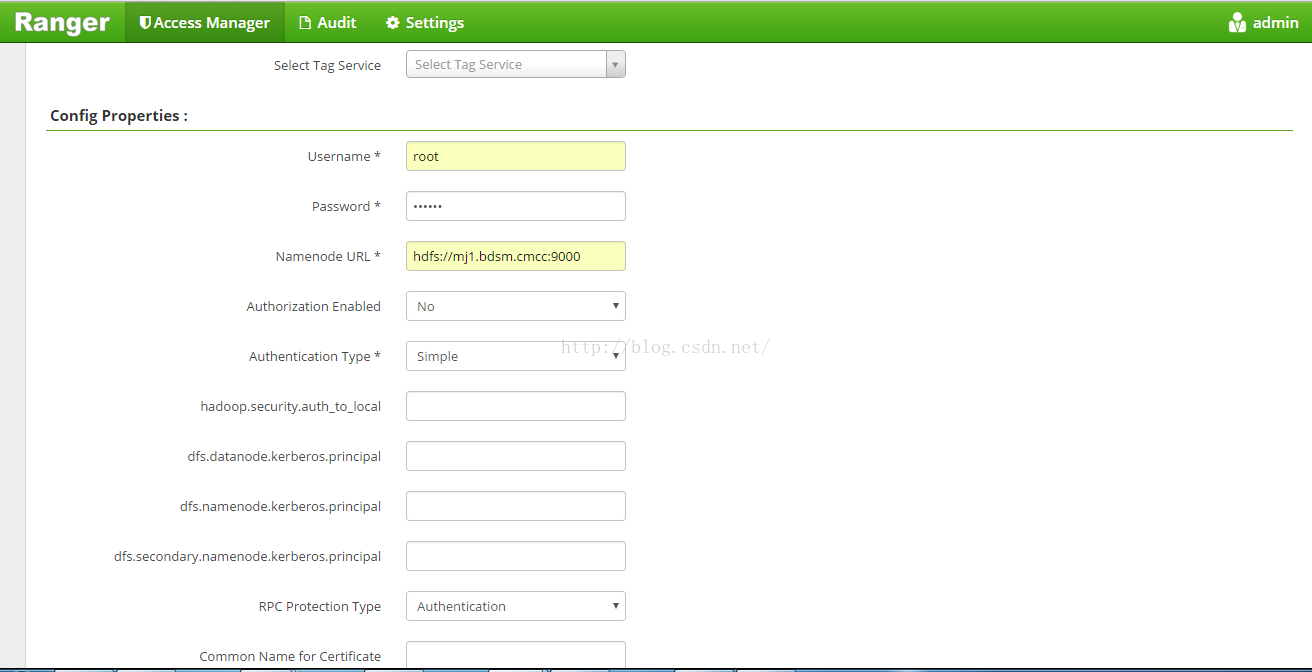

1 登录Ranger Adming

2 点击HDFS plugin的添加按钮

3 定义服务名为hadoopdev,提交其它信息后保存

注意上面的Username和Password为系统登录的用户名和密码(我这里也是ssh登录hadoop的用户名和密码)

Namenode URL 填的是hadoop目录下的etc/hadoop/core-site.xml文件中的

<name>fs.defaultFS</name>

<value>hdfs://mj1:9000</value>

</property>

#再次验证HDFS plugin插件,则发现已经正常加载

注:

1 如果没有安装和开启Ranger-usersync服务的情况下直接测试HDFS赋权权限是不成功的.

2 Ranger Admin的日志文件见 /root/ranger-0.5.0-admin/ews/logs/xa_portal.log

403

403

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?