关注公众号,发现CV技术之美

▊ 写在前面

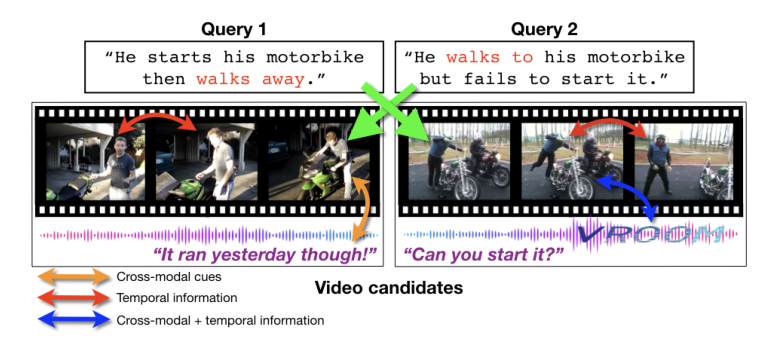

检索与自然语言查询相关的视频内容对于有效处理互联网规模的数据集起着关键作用。现有的大多数文本到视频检索方法都没有充分利用视频中的跨模态线索。此外,它们以有限或没有时间信息的方式聚合每帧视觉特征。

在本文中,作者提出了一种多模态Transformer(MMT)来对视频中的不同模态进行联合编码,从而允许它们中的每一帧关注其他模态。此外,Transformer架构还用于对时间信息进行编码和建模。通过实验表明,本文提出的多模态Transformer能够在多个数据集上实现SOTA的视频检索性能。

▊ 1. 论文和代码地址

Multi-modal Transformer for Video Retrieval

论文地址:https://arxiv.org/abs/2007.10639

代码地址:https://github.com/gabeur/mmt

▊ 2. Motivation

视频是目前最受欢迎的媒体形式之一,因为它能够捕捉动态事件,并自然地吸引人类的视觉和听觉感官。在线视频平台在推动这种媒体形式方面发挥着重要作用。

然而,如果不能有效地访问这些平台上数十亿小时的视频,例如通过查询检索相关内容,那么这些平台上的视频将无法使用。

在本文中,作者解决了文本到视频和视频到文本的检索任务。在文本到视频的检索任务中,给定一个文本形式的查询,目标是检索能够最好描述它的视频。

实际上,给定文本-视频对的测试集,模型的目标是为每个文本查询提供所有候选视频的排名,以便与文本查询相关联的视频的排名尽可能高。另一方面,视频到文本检索的任务侧重于在文本候选集合中找到最能描述查询视频的候选文本。

检索问题的一种常见方法是相似性学习,即学习衡量两个元素(查询和候选元素)相似性的函数。然后,可以根据与查询的相似性对所有候选对象进行排序。为了执行该排序,文本以及视频被表示在公共多维嵌入空间中,其中相似性可以被计算为其相应表示的点积。这里的关键问题是如何学习文本和视频的精确表示,以建立相似性估计。

文本的学习表征问题已经得到了广泛的研究,可用于对文本进行编码。与这些进步相反,学习有效的视频表

本文提出了一种多模态Transformer(MMT),用于视频检索,结合字幕、音频和视频信息,解决了现有方法在跨模态线索利用和时间信息处理上的不足。MMT通过Transformer架构对视频的多模态和时间信息进行建模,实现了在多个数据集上的SOTA性能。代码已开源。

本文提出了一种多模态Transformer(MMT),用于视频检索,结合字幕、音频和视频信息,解决了现有方法在跨模态线索利用和时间信息处理上的不足。MMT通过Transformer架构对视频的多模态和时间信息进行建模,实现了在多个数据集上的SOTA性能。代码已开源。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?