CNN-LSTM-Attention基于卷积-长短期记忆神经网络结合注意力机制的数据分类预测 Matlab语言

程序已调试好,无需更改代码直接替换Excel即可运行

1.多特征输入,LSTM也可以换成GRU、BiLSTM,Matlab版本要在2020B及以上。

2.特点:

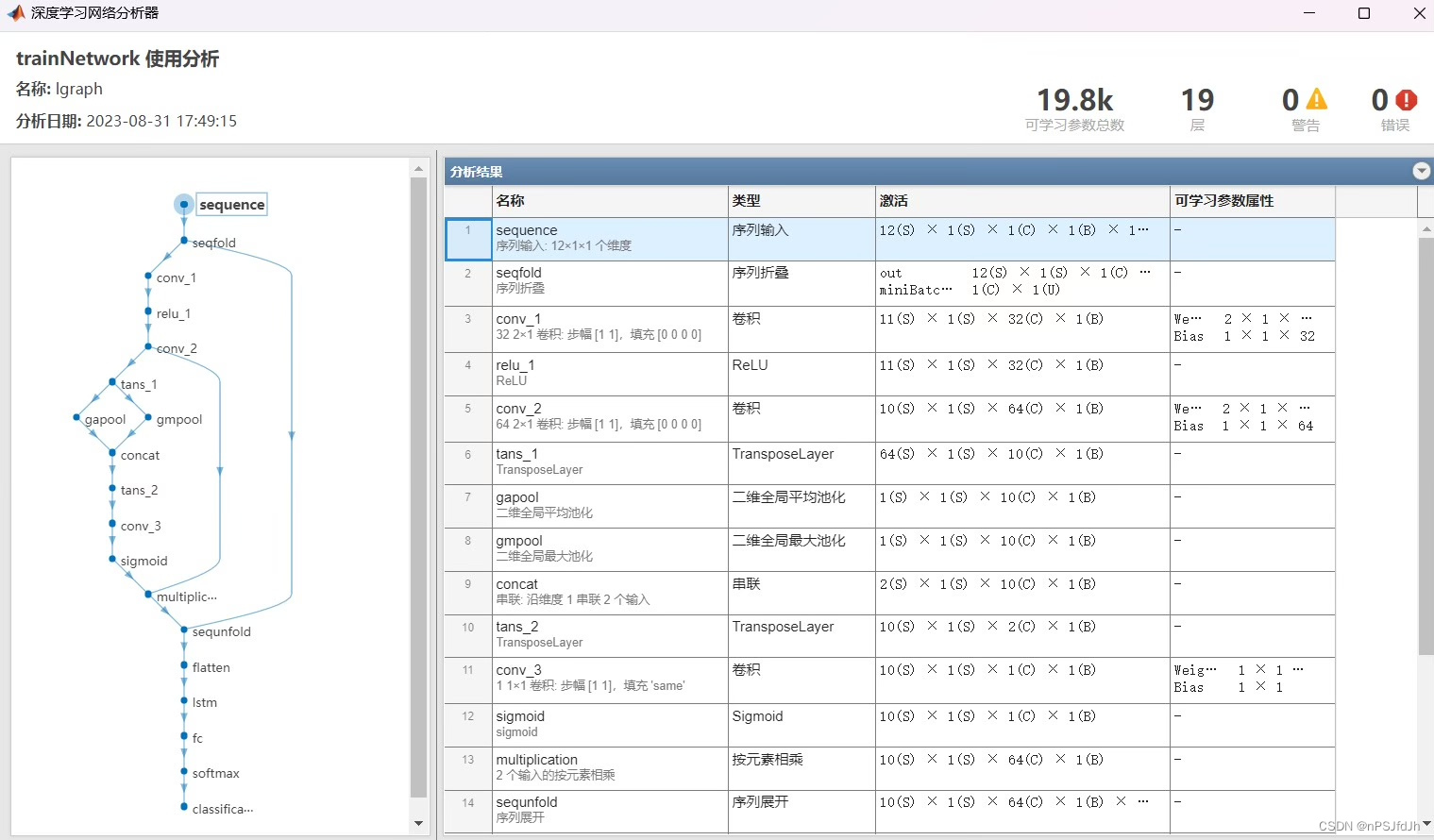

[1]卷积神经网络 (CNN):捕捉数据中的局部模式和特征。

[2]长短期记忆网络 (LSTM):处理数据捕捉长期依赖关系。

[3]注意力机制:为模型提供了对关键信息的聚焦能力,从而提高预测的准确度。

3.直接替换Excel数据即可用,注释清晰,适合新手小白

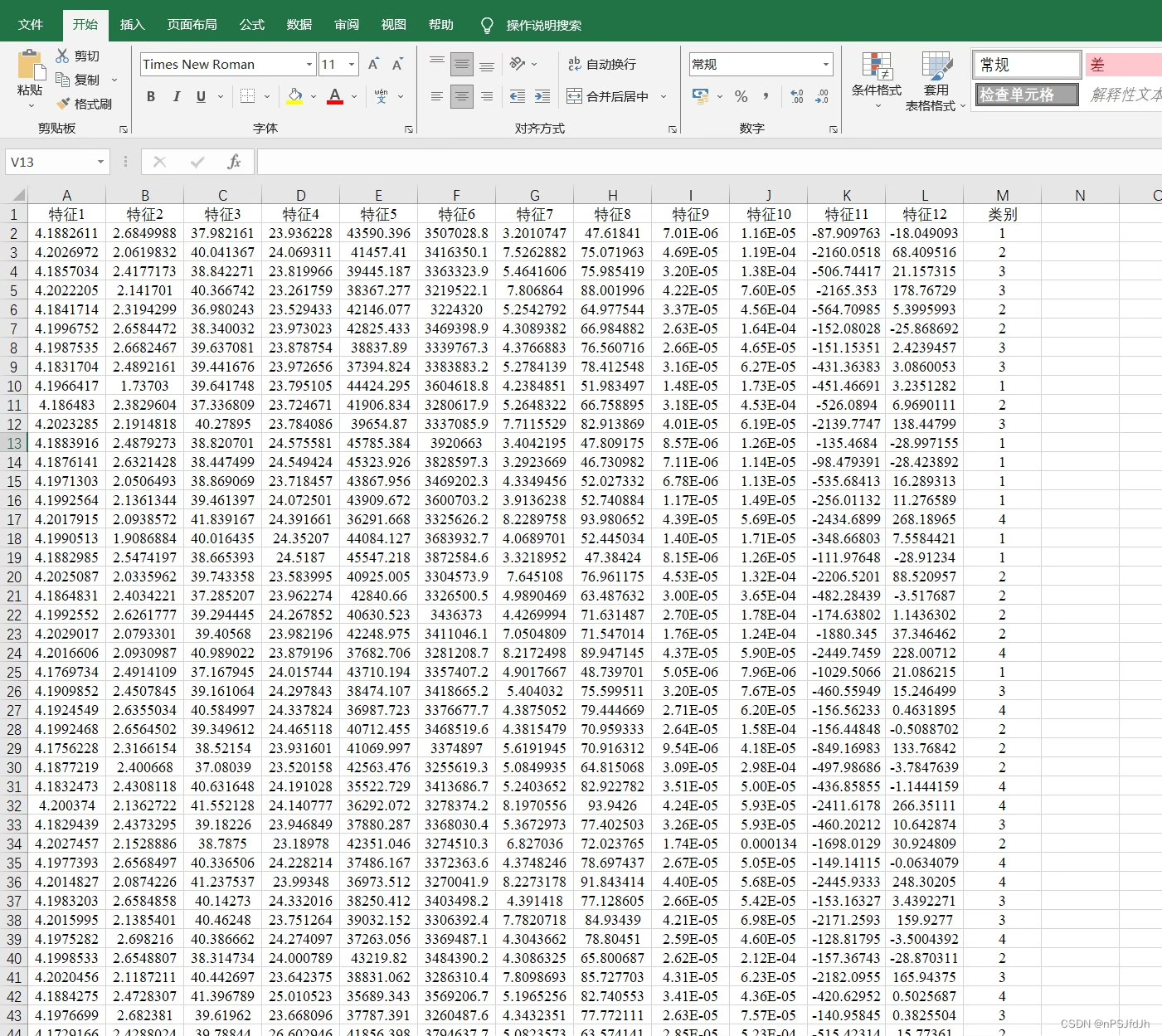

4.附赠测试数据,输入格式如图3所示,可直接运行

5.仅包含模型代码,价格不包含讲解

6.模型只是提供一个衡量数据集精度的方法,因此无法保证替换数据就一定得到您满意的结果

标题:基于CNN-LSTM-Attention的数据分类预测方法及其实现

摘要:本文介绍了一种基于卷积神经网络 (CNN)、长短期记忆网络 (LSTM)和注意力机制的数据分类预测方法,采用Matlab语言实现。该方法具备多特征输入的能力,且可灵活替换LSTM为GRU或BiLSTM。文章首先介绍了该方法的特点和基本原理,然后详细说明了如何使用该方法进行数据分类预测,包括代码替换和数据格式要求等。最后,文章提供了测试数据和运行结果,以供读者参考。

一、引言

数据分类预测是机器学习和数据挖掘领域的重要应用之一。随着卷积神经网络和长短期记忆网络的发展,结合注意力机制的CNN-LSTM-Attention模型成为了一种有效的方法。本文将重点介绍基于该模型的数据分类预测方法,并提供相应的实现代码。

二、方法介绍

2.1 卷积神经网络 (CNN)

CNN是一种深度学习算法,主要用于捕捉数据中的局部模式和特征。它通过卷积和池化操作将输入数据转化为高级抽象特征,以提取更有效的信息。

2.2 长短期记忆网络 (LSTM)

LSTM是一种循环神经网络,能够处理数据之间的长期依赖关系。它通过遗忘门、输入门和输出门的控制,有效地捕捉数据中的时序信息,从而提高预测的准确度。

2.3 注意力机制

注意力机制为模型提供了对关键信息的聚焦能力,从而进一步提高预测的准确度。通过对不同时间步的特征进行权重分配,注意力机制能够自适应地选择对分类预测最有贡献的特征。

三、数据分类预测方法实现

3.1 环境需求

为了能够成功运行该方法,需要使用Matlab语言,并且版本要在2020B及以上。

3.2 多特征输入和模型替换

该方法支持多特征输入,读者可以根据自己的数据情况进行相应的调整。此外,LSTM也可以替换为GRU或BiLSTM,以便更好地适应不同的数据特征。

3.3 数据替换和运行

使用该方法进行数据分类预测非常简单。只需将待分类的数据替换Excel表格中的数据,并按照注释要求进行格式设置。然后,直接运行代码即可获得预测结果。

四、实验结果与分析

为了验证该方法的有效性,我们提供了附赠的测试数据,并展示了输入格式和运行结果。通过对比真实标签和预测标签,我们可以评估该方法的分类准确度。

五、总结与展望

本文介绍了一种基于CNN-LSTM-Attention的数据分类预测方法,并提供了Matlab语言实现代码。该方法通过将卷积神经网络、长短期记忆网络和注意力机制相结合,能够有效地捕捉数据的局部特征和时序信息,并提高预测的准确度。实验结果表明,该方法在数据分类预测任务中具备良好的性能。未来的研究可以进一步优化该方法,并应用于更广泛的领域中。

以上是关于基于CNN-LSTM-Attention的数据分类预测方法及其实现的介绍。希望本文能给读者带来一定的帮助和启发,欢迎与我们分享更多关于数据分类预测的讨论和交流。

相关代码,程序地址:http://lanzoup.cn/740736860855.html

1070

1070

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?