- 广义线性分布(包括线性回归,逻辑回归)首先假设预测变量 Y Y Y服从指数分布族的分布。像线性回归就是假设了 Y Y Y服从了高斯分布。而逻辑回归假设变量服从伯努利分布。

- 指数分布族的概率密度函数为

P ( Y , η ) = b ( Y ) e ( η T T ( Y ) − a ( η ) ) P(Y, \eta)=b(Y) e^{\left(\eta^{T} T(Y)-a(\eta))\right.} P(Y,η)=b(Y)e(ηTT(Y)−a(η))

其中 ϕ \phi ϕ为分布的参数,T(Y)称为充分统计量(一般为Y)

1)线性回归

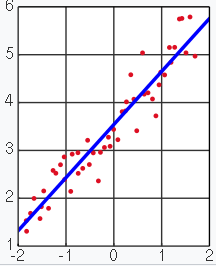

- 定义:利用线性回归方程的最小二乘函数对自变量x与因变量y之间关系进行建模的回归分析(参考wiki)。

- 最小二乘法:一种数学优化技术,它通过最小化误差的平方和寻找数据的最佳函数匹配。

- 线性回归方程:

Y = W T X Y = W^TX Y=WTX

其中X可以包含偏置 b b b。 - 最优化方法:

- 非数值方法,直接对矩阵求导

从贝叶斯的角度看待线性回归

- 线性回归可以看成是一种极大似然估计(极大似然估计(MLE)是一种估计参数的方法,MLE假设已经知道随机样本服从的分布但不知道分布的参数,根据当前样本去求使当前样本出现的最大概率的分布参数,即使 P ( W ∣ X ) P(W|X) P(W∣X)最大)。

- 我们首先假设Y服从高斯分布

N

(

μ

,

1

)

N(\mu,1)

N(μ,1),则Y的概率密度可以转换成指数分布族的一般形式:

P ( Y , η ) = 1 2 π e − ( Y − μ ) 2 2 = 1 2 π e − γ 2 2 + μ Y − μ 2 2 = 1 2 π e − Y 2 2 e μ Y − μ 2 2 \begin{aligned} P(Y, \eta) &=\frac{1}{\sqrt{2 \pi}} e^{-\frac{(Y-\mu)^{2}}{2}} \\ &=\frac{1}{\sqrt{2 \pi}} e^{-\frac{\gamma^{2}}{2}+\mu Y-\frac{\mu^{2}}{2}} \\ &=\frac{1}{\sqrt{2 \pi}} e^{-\frac{Y^{2}}{2}} e^{\mu Y-\frac{\mu^{2}}{2}} \end{aligned} P(Y,η)=2π1e−2(Y−μ)2=2π1e−2γ2+μY−2μ2=2π1e−2Y2eμY−2μ2

显然, b ( Y ) = 1 2 π e − Y 2 2 b(Y)=\frac{1}{\sqrt{2 \pi}} e^{-\frac{Y^{2}}{2}} b(Y)=2π1e−2Y2, η = μ \eta=\mu η=μ, T ( Y ) = Y T(Y)=Y T(Y)=Y - 线性回归假设Y服从分布参数为

μ

=

η

=

ω

T

X

\mu=\eta=\omega^TX

μ=η=ωTX的高斯分布

N

(

μ

,

1

)

N(\mu, 1)

N(μ,1),则参数W的似然函数为

log ∏ i = 1 N 1 2 π ∗ e − ( y i − ω T x i ) 2 / 2 \log \prod_{i=1}^{N} \frac{1}{\sqrt{2 \pi}} * e^{-\left(y_{i}-\omega^{T} x_{i}\right)^{2} / 2} logi=1∏N2π1∗e−(yi−ωTxi)2/2

将似然函数变形,去掉常数项以后得

∑ i = 1 N − ( y i − ω T x i ) 2 \sum_{i=1}^{N}-\left(y_{i}-\omega^{T} x_{i}\right)^{2} i=1∑N−(yi−ωTxi)2

然后优化问题就可以变为

max ∑ i = 1 N − ( y i − ω T x i ) 2 = min ∑ i = 1 N ( y i − ω T x i ) 2 \max \sum_{i=1}^{N}-\left(y_{i}-\omega^{T} x_{i}\right)^{2}=\min \sum_{i=1}^{N}\left(y_{i}-\omega^{T} x_{i}\right)^{2} maxi=1∑N−(yi−ωTxi)2=mini=1∑N(yi−ωTxi)2

2)逻辑回归

- Y服从参数为

ϕ

\phi

ϕ的伯努利分布,因此

P ( Y , ϕ ) = ϕ Y ( 1 − ϕ ) ( 1 − Y ) = e Y log ( ϕ ) + ( 1 − Y ) log ( 1 − ϕ ) = e ( Y log ( ϕ / ( 1 − ϕ ) ) + log ( 1 − ϕ ) ) P(Y,\phi) = \phi ^ {Y}(1-\phi)^{(1-Y)}=e^{Y\log(\phi)+(1-Y)\log(1-\phi)}=e^{(Y\log(\phi/(1-\phi))+\log(1-\phi))} P(Y,ϕ)=ϕY(1−ϕ)(1−Y)=eYlog(ϕ)+(1−Y)log(1−ϕ)=e(Ylog(ϕ/(1−ϕ))+log(1−ϕ))

显然, b ( Y ) = 1 b(Y)=1 b(Y)=1, T ( Y ) = Y T(Y)=Y T(Y)=Y, η = log ( ϕ / ( 1 − ϕ ) ) \eta=\log(\phi/(1-\phi)) η=log(ϕ/(1−ϕ))。逻辑回归假设分布参数为 η = ω T X \eta=\omega^TX η=ωTX。可以推导得到

ϕ = 1 1 + e − η \phi=\frac{1}{1+e^{-\eta}} ϕ=1+e−η1

显然, ϕ ( η ) \phi(\eta) ϕ(η)是一个sigmoid函数。 - 利用似然估计

P

(

Y

,

ϕ

)

=

e

Y

log

(

ϕ

)

+

(

1

−

Y

)

log

(

1

−

ϕ

)

P(Y,\phi)=e^{Y\log(\phi)+(1-Y)\log(1-\phi)}

P(Y,ϕ)=eYlog(ϕ)+(1−Y)log(1−ϕ)可得

log P ( Y ∣ ϕ ) = log ∏ i = 1 N ( e y i log ( ϕ ) + ( 1 − y i ) log ( 1 − ϕ ) ) = ∑ i = 1 N ( y i log ( ϕ ) + ( 1 − y i ) log ( 1 − ϕ ) ) \log P(Y|\phi)=\log \prod_{i=1}^N(e^{y_i\log(\phi)+(1-y_i)\log(1-\phi)})=\sum_{i=1}^N(y_i\log(\phi)+(1-y_i)\log(1-\phi)) logP(Y∣ϕ)=logi=1∏N(eyilog(ϕ)+(1−yi)log(1−ϕ))=i=1∑N(yilog(ϕ)+(1−yi)log(1−ϕ))

转成最小化的优化问题得

min − ∑ i = 1 N ( y i log ( ϕ ) + ( 1 − y i ) log ( 1 − ϕ ) ) \min-\sum_{i=1}^N(y_i\log(\phi)+(1-y_i)\log(1-\phi)) min−i=1∑N(yilog(ϕ)+(1−yi)log(1−ϕ))

刚好就是一个分类随处可以见的交叉熵损失函数了…

556

556

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?