一、回归

回归:是指一类为一个或多个自变量与因变量之间关系建模的方法,通常用来表示输入与输出的关系(连续值)

二、线性回归

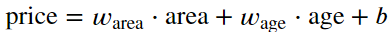

自变量x与因变量 y 之间的关系是线性的,即y可以表示为 x 中元素的加权和,这里通常允许包含观测值的一些噪声

三、线性模型

式子中:w 称为权重;b为偏置

1、权重决定了每个特征对我们预测值的影响。偏置是指当所有特征都取值为0时,预测值应该为多少。

2、 严格来说,式子是输入特征的一个仿射变换(affine transformation)。仿射变换的特点是通过加权和对特征进行线性变换(linear transformation),并通过偏置项来进行平移(translation)

3、线性回归的目标是找到一组权重向量 w 和偏置 b。当给定从X的同分布中取样的新样本特征时,找到的权重向量和偏置能够使得新样本预测标签的误差尽可能小

4、在我们开始寻找最好的 模型参数(model parameters)w 和 b 之前,我们还需要两个东西:(1)一种模型质量的度量方式;(2)一种能够更新模型以提高模型预测质量的方法。

四、损失函数

1、损失函数:能够量化目标的实际值与预测值之间的差距

2、样本 𝑖 的预测值为 𝑦̂ (𝑖),其相应的真实标签为 𝑦(𝑖) 。平方误差如下

3、为了度量模型在整个数据集上的质量,我们需要计算在训练集n个样本上的损失误差均值

4、在训练模型时,我们希望寻找一组参数 (𝐰∗,𝑏∗w∗,b∗),这组参数能最小化在所有训练样本上的总损失

五、小批量随即梯度下降

1、它通过不断地在损失函数递减的方向上更新参数来降低误差

2、最简单的用法是计算损失函数(数据集中所有样本的损失均值)关于模型参数的导数(在这里也可以称为梯度),但是在执行中会非常慢,因为每一个更新数据库都需要遍历整个数据集

3、为解决以上问题,可以在每次计算更新时随机抽取一小批样本,这就是小批量随机梯度下降

4、随机梯度下降步骤

- 随机抽样一个小批量B

- 计算小批量的平均损失关于模型参数的导数

- 将梯度乘以一个预先确定的正数𝜂η,并从当前参数的值中减掉

5、公式介绍

- |B| 表示每个小批量中的样本数,这也称为批量大小

- η 表示学习率

- 批量大小和学习率的值通常是手动预先指定,而不是通过模型训练得到。这种可以调整但不在训练过程中更新的参数被称为超参数

- 调参就是选择超参数的过程

五、神经网络图

对于线性回归,每个输入都与每个输出(在本例中只有一个输出)相连,我们将这种变换( 输出层)称为 全连接层

3983

3983

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?