前言:

这段时间都在研究LLaMaFactory的本地搭建,因为网上现在广告实在是太多了,而且也不利于真正需要的人,所以这在这里写一下搭建步骤,有需要的朋友可以参考,也可以转载,附上原文链接就行,那么现在开始。

上面是效果图,那么我从现在开始从搭建。

所有需要的链接我都给出来:

Anaconda3 https://pan.quark.cn/s/4317e4e69d8d

LLaMA-Factory https://pan.quark.cn/s/7ffe855e920c

deepseek-aiDeepSeek-R1-Distill-Qwen-1.5B https://pan.quark.cn/s/49e6ff26d13a

deepseek-aiDeepSeek-R1-Distill-Qwen-7B https://pan.quark.cn/s/e64070eeb93c

deepseek-aiDeepSeek-R1-Distill-Llama-8B https://pan.quark.cn/s/1f893ea91f4c

总共需要三步骤:

1.安装python环境,我这里只推荐3.10(另外ollama也是需要这个环境)

2.安装Anaconda3环境,我这里会附带安装包(建议2024版本的,比较稳定)

3.安装LLaMaFactory环境,并且附带一个deepseek 1.5B的模型测试一下(链接附带在后面)

开始正文:首先是python环境

分享一个链接,还不错

安装完之后是这个效果就行(版本不比和我一样)

win+r cmd之后输入python有环境就可以了

第二步安装Anaconda3环境

有一位大哥写的链接也很不错,而且有清华源的镜像。

Anaconda3安装_anaconda3安装教程-CSDN博客

这是清华源

Index of /anaconda/archive/ | 清华大学开源软件镜像站 | Tsinghua Open Source Mirror

如果实在不方便,我分享一个夸克链接:

我用夸克网盘分享了「Anaconda3-2024.06-1-Windows-x86_64.exe」,点击链接即可保存。打开「夸克APP」,无需下载在线播放视频,畅享原画5倍速,支持电视投屏。

链接:https://pan.quark.cn/s/4317e4e69d8d

安装完之后,输入 conda --version

看得到版本号就可以了。

在做完了上述步骤,开始我们的重点LLaMaFactory

LLaMaFactory的配置与环境

我先分享一个安装包,可以解压直接用

我用夸克网盘分享了「LLaMA-Factory-main.zip」,点击链接即可保存。打开「夸克APP」,无需下载在线播放视频,畅享原画5倍速,支持电视投屏。

链接:https://pan.quark.cn/s/7ffe855e920c

解压完之后是这样的,放在自己电脑硬盘里面就可以了

安装完之后,我们进入这个文件夹:

选择这个Anaconda Prompt进入

打开是这样的:

然后我们进入llamafac所在的文件夹(我是放在d盘)

cd进入这个文件夹

下面我们要创建一个conda环境

conda create -n ceshi python=3.10

1. 命令功能

- 创建新环境:在 Conda 中新建一个名为

ceshi的独立环境,用于隔离不同项目的依赖。 - 指定 Python 版本:在新环境中安装 Python 3.10,避免与其他环境或全局 Python 版本冲突。

2. 参数解析

conda create:Conda 的基础命令,用于创建新环境。-n ceshi:-n表示环境名称(--name的缩写),ceshi是自定义的环境名(可替换为其他名称)。python=3.10:指定环境中安装 Python 3.10 版本(Conda 会自动解析兼容的依赖包)之后就自动开始创建 然后后面y,就是yes就好了

然后后面y,就是yes就好了

3.打开 llama factory

pip install -e ".[torch,metrics]"

pip install -e ".[torch,metrics]" 是一个结合 可编辑模式安装 和 可选依赖项 的 pip 命令,常见于 Python 项目的开发场景。以下是逐层解析:

1. 命令结构

pip install:基础命令,用于安装 Python 包。-e:表示以 可编辑模式(editable mode) 安装包(等价于--editable)。".":点号.表示当前目录(即安装当前文件夹下的包)。[torch,metrics]:方括号内是包的 额外依赖项(称为extras),需在包的配置文件中定义。

这样会安装一系列的包

然后之后

conda activate ceshi

llamafactory-cli webui

以上就是运行环境,然后打开网站。

首先是语言!这是中国人开发的,所以中文优化很好,选择zh

我们把模型名称选择自己有点模型,然后后面的路径就windows复制一下路径

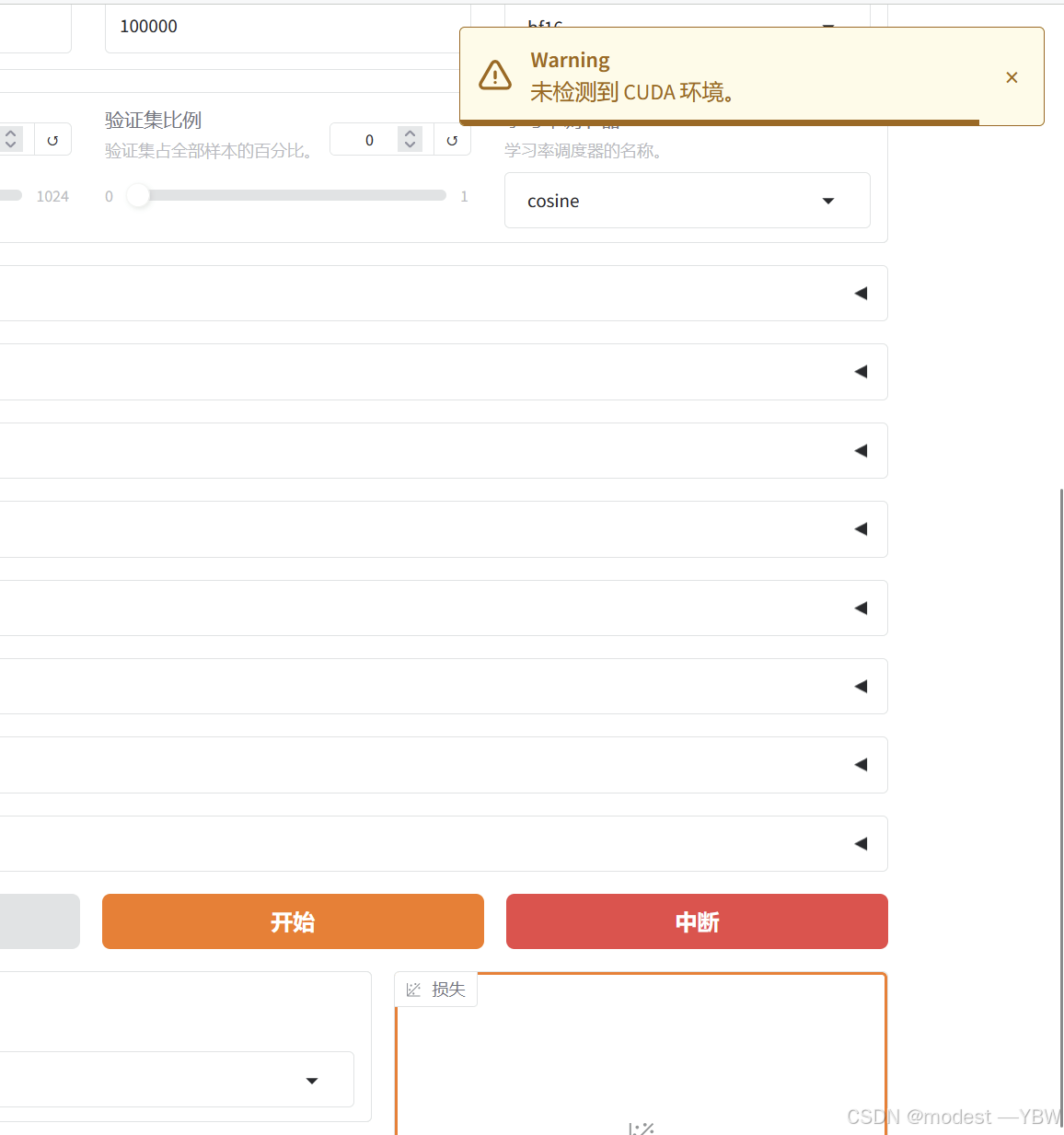

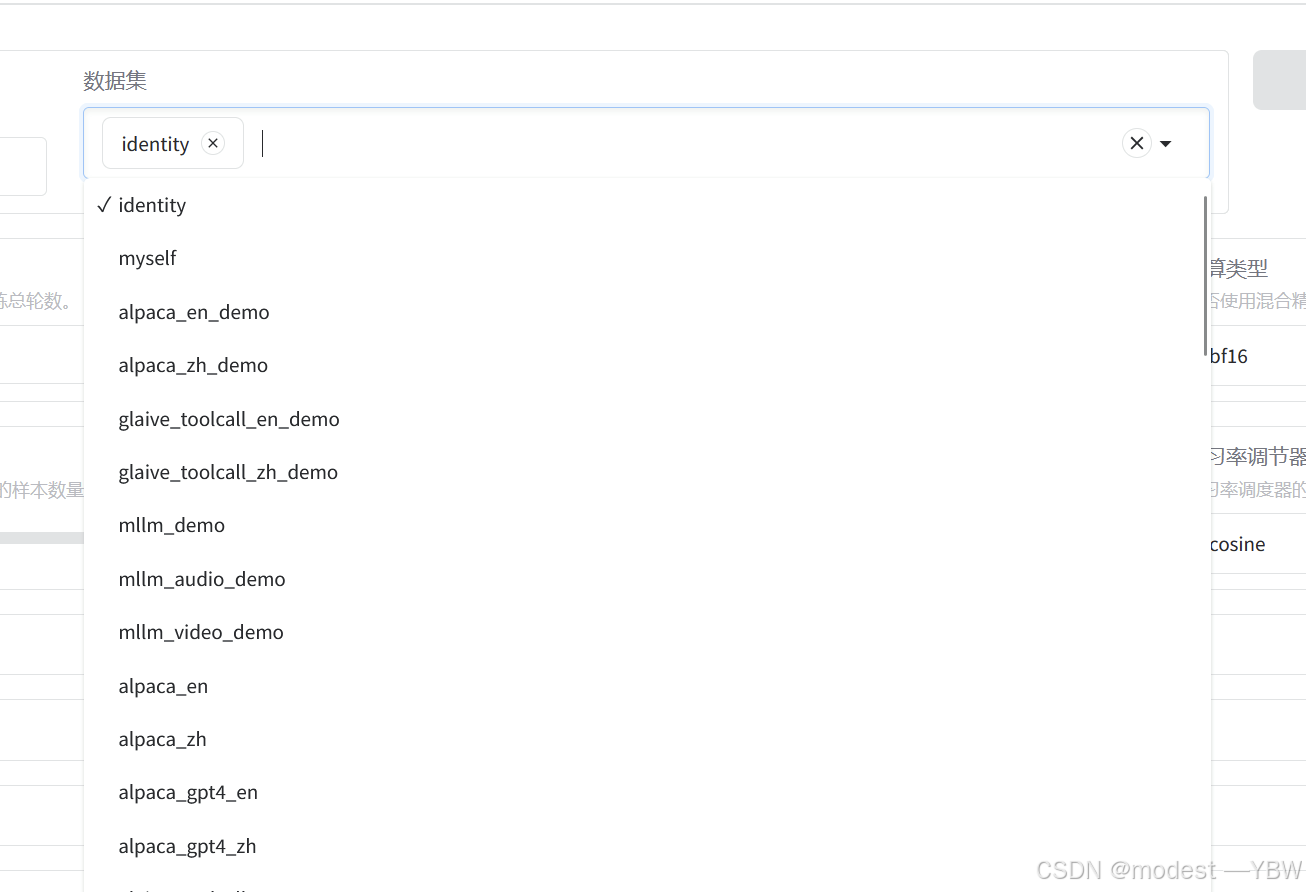

数据集先选择identity,之后可以自己编写

然后我们点击开始

就会报错,找不到CUDA环境

我们就来解决这个报错

本质上是torch包不对,所以我们要重新安装一个适合的torch

步骤 1:卸载 PyTorch

如果您的 PyTorch 是通过 conda 安装的:

conda remove pytorch torchvision torchaudio

如果是通过 pip 安装的:

pip uninstall torch torchvision torchaudio

然后一路yes下去

步骤2:然后安装的话

# Conda 安装

conda install pytorch torchvision torchaudio pytorch-cuda=12.1 -c pytorch -c nvidia

# Pip 安装

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121

包比较大,消耗很长的时间

然后安装完之后就可以正常打开

在这里选择模型和本地路径(对于模型必须是lla格式,不能是gguf格式)

这个对话模板看自己需求选择

数据集先用identy试试

然后加载模型,等他加载好就好(右边图标也会显示对比分数)

到这里整个llama factory也就搭建完成了,不是很复杂。

最后去chat里面就可以对话微调后的模型了

附带几条最简单的命令:

conda:

conda env list 看一下现在conda有哪些环境

conda remove --name 环境名字 --all 删除某个conda环境

conda create --name python=3.10 环境名字 创造某个conda环境,python等于什么般般

conde activate 环境名字 打开某个环境,或者说激活

conda deactivate 关闭某个环境

3262

3262

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?