前言

近年来,Transformer 模型在自然语言处理领域取得了巨大成功,但其计算复杂度随输入文本长度的增加而急剧上升,成为制约其发展的瓶颈。传统的 Transformer 模型采用全局注意力机制,计算复杂度为 O(n²),这意味着处理长文本时需要消耗大量计算资源和内存。为了解决这一问题,Google 提出了一种名为 Infini-attention 的压缩内存技术,可以有效降低 Transformer 的内存占用。基于此,一款名为 Gemma-10M 的新型 Transformer 模型应运而生,它结合了循环神经网络和局部注意力机制,能够高效处理百万级上下文长度,并仅需 32GB 显存即可运行 20 亿参数模型,为 Transformer 长文本处理带来了新的突破。

-

Huggingface模型下载:https://huggingface.co/mustafaaljadery/gemma-2B-10M

-

AI快站模型免费加速下载:https://aifasthub.com/models/mustafaaljadery

技术特点

循环局部注意力机制

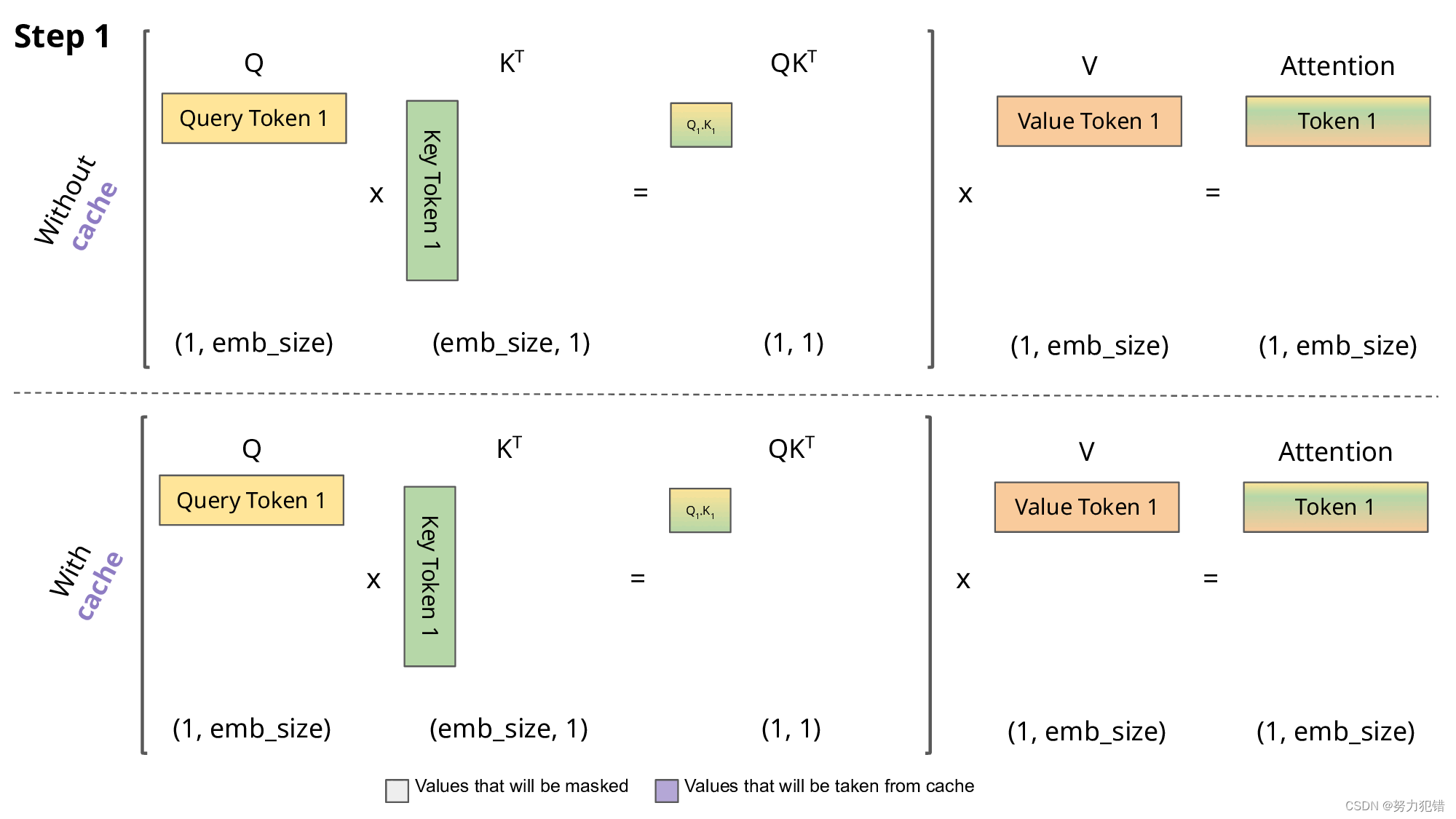

Gemma-10M 的核心技术是循环局部注意力机制。该机制将输入文本划分为多个固定大小的块(例如 2048 个 token),并仅在每个块内进行局部注意力计算。然后,将每个块的注意力结果压缩成一个状态向量,并将其传递给下一个块作为附加参数。这种方式类似于循环神经网络,通过状态向量传递信息,从而捕捉长距离依赖关系。

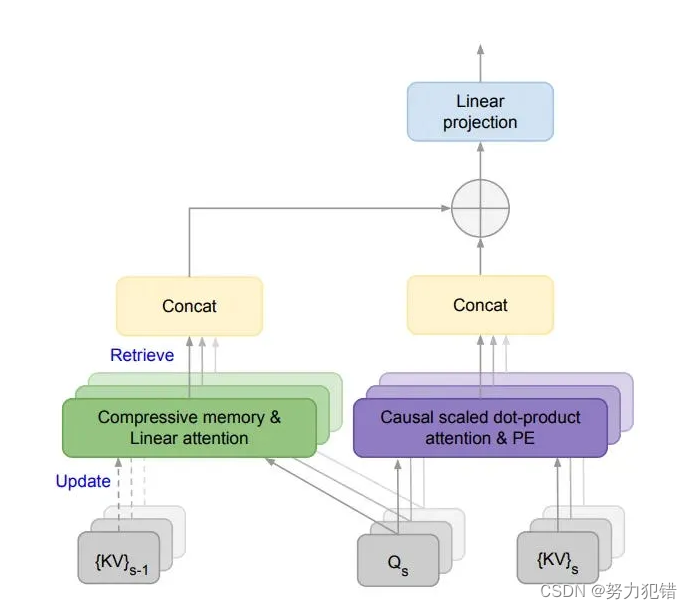

Infini-Attention 压缩内存技术

为了进一步降低内存占用,Gemma-10M 采用了 Google 提出的 Infini-attention 压缩内存技术。该技术通过引入一个压缩内存矩阵,将历史信息以压缩形式存储,并使用线性注意力机制来访问和更新压缩内存。这种方法有效地减少了内存占用,并使得模型能够处理任意长度的上下文窗口。

渐进式上下文窗口扩展训练

为了优化训练成本和数据效率,Gemma-10M 采用了 渐进式上下文窗口扩展训练策略。在训练初期,模型使用较小的上下文窗口(例如 32K 个 token),随着训练的进行,逐渐增加上下文窗口大小,最终达到 10M 个 token。这种方式可以有效地利用计算资源,并逐步提升模型对长文本的理解能力。

性能表现

Gemma-10M 在长文本处理任务上表现出色,其主要优势包括:

-

低内存占用: Gemma-10M 仅需 32GB 显存即可运行 20 亿参数模型,这得益于其循环局部注意力机制和 Infini-Attention 压缩内存技术。

-

高效处理长文本: Gemma-10M 能够高效处理百万级上下文长度,有效解决了传统 Transformer 模型在长文本处理上的性能瓶颈。

-

易于训练: 渐进式上下文窗口扩展训练策略使得 Gemma-10M 的训练过程更加稳定和高效。

应用场景

Gemma-10M 凭借其强大的长文本处理能力,在众多应用场景中具有巨大潜力:

-

长文本摘要: Gemma-10M 可以用于生成长文本的摘要,帮助人们快速了解文本的核心内容。

-

长文本问答: Gemma-10M 可以作为长文本问答系统的核心组件,有效提升问答系统的准确性和效率。

-

代码生成: Gemma-10M 可以用于生成代码,帮助程序员更快速地完成编程任务。

-

机器翻译: Gemma-10M 可以用于长文本的机器翻译,提升翻译质量和效率。

总结

Gemma-10M 是一款高效且强大的 Transformer 模型,通过循环局部注意力机制和 Infini-Attention 压缩内存技术,有效解决了传统 Transformer 模型在长文本处理上的性能瓶颈。其渐进式上下文窗口扩展训练策略使得模型训练更加高效,并在多个长文本处理任务上取得了显著成果。相信 Gemma-10M 将会推动 Transformer 模型在长文本处理领域的进一步发展,为自然语言处理应用带来更多可能性。

模型下载

Huggingface模型下载

https://huggingface.co/mustafaaljadery/gemma-2B-10M

AI快站模型免费加速下载

https://aifasthub.com/models/mustafaaljadery

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?