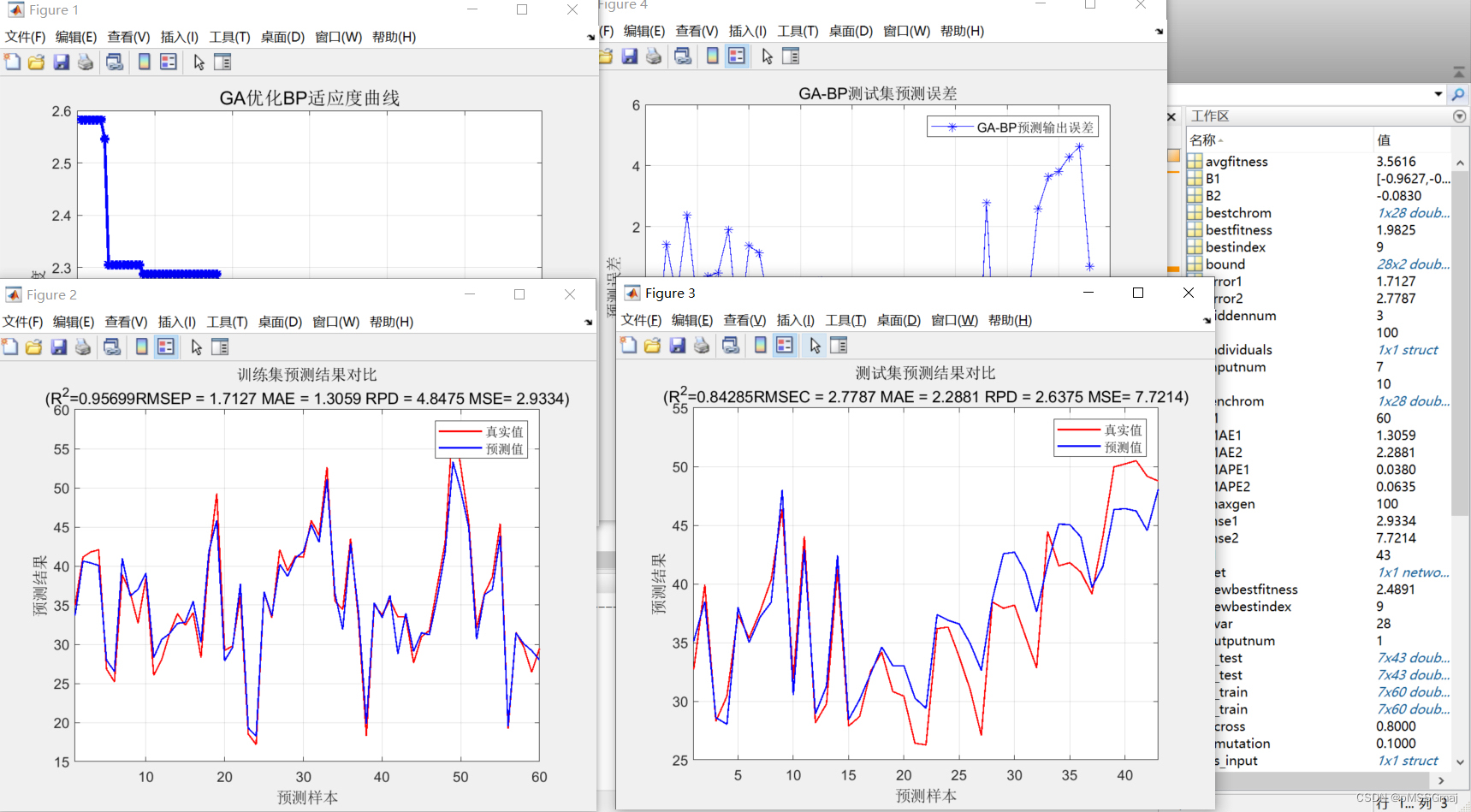

利用遗传算法GA和粒子群算法PSO优化算法,将BP神经网络训练集的MSE作为适应度函数,获取最优的权值和阈值在反向输入到BP神经网络里构建回归预测模型,同时能够打印出模型的多个评价指标,具体效果可以看图

遗传算法GA和粒子群算法PSO是一种常见的优化算法,它们能够通过模拟生物进化和群体智能来寻找最优解。在本文中,我们将介绍如何使用遗传算法GA和粒子群算法PSO来优化BP神经网络模型,并构建一个高效的回归预测模型。

首先,我们需要定义一个适应度函数来衡量BP神经网络模型的性能。通常情况下,我们会使用MSE(Mean Squared Error)作为适应度函数,因为它可以衡量模型的预测误差大小。在这里,我们将利用遗传算法GA和粒子群算法PSO来寻找最优的权值和阈值,以最小化MSE。

遗传算法GA模拟了自然选择和遗传机制,通过不断的交叉、变异和选择操作来生成新的种群。在每一代中,遗传算法GA会根据适应度函数对所有个体进行评估,并选择出适应度最高的个体作为“父代”,再通过交叉和变异操作生成新的“后代”个体。通过这样的迭代过程,遗传算法GA不断优化个体适应度,并逐渐逼近最优解。

粒子群算法PSO模拟了群体智能的行为,通过不断的位置更新来寻找最优解。在PSO中,每个“粒子”代表一个解空间中的可能解。在每一代中,基于适应度函数,粒子会根据自己的历史最优位置和群体最优位置来调整自己的速度和位置。通过这样的迭代过程,粒子群算法PSO不断搜索最优解,并逐渐逼近全局最优解。

在本文中,我们将结合遗传算法GA和粒子群算法PSO,来训练BP神经网络模型,并构建一个高效的回归预测模型。具体而言,我们将首先通过遗传算法GA来优化BP神经网络模型的权值和阈值,然后将得到的最优权值和阈值输入到BP神经网络中进行训练。接着,我们将使用粒子群算法PSO来优化BP神经网络模型的参数,进一步提高模型的性能。

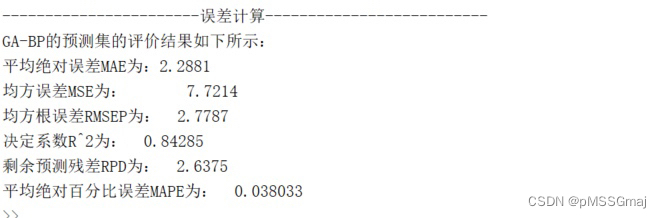

最后,我们将通过打印出模型的多个评价指标来评估模型的性能。这些指标包括MSE、RMSE(Root Mean Squared Error)、MAE(Mean Absolute Error)、MAPE(Mean Absolute Percentage Error)和R2(R Squared)。通过这样的评估,我们能够更准确地了解模型的预测效果,以及是否符合我们的需求和要求。

综上所述,利用遗传算法GA和粒子群算法PSO优化算法,将BP神经网络训练集的MSE作为适应度函数,获取最优的权值和阈值在反向输入到BP神经网络里构建回归预测模型,同时能够打印出模型的多个评价指标,这不仅可以提高预测准确度,还能够节省时间和资源成本。所以,我们相信这个方法是非常有价值的,并可以在实际应用中发挥重要的作用。

相关代码,程序地址:http://lanzouw.top/669194443543.html

2706

2706

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?